本文来源公众号“arXiv每日学术速递”,仅用于学术分享,侵权删,干货满满。

原文链接:专题解读 | 图增强大语言模型研究进展

一、简介

图在表示和分析现实世界中的复杂关系方面发挥着重要作用,如社交网络、生物数据等。大语言模型(LLM)在自然语言处理领域取得了巨大成功,现在也被用于与图相关的任务,超越了传统的基于图神经网络(GNN)的方法。这种结合在多个领域取得了成功,显示了图和LLM集成的强大潜力。下面将介绍两篇关于图增强大语言模型的论文。

二、Can Graph Learning Improve Planning in LLM-based Agents?(NurIPS 2024)

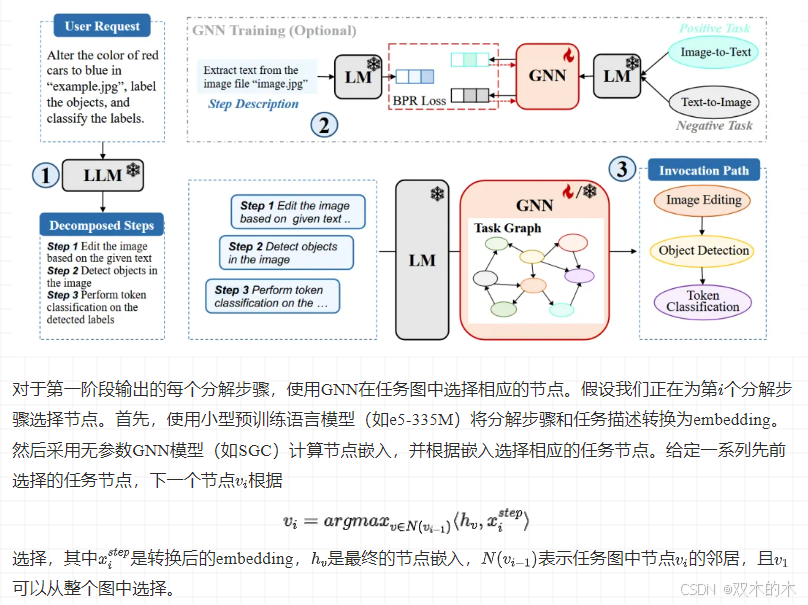

任务规划旨在将复杂的自然语言用户请求分解为具体且可解决的子任务,并执行这些子任务以满足原始请求。然而注意力的归纳偏差和自回归损失阻碍了LLM在图上有效导航决策的能力,而图神经网络(GNN)则巧妙地解决了这一问题。在这种情况下,子任务可以自然地被视为一个图,其中节点表示子任务,边表示它们之间的依赖关系。因此,任务规划是一个在相应的图中选择连通路径或子图的决策问题。该论文提出将GNN与LLM集成在一起,以提高任务规划的性能。

2.1.无需训练的GNN方法

当前的任务规划解决方案涉及两个阶段。第一阶段需要理解用户请求的自然语言并将其分解为具体指令,这是LLM的独特能力。第二阶段是在任务图上选择路径,其中每个节点对应一个分解的步骤。因此,我们可以在这个阶段集成GNN。

由于e5-335M是预训练的,SGC是无参数的,因此提出的方法不需要额外的训练,并且可以有效地在零样本场景下应用。

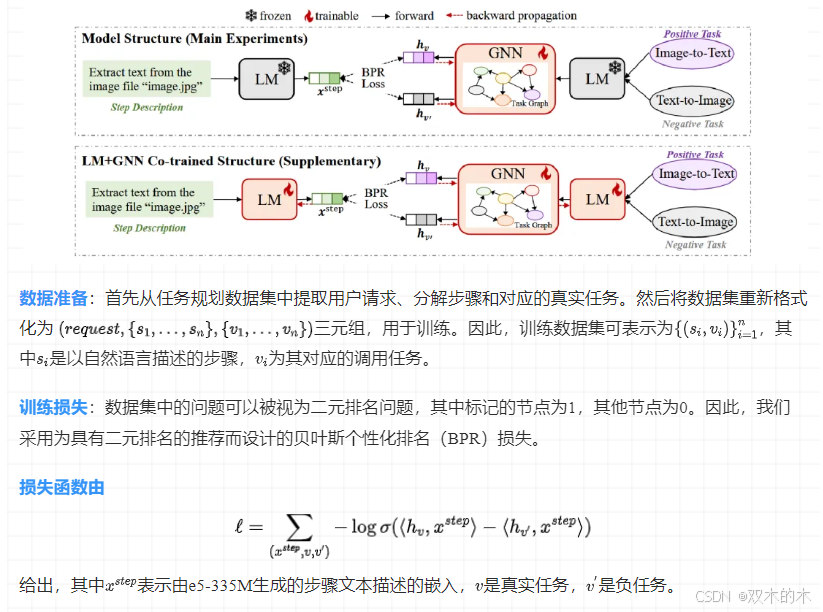

2.2.需要训练的GNN的方法

需要训练的GNN的方法的推理过程与无需训练的方法相似,区别在于使用参数化的GNN(如GAT或GraphSAGE)代替无参数的GNN。以下是GNN的训练过程:

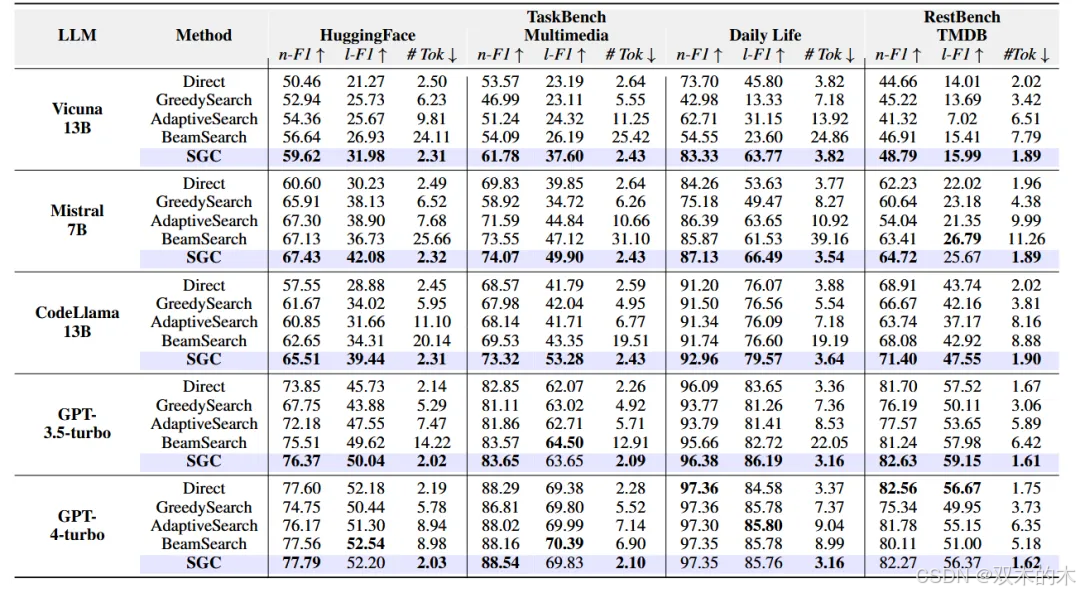

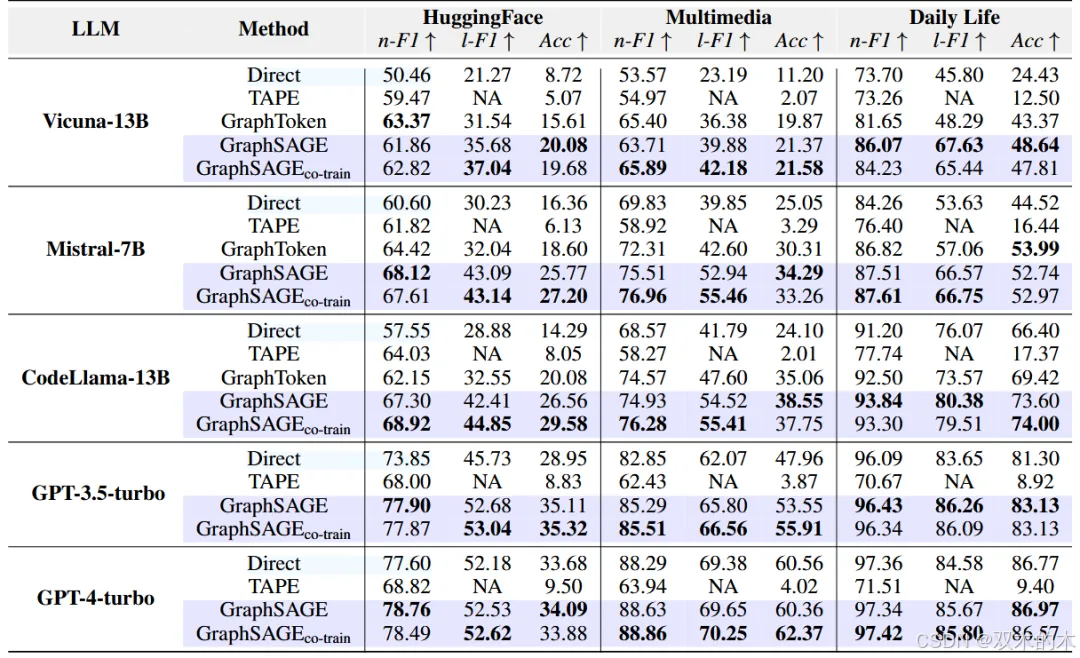

实验结果

无需训练方法的性能:与直接推理相比,集成SGC一致提高了性能。

需要训练方法的性能:采用基于训练的GraphSAGE方法比无需训练的方法有显著的性能提升。然而,GNN与e5-335M的共同训练并没有产生显著的改进,这表明消息传递是提高性能的关键元素。

三、Graph Chain-of-Thought: Augmenting Large Language Models by Reasoning on Graphs(ACL 2024)

大语言模型(LLM)在知识密集型任务上存在幻觉问题,即生成看似合理但未经证实的内容。现有方法通过检索外部文本语料库来增强LLM,每个文档视为一个知识单元,但忽略了文本间的相互关联和结构信息。并且将局部子图转换为文本来作为LLM输入时会导致上下文过长,可能使LLM迷失方向或超出其输入限制,因此该论文提出使用外部图来增强LLM。

3.1.Graph Reasoning benchmark dataset :GRBENCH

为了促进使用图增强LLM的研究,该论文手动构建了一个名为GRBENCH的图推理基准数据集。该数据集包含来自五个不同领域的图数据,包括学术、电子商务、文学、医疗和法律。每个领域图都包含了丰富的结构化知识,以节点和边的形式表示实体及其之间的关系。其中每个样本都是一个精心设计的问题-答案对,且问题需要通过与图数据的交互来回答。问题被分为不同的难度级别,包括简单(单跳推理)、中等(多跳推理)和困难(需要归纳推理)。

该数据集构建步骤如下:首先从现实世界场景中收集大型参考图数据,然后手动设计可以在参考图数据上回答的问题模板,由于属于同一模板的所有样本将共享相同的表达式,为了得到更多样化的表达式,调用GPT-4为每个问题模板生成不同的问题表达式,最后从特定领域的图中自动生成问题的正确答案。

3.2.Graph Chain-of-Thought 框架

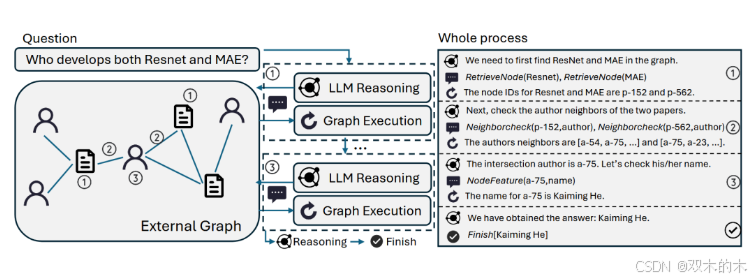

GRAPH-COT是一个迭代框架,每次迭代有以下三个步骤:LLM推理:LLM根据当前信息推理出需要从图中获取哪些额外信息,或者是否可以根据当前图上下文回答问题。LLM与图的交互:基于LLM的推理结果,生成与图交互所需的操作。定义了四个图函数来覆盖图上的语义信息和结构信息。图执行:调用上一步给出的函数,并从图中获取相关信息。

四个图函数如下:RetrieveNode(Text):通过语义搜索识别图中的相关节点。NodeFeature(NodeID, FeatureName):从图中提取特定节点的文本特征信息。NeighborCheck(NodeID, NeighborType):返回图中特定节点的相邻信息NodeDegree(NodeID, NeighborType):返回图中特定节点的特定邻居类型的度数。

3.3.实验结果

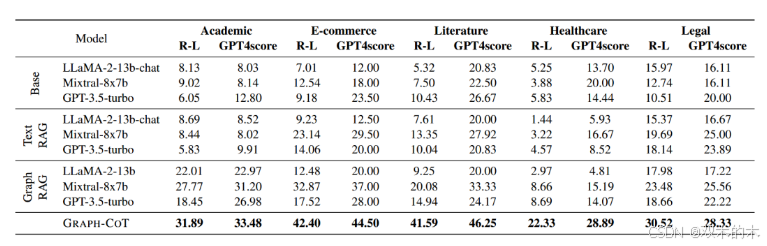

从实验结果可以看出,GRAPH-COT始终显著优于所有Baselines。在三个骨干模型中,Base LLMs的表现很差,通常是因为LLM可能不包含回答这些问题所需的知识。大多数情况下,Graph RAG LLMs性能优于Text RAG LLMs,因为前者可以提供更多的结构感知上下文,有助于解决问题。

四、总结

本文介绍了图增强LLM的两种应用:任务规划和图推理。在任务规划中,通过将图神经网络(GNN)与LLM结合,提升了任务分解和路径选择的性能;在图推理中,通过Graph Chain-of-Thought(Graph-COT)框架,实现了与图的交互式推理,有效解决了幻觉问题。实验结果表明,图结构与LLM的深度融合显著提升了模型的推理、规划和知识利用能力,展示了这一方向在未来图学习任务中的巨大潜力。

THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。

694

694

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?