过去两年,大模型的能力曲线一路向上,但开发者却反复遇到同一个困境:模型越来越强,却越来越“不听话”。无论是在企业项目中,还是在智能体(Agent)系统里,你都能感受到这种漂移:模型有时过度“自信”,有时过度“安全”,有时又出现幻觉,一旦进入复杂语境,行为更像是一块难以琢磨的黑石头。

于是,对齐(Alignment)技术变成了所有模型团队的必修课。

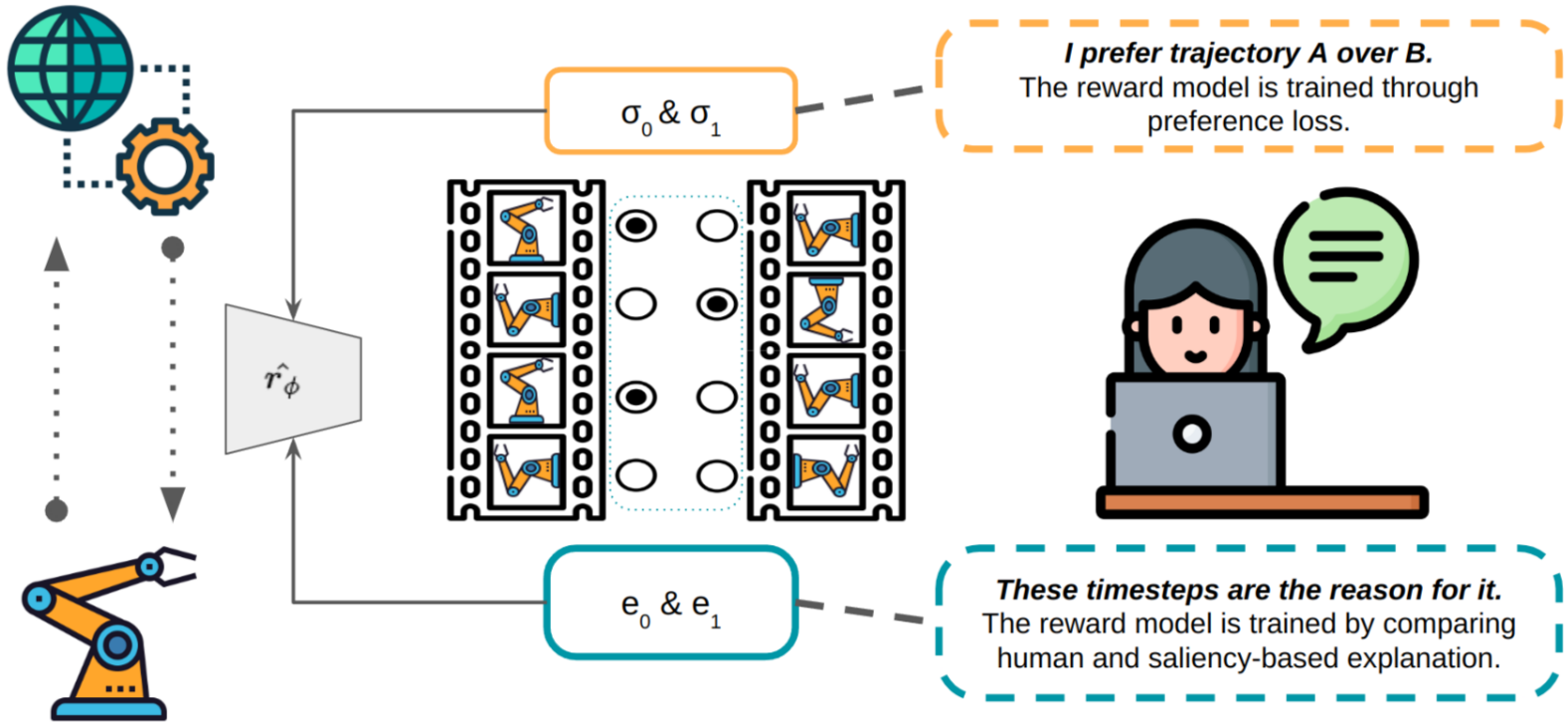

真正让模型从“能说”到“说得对”“说得稳”“说得负责任”,靠的不是堆显卡,而是——偏好学习(Preference Learning)。

这篇文章,我们来拆开大型模型对齐的三次演化:

RLHF → RLAIF → 自动偏好学习(Autonomous Preference Learning)。

不是概念罗列,而是让你看懂“为什么演化”“怎么演化”“对你做的 AI 应用意味着什么”。

一、当模型第一次学会“迎合人类”:RLHF 为什么有效?

如果要用一句话概括 RLHF(Reinforcement Learning from Human Feedback),那就是:

让模型学会“人类喜欢什么样的回答”。

过去我们训练一个语言模型,只需要海量文本,但这些文本没有告诉模型什么是“好回答”。

RLHF 的出现,让模型第一次有机会理解:

原来回答要符合人类偏好,而不是概率统计。

RLHF 做了三件事

-

先用 SFT(监督微调)教模型“正确示范”

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1381

1381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?