LLaMA-Factory微调大模型导出的模型时HF格式的而Ollama框架只支持gguf文件格式的自定义模型,所以需要将模型进行转换

开源项目llama.cpp提供的有模型格式转换工具

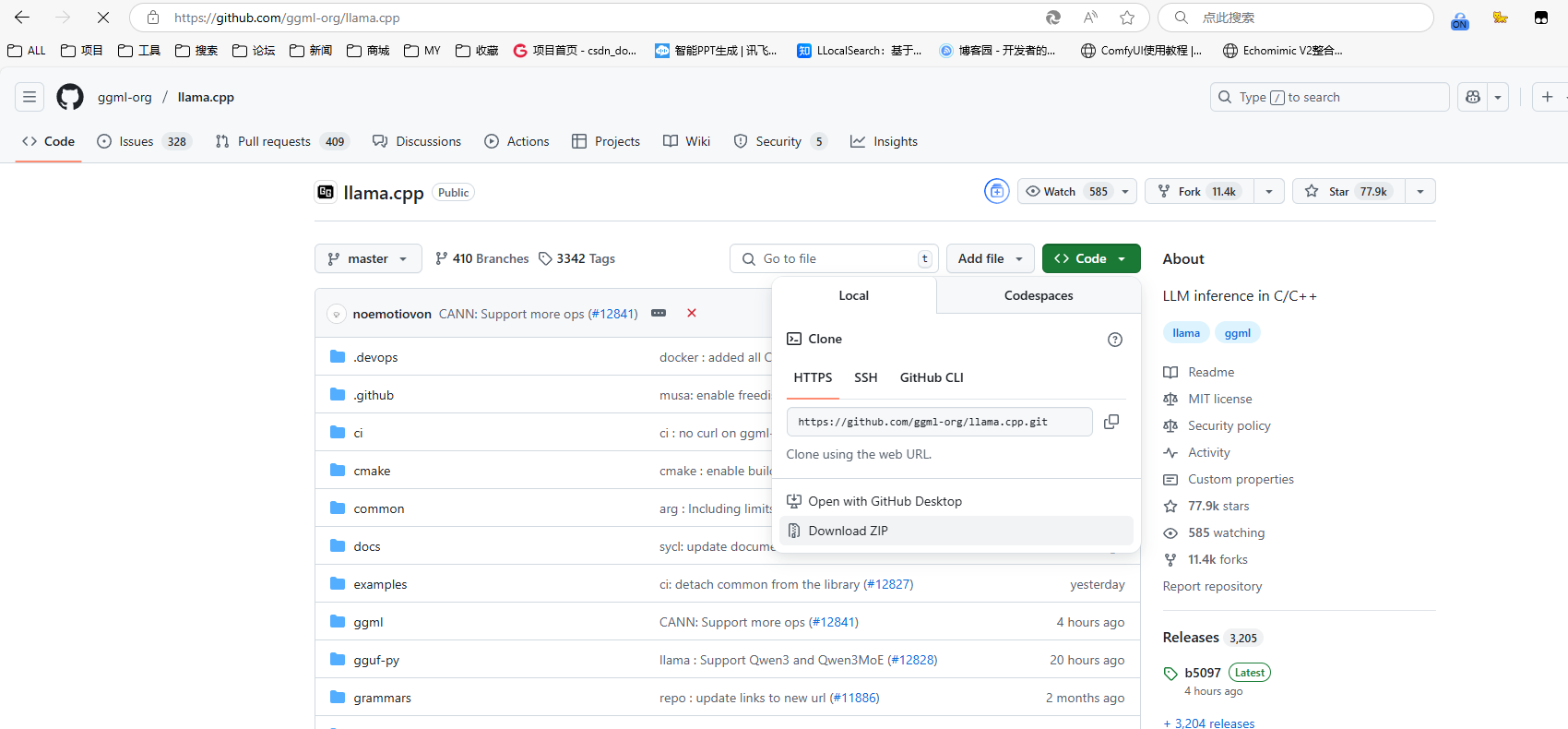

项目地址:https://github.com/ggerganov/llama.cpp

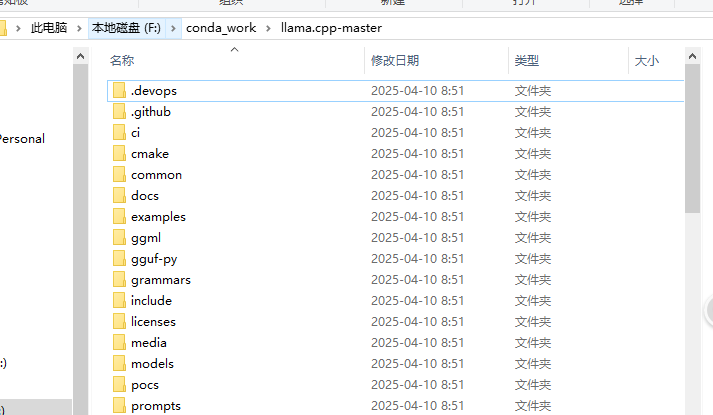

先下载项目

解压,在项目下打开cmd命令窗口

创建虚拟环境

conda create -n llama_cpp python==3.10

激活

activate llama_cpp

torch 安装

conda install pytorch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 pytorchcuda=12.1 -c pytorch -c nvidia

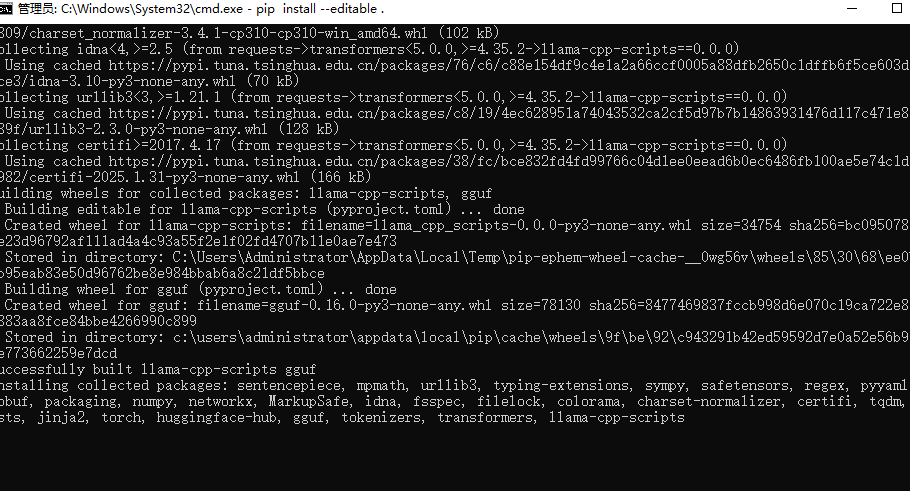

依赖安装

pip install --editable .

安装完成

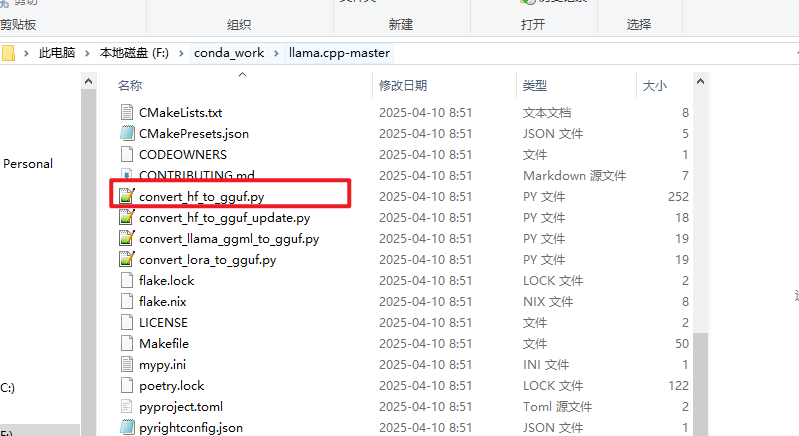

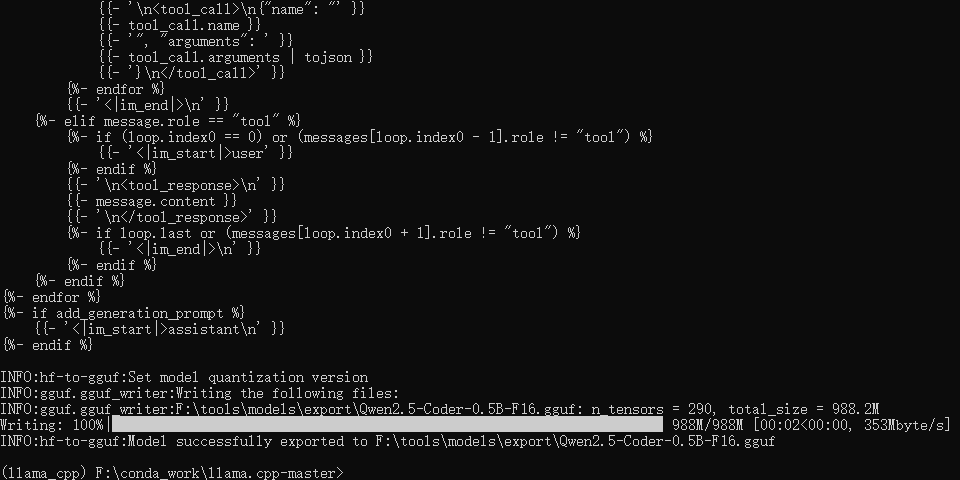

llama.cpp官方提供的 convert-hf-to-gguf.py 脚本,用于完成huggingface格式到gguf格式的转换

格式转换

python convert_hf_to_gguf.py F:\tools\models\export

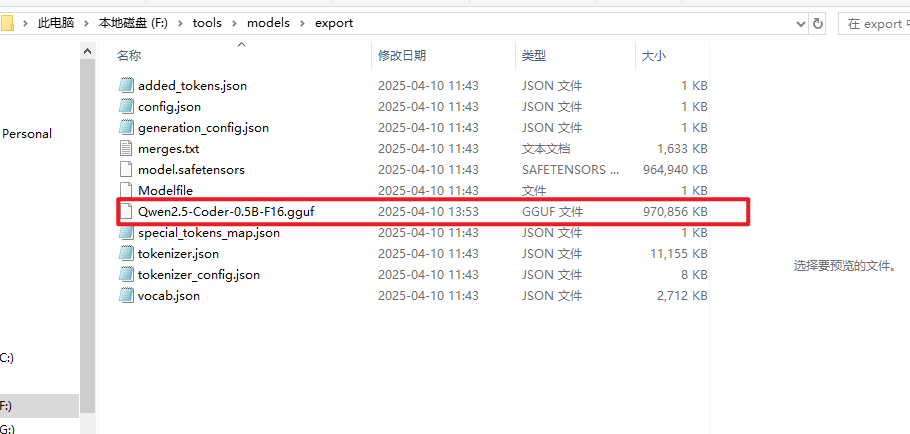

这里的 F:\tools\models\export 是我微调大模型后导出的模型路径

转换后的模型就可以使用ollama进行加载:ollama加载本地自定义模型

5040

5040

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?