目录

内容寻址与不可变数据对象(Content-Addressable Storage)

第12.3 节 实现与加速要点(稀疏算子、硬件优化、低精度与推理批处理)

内存占用与梯度检查点(gradient checkpointing)

低精度训练(FP16 / BF16 / 8-bit)与数值稳定性

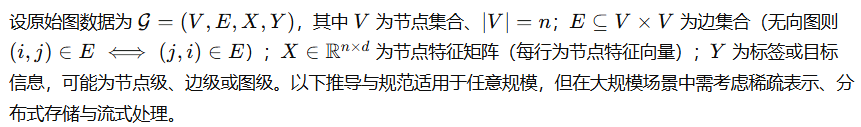

本章集中讨论大规模图神经网络系统中数据管道与预处理的理论基础、算法推导与工程实现要点。所给内容以数学/算法推导为主,目标为教材中“算法原理”与工程实现章的可直接使用条目:定义精确、推导严密、步骤完整,可作为实现与验证的规范。

12.1 数据管道与预处理

订阅专栏 解锁全文

订阅专栏 解锁全文

933

933

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?