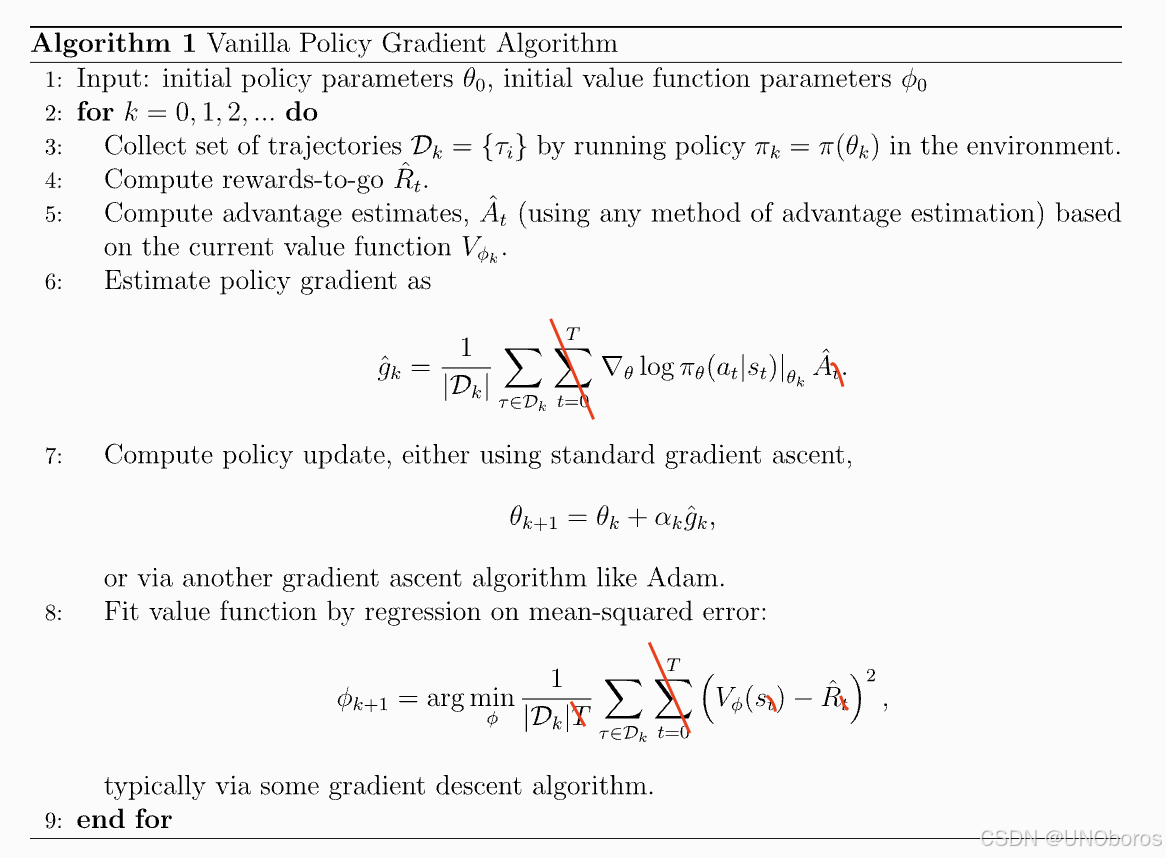

在经典的REINFORCE中,当我们把一个RL问题简化成一个Contextual Bandit问题后(也就是说,我们只关心最后的结果,不关心中间的过程),那么我们会有如下算法

仔细观察,看出什么了吗?

首先,我们来看这个 Value Model,它本质上就是对所有 sample episode 的 reward 均值进行回归。那么,既然如此,为什么不直接计算这个均值呢?再来看 Advantage,它最简单的定义是 A(s,a)=Q(s,a)−V(s)A(s,a) = Q(s,a) - V(s)A(s,a)=Q(s,a)−V(s)。假设最终学到的 QQQ 是完全准确的,那它是什么?它不就是我们观察到的 reward 吗?因此,对于 episode i而言,A=ri−mean(r),再进行归一化后,就变成了 DEEPSEEK 论文 4.1.2 中的形式。

理解了这一层后,我们回到标准的 RL 设定,这个逻辑依然成立。也就是说,我们依然不需要 value model。只不过在这种情况下,我们知道 V 实际上是在回归所有 sample episode 的每一步 reward 均值,也就是 4.1.3 中的形式。

到这里,一切看起来似乎都很平常。那么,真正的“魔法”究竟发生在哪里呢?我认为就在 4.1.2 这里,即 Outcome Supervision RL!Ron 似乎很早就意识到了这一点——我们不需要去关心 credit assignment,我们只要告诉模型最终目标是什么就够了!

其实,我早该意识到这一点。在研究 AlphaZero 时,我一直想用它来求解 single-player game,却被对弈这一思想所束缚。现在看来,完全没必要!回顾原始算法,对弈双方的中间步骤 reward 本来就是最终 reward 复制后加个正负号再传回去。当时我还觉得这种做法完全不考虑 credit assignment,过于简单粗暴。但现在来看,修改竟如此直截了当——移除一方后,所有中间节点都会被赋予与最终结果相同的 reward,而算法依然成立。这不正是 GRPO 吗?

所以,GRPO 本质上是 CB 版的 REINFORCE,同时也是一个仅有单个玩家的 MCTS。虽然在 4.2 中,作者也尝试了 MCTS,但和当年的我一样,被“树”这个概念限制了思维。其实,根本不需要将答案拆解成更小的部分来探索解空间——只要每个节点对应一个 token,直接 rollout 到终止符,理论上就与 GRPO 完全等价。

至此,一切都对上了。大道至简!没想到我们求索多年的问题,Ron 早在几十年前就已经为我们写好了答案,这让我感触良多……

507

507

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?