一、数据获取

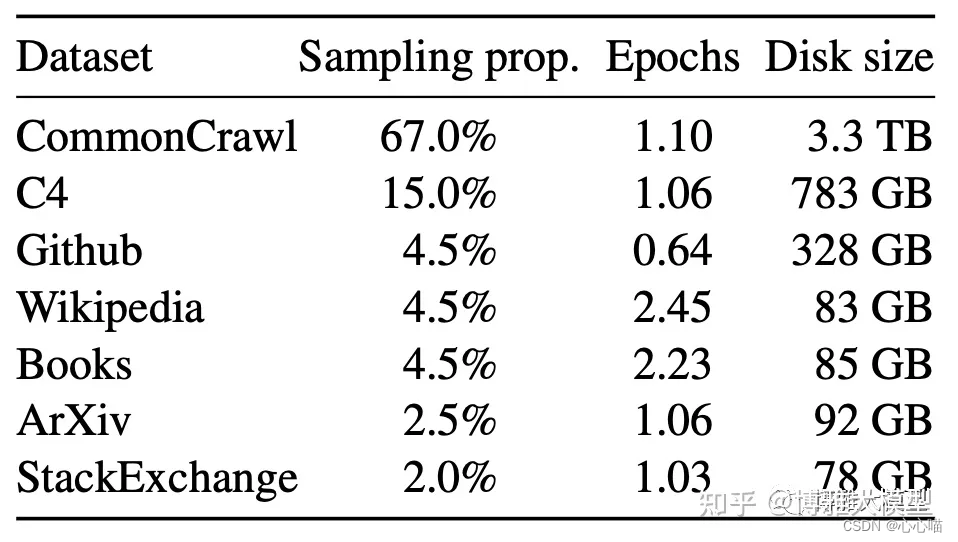

数据通常分开源、自建、爬取三种。在开源中常见的有wikipedia,书籍,CommonCrawl,代码,对话等类型。下图列举了LLama使用的数据分布。

其中wikipedia由于质量较高基本上会被每个LLM使用。书籍则是为较长的上下文学习提供语料,现在分学科的书籍电子化和抽取是各家重点搞的数据。代码数据则能加强模型的逻辑推理能力,因为其实现通常是分步骤有逻辑的。尽可能整理自有数据和爬取外部数据是LLM项目讨论中最常见的话题。在中文领域中,常见的数据可分为几个档次,A档:知乎,小红书,头部GZH/头条文章,百科,经验,专业新闻网站,政务网站,行业垂类网站,比如起点,晋江,传统图书电子化;B档: 英文数据集翻译成中文,主要得益于原始的英文质量高,实践中会有一些较严

本文探讨了大模型预训练中数据获取的多种途径,包括开源、自建和爬取,并重点关注了数据清洗的通用方法和case驱动策略。数据清洗涉及质量检查、去重和安全过滤。此外,还讨论了数据配比的重要性以及微调阶段对数据质量和多样性的要求。

本文探讨了大模型预训练中数据获取的多种途径,包括开源、自建和爬取,并重点关注了数据清洗的通用方法和case驱动策略。数据清洗涉及质量检查、去重和安全过滤。此外,还讨论了数据配比的重要性以及微调阶段对数据质量和多样性的要求。

订阅专栏 解锁全文

订阅专栏 解锁全文

424

424

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?