自从DeepSeek-OCR发布,实现视觉压缩文本以来,马斯克的预言正在一步步成真:从长远来看,人工智能模型的输入和输出中 99% 以上都将是光子。直到不能缩放。

现在更进一步,连抽象推理都变成光子问题了。

麻省理工学院(MIT)何恺明团队发布的研究成果证实,机器的抽象推理能力并不依赖于庞大的语言模型,而是可以通过纯粹的视觉范式实现,其仅用18M参数的模型便在ARC基准测试中追平了人类平均表现。

这篇题为《ARC Is a Vision Problem!》的论文,针对长期以来被视为人工智能终极挑战之一的抽象与推理语料库(ARC)提出了颠覆性的解法。

ARC基准测试自诞生以来,一直被设计用来评估机器在极少样本下的通用智能,特别是抽象推理能力。

过去的主流观点倾向于将其视为一个类似于编程或语言逻辑的问题,试图通过大语言模型或者符号推理系统来寻找规律。

这种路径依赖导致了算力资源的巨大消耗,且在面对需要极强泛化能力的未见任务时,表现往往难以突破瓶颈。

麻省理工学院的研究人员打破了这一惯性思维。

他们指出ARC任务中的核心概念,例如反射、对称、重力、物体移动等,本质上是视觉世界和物理规律的投影。

人类在解决这些谜题时,并非在脑海中构建复杂的程序代码,而是调动了对物理世界的直观感知和视觉经验。

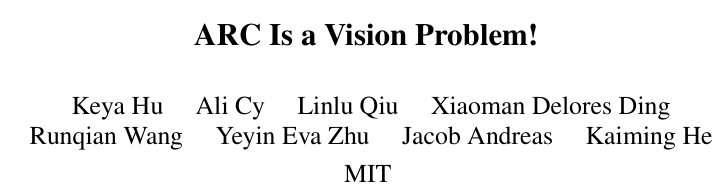

基于这一洞察,研究团队构建了Vision ARC(VARC)框架,将抽象推理任务重新定义为图像到图像的转换问题。

这一转变不仅极大地简化了问题空间,更让计算机视觉领域成熟的技术栈得以直接应用。

该研究最令人震撼的结论在于数据表现。

在ARC-1基准测试中,VARC框架取得了60.4%的准确率。

这个数字具有双重意义:它不仅大幅超越了那些同样从零开始训练的递归推理模型,更足以与拥有数千亿参数的顶尖大型语言模型分庭抗礼。

与此同时,这一成绩填补了机器智能与人类平均表现之间的最后空白,证明了在抽象推理这一认知高地上,视觉智能是一条被严重低估的路径。

ARC本质是视觉与物理世界的映射

理解ARC任务的本质是解开这一难题的关键。

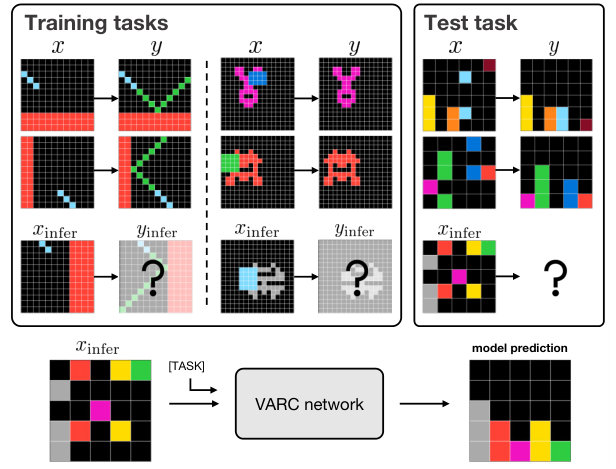

ARC包含数百个设计精巧的网格谜题,每个任务仅提供2到4个演示示例。

输入和输出都是由不同颜色方块组成的二维网格。

传统的处理方法往往陷入了符号化的陷阱,将这些彩色方块转换为数字序列或文本标记,试图通过语言模型的序列预测能力来寻找变换规则。

这种做法实际上是在强行将二维的空间信息降维成一维的线性逻辑,过程中不可避免地丢失了至关重要的空间结构信息。

研究团队敏锐地捕捉到了这一点。

他们分析发现,ARC任务中隐藏的变换规则并非随意的数学映射,而是对现实物理世界和视觉规律的抽象。

无论是物体的反射、图形的对称,还是模拟重力的下落,这些概念在人类的认知中都是与其视觉经验紧密绑定的。

人类之所以能够快速解开这些谜题,是因为我们生活在一个视觉主导的世界里,大脑皮层中专门负责视觉处理的区域天然具备处理空间关系、物体恒常性和物理模拟的能力。

VARC框架正是基于这一仿生学原理构建的。

它不再将输入网格视为一串冰冷的数字,而是将其视为一张图像。

在这个框架下,输入不再是文本标记,而是像素;任务不再是文本生成,而是图像生成。

这种视角的转换将ARC问题从自然语言处理(NLP)领域拉回了计算机视觉(CV)领域。

在计算机视觉中,图像到图像的转换是一个经典且成熟的问题,涵盖了从图像去噪、风格迁移到语义分割等一系列任务。

将ARC定义为此类问题,意味着可以直接利用卷积神经网络(CNN)或视觉变换器(ViT)等强大的视觉架构,挖掘像素之间潜在的空间依赖关系。

这种映射关系的建立并非简单的比喻。

在VARC的架构中,每一个推理步骤都被具象化为视觉操作。

比如,识别一个形状对应于视觉中的物体检测;寻找相同的形状对应于特征匹配;预测形状的移动对应于光流估计或运动预测。

通过这种方式,模型不需要显式地学习复杂的逻辑规则或编程语法,而是通过大量的视觉训练,隐式地掌握了物理世界的运作规律。

这种隐式学习更接近人类直觉的形成过程,也解释了为何该模型能够在未见过的任务上表现出强大的泛化能力。

画布理念让视觉模型学会举一反三

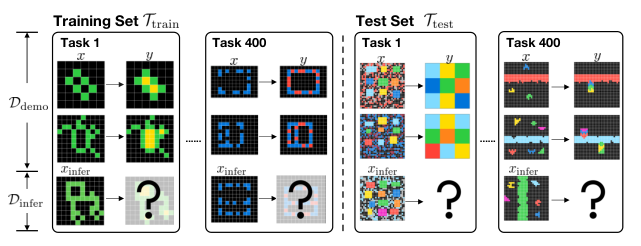

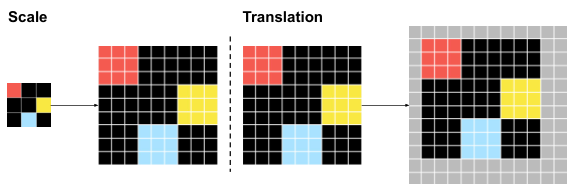

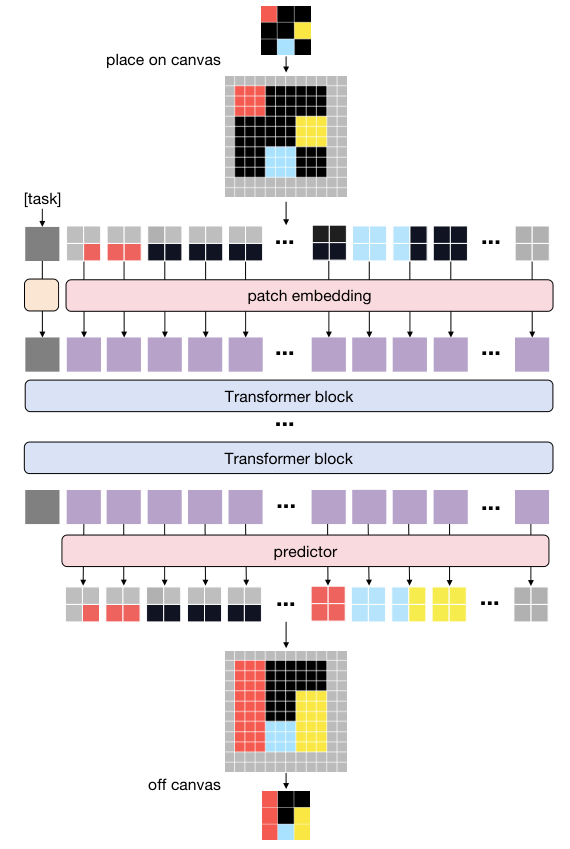

为了让标准的视觉模型能够处理ARC这种特殊的网格数据,研究团队引入了一个极具创新性的概念——画布。

在原始的ARC数据中,网格的大小是不固定的,最大为30x30,且包含离散的颜色值。

直接将这样的小网格输入到为高分辨率自然图像设计的神经网络中,会面临信息密度不足和空间结构难以捕捉的问题。

画布概念的提出,巧妙地解决了这一工程难题,并为引入视觉先验提供了载体。

画布被定义为一个预定义大小的网格,例如64x64,其背景被设定为一种特殊的背景色。

原始的输入网格被放置在这个更大的画布上。

这种看似简单的操作,实则为模型引入了两个至关重要的视觉先验:平移不变性和缩放不变性。

在自然图像处理中,识别一只猫并不取决于猫在图像中的位置,也不取决于猫的大小,这就是平移和缩放不变性。

ARC任务同样遵循这一规律,一个图形的变换规则往往与其在网格中的绝对位置无关,与其尺寸大小也无必然联系。

通过在画布上随机放置输入网格(平移增强)以及随机调整输入网格的大小(缩放增强),VARC框架强迫模型去学习那些不随位置和大小改变的本质特征。

这种数据增强策略实际上是在模拟人类的视觉认知过程:当我们观察一个物体时,无论远近高低,我们都能认出它。

在训练过程中,模型不再是死记硬背某个特定位置的颜色变化,而是学会了识别某种结构或模式,无论它出现在画布的哪个角落。

配合画布概念,研究团队主要采用了视觉变换器(ViT)作为核心架构。

ViT的核心思想是将图像分割成一个个小补丁(Patch),然后通过Transformer机制处理这些补丁之间的关系。

在VARC中,画布被划分为2x2的补丁。

与将每个像素视为一个标记的传统做法不同,这种基于补丁的处理方式使得每个标记能够包含更丰富的信息。

一个2x2的补丁可以包含多种颜色的组合,其可能的状态空间呈指数级增长。

这种高基数的局部配置不仅丰富了特征表达,还有效防止了模型过拟合,促使其关注更宏观的空间结构而非微观的像素噪声。

为了进一步强化模型的空间感知能力,VARC采用了可分离的2D位置嵌入。

与语言模型中常用的一维位置编码不同,图像天生具有二维结构。如果简单地将图像补丁拉平成一维序列,就会破坏像素在垂直方向上的邻接关系。

VARC通过分别对水平坐标和垂直坐标进行编码,确保了模型能够精确地理解网格中每一个元素在二维空间中的相对位置。

这对于解决那些涉及几何变换(如旋转、镜像)的ARC任务至关重要。

除了ViT,研究还验证了经典的U-Net架构的有效性。

U-Net最初是为了生物医学图像分割而设计的,其典型的编码器-解码器结构和跳跃连接非常适合处理图像到图像的转换任务。

实验表明,即便是这种传统的卷积神经网络,在结合了画布和数据增强策略后,也能在ARC任务上取得令人印象深刻的效果。

这进一步佐证了VARC框架的核心假设:ARC问题的难点不在于逻辑推理的深度,而在于视觉表征的准确性。

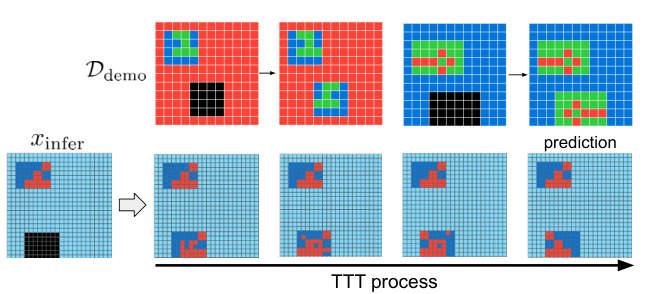

测试时训练赋予模型即时适应能力

ARC基准测试的一大难点在于其少样本特性。

对于测试集中的每一个新任务,模型只能看到极少数(通常是2到4个)演示示例,然后必须立即对新的输入进行推理。

这要求模型具备极强的快速适应能力,类似于人类的学习过程——看一眼就能懂。

为了实现这一能力,VARC采用了一种被称为测试时训练(Test-Time Training, TTT)的策略,让模型在推理阶段能够根据当前任务进行实时调整。

测试时训练的过程可以被视为一种临时的微调。

当模型面对一个新的测试任务时,它并不会直接调用离线训练好的参数进行预测,而是先利用该任务提供的少量演示示例对自身进行一轮快速训练。

模型从离线训练得到的通用参数出发,针对当前任务特定的转换规则优化其内部权重。

为了解决演示样本过少可能导致的过拟合问题,研究团队再次利用了视觉增强技术。

通过对仅有的几个演示示例进行翻转、旋转、颜色置换等操作,模型能够在瞬间生成大量的辅助训练数据。

这就像是人类在解题前,会在脑海中把题目给出的例子反复演练、变换角度观察,直到确信自己掌握了其中的规律。

每个辅助任务都被分配了一个独立的任务嵌入向量,帮助模型区分不同的变换模式。

这一过程不仅提升了模型的适应性,还揭示了关于学习机制的一个重要发现:针对每个测试任务独立进行微调,比将所有测试任务混合在一起进行微调效果要好得多。

实验数据显示,独立微调的策略比联合微调高出了约10个百分点的准确率。

这说明ARC中的不同任务之间虽然共享底层的视觉物理规律,但在具体的规则实现上是高度独立的。试图同时掌握所有新任务的规则,反而会造成任务间的干扰,导致模型“贪多嚼不烂”。

从图中可以清晰地看到测试时训练的威力。

随着在演示示例上的微调步骤不断推进,模型对推理输入的预测结果逐渐从模糊、错误变得清晰、准确。

这种动态的学习过程,使得VARC不再是一个静态的知识库,而是一个具备实时学习能力的智能体。

它不仅记住了离线训练中见过的40万个样本对所蕴含的普遍规律,还能灵活地将这些规律应用到前所未见的新情境中。

为了进一步确保预测的可靠性,VARC在推理阶段还引入了多视图推理机制。

这是一种借鉴自经典计算机视觉领域的集成策略。

由于模型在画布上具有平移和缩放不变性,对于同一个输入网格,可以通过随机的平移和缩放生成多个不同的“视图”。

模型对这些视图分别进行预测,然后通过多数投票的方式汇总结果。

这种做法有效地消除了单一视角下可能产生的偶然性错误,利用统计学的力量提升了最终答案的准确度。

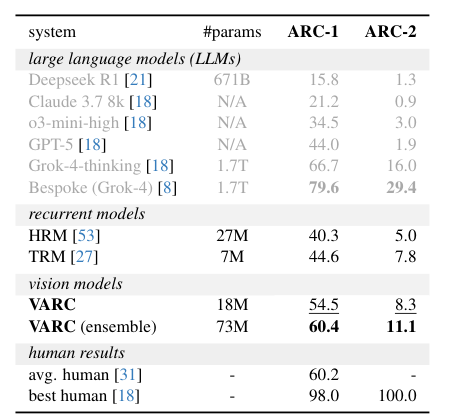

小模型战胜大语言模型的实证分析

VARC框架的提出,最直观的冲击力来自于其在性能对比上的压倒性优势。

在ARC-1基准测试中,仅有18M参数的VARC单模型就达到了54.5%的准确率,而通过集成一个ViT模型和一个U-Net模型,准确率更是攀升至60.4%。

相比之下,那些动辄数千亿参数的大语言模型在这一任务上显得步履维艰。

即便是备受瞩目的GPT-5,在该基准上的得分也仅为44.0%,而拥有6710亿参数的DeepSeek R1仅得到15.8%。

这种巨大的反差揭示了人工智能领域的一个重要真理:规模并非万能,归纳偏置(Inductive Bias)的适配性才是关键。

大型语言模型虽然阅尽了互联网上的浩瀚文本,学习了极其丰富的人类知识,但其底层的Transformer架构是为处理一维序列数据而优化的。

当面对ARC这种本质上是二维视觉和物理规律的谜题时,将网格强制拆解为文本序列,实际上是在破坏数据原本的结构。

LLM不得不花费巨大的参数容量去重新学习那些在视觉模型中显而易见的空间关系,这无疑是事倍功半。

相比之下,VARC模型的参数量仅为LLM的万分之一甚至更少,但其架构设计天然契合任务的本质。

卷积操作和2D位置嵌入使得模型能够高效地捕捉局部特征和空间依赖,画布上的数据增强则直接注入了物理世界的先验知识。

这种精准的架构适配,使得小模型能够爆发出超越大模型的能力。

VARC不仅击败了通用的LLM,也大幅超越了专门为ARC设计的递归模型,如HRM和TRM。

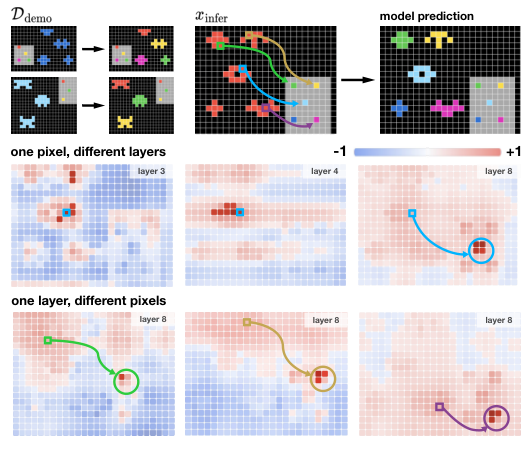

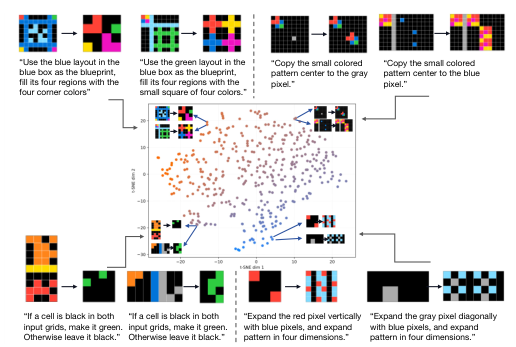

通过对模型内部机制的可视化分析,研究人员进一步确认了VARC并非在进行简单的模式匹配,而是真正发生了类似于推理的过程。

注意力图(Attention Maps)显示,模型在处理任务时,注意力焦点会随着逻辑需求而移动。

在像素复制任务中,模型会精准地关注源像素;在几何扩展任务中,注意力会沿着特定的方向发散,如同探照灯一样扫描着网格,寻找符合规则的落点。

此外,对任务嵌入(Task Embeddings)的t-SNE可视化分析表明,模型在没有任何人工标注的情况下,自发地学会了对任务进行分类。

语义相似的任务,如涉及颜色填充的任务或涉及逻辑运算的任务,在嵌入空间中聚集在一起。

这证明模型已经具备了将具体任务抽象化、并提取其底层逻辑结构的能力。这种能力正是抽象推理的核心,也是通往通用人工智能(AGI)的必经之路。

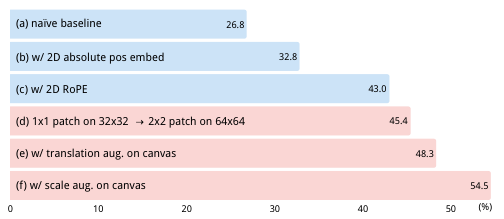

消融实验的数据更是量化了视觉先验的价值。

如果剥离掉画布、缩放增强等视觉组件,仅保留最基础的模型结构,准确率会直接跌落至26.8%。

这说明VARC的成功并非源于某种神秘的黑盒魔法,而是源于每一个精心设计的视觉组件的叠加。

从32.8%到45.4%,再到最终的54.5%,每一步提升都对应着一个具体的视觉概念被注入模型之中。

VARC框架的成功证明了在人工智能的发展路径上,并非只有堆砌算力和数据这一条路,回归问题本质,选择最适合的感知模态,往往能以极小的代价撬动极大的智能。

视觉智能或许才是通往机器抽象推理的最短路径。

参考资料:

https://arxiv.org/abs/2511.14761

END

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?