Meta最新的SAM 3,让分割模型学会了理解你说的话,而不仅仅是你指的东西。

计算机视觉里的Segment Anything Model (SAM,分割一切模型) 系列,一直在干一件事,就是把图像视频里你想要的东西给“抠”出来。

2023年的老大SAM 1,像个刚学会指认东西的婴儿。你给它一张图,用鼠标点一下、画个框,它就把那个东西的轮廓给你描出来。它开创了一个时代,让模型学会了零样本泛化,不用提前训练就能分割没见过的东西。它的三段式架构,提示编码器、图像编码器、掩码解码器,成了后来者的基石。

2024年的老二SAM 2,学会了看视频。它有了记性,能在连续的画面里一直跟着一个目标。这就解决了视频对象分割(VOS)的难题。它用上了Transformer架构,靠着对前面画面的记忆来预测下一帧里目标的位置,实现了实时跟踪。

到了2025年,老三SAM 3来了。它被投到顶会ICLR 2026,现在还在被大神们匿名评审。它干了件更颠覆的事,学会了听“概念”。你不用再指指点点,直接用文字告诉它“红色的苹果”或者“所有条纹猫”,它就能心领神会,把图里所有符合描述的东西都给你找出来,一个不落。

SAM系列就这样,从一个听话的工具,进化成了一个能理解语义的多模态模型。

SAM学会了思考

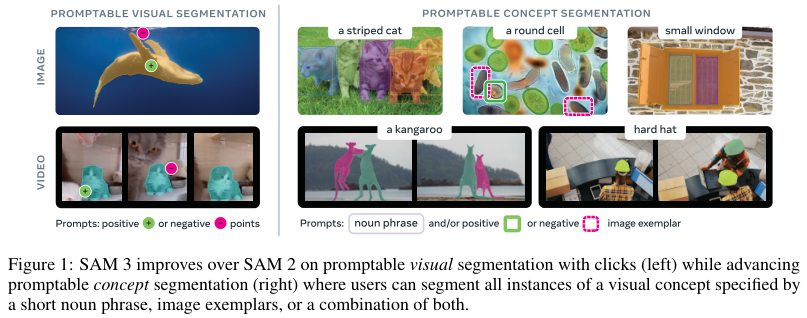

SAM 3的论文提出了一个新玩法,叫可提示概念分割(Promptable Concept Segmentation, PCS)。

就是你给它一张图或者一段不超过30秒的短视频,然后用一句话、一张示例图,或者两者结合的方式告诉它你要找什么“概念”,它就得把这个概念下的所有实例都检测、分割、并跟踪出来。

这事儿有几个核心的难点和亮点。

首先是开放词汇。它不像以前的分类模型,只能认识固定的几百几千个类别。PCS支持你输入任何名词短语,比如“一只快乐的狗”或者“没关紧的窗户”。

其次是全实例分割。以前的SAM,你点一下,它给你一个结果。现在你跟它说“车”,它就得把画面里所有的车都找出来,并且在视频里,还得认准了哪辆是哪辆,不能跟丢了。

再者是多模态提示。你可以只用文字,全局生效。也可以在某一帧上画个框,告诉它“这个是正样本”或者“这个不是”,让它举一反三。当然,文字和图像示例混着用也行。

最后是用户交互。它抠出来的图要是不够完美,你可以继续用点击的方式告诉它哪里多了,哪里少了,进行微调。

这个任务最大的挑战,在于“概念”本身是模糊的。你说“小窗户”,多小算小?带百叶窗的算不算?为了应对这种人类语言里的不确定性,SAM 3从数据收集、评估指标设计到模型构建,每一步都把这种歧义性考虑了进去。

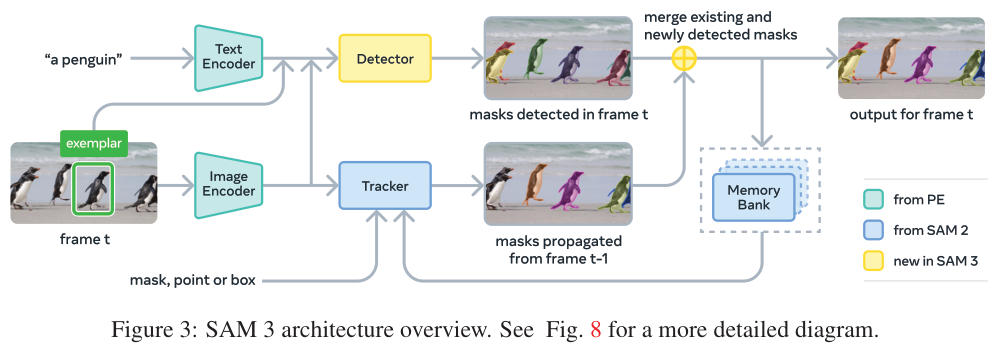

要完成这么复杂的任务,模型架构自然不能简单。SAM 3的架构在SAM 2的基础上做了扩展,既能玩新的PCS任务,也兼容老的可提示视觉分割(PVS)任务。它用了双编码器-解码器的Transformer架构,里面有一个负责图像的检测器,还有一个负责视频的跟踪器和记忆模块。

检测器的设计思路,借鉴了DETR(DEformable TRansformer)的范式。图片和文字提示先进去编码,要是有图片示例,也一并编码。这些编码后的信息,统称为“提示标记”。然后,一个融合编码器把这些提示标记和图像信息“搅拌”在一起。最后,一个类似DETR的解码器,通过学习到的对象查询,从融合后的信息里把目标一个个“揪”出来。

每一层的每个对象查询,都会预测两样东西:一个分类结果(这是不是你要找的东西?)和一个边界框的微调。它还用了一个叫“存在标记”(Presence Token)的聪明设计。

这个“存在标记”是SAM 3的一大创新。它把“识别”(这是什么)和“定位”(这东西在哪)这两件事给分开了。

在以前的检测模型里,模型得同时回答“有没有猫?”和“猫在哪里?”这两个问题,有时候会把自己搞糊涂。尤其是在找多个目标的时候,很容易顾此失彼。

SAM 3引入的这个存在标记,是个全局的、可学习的标记。它的唯一工作,就是判断你说的那个概念。

这个设计极大地提升了检测的准确率,尤其是在训练那些带否定词的短语时,比如“没有花的树”。论文里的消融实验显示,加上存在标记后,CGF1(分类门控F1)这个核心指标提升了5.7个点,主要是图像级的识别能力变强了。

SAM 3不仅能听懂文字,还能看懂例子。你可以给它一些带标签的边界框作为图像示例。比如,在一张有很多动物的图里,你圈出一只狗,标记为“正样本”,它就会去找到图里所有其他的狗。这和SAM 1、2那种点一下只出一个结果的模式完全不同,这是真正的举一反三。

对于视频,SAM 3用检测器加跟踪器的组合拳来处理。每一帧画面来了,检测器先找出新出现的目标,同时,跟踪器会把上一帧已经跟踪到的目标传播到当前帧。然后通过一个匹配函数,把新检测到的和跟踪过来的目标合并、更新,实现连贯的跟踪。

为了解决视频里常见的遮挡、拥挤等问题,它还设计了两套时间消歧策略。一是根据一个目标在过去一段时间内被稳定检测到的频率来打分,分数低的就抑制掉。二是用置信度高的检测结果,定期去“校准”跟踪器,防止它跟丢了或者跟错了。

在得到初步的分割结果后,用户还可以用点击来精修。这个过程和SAM 1、2类似,编码点击信息,然后解码器输出一个调整后的掩码。在视频里,这个调整会自动传播到整个片段。

它给自己造了个数据工厂

要让SAM 3学会PCS这种新技能,需要的数据量和多样性是任何现有数据集都无法满足的。所以,研究团队干脆自己动手,造了一个高效的“数据引擎”。

这个引擎的核心思想是一个反馈循环。SAM 3、人类标注员、AI标注员,三者协同工作。引擎会主动去挖掘当前版本SAM 3搞不定的“媒体-短语”组合,也就是专挑模型的弱项进行训练,从而高效地提升模型能力。

更绝的是,他们把一些人类标注员的工作,比如验证掩码质量,也交给了AI。这些AI标注员在特定任务上的表现已经能媲美甚至超过人类。这么一来,整个数据生产的吞吐量直接翻倍。

这个数据引擎的开发分了四个阶段,AI的参与度越来越高,人类则越来越专注于那些最困难、最需要创造力的环节。

一开始,数据引擎还比较原始。随机抽图,用简单的字幕模型和解析器来生成名词短语(NP)提案,然后让SAM 2生成候选掩码,最后完全由人类来验证这些掩码的质量和是否找全了所有实例。这个阶段积累了430万个图像-NP对,构成了初始数据集SA-Co/HQ。

到了第二阶段,事情变得有趣了。团队用第一阶段收集到的人类“接受/拒绝”标签,微调了一个Llama 3.2模型,创造出了AI验证员。这个AI能自动完成大部分掩码验证(MV)和穷举性验证(EV)工作,判断掩码质量好不好,以及有没有漏网之鱼。人类标注员从此解放出来,可以专注于AI搞不定的硬骨头。随着SAM 3和AI验证员的不断迭代升级,数据生产进入了快车道,这个阶段为数据集增加了1.22亿个图像-NP对。

第三阶段的目标是扩展。一方面,用AI去挖掘更有挑战性的案例。另一方面,把数据领域扩展到15个不同的数据集。他们还利用维基数据构建了一个包含2240万个节点的本体论,从中挖掘长尾、细粒度的概念,让模型的知识面更广。这个阶段又增加了1950万个图像-NP对。

最后,引擎扩展到了视频。视频标注的难度远超图像。团队让已经相当成熟的SAM 3来生成视频中的掩码片段,然后让人类标注员重点关注那些拥挤、容易跟丢的失败案例。最终,他们收集了一个包含52500个视频和467000个掩码片段的视频数据集SA-Co/VIDEO。

这个数据引擎本身,就是一项杰出的AI工程。

新考卷上的成绩怎么样?

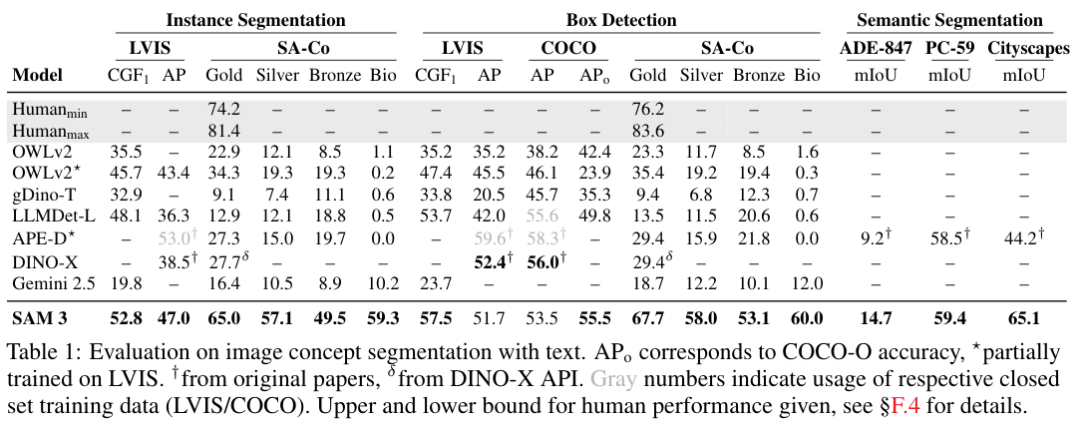

有了强大的模型和数据引擎,是时候看看SAM 3的真实水平了。为此,团队不仅构建了庞大的训练数据集SA-Co,还专门打造了一套全新的评估基准,也叫SA-Co。

这个基准测试堪称“地狱难度”。它总共包含了21.4万个独特的短语,12.6万张图片和视频,还有超过300万个带“困难否定”标签的样本,专门用来测试模型的开放词汇识别能力。它的概念覆盖范围,比现有所有基准加起来还要大50倍。

评估指标也经过了精心设计。传统的检测指标比如平均精度(AP)不关心模型的置信度校准,导致模型可能在实际使用中并不好用。SA-Co基准只评估置信度高于0.5的预测,模拟了真实应用的场景,逼着模型做出靠谱的判断。

核心指标叫分类门控F1(CGF1),它同时考察了定位能力(pmF1)和分类能力(IL MCC)。简单说,你不仅要找得准,还得先判断对图里到底有没有这东西。

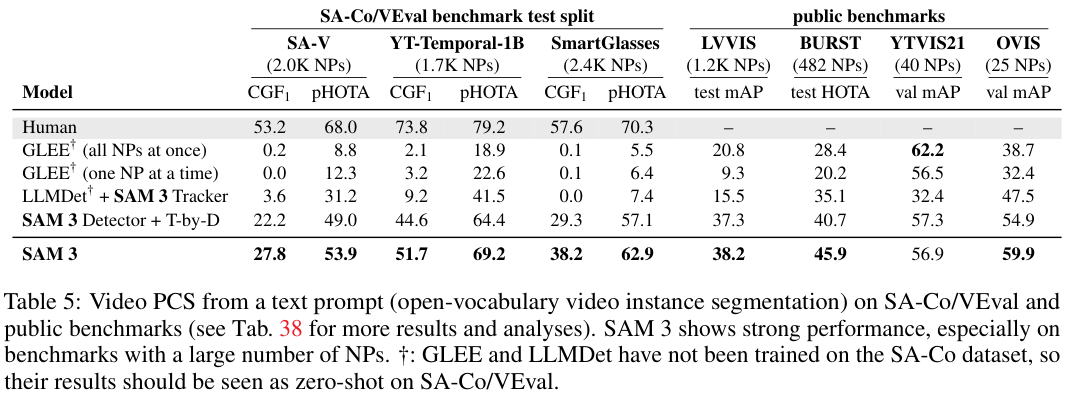

在图像PCS任务上,SAM 3和一众高手进行了比较,包括OWLv2、GroundingDino等专业检测模型,以及Gemini 2.5 Flash这样的通用大模型。

结果是碾压性的。在开放词汇的SA-Co/Gold基准上,SAM 3的CGF1分数达到了最强基线OWLv2⋆的两倍,并且已经达到了人类标注员预估性能下限的88%。在LVIS数据集上,它的零样本掩码AP达到了47.0,比之前的最好成绩高出一大截。

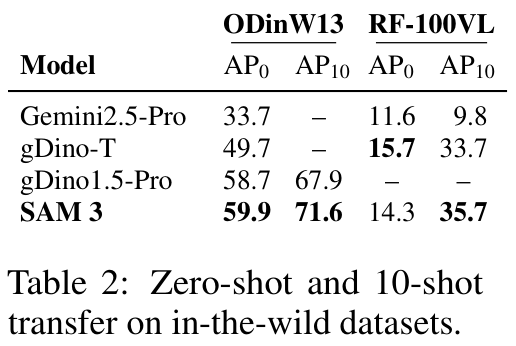

在少样本适应性测试中,SAM 3也展示了强大的学习能力。只需10个样本进行微调,它在ODinW13和Roboflow100-VL这两个数据集上的表现就超过了Gemini和专业的检测模型gDino。

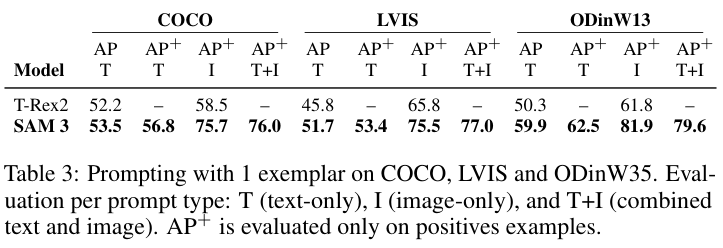

当使用图像示例进行提示时,SAM 3同样表现出色,在COCO、LVIS等数据集上显著优于之前的SOTA模型T-Rex2。

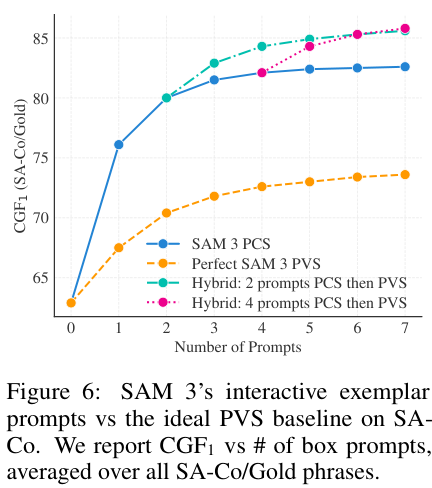

在模拟人类交互的实验中,SAM 3的PCS能力比传统的PVS(点一下改一个)效率高得多。因为它能从你给的示例中泛化,比如你告诉它一个漏掉的目标,它会主动去寻找其他类似的目标。仅仅3次点击交互,PCS的CGF1分数就比纯文本提示高了18.6个点。

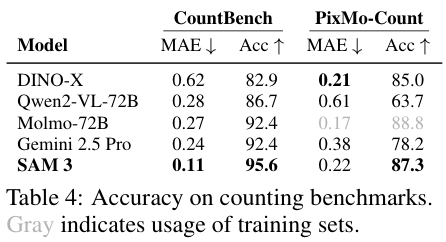

有趣的是,SAM 3还能用来数数。在对象计数基准上,它的准确率和平均绝对误差都优于Qwen2-VL-72B、Gemini 2.5 Pro等一众强大的多模态大语言模型(MLLM)。而且,它在数数的同时,还能把每个对象都给你分割出来,这是绝大多数MLLM做不到的。

在视频PCS任务上,SAM 3同样大幅领先基线模型,证明了其在复杂动态场景下的强大分割与跟踪能力。

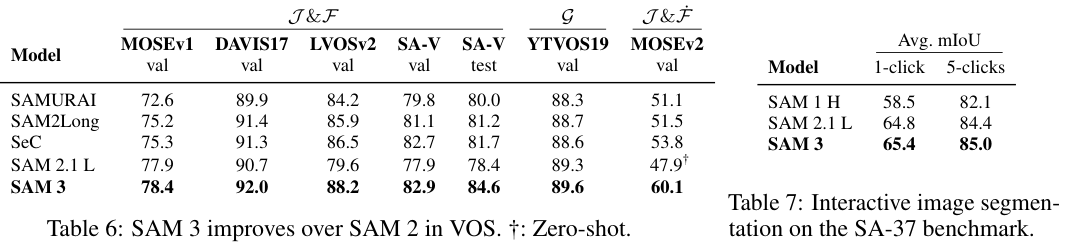

即使是在传统的PVS任务上,SAM 3也比它的前辈SAM 2更强,无论是在视频对象分割还是交互式图像分割上,都取得了更好的成绩。

当SAM有了个“大脑”

SAM 3本身是一个强大的视觉工具,但它的语言理解能力仅限于名词短语。如果把它和一个真正的多模态大语言模型(MLLM)结合,会发生什么?

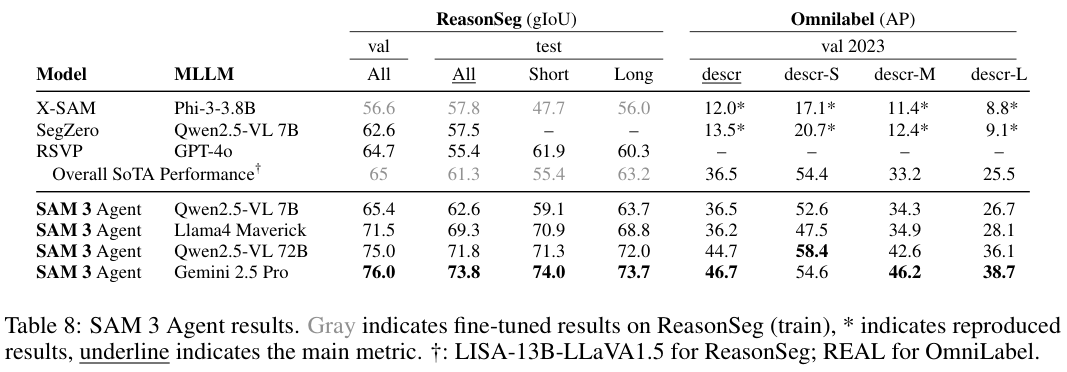

研究团队做了一个实验,他们把SAM 3当作一个工具,交给一个MLLM来调用,组成了一个所谓的“SAM 3 Agent”。这个Agent可以处理更复杂的、带有逻辑推理的文本查询,比如“坐着但不拿礼物盒的人”。

MLLM负责理解这个复杂句式,把它分解成SAM 3能听懂的简单名词短语(比如“人”、“礼物盒”),然后指挥SAM 3去执行分割,并分析返回的结果,通过逻辑运算(比如求“人”的掩码与“礼物盒”掩码的差集)得到最终答案。

结果惊人。在ReasonSeg和OmniLabel这两个专门测试推理分割的基准上,零样本的SAM 3 Agent全面超越了之前所有经过专门训练的模型。这证明了SAM 3作为一个基础视觉工具的强大和通用性。它可以和各种MLLM即插即用,赋予它们强大的视觉感知和操作能力。

性能方面,SAM 3在一块H200 GPU上处理一张包含100多个对象的图像,只需要30毫秒。处理视频时,只要并发对象不超过5个,基本能做到实时。

当然,SAM 3并非完美。它在医疗影像、热成像这类专业领域的泛化能力还很有限。

在视频中遇到目标特别多的拥挤场景,性能也会下降。

而且,它对语言的理解还停留在短语层面,无法处理复杂的句子,更不具备MLLM那样的语言生成和复杂推理能力。

SAM 3通过引入可提示概念分割,成功地将分割模型从一个简单的视觉交互工具,升级为了一个能理解语义概念的视觉-语言多模态模型。

它的出现,以及其背后那套强大的数据引擎和评测基准,为整个计算机视觉领域树立了新的标杆。

参考资料:

https://openreview.net/forum?id=r35clVtGzw

https://arxiv.org/abs/2304.02643

https://arxiv.org/abs/2408.00714

END

4274

4274

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?