字节刚刚开源了Depth Anything 3 (后面简称DA3) 。

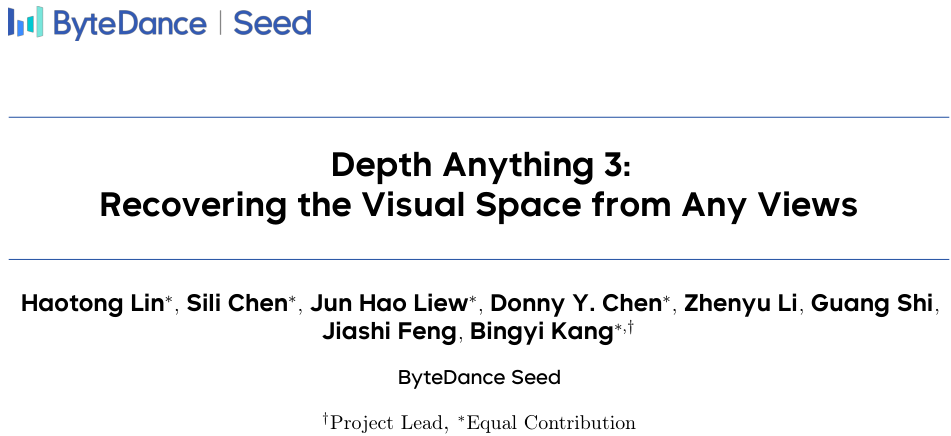

实现了视觉三维感知领域的重要突破,它能从任意数量、任意视角的视觉输入中,恢复出空间一致的三维几何结构。

,时长00:37

人类天生具备从眼睛看到的画面中理解空间的能力,这种能力是机器人导航、混合现实等前沿科技应用的核心。

为了在机器上复现这种能力,计算机视觉领域衍生出一系列看似不同却又紧密相关的任务,比如从单张图片估算距离远近的单目深度估计(Monocular Depth Estimation),从移动的画面中恢复物体结构的运动恢复结构(Structure from Motion),利用多个视角的图像生成三维模型的的多视图立体视觉(Multi-View Stereo),以及让机器在未知环境中实时定位并构建地图的同时定位与地图构建(Simultaneous Localization and Mapping)。

这些任务的本质目标都是理解三维空间,区别常常只在于输入的是一张图、多张图还是一段视频。

过去,主流的研究范式是为每一个细分任务设计一套高度专门化的模型和算法。

这种一个萝卜一个坑的模式,虽然在特定场景下效果不错,却导致了技术上的壁垒和资源上的浪费。

近期虽有研究尝试构建统一模型来处理多个任务,但它们往往依赖于复杂且定制化的架构,需要从零开始进行联合优化训练,这使得它们难以有效利用今天已经非常强大的大规模预训练模型的知识。

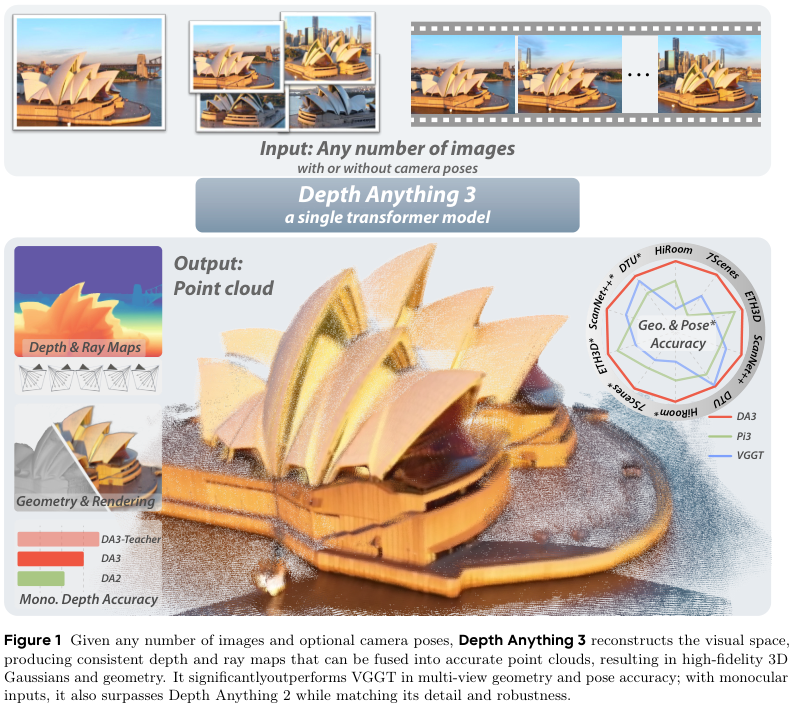

为了实现这个目标,DA3摒弃了繁杂的架构工程,采用了一种极简的建模策略。

一个最小化的预测目标集合,就能完整地描述三维几何。

一个普通的、未经特殊改造的Transformer模型,足以胜任这个统一建模。

一个极简模型统一了复杂的3D世界

DA3巧妙地将所有三维几何重建任务,统一表述为一个简单的密集预测问题。

具体来说,给定N张输入图像,模型的核心任务就是输出N个与之对应的深度图和射线图。

深度图告诉我们每个像素点的远近,而射线图则记录了每个像素点在空间中的方向和原点。

实现这一目标的架构出奇地简洁。

它的主干网络是一个标准的、已在海量图像数据上预训练过的视觉Transformer,例如DINOv2。

这使得DA3可以直接站在巨人的肩膀上,继承其强大的图像特征提取能力。

处理任意数量的视图是这类统一模型的关键难点。

DA3引入了一个核心创新:输入自适应的跨视图自注意力机制。

这个机制并不需要修改Transformer的底层结构,而是在模型进行前向传播时,在特定的网络层动态地重新排列token,让来自所有输入视图的信息能够高效地交流和融合。

具体实现上,DA3将Transformer的网络层分为前后两组,比如前三分之二的层专注于在单张图像内部处理信息,而后三分之一的层则在跨视图信息交互和视图内信息处理之间交替进行。

这种设计是输入自适应的,当输入只有一张图像时,模型会自动退化为标准的单目深度估计模式,不会产生任何额外的计算开销。

在预测阶段,DA3提出了一个新的双DPT(Dense Prediction Transformer)头,它接收来自主干网络的同一组特征图,然后通过两套使用不同融合参数的分支,同时输出最终的深度图和射线图。

这种设计鼓励两个预测任务之间进行深层的信息共享,同时又避免了产生冗余的中间表示,既高效又精准。

为了增加模型的灵活性,使其能适应各种真实场景,DA3还设计了一个轻量级的相机编码器。

如果输入图像的相机位姿(位置、朝向、焦距等)是已知的,这些信息就可以通过这个编码器整合到模型中,为几何重建提供明确的约束。

如果位姿未知,模型也能正常工作。这种整体设计,最终形成了一个干净、优雅且具备良好扩展性的架构,能够直接受益于其预训练主干模型的规模效应。

用深度-射线表示法解构三维空间

传统方法中,直接预测相机的旋转矩阵(Rotation Matrix)是一个棘手的技术难题,因为它必须满足严格的正交约束。

为了绕开这个难题,DA3采用了一种更巧妙的隐式表示方法:用与每个像素点对齐的射线图(Ray Map)来替代直接预测相机位姿。

空间中的一条射线可以由它的原点(Origin)和方向(Direction)唯一确定。

对于图像上的每一个像素点,都可以想象有一条光线从相机中心出发,穿过这个像素点,射向三维空间中的某个物体点。

这条光线的原点就是相机中心的位置,方向则是从相机中心指向该像素点的向量。

DA3的模型就为输入图像的每个像素点预测这样一个六维的射线参数(三维原点坐标+三维方向向量),形成一张密集的射线图。

同时,模型还预测一张对应的深度图,告诉我们每个像素点代表的物体沿着对应射线方向的距离。

有了深度图和射线图,三维空间的重建就变得异常简单:三维点坐标 = 射线原点 + 深度值 × 射线方向。

这个公式用最基础的向量运算,就将二维图像信息还原到三维世界中,并且由于所有像素的射线原点和方向都在一个统一的世界坐标系下,生成的点云自然就是空间一致的。

这种深度-射线表示法构成了一个最小且完备的目标集,它既能精确描述场景的几何结构,又能隐式地编码相机的运动信息,效果优于之前工作所采用的点图(Point Map)或其他更复杂的输出组合。

虽然这个表示法很优雅,但在推理时,如果需要从预测出的密集射线图中反向求解出相机的精确位姿参数(如旋转矩阵、焦距等),计算会比较耗时。

为了解决这个实际应用中的不便,DA3额外增加了一个极其轻量级的相机头,它专门处理与每个视图关联的相机camera token,直接预测出相机的视场、旋转(以四元数形式)和平移参数。

因为每个视图只有一个这样的token,所以增加的计算成本几乎可以忽略不计,却大大方便了下游应用。

老师教学生,解决了数据质量的根本矛盾

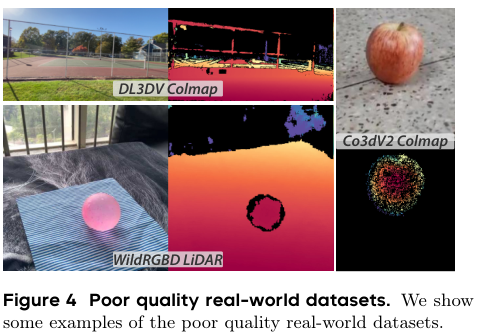

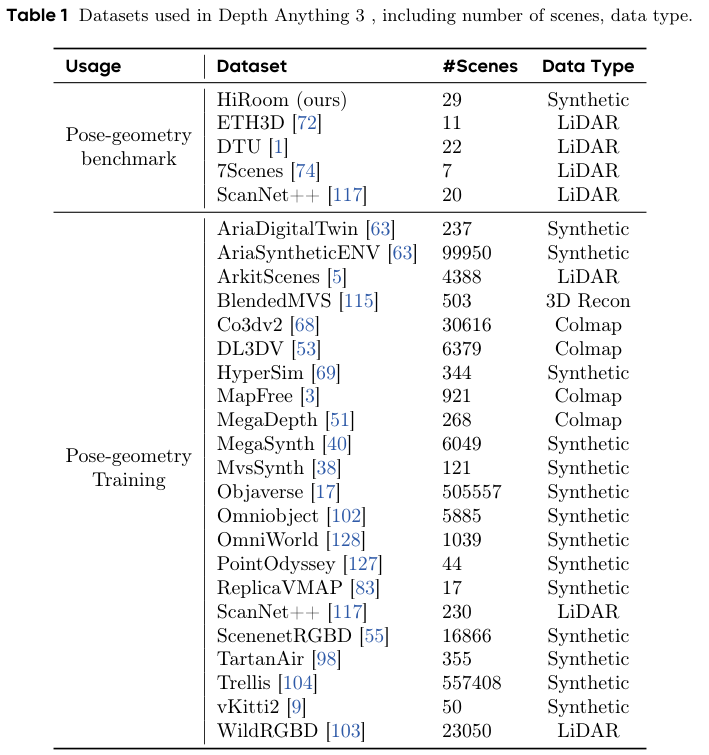

要训练一个能处理各种场景的通用模型,就需要海量且多样化的训练数据。

这些数据来源各异,包括真实世界中用深度相机采集的数据、通过三维重建技术生成的数据,以及完全由计算机合成的数据。

这里存在一个核心矛盾:真实世界的数据虽然宝贵,但质量往往不尽人人意。

例如,消费级的深度相机采集的深度图常常充满噪声、存在空洞,或者在物体边缘处非常模糊。

而合成数据虽然可以生成完美、稠密的深度标签,但与真实世界之间始终存在一道次元壁,模型在合成数据上学到的知识可能无法很好地泛化到真实场景。

为了解决这个难题,DA3采用了一种高效的教师-学生范式。

首先,DA3团队构建了一个异常强大的教师模型。

这个教师模型只在海量的、高质量的合成数据上进行训练。

训练数据覆盖了室内、室外、以物体为中心以及各种野外场景,确保了教师模型具备了对精细几何细节的深刻理解。

这个教师模型本身就是一个顶级的单目深度估计模型,其架构与DA3的主框架保持一致,由DINOv2视觉Transformer和DPT解码器组成,没有任何花哨的修改。

与前代工作Depth Anything 2预测视差(Disparity,与深度成反比)不同,DA3的教师模型直接预测对下游任务更友好的深度。

为了解决深度值在近距离区域不敏感的问题,模型预测的是指数深度,这放大了近处物体的区分度。

这个教师模型训练好之后,就成为了一个高质量伪标签的生产工厂。

对于所有真实世界的训练数据,无论其原始的深度标签是稀疏的、有噪声的还是完全缺失的,DA3都用这个教师模型去预测一个密集、干净且细节丰富的相对深度图。

接着是关键的一步:对齐。

为了保证几何的准确性,DA3将教师模型生成的相对深度图,与原始数据中那些虽然不完美但包含了真实尺度信息的稀疏或有噪声的深度值进行对齐。

这个过程通过一个鲁棒的RANSAC(随机样本一致性)最小二乘法来完成,它能自动找到最佳的尺度和平移参数,将相对深度转换到真实的度量空间。

经过这个流程,原本质量参差不齐的真实世界数据,就被净化和增强了。

它们既保留了真实的几何约束,又拥有了由教师模型赋予的丰富细节和完整性。

最后,DA3的最终模型(即学生模型)就在这些高质量的、对齐过的伪标签上进行训练。

这种教师-学生范式,巧妙地绕过了真实世界数据质量差的难题,极大地提升了模型的学习效率和最终性能。

DA3的训练目标函数也经过精心设计,它综合考虑了深度图的准确性、射线图的准确性、最终重建点云的准确性、相机位姿的准确性以及深度图梯度的平滑性,通过多个损失项的加权和,引导模型向着生成高度一致且精确的几何结构的目标优化。

全新基准证明了模型的绝对领先

为了更全面、更公平地评估视觉几何估计模型的能力,并推动该领域的持续进步,DA3团队建立了一个全新的、综合性的基准测试。

这个基准不仅评估传统的深度图精度,还直接评估模型预测的相机位姿准确性,以及最终融合生成的3D点云的重建质量。

该基准涵盖了5个多样化的公开数据集,包括HiRoom、ETH3D、DTU、7Scenes和ScanNet++,总计超过89个场景,场景类型从单个物体级别,延伸到复杂的室内房间和广阔的室外环境。

评估流程分为两步。

第一步是位姿估计评估,模型需要处理一个场景中的所有(或最多100张)图像,以纯前馈的方式一次性输出所有相机的位姿,然后与真实的相机位姿进行比较,计算旋转和平移的精度。

第二步是几何估计评估,模型使用自己预测出的位姿和深度图,通过TSDF(截断符号距离函数)融合技术生成三维点云。生成的点云会先与真实的相机位姿进行对齐,然后与真实的场景点云进行比较,计算其准确性(Accuracy)、完整性(Completeness)和F1分数,这些指标能全面地衡量重建质量的好坏。

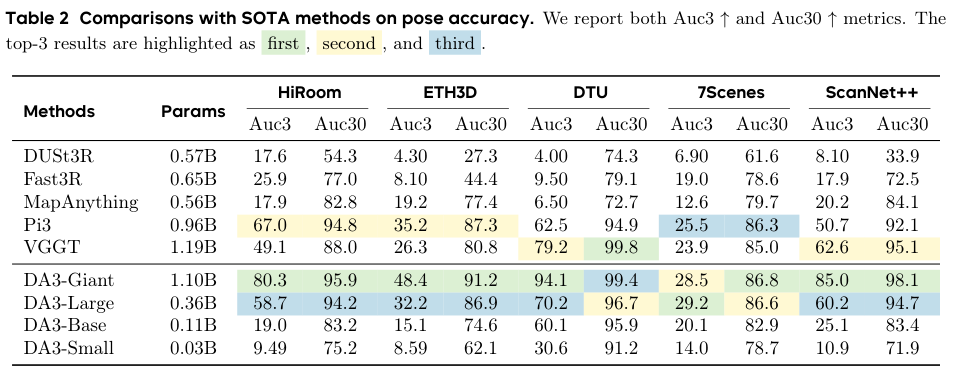

实验结果令人印象深刻。

在位姿估计方面,DA3-Giant模型(参数量最大的版本)在几乎所有指标上都超越了所有已知的基线方法。

尤其是在要求更严苛的精度阈值下(例如旋转和平移误差小于3度或3%),DA3的领先优势尤为明显,相对于所有竞争者实现了至少8%的相对性能提升。

在ScanNet++这个极具挑战性的数据集上,其相对增益更是高达33%。

在几何估计方面,无论是在位姿未知(pose-free)还是位姿已知(pose-conditioned)的设定下,DA3的表现都堪称统治级。

在所有五个数据集的无位姿设置中,DA3-Giant全面超越了所有对手,刷新了SOTA(State-of-the-Art)记录。

与之前的最佳模型VGGT相比,DA3-Giant的平均相对改进达到了惊人的25.1%。

更值得注意的是,即使是参数量小得多的DA3-Large版本(0.30B参数,约为Giant版本的三分之一),其性能也极具竞争力,在10个评测设置中的5个上超过了之前的SOTA模型VGGT(1.19B参数)。

这充分证明了DA3架构的卓越效率。

从可视化的结果来看,DA3重建的点云干净、准确、完整,并且保留了非常精细的几何细节,例如物体的纤薄结构和复杂的轮廓,其质量明显优于其他方法。

除了在多视图几何任务上的卓越表现,DA3在传统的单目深度估计基准测试中也展现了最先进的性能,其单目模型在NYUv2、KITTI等经典数据集上的表现优于其前身Depth Anything 2和其他竞争方法。

这证明了DA3的统一框架并未因为追求通用性而牺牲在特定任务上的专精能力。

驱动下游任务,开启3D应用新可能

一个强大的基础模型,其价值不仅在于自身性能的卓越,更在于它能作为基石,推动下游相关应用的发展。

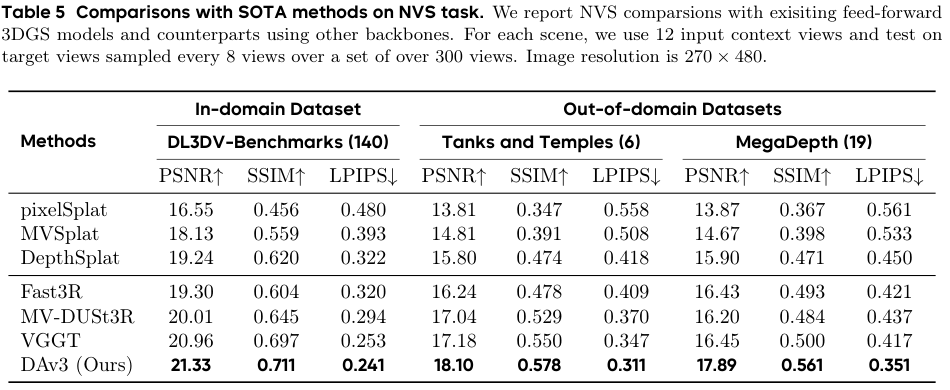

DA3团队选择了前馈新视角合成(Feed-Forward Novel View Synthesis, FF-NVS)这一热门且极具挑战性的任务,来展示DA3作为几何基础模型的潜力。

新视角合成的目标是根据一个场景的几张输入图像,合成出任意新视角的图像。

近年来,随着3D高斯散射(3D Gaussian Splatting, 3DGS)技术的兴起,这一领域取得了飞速发展。

3DGS用海量的三维高斯雪花来表示场景,渲染速度快且质量高。

DA3团队遵循其一贯的极简建模策略,在DA3模型的基础上,仅增加了一个额外的DPT头,用于预测与每个像素对齐的3D高斯参数(如不透明度、旋转、缩放和颜色)。

然后,通过对这个新模型进行微调,就能实现高质量的新视角合成。

DA3为此也建立了一个包含超过160个场景的、具有挑战性的FF-NVS基准测试。

大量的实验得出了两个关键结论:

-

将一个强大的几何基础模型(如DA3)微调用于新视角合成,其效果显著优于那些从零开始设计的、高度专业化的任务特定模型。这说明,精确的几何先验知识对于理解和渲染三维场景至关重要。

-

几何重建能力的提升,与新视角合成性能的改善,存在直接的正相关关系。DA3凭借其在几何重建上的绝对优势,自然而然地成为了当前该任务的最佳骨干网络。

DA3还进一步提出了一个位姿自适应的前馈3DGS版本。

这个版本可以直接使用DA3的预训练权重,无缝地处理带有或不带相机位姿的输入,并且能适应不同的图像分辨率和输入视图数量。

这使得它非常适合在真实世界(in-the-wild)的复杂环境中进行评估和应用。

Depth Anything 3通过回归本源的思考和极简主义的设计,证明了用一个单一、简洁的Transformer模型统一复杂多样的三维视觉几何任务是完全可行的。

它所采用的深度-射线表示法和教师-学生训练范式,为解决通用三维感知中的核心挑战提供了优雅且高效的解决方案。

DA3在全新的视觉几何基准上,将相机位姿准确率和几何准确率的SOTA记录分别提升了35.7%和23.6%,同时在单目深度估计和新视角合成等任务中也展现了顶级的性能。

所有模型仅在公开的学术数据集上进行训练,这进一步凸显了其强大的泛化能力。

参考资料:

https://github.com/ByteDance-Seed/Depth-Anything-3

https://depth-anything-3.github.io/

https://arxiv.org/abs/2511.10647

https://huggingface.co/spaces/depth-anything/depth-anything-3

END

1647

1647

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?