Self-Polish: Enhance Reasoning in Large Language Models via Problem Refinement

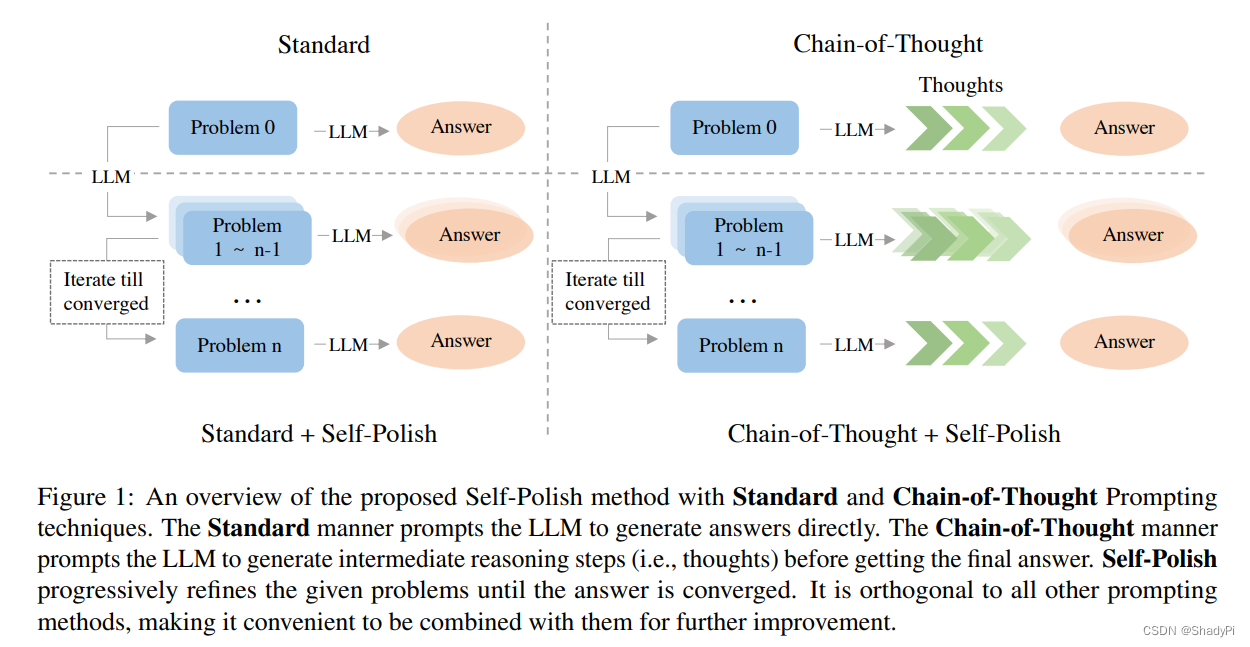

核心思想是通过instruction让LLM来优化问题本身,从而达到更好的效果,且这种针对问题的优化可以跟其他的prompt技术,如CoT或者Least-to-Most相结合。

作者提出了一些重述问题的准则:

(1)简短:问题不要太长,确保容易理解

(2)清晰:问题表述清晰,能量化的部分就量化

(3)聚焦:想问的问题应该突出

(4)清除无关信息

作者说因为不好构建数据库,所以训练一个模型来搞这件事很麻烦,他们转而寻求不用训练的办法。

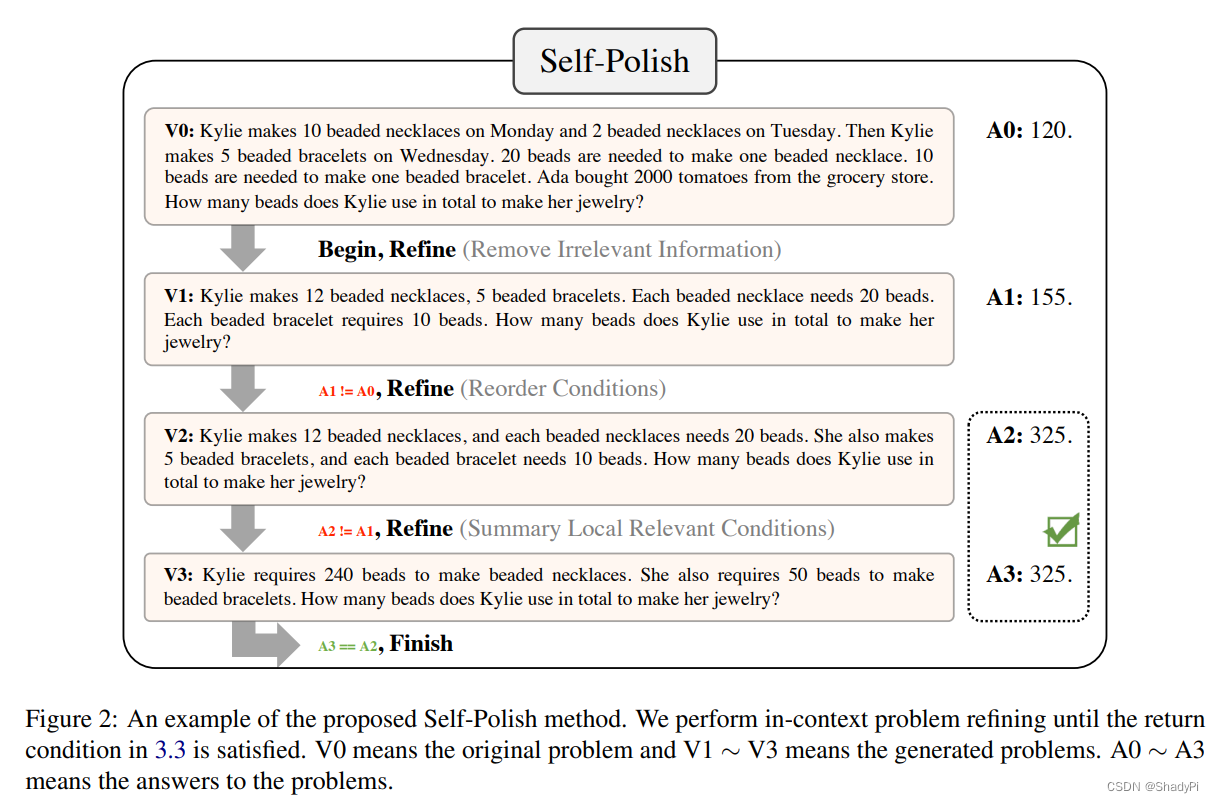

在zero-shot的setting下,方法很简单,通过给LLM instruction让LLM按照之前说的准则修改问题表述。而在few-shot的setting下,作者会展示一些样例给LLM,让LLM参照样例去移除无关信息、重排条件、整合相关条件等,如下

注意到右侧还有个An,按照作者的说法这是问题的答案,然而这个答案似乎不太对,显然左边的数学题答案应该是1220+510=290,不知道作者是粗心大意了还是LLM真的做错了😂总而言之,这个过程表达的意思是改进和做题交替进行,如果连续两次得到的答案相同,说明答案收敛,以此作为输出,作者称其为progressive problem-refining。

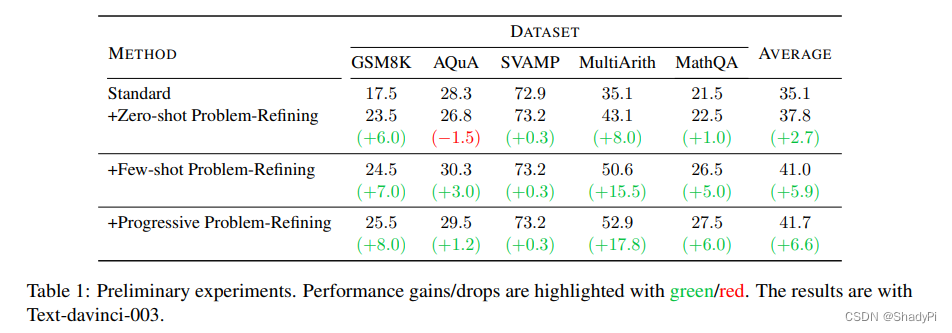

上述重写问题的效果则如下图所示,

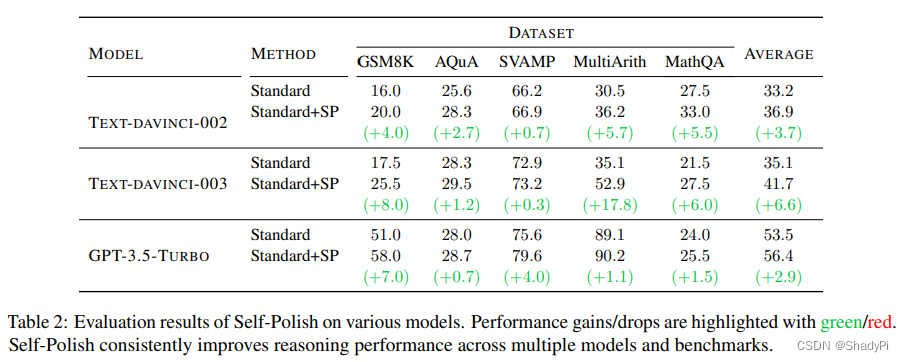

可以看到在davinci-003的情况下表现均有所提升,且基本上progressive>few-shot>zero-shot,说明refinement是有效果的。以及下面是在不同LLM上的效果。

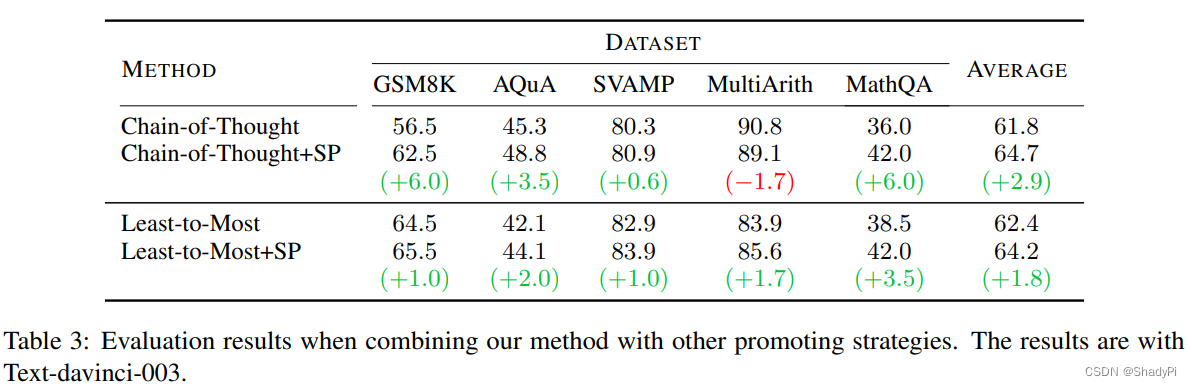

之后,作者还展示了该方法和其他prompt方法结合,比如CoT和Least-to-Most,均有提升。

最后,作者针对progressive中的两个变量:迭代次数和最终答案选取做了消融实验。结果表明迭代次数越多,性能提升越大。同时在迭代次数少的时候采信最后一次迭代的答案正确率高,而次数多了以后投票的正确率高。

作者介绍了一种名为Self-Polish的方法,通过指导大型语言模型(LLM)改进问题表述,提高推理效果。在零样本和少量样本设置下,这种方法通过逐步细化问题和比较答案收敛来提升性能。与其他prompt技术结合使用时也显示出增强效果。

作者介绍了一种名为Self-Polish的方法,通过指导大型语言模型(LLM)改进问题表述,提高推理效果。在零样本和少量样本设置下,这种方法通过逐步细化问题和比较答案收敛来提升性能。与其他prompt技术结合使用时也显示出增强效果。

860

860

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?