目录

“自然科学的发展除了按常规科学一点一滴地积累之外,还必然要出现‘科学革命’。”托马斯·库恩在其发表于 1962 年的经典著作《科学革命的结构》中提出的“范式转换”一词,如今已成为大家耳熟能详的技术用语。

大的“范式转换”存在于基础科学领域,小的“范式转化”也存在于几乎每个细分的技术领域。

语音识别新范式

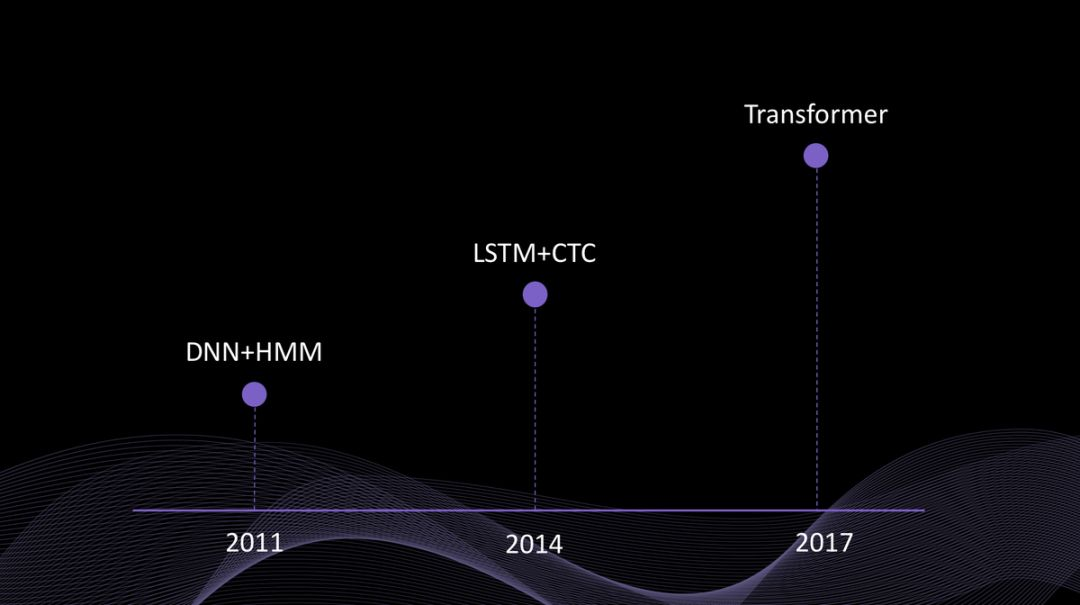

以自然语言处理的子领域“语音识别”为例,从 2012 年引入深度学习技术开始,语音识别的研究热点经历了三个阶段:

-

2011年前后,基于 DNN+HMM(深度神经网络+隐马尔科夫模型)的语音识别

-

2014年前后,基于 LSTM+CTC(长短时记忆网络+连接时序分类)的不完全端到端语音识别

-

2017年前后,基于 Transformer(自注意力机制)的完全端到端语音识别

如果说 2011 年深度学习的引入,是语音识别领域上一次范式转换的起点,那么从 2017 年开始,基于注意力机制和 Transformer 新型神经网络结构的语音识别研究,无疑标志着语音识别的新范式正在形成。

传统的语音识别主要框架包括:声学模型和语言模型。2011 年前后引入深度神经网络(DNN),主要目标是改进传统语音识别框架中的声学模型算法。2014

Transformer引领的语音识别新范式:端到端模型的优势

Transformer引领的语音识别新范式:端到端模型的优势

本文探讨了语音识别领域的范式转变,从DNN+HMM到Transformer的完全端到端模型。Transformer采用自注意力机制,解决了传统模型的局限,提升了语义特征提取和长序列建模能力。Transformer-XL进一步优化长序列处理,循环智能已将此技术应用于商业场景,提高语音识别准确率。

本文探讨了语音识别领域的范式转变,从DNN+HMM到Transformer的完全端到端模型。Transformer采用自注意力机制,解决了传统模型的局限,提升了语义特征提取和长序列建模能力。Transformer-XL进一步优化长序列处理,循环智能已将此技术应用于商业场景,提高语音识别准确率。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

519

519

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?