别名:

Lifelong learning

Continuous Learning

Never ending Learning

Incremental Learning

背景:

对于人工智能发展来说,具有以序列化方式学习任务的能力是非常重要的。

神经网络是不具有这个能力的,灾难性遗忘(catastrophic forgetting)是连接主义模型(connectionist models)不可避免的特点。

方法:

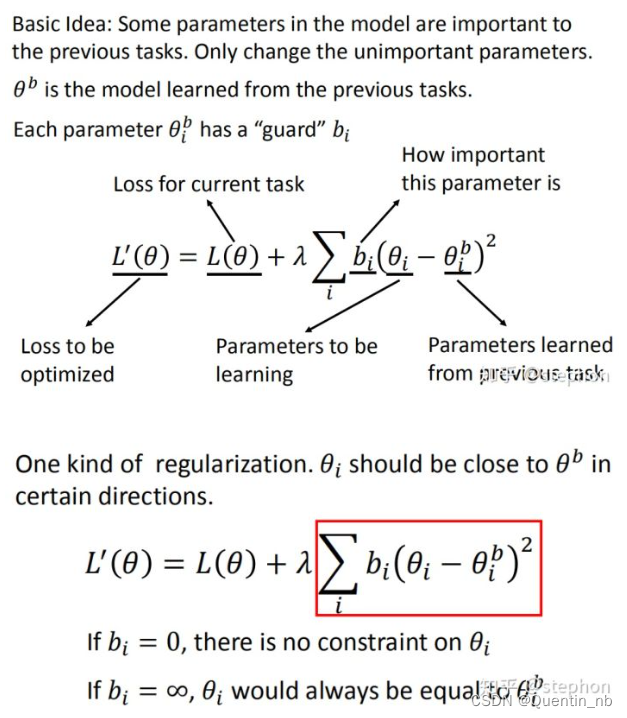

1.基于正则:EWC: Elastic Weight Consolidation

在loss方程中加入一项来巩固以前任务,减慢之前任务中重要参数的忘记的速率,单模型方法。

2.基于模型扩展:Model Expansion

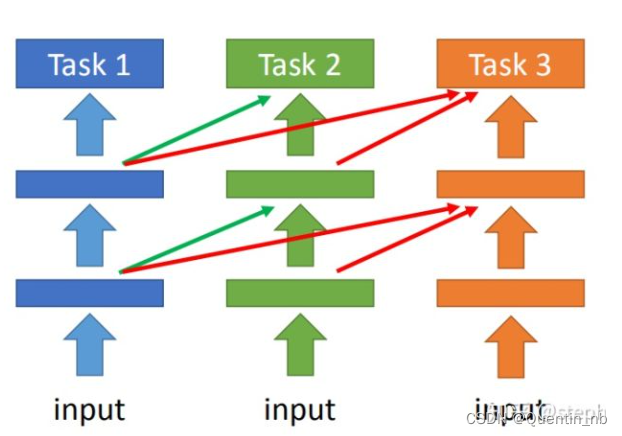

a.参数独立-----渐进式神经网络(Progressive Neural Network)

这类方法中,模型参数的不同子集被分配给不同的任务。当网络规模没有限制的时候,每个任务都可以拥有部分相应网络。进一步的想法是将过去任务对应的部分进行遮蔽进而避免更改,这种 mask 操作可以在参数权重层面上进行也可以在神经元甚至是模块层面进行。大多数这类方法需要一个先验任务定义去激活相应的遮蔽或者任务分支。

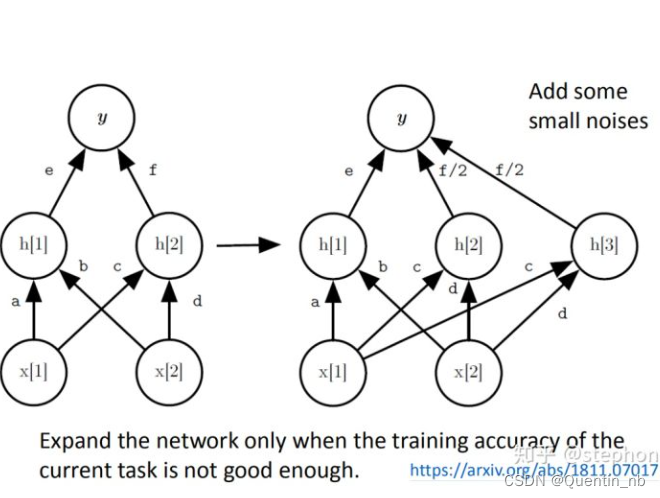

b.Net2Net

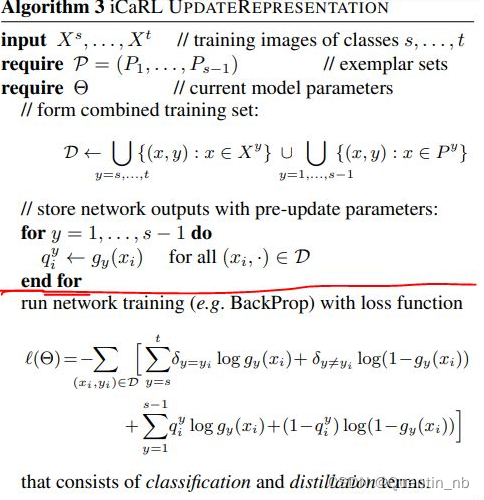

3.基于重演的方法--iCaRL

这类方法以原本形式存储样本或者在一个生成模型中存储样本的‘压缩版本’。存储的关于 过去任务样本/伪样本可以用于重演(rehearsal)/评估过去和现在任务的联合训练/限制新任务的优化不干预之前的任务。replay 方法的主要缺点是类别规模方面的限制,需要额外的计算去存储原始的输入样本。受限的存储空间也限制了原始分布的复现。除此之外,存储原始的样本往往涉及隐私问题。

红线上部分还是旧网络,使用旧网络针对存储的样本进行预测得到输出;红线下是针对全数据集的参数更新,即新样本的0-1loss和存储样本的蒸馏损失,算法结束后得到新网络。网络更新之后样本的存储也会相应发生变化:新样本按照和 prototype center 的距离添加,同时根据 memory size 会对之前样本进行调整(FIFO or others)。

重演的方式是存储过去任务的一个子集进行联合训练(蒸馏模拟预测),但是这个方法可能会有过拟合的问题,且当 memory 有限制的情况下,随着任务的增加会出现越来越大的限制。

4.基于数据:Multi-task learning with some modify

LifeLong Learning训练时只用当前任务的数据; 而Multi-task Learning会用到之前所有任务的数据。这带来了数据存储以及计算量不断增大的问题; Multi-task learning可以看作是LifeLong learning的upper bound

其实就是新的老的数据都扔进去喂。

考虑到实际数据存储的问题,会借助于GAN(GenerativeAdversarialNetworks,生成式对抗网络)来完成, 减少了数据存储,但带来了更大的计算量。

评价指标

没有统一:

有的地方按这三种:

①Accuracy 表征N个任务学完后总体的性能;

②Backward Transfer: 表征N个任务学完后,总体遗忘的程度;通常为负数,越大越好;

③Forward Transfer: 表征N个任务学完后,总体学习的程度;通常为正数,越大越好;

有的地方按这4种:

①平均准确度(Average Accuracy)

②遗忘速率(Forgetting Measure)

③学习曲线面积(Learning Curve Area

④在线学习评价(online codelength)

参考

1.continual learning summarycontinual learning summary - 知乎

2.持续学习论文阅读——CL in NLP: A Survey持续学习论文阅读——CL in NLP: A Survey - 知乎

3.2020机器学习前沿技术----LifeLong learning2020机器学习前沿技术----LifeLong learning - 知乎

4.Continual Lifelong Learning in Natural Language Processing: A Surveyhttps://arxiv.org/pdf/2012.09823.pdf

1191

1191

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?