本文为tensorboard的进一步使用,tensorboard的安装及最初使用方法见【tensorflow入门】10、可视化--Tensorboard的安装、使用、排雷

代码见文章最后。

一、踩雷!

本人跟着莫烦教程学习,莫烦教程视频中的tensorflow代码现在已不适用,我改了好久!

1、几个函数更新:

- tf.train.SummaryWriter 改为:tf.summary.FileWriter

- tf.merge_all_summaries() 改为:summary_op = tf.summary.merge_all()

- tf.histogram_summary() 改为:tf.summary.histogram()

- tf.scalar_summary() 改为:tf.summary.scalar()

否则会报错!

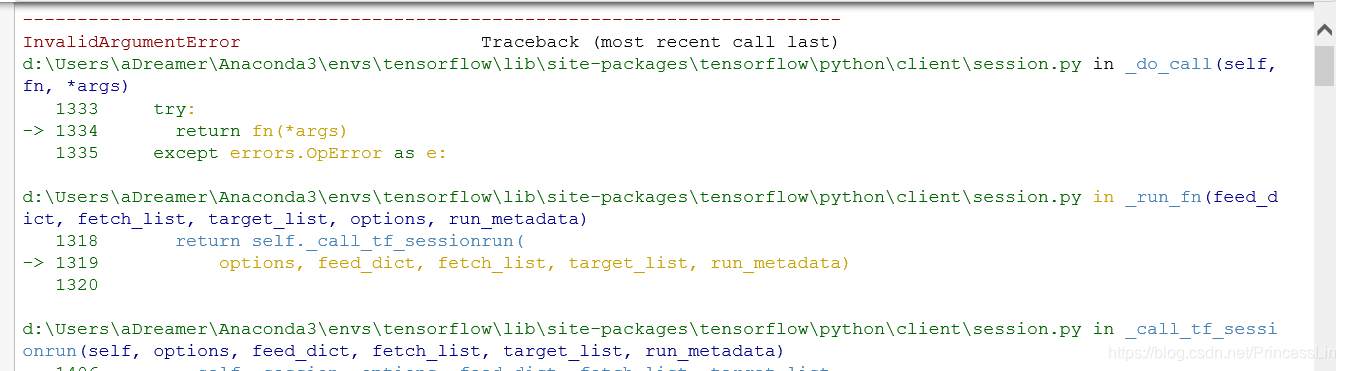

2、tensorboard的图好像每次只能使用一个,不然会报奇怪的错误:

错误特别长,报错的具体内容:

InvalidArgumentError: You must feed a value for placeholder tensor 'inputs/x_input' with dtype float and shape

本文介绍了在TensorFlow中使用TensorBoard进行直方图和标量信息的可视化过程中遇到的问题及解决办法,包括函数更新、图形冲突和显示异常。关键代码展示了如何创建scalar和histogram,并使用`tf.summary.merge_all()`和`tf.summary.FileWriter`进行数据写入。

本文介绍了在TensorFlow中使用TensorBoard进行直方图和标量信息的可视化过程中遇到的问题及解决办法,包括函数更新、图形冲突和显示异常。关键代码展示了如何创建scalar和histogram,并使用`tf.summary.merge_all()`和`tf.summary.FileWriter`进行数据写入。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?