✅作者简介:热爱科研的Matlab仿真开发者,擅长数据处理、建模仿真、程序设计、完整代码获取、论文复现及科研仿真。

🍎 往期回顾关注个人主页:Matlab科研工作室

🍊个人信条:格物致知,完整Matlab代码获取及仿真咨询内容私信。

🔥 内容介绍

在工业生产、精密制造、医疗手术等领域,机器人操纵器的精准控制直接决定了任务完成质量。无论是机械臂的平稳抓取,还是手术机器人的微米级操作,都对控制系统提出了极高要求——不仅要应对负载变化、摩擦干扰等外部不确定因素,还要克服自身动力学模型误差带来的影响。

传统控制方法(如PID控制)在模型精确、环境稳定的场景下表现尚可,但面对复杂多变的工况时,容易出现响应滞后、稳态误差过大甚至震荡等问题。而神经网络凭借强大的非线性逼近能力,成为解决机器人操纵器复杂控制问题的核心技术之一。其中,带有自适应偏置的RBF(径向基函数)神经网络,更是通过对偏置项的动态调整,进一步提升了控制的精准度和鲁棒性,成为当前机器人控制领域的研究热点。

一、基础认知:RBF神经网络与机器人操纵器控制的适配性

(一)RBF神经网络的核心特性

RBF神经网络是一种三层前馈神经网络,由输入层、隐含层和输出层构成。其核心优势在于采用径向基函数(如高斯函数)作为隐含层神经元的激活函数,具有局部逼近特性——即只有当输入信号落在神经元的“感受野”内时,该神经元才会被激活并参与计算。这种特性使得RBF神经网络能够以较少的神经元实现对复杂非线性函数的高精度逼近,且训练速度快、泛化能力强,非常适合处理机器人操纵器这类非线性强、耦合性高的控制对象。

(二)机器人操纵器的控制难点

机器人操纵器的动力学模型包含惯性项、科里奥利力项、离心力项等复杂成分,且在实际运行中,负载变化(如抓取不同重量的工件)、关节摩擦、外部扰动(如气流、碰撞)等因素都会导致模型参数发生波动,难以建立精准的数学模型。此外,操纵器的各个关节之间存在强耦合关系,一个关节的运动必然会影响其他关节的受力状态,进一步增加了控制难度。传统控制方法由于对模型依赖性强,难以应对这些复杂工况,而RBF神经网络的非线性逼近能力恰好能够弥补这一短板。

二、核心突破:自适应偏置为何能提升控制性能?

(一)传统RBF神经网络的局限性

常规RBF神经网络的隐含层偏置项多为固定值,在训练过程中仅调整权重参数。这种设计在环境相对稳定的场景下能够满足基本需求,但当机器人操纵器面临大范围的负载变化或强外部干扰时,固定偏置的RBF神经网络容易出现逼近精度下降、响应速度变慢的问题。因为偏置项直接影响隐含层神经元的激活阈值,固定偏置无法动态适配外部环境的变化,导致神经网络对复杂工况的适应性不足。

(二)自适应偏置的作用机制

自适应偏置RBF神经网络的核心改进的是:将隐含层偏置项设计为可动态调整的参数,通过引入自适应律,让偏置项能够根据系统的运行状态(如跟踪误差、关节角速度)实时更新。具体来说,当机器人操纵器出现跟踪误差时,自适应算法会自动调整偏置项的取值,改变隐含层神经元的激活范围和灵敏度,使神经网络能够更快、更精准地逼近操纵器的非线性动力学特性,从而抵消模型误差和外部干扰的影响。

打个比方,传统RBF神经网络如同“固定焦距的相机”,只能清晰拍摄特定范围内的物体;而自适应偏置RBF神经网络则是“自动对焦的相机”,能够根据物体的距离动态调整焦距,始终保持清晰的成像效果——这正是其提升控制性能的关键所在。

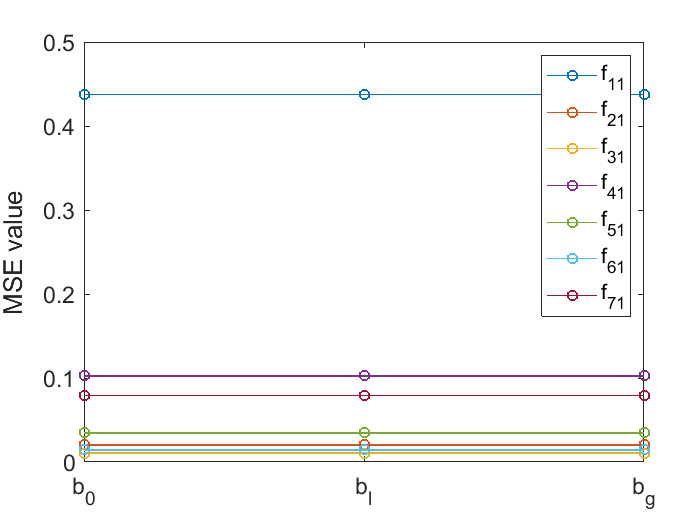

⛳️ 运行结果

📣 部分代码

clear

clc

close all

%define function

x_min=-2.1;

x_max=2.1;

step=(x_max-x_min)/100;

x=linspace(x_min,x_max,100);

constans=ones(1,length(x));

approximation_aim=3*x.*(x-1).*(x-1.9).*(x+0.7).*(x+1.8);

hidden_node=linspace(x_min,x_max,25);

number_node=length(hidden_node);

train_loop_number=10;

mode=2;

switch mode

case 0

bias=-sum(approximation_aim)/length(approximation_aim);

approximation_aim=approximation_aim+bias;

gamma=6; %learning rate

variance=0.15;

test_bias_1=[0,0.01];

test_bias_2=[0.1];

case 1

bias=max(abs(approximation_aim));

approximation_aim=approximation_aim+bias;

gamma=6; %learning rate

variance=0.15;

test_bias_1=[0,0.04,0.045,0.05,0.055,0.06];

test_bias_2=[0.25,0.3,0.35,0.4,0.45,0.5];

case 2

bias=2*max(abs(approximation_aim));

approximation_aim=approximation_aim+bias;

gamma=6; %learning rate

variance=0.15;

% test_bias_1=[0,0.02,0.03,0.04,0.05,0.06];

% test_bias_2=[0.3,0.35,0.4,0.45,0.5,0.55];

test_bias_1=[0,0.03,0.04,0.05,0.055,0.06];

test_bias_2=[0.3,0.35,0.4,0.45,0.5,0.55];

case 3

bias=4*max(abs(approximation_aim));

approximation_aim=approximation_aim+bias;

gamma=6; %learning rate

variance=0.15;

% test_bias_1=[0,0.02,0.03,0.04,0.05,0.06];

% test_bias_2=[0.3,0.35,0.4,0.45,0.5,0.55];

test_bias_1=[0,0.03,0.04,0.05,0.055,0.06];

test_bias_2=[0.3,0.35,0.4,0.45,0.5,0.55];

end

mean_y=sum(approximation_aim)/length(approximation_aim);

% for reduce the bias of function

% bias=sum(approximation_aim)/length(approximation_aim);

% test bias on time

% test_bias_1=[0,0.1,0.65,0.7,0.75,0.8];

% test_bias_2=[3,3.5,4,4.5,5];

% reduce the bias

% % original function

% test_bias_1=[0,0.01,0.014,0.018,0.022];

% test_bias_2=[0.15,0.017,0.2,0.023,0.25,0.3];

% in term of bias is add for each activation

number_bias_1=length(test_bias_1);

W1=zeros(number_node,number_bias_1); % function_i =W(:,i,j)'*S(Z);

for j=1:train_loop_number

for i=1:length(x)

S(:,i,1)=RBF(x(i),hidden_node, variance,number_node);

for k=1:number_bias_1

S1(:,i,k)=S(:,i,1)+test_bias_1(k);

e1(i,k)=approximation_aim(i)-W1(:,k)'*S1(:,i,k);

dotW1(:,k)=gamma*S1(:,i,k)*e1(i,k);

W1(:,k)=W1(:,k)+step*dotW1(:,k);

end

end

end

%test in same data

for k=1:number_bias_1

error1(:,k)=approximation_aim-W1(:,k)'*S1(:,:,k);

end

% in term of bias is add as another activation which is can be seen as PID+RBF

number_bias_2=length(test_bias_2);

W2=zeros(number_node+1,number_bias_2);

for j=1:train_loop_number

for i=1:length(x)

for k=1:number_bias_2

S2(:,i,k)=[S(:,i,1);test_bias_2(k)];

e2(i,k)=approximation_aim(i)-W2(:,k)'*S2(:,i,k);

dotW2(:,k)=gamma*S2(:,i,k)*e2(i,k);

W2(:,k)=W2(:,k)+step*dotW2(:,k);

end

end

end

for k=1:number_bias_2

error2(:,k)=approximation_aim-W2(:,k)'*S2(:,:,k);

end

% test data

x_t=linspace(x_min,x_max,1000);

y_test=3*x_t.*(x_t-1).*(x_t-1.9).*(x_t+0.7).*(x_t+1.8)+bias;

% test for 1

for i=1:length(x_t)

S(:,i,1)=RBF(x_t(i),hidden_node, variance,number_node);

for k=1:number_bias_1

S1(:,i,k)=S(:,i,1)+test_bias_1(k);

error_test1(i,k)=y_test(i)-W1(:,k)'*S1(:,i,k);

mean_error_1(i,k)=y_test(i)-mean_y;

end

end

for k=1:number_bias_1

norm_test1(k)=sqrt(sum(error_test1(:,k).^2)/length(x_t));

%NRMSE_1(k)=sqrt(sum(error_test1(:,k).^2)/sum( mean_error_1(:,k).^2));

NRMSE_1(k)=sqrt(sum(error_test1(:,k).^2)/sum(y_test(:).^2));

end

% test for 2

for i=1:length(x_t)

S(:,i,1)=RBF(x_t(i),hidden_node, variance,number_node);

for k=1:number_bias_2

S2(:,i,k)=[S1(:,i,1);test_bias_2(k)];

error_test2(i,k)=y_test(i)-W2(:,k)'*S2(:,i,k);

mean_error_2(i,k)=y_test(i)-mean_y;

end

end

for k=1:number_bias_2

norm_test2(k)=sqrt(sum(error_test2(:,k).^2)/length(x_t));

% NRMSE_2(k)=sqrt(sum(error_test2(:,k).^2)/sum( mean_error_2(:,k).^2));

NRMSE_2(k)=sqrt(sum(error_test2(:,k).^2)/sum(y_test(:).^2));

end

vecnorm(W1)

vecnorm(W2)

mean_y

Fbl=sum(W1,1).*test_bias_1

Fbg=W2(26,:).*test_bias_2

figure

plot(e1);

hold on

plot(e2);

legend

figure

plot(error1);

hold on

plot(error2);

legend

figure

plot(error_test1);

hold on

plot(error_test2);

legend

figure

plot([norm_test1,norm_test2])

figure

plot([ NRMSE_1, NRMSE_2])

[norm_test1,norm_test2]

%plot(x,e1,'r',x,e2,'g',x,e3,'b',x,en1,'c',x,en2,'m')

% legend;

% norme=[norm(e1),norm(e2),norm(e3),norm(en1),norm(en2)]

% figure

% error1=approximation_aim'-W1'*S1;

% error2=approximation_aim'-W2'*S2;

% error3=approximation_aim'-W3'*S3;

%

% error_n1=approximation_aim'-Wn1'*Sn1;

% error_n2=approximation_aim'-Wn2'*Sn2;

%

%

% plot(x,error1,'r',x,error2,'g',x,error3,'b',x,error_n1,'c',x,error_n2,'m')

% legend

%

% normerror=[norm(error1),norm(error2),norm(error3),norm(error_n1),norm(error_n2)]

%

% % plot(approximation_aim)

🔗 参考文献

🎈 部分理论引用网络文献,若有侵权联系博主删除

👇 关注我领取海量matlab电子书和数学建模资料

🏆团队擅长辅导定制多种科研领域MATLAB仿真,助力科研梦:

🌟 各类智能优化算法改进及应用

生产调度、经济调度、装配线调度、充电优化、车间调度、发车优化、水库调度、三维装箱、物流选址、货位优化、公交排班优化、充电桩布局优化、车间布局优化、集装箱船配载优化、水泵组合优化、解医疗资源分配优化、设施布局优化、可视域基站和无人机选址优化、背包问题、 风电场布局、时隙分配优化、 最佳分布式发电单元分配、多阶段管道维修、 工厂-中心-需求点三级选址问题、 应急生活物质配送中心选址、 基站选址、 道路灯柱布置、 枢纽节点部署、 输电线路台风监测装置、 集装箱调度、 机组优化、 投资优化组合、云服务器组合优化、 天线线性阵列分布优化、CVRP问题、VRPPD问题、多中心VRP问题、多层网络的VRP问题、多中心多车型的VRP问题、 动态VRP问题、双层车辆路径规划(2E-VRP)、充电车辆路径规划(EVRP)、油电混合车辆路径规划、混合流水车间问题、 订单拆分调度问题、 公交车的调度排班优化问题、航班摆渡车辆调度问题、选址路径规划问题、港口调度、港口岸桥调度、停机位分配、机场航班调度、泄漏源定位、冷链、时间窗、多车场等、选址优化、港口岸桥调度优化、交通阻抗、重分配、停机位分配、机场航班调度、通信上传下载分配优化

🌟 机器学习和深度学习时序、回归、分类、聚类和降维

2.1 bp时序、回归预测和分类

2.2 ENS声神经网络时序、回归预测和分类

2.3 SVM/CNN-SVM/LSSVM/RVM支持向量机系列时序、回归预测和分类

2.4 CNN|TCN|GCN卷积神经网络系列时序、回归预测和分类

2.5 ELM/KELM/RELM/DELM极限学习机系列时序、回归预测和分类

2.6 GRU/Bi-GRU/CNN-GRU/CNN-BiGRU门控神经网络时序、回归预测和分类

2.7 ELMAN递归神经网络时序、回归\预测和分类

2.8 LSTM/BiLSTM/CNN-LSTM/CNN-BiLSTM/长短记忆神经网络系列时序、回归预测和分类

2.9 RBF径向基神经网络时序、回归预测和分类

2.10 DBN深度置信网络时序、回归预测和分类

2.11 FNN模糊神经网络时序、回归预测

2.12 RF随机森林时序、回归预测和分类

2.13 BLS宽度学习时序、回归预测和分类

2.14 PNN脉冲神经网络分类

2.15 模糊小波神经网络预测和分类

2.16 时序、回归预测和分类

2.17 时序、回归预测预测和分类

2.18 XGBOOST集成学习时序、回归预测预测和分类

2.19 Transform各类组合时序、回归预测预测和分类

方向涵盖风电预测、光伏预测、电池寿命预测、辐射源识别、交通流预测、负荷预测、股价预测、PM2.5浓度预测、电池健康状态预测、用电量预测、水体光学参数反演、NLOS信号识别、地铁停车精准预测、变压器故障诊断

🌟图像处理方面

图像识别、图像分割、图像检测、图像隐藏、图像配准、图像拼接、图像融合、图像增强、图像压缩感知

🌟 路径规划方面

旅行商问题(TSP)、车辆路径问题(VRP、MVRP、CVRP、VRPTW等)、无人机三维路径规划、无人机协同、无人机编队、机器人路径规划、栅格地图路径规划、多式联运运输问题、 充电车辆路径规划(EVRP)、 双层车辆路径规划(2E-VRP)、 油电混合车辆路径规划、 船舶航迹规划、 全路径规划规划、 仓储巡逻、公交车时间调度、水库调度优化、多式联运优化

🌟 无人机应用方面

无人机路径规划、无人机控制、无人机编队、无人机协同、无人机任务分配、无人机安全通信轨迹在线优化、车辆协同无人机路径规划、

🌟 通信方面

传感器部署优化、通信协议优化、路由优化、目标定位优化、Dv-Hop定位优化、Leach协议优化、WSN覆盖优化、组播优化、RSSI定位优化、水声通信、通信上传下载分配

🌟 信号处理方面

信号识别、信号加密、信号去噪、信号增强、雷达信号处理、信号水印嵌入提取、肌电信号、脑电信号、信号配时优化、心电信号、DOA估计、编码译码、变分模态分解、管道泄漏、滤波器、数字信号处理+传输+分析+去噪、数字信号调制、误码率、信号估计、DTMF、信号检测

🌟电力系统方面

微电网优化、无功优化、配电网重构、储能配置、有序充电、MPPT优化、家庭用电、电/冷/热负荷预测、电力设备故障诊断、电池管理系统(BMS)SOC/SOH估算(粒子滤波/卡尔曼滤波)、 多目标优化在电力系统调度中的应用、光伏MPPT控制算法改进(扰动观察法/电导增量法)、电动汽车充放电优化、微电网日前日内优化、储能优化、家庭用电优化、供应链优化\智能电网分布式能源经济优化调度,虚拟电厂,能源消纳,风光出力,控制策略,多目标优化,博弈能源调度,鲁棒优化

电力系统核心问题经济调度:机组组合、最优潮流、安全约束优化。新能源消纳:风光储协同规划、弃风弃光率量化、爬坡速率约束建模多能耦合系统:电-气-热联合调度、P2G与储能容量配置新型电力系统关键技术灵活性资源:虚拟电厂、需求响应、V2G车网互动、分布式储能优化稳定与控制:惯量支撑策略、低频振荡抑制、黑启动预案设计低碳转型:碳捕集电厂建模、绿氢制备经济性分析、LCOE度电成本核算风光出力预测:LSTM/Transformer时序预测、预测误差场景生成(GAN/蒙特卡洛)不确定性优化:鲁棒优化、随机规划、机会约束建模能源流分析、PSASP复杂电网建模,经济调度,算法优化改进,模型优化,潮流分析,鲁棒优化,创新点,文献复现微电网配电网规划,运行调度,综合能源,混合储能容量配置,平抑风电波动,多目标优化,静态交通流量分配,阶梯碳交易,分段线性化,光伏混合储能VSG并网运行,构网型变流器, 虚拟同步机等包括混合储能HESS:蓄电池+超级电容器,电压补偿,削峰填谷,一次调频,功率指令跟随,光伏储能参与一次调频,功率平抑,直流母线电压控制;MPPT最大功率跟踪控制,构网型储能,光伏,微电网调度优化,新能源,虚拟同同步机,VSG并网,小信号模型

🌟 元胞自动机方面

交通流 人群疏散 病毒扩散 晶体生长 金属腐蚀

🌟 雷达方面

卡尔曼滤波跟踪、航迹关联、航迹融合、SOC估计、阵列优化、NLOS识别

🌟 车间调度

零等待流水车间调度问题NWFSP 、 置换流水车间调度问题PFSP、 混合流水车间调度问题HFSP 、零空闲流水车间调度问题NIFSP、分布式置换流水车间调度问题 DPFSP、阻塞流水车间调度问题BFSP

👇

862

862

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?