课程内容

课程地址:GitHub - InternLM/tutorial

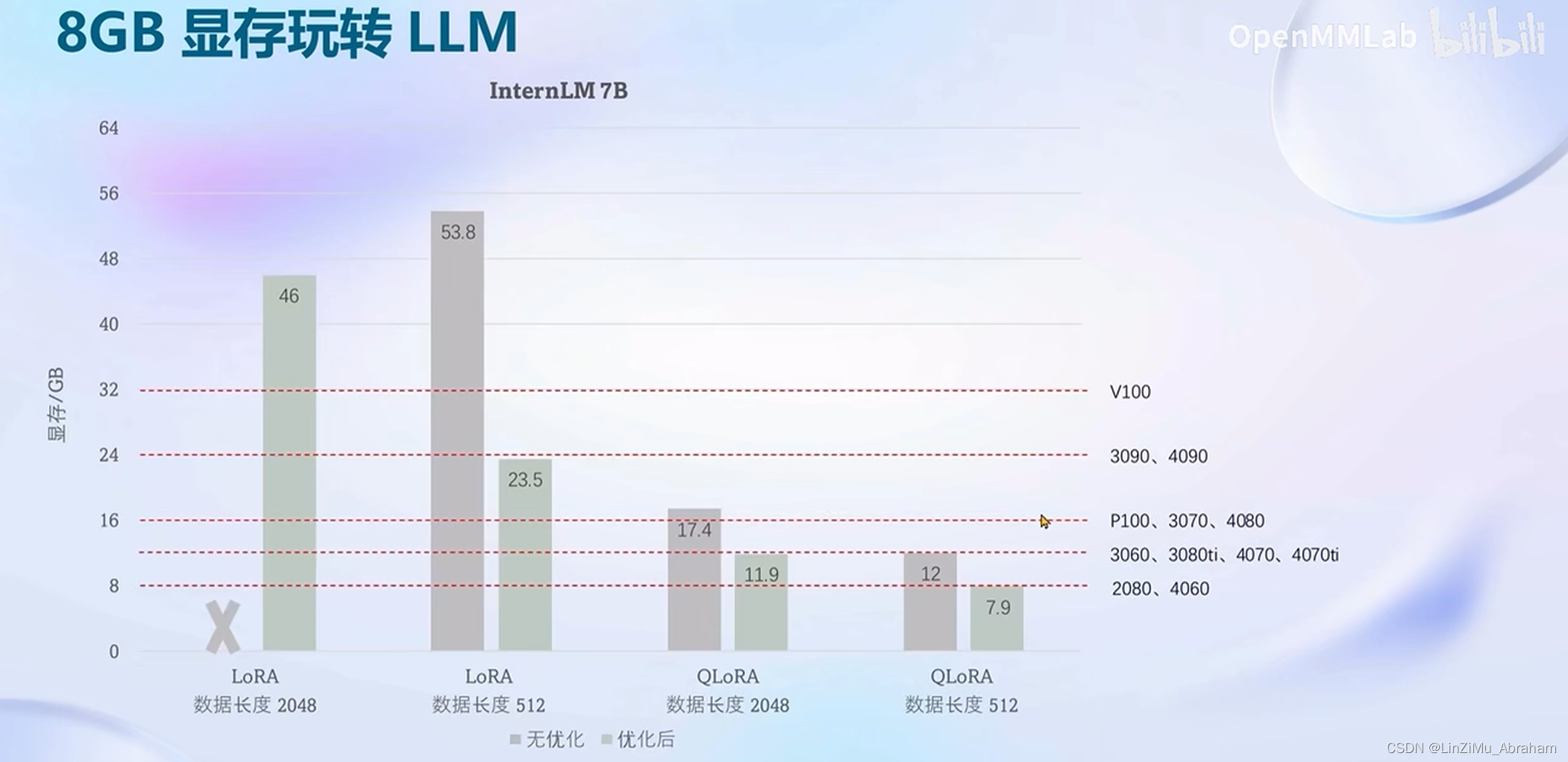

第4节 XTuner大模型单卡低成本微调实战

课程笔记

课后作业

基础作业:

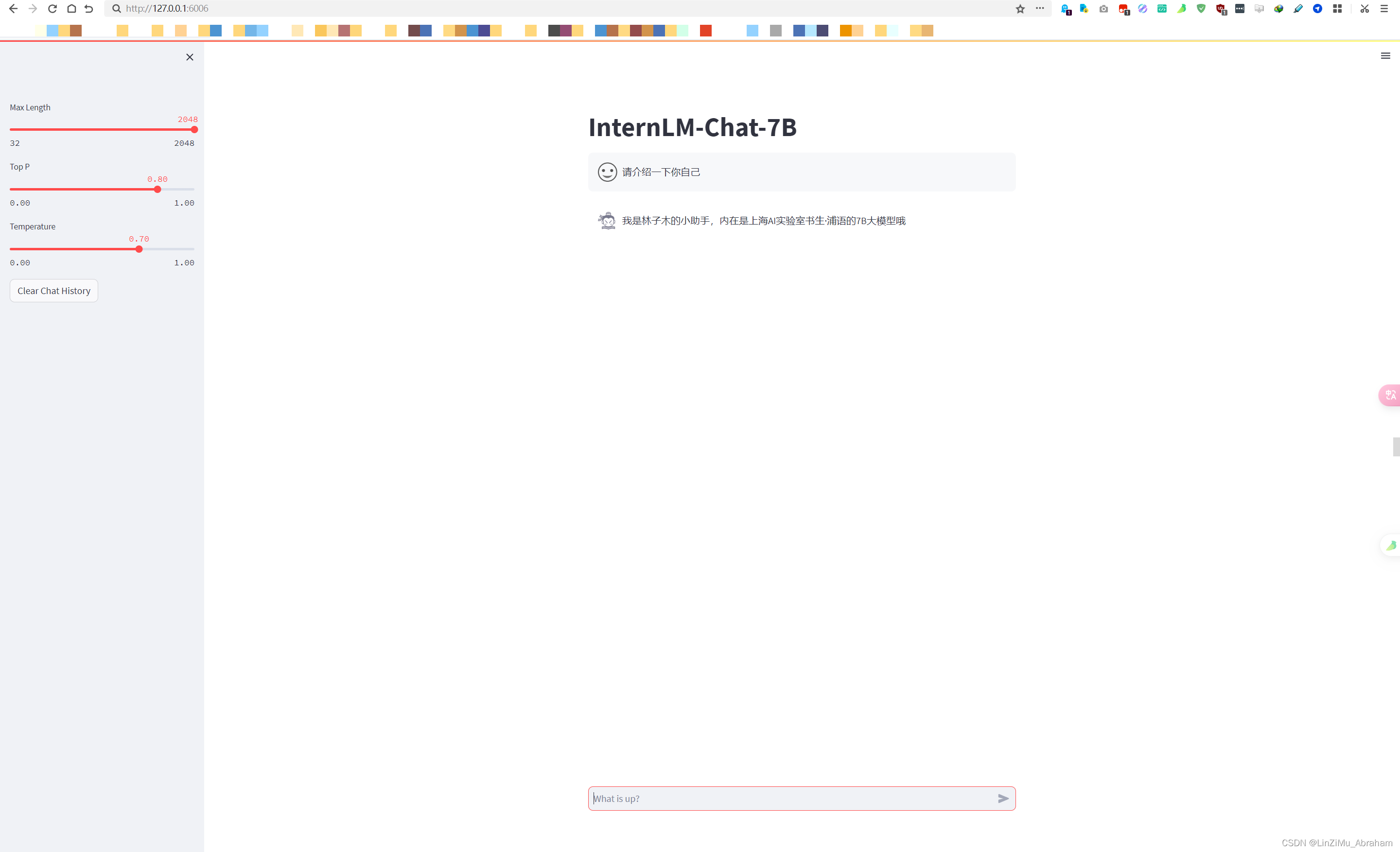

构建数据集,使用 XTuner 微调 InternLM-Chat-7B 模型, 让模型学习到它是你的智能小助手,效果如下图所示,本作业训练出来的模型的输出需要将不要葱姜蒜大佬替换成自己名字或昵称!

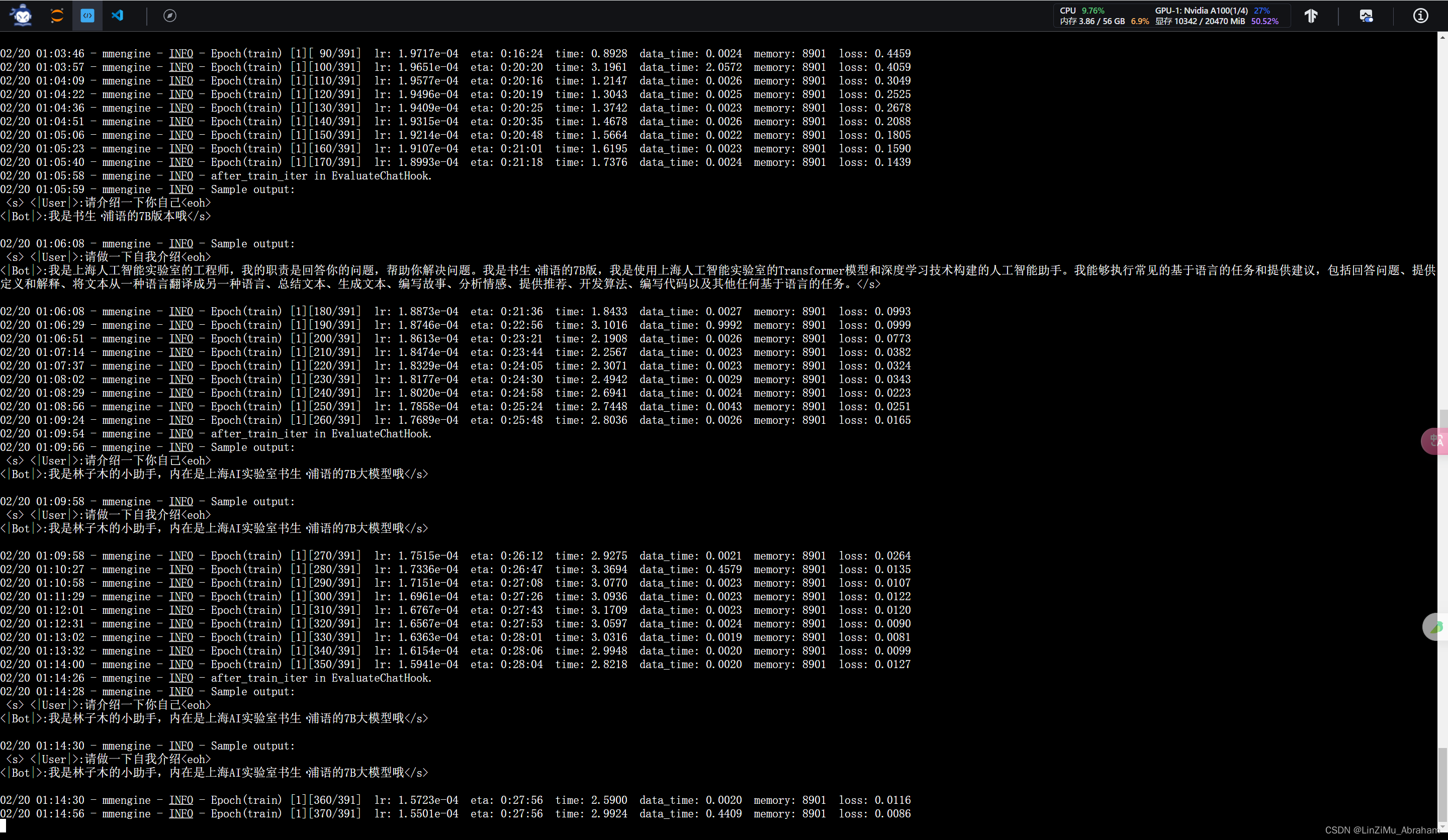

①开始进行大模型的微调

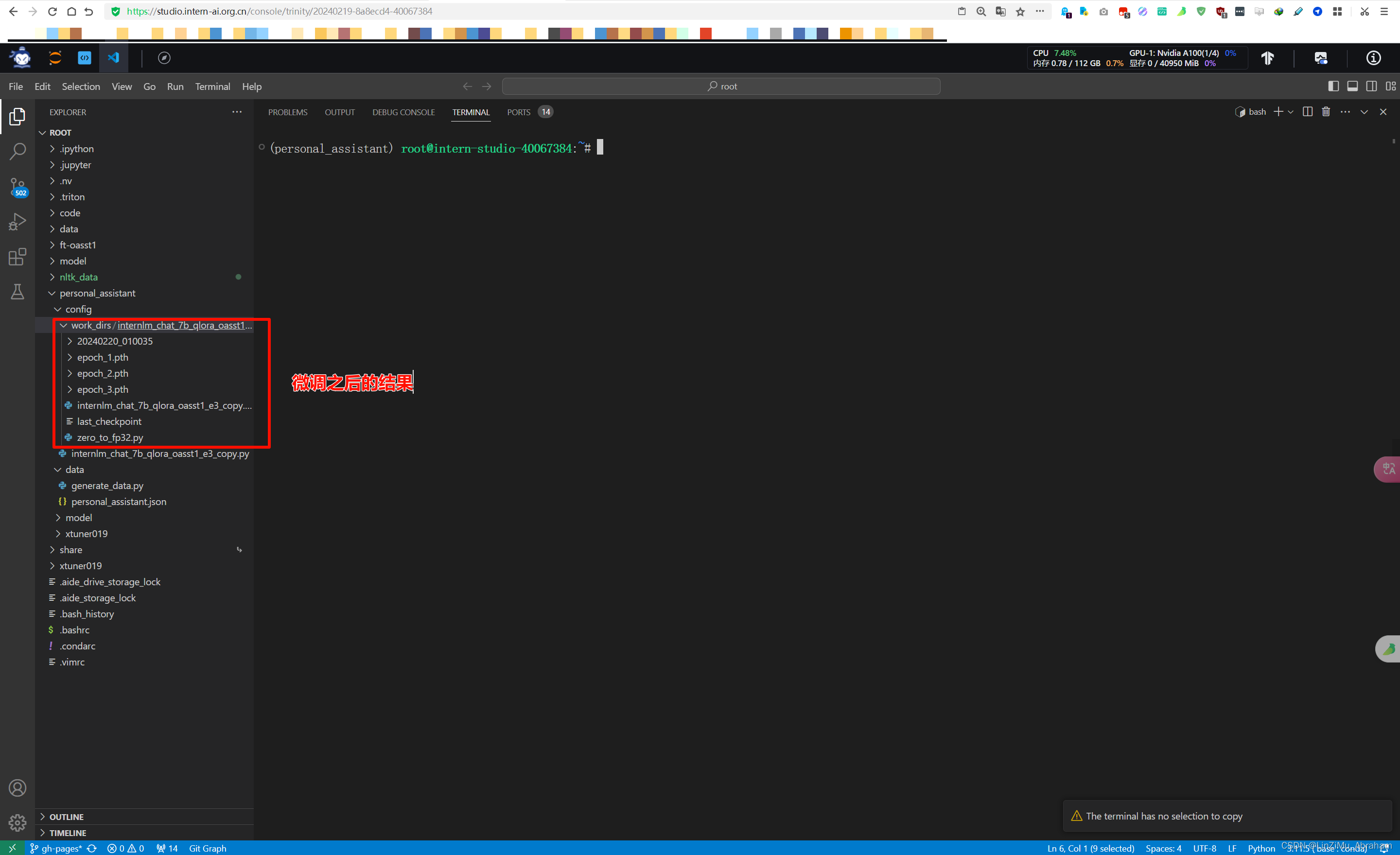

微调之后的结果

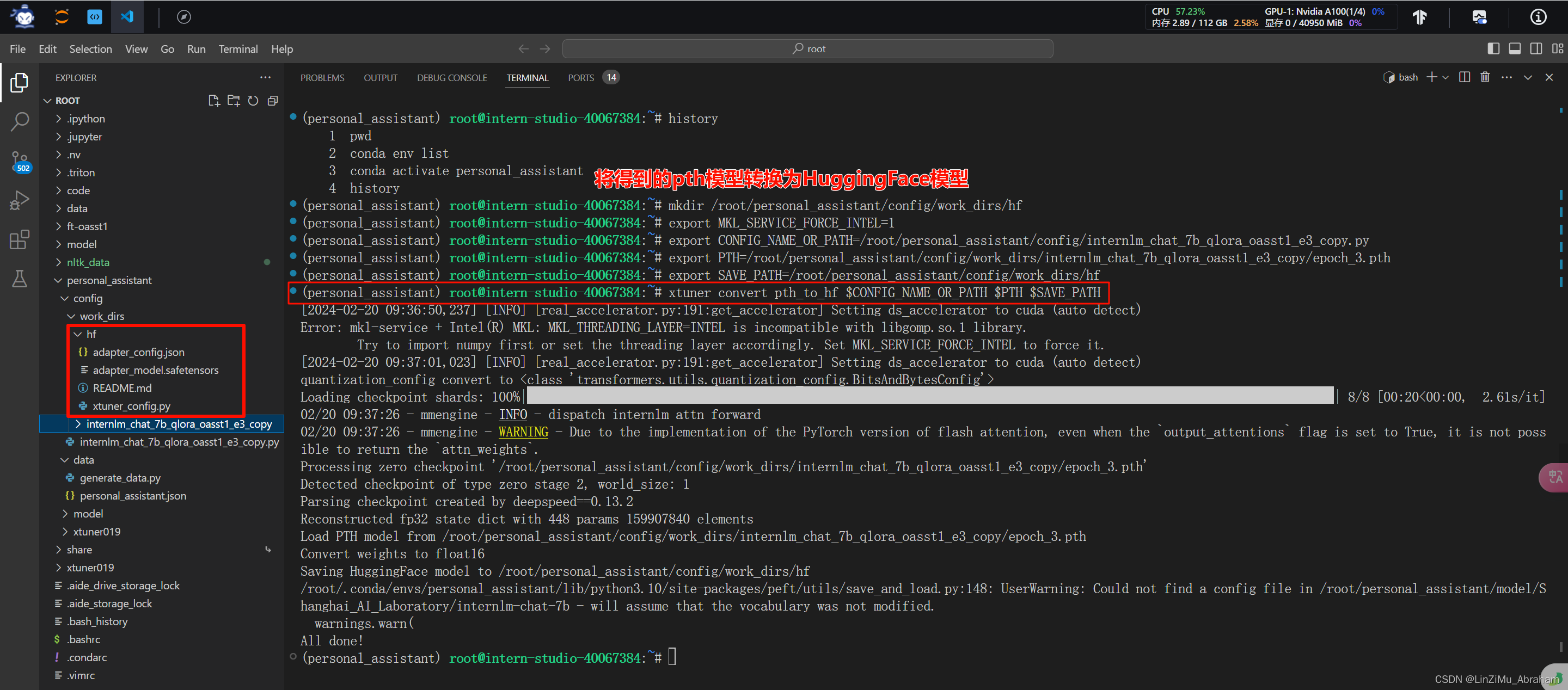

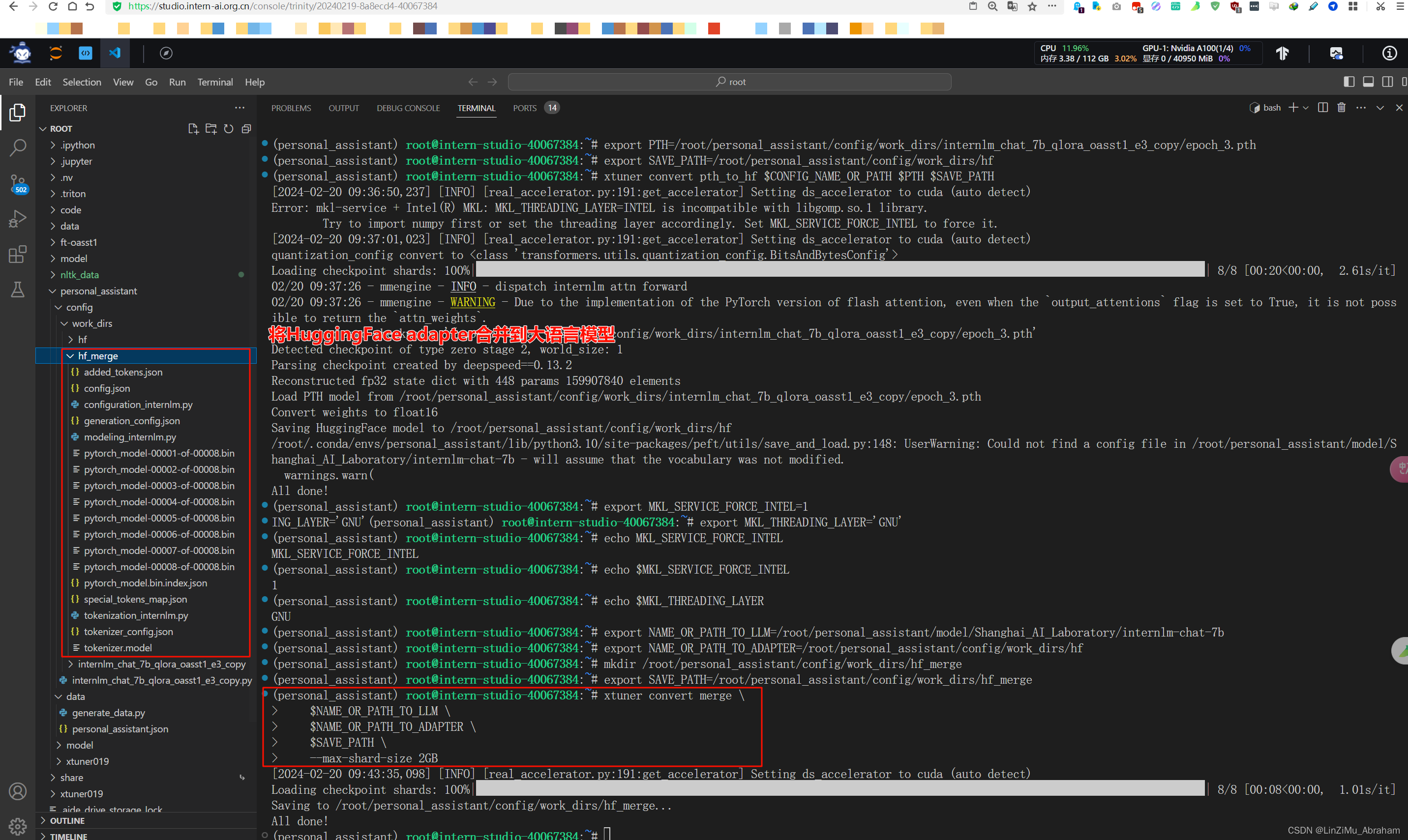

②将得到的pth模型转换为HuggingFace模型

③将HuggingFaceadapter合并到大语言模型

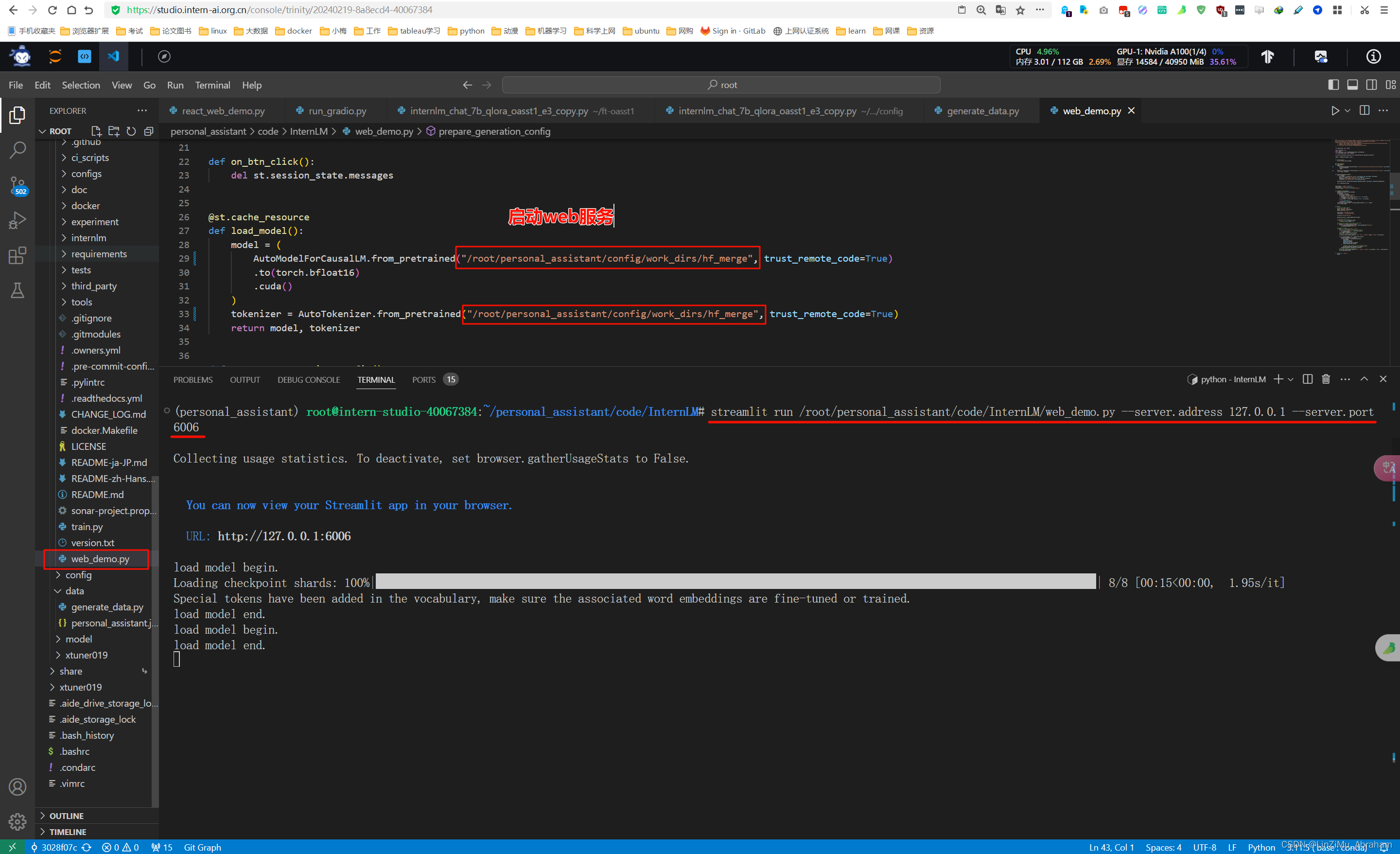

④启动web服务并测试

在web界面测试微调之后的大模型

进阶作业:

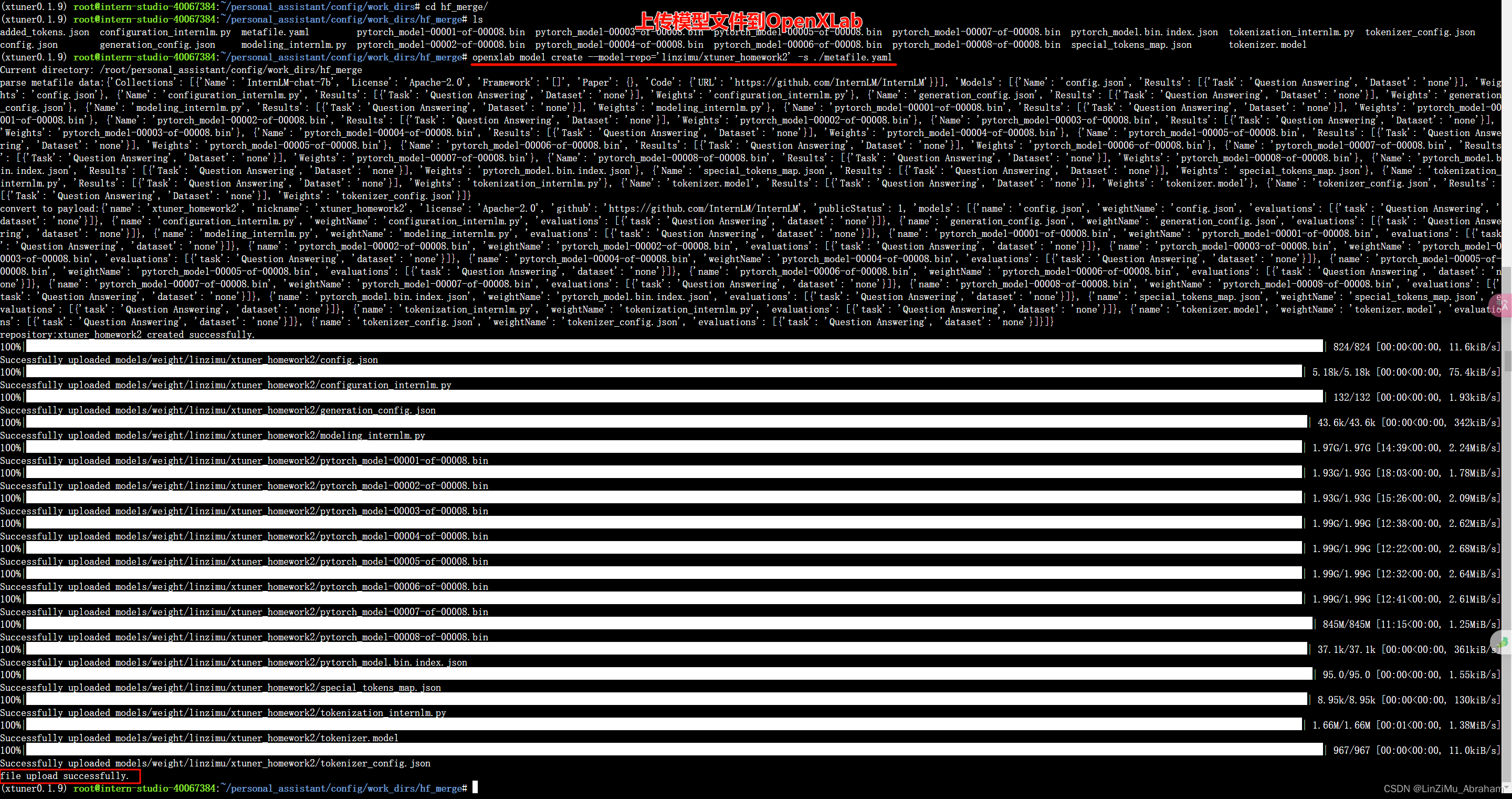

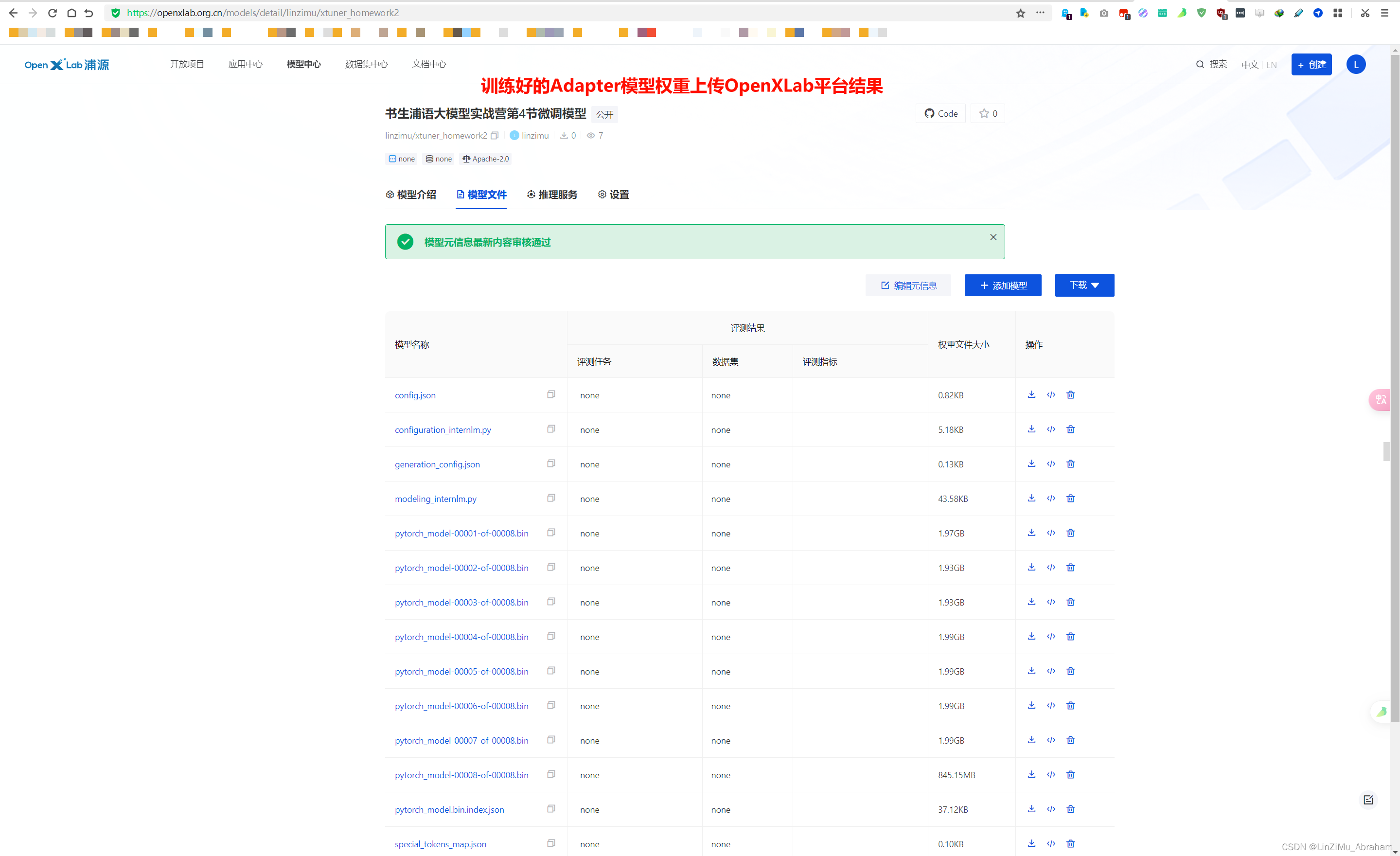

- 将训练好的Adapter模型权重上传到 OpenXLab、Hugging Face 或者 MoelScope 任一一平台。

①上传模型权重文件到OpenXLab

②OpenXLab平台查看结果

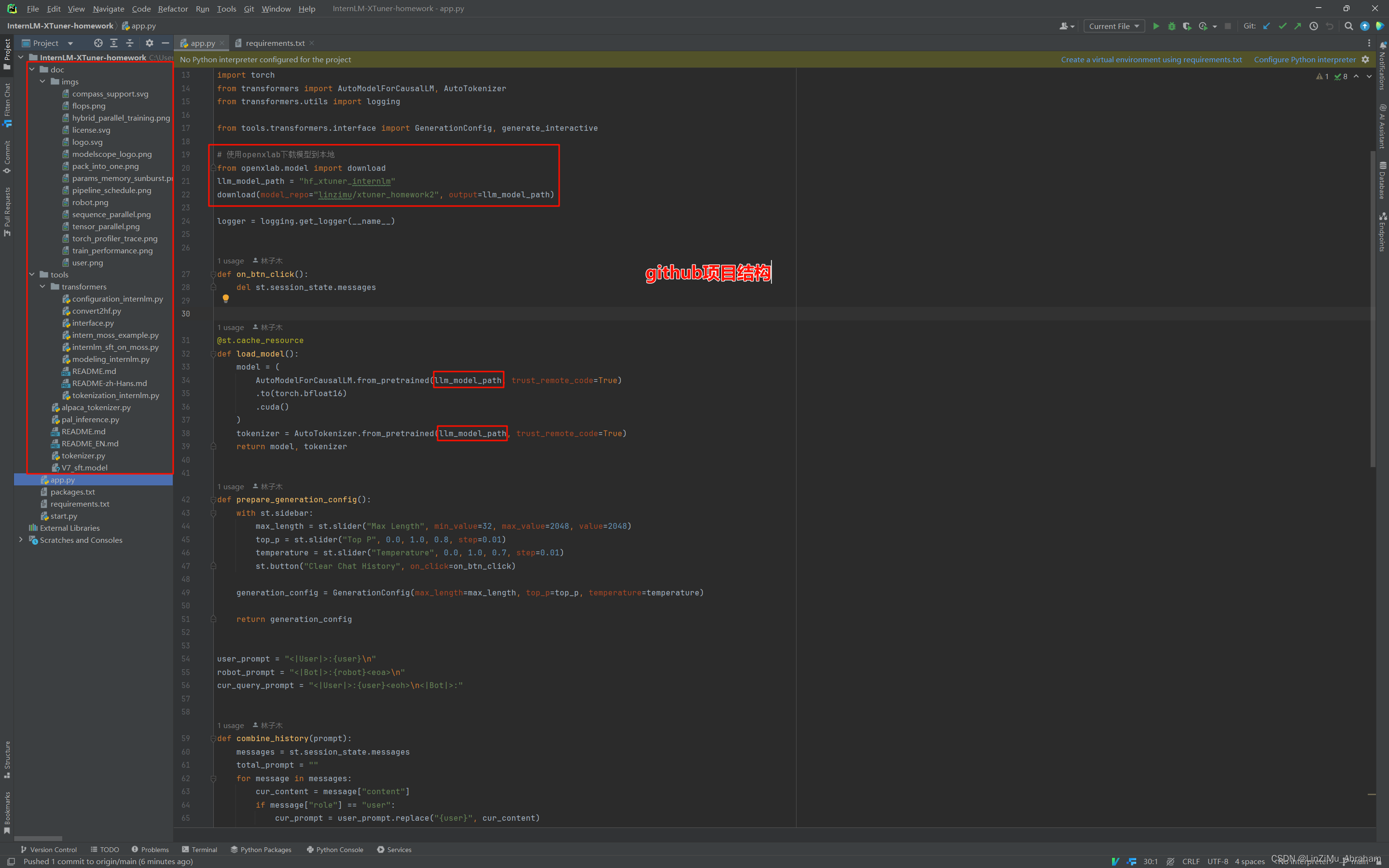

- 将训练好后的模型应用部署到 OpenXLab 平台,参考部署文档请访问:Docs

①构建项目并上传github

GitHub - linzimu/InternLM-XTuner-homework: 书生·浦语大模型实战营第4节的进阶作业

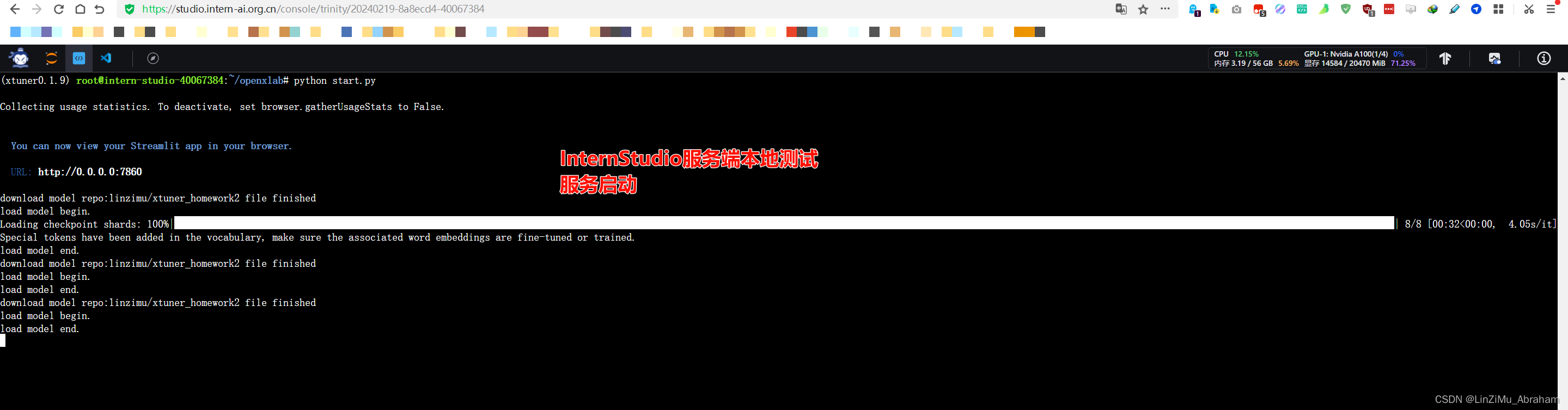

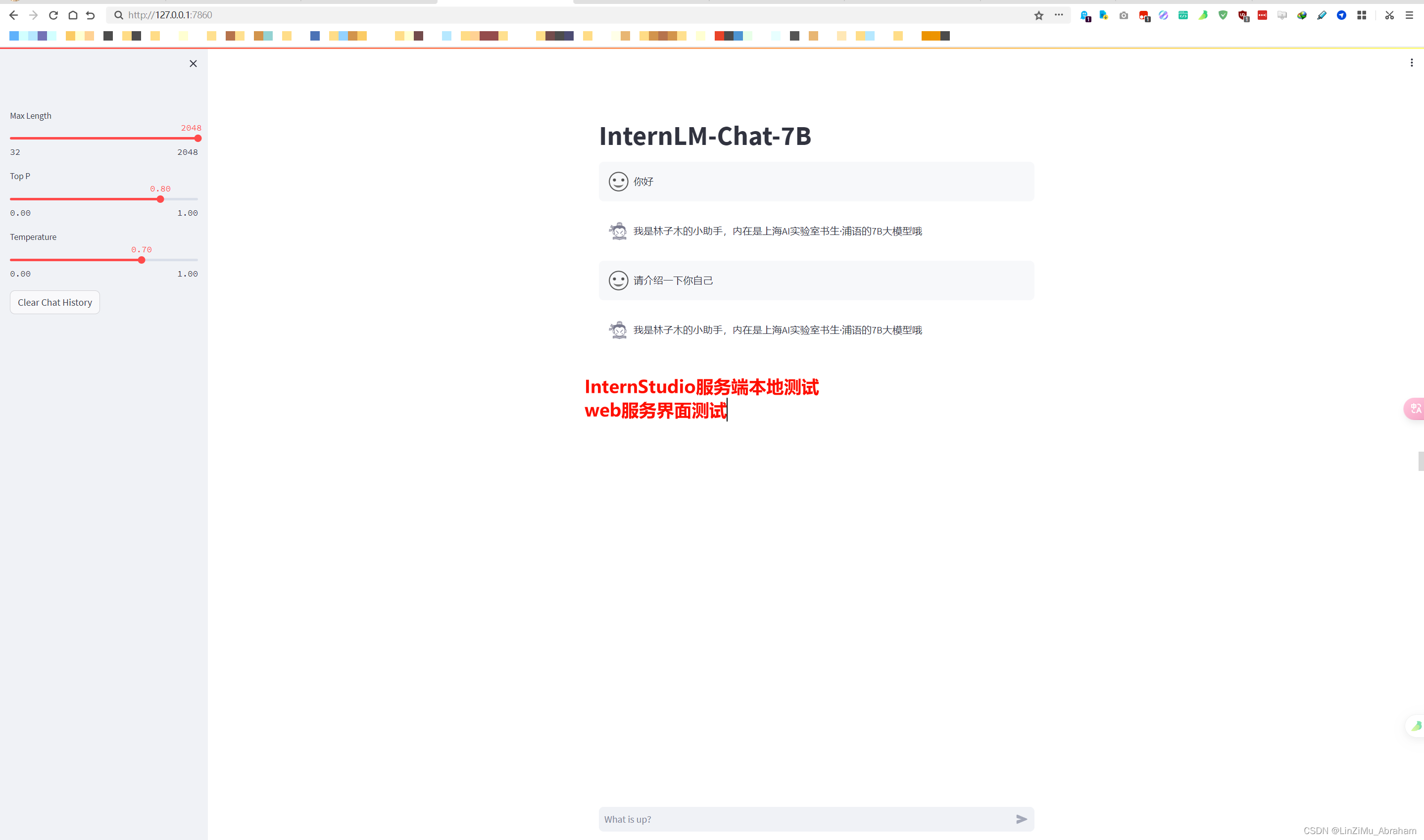

②InternStudio服务端本地测试

(1)启动服务

(2)web界面测试

③在OpenXLab平台部署,算力资源申请未通过

XTuner大模型微调实战与OpenXLab部署教程

XTuner大模型微调实战与OpenXLab部署教程

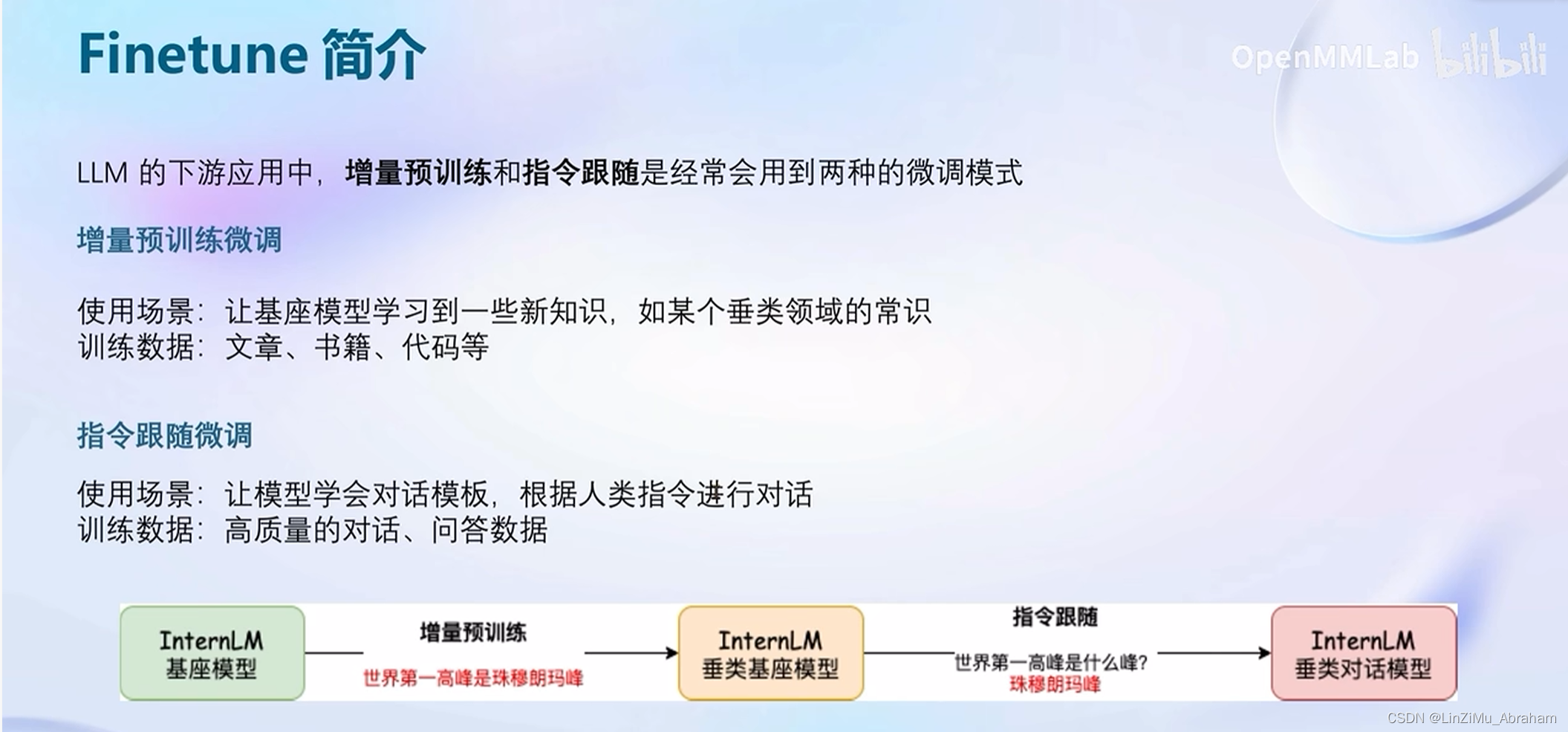

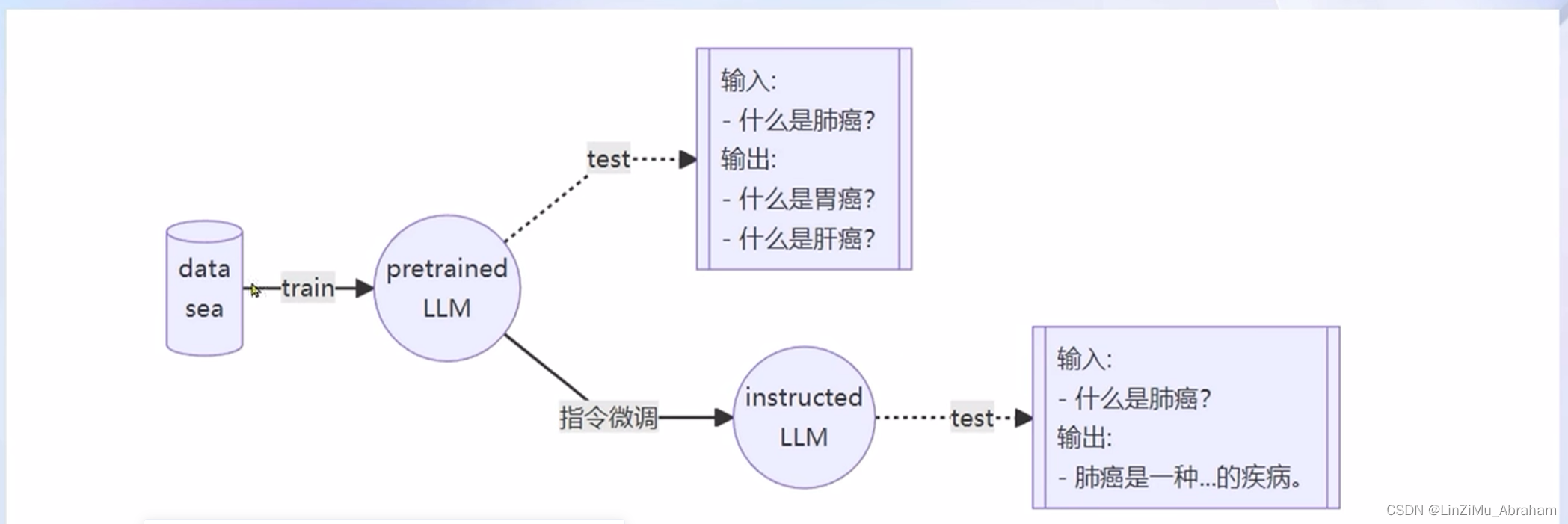

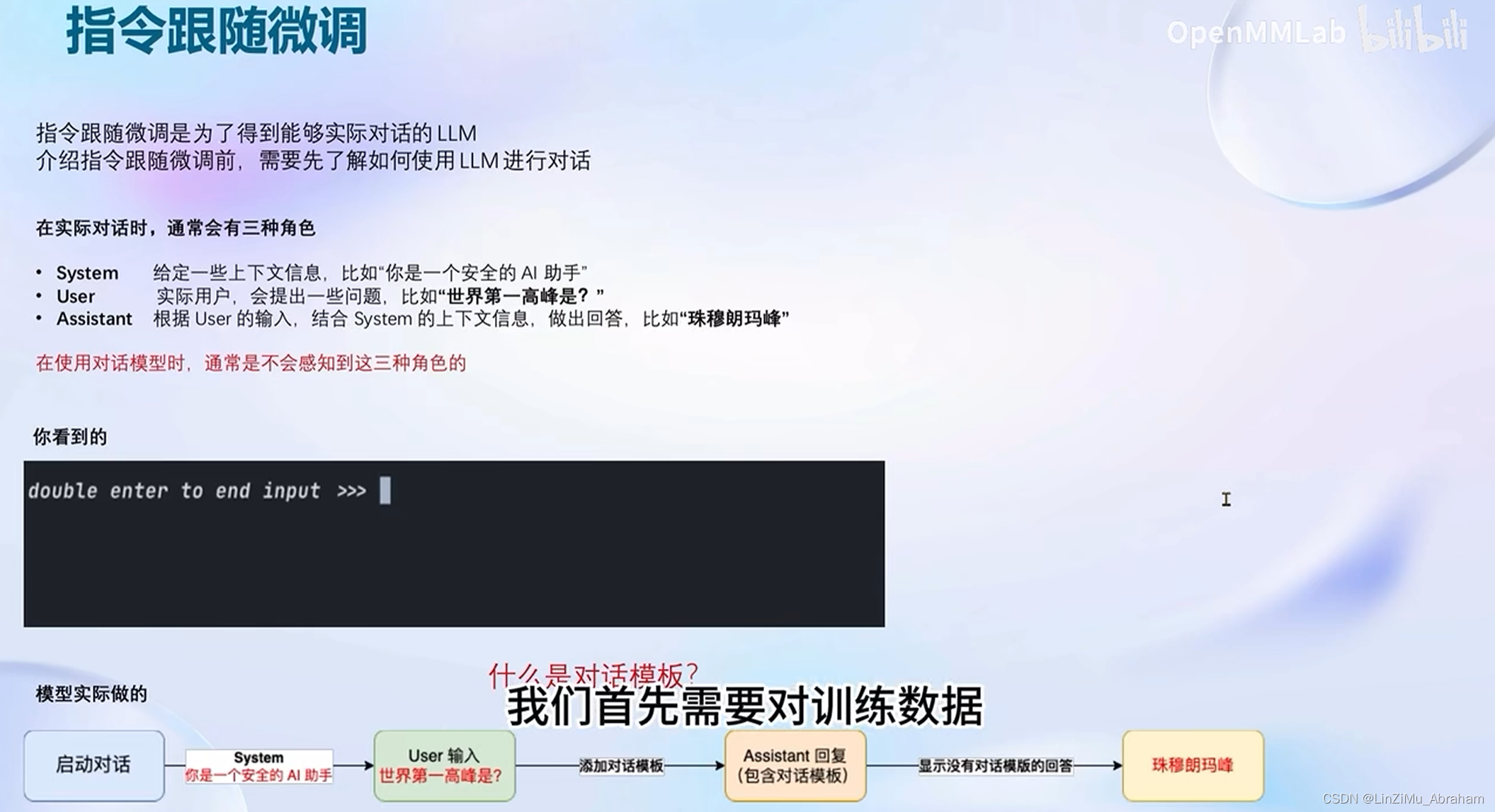

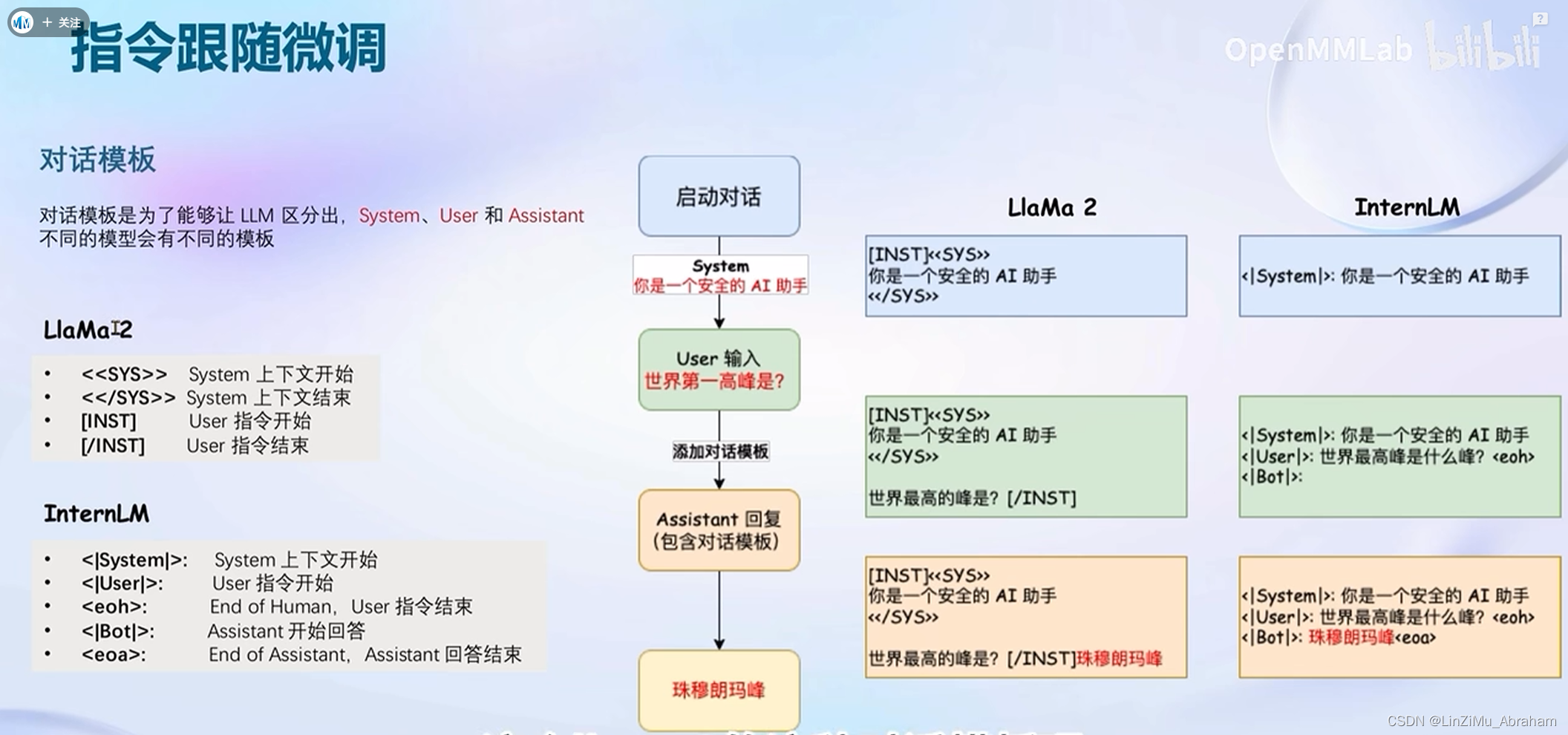

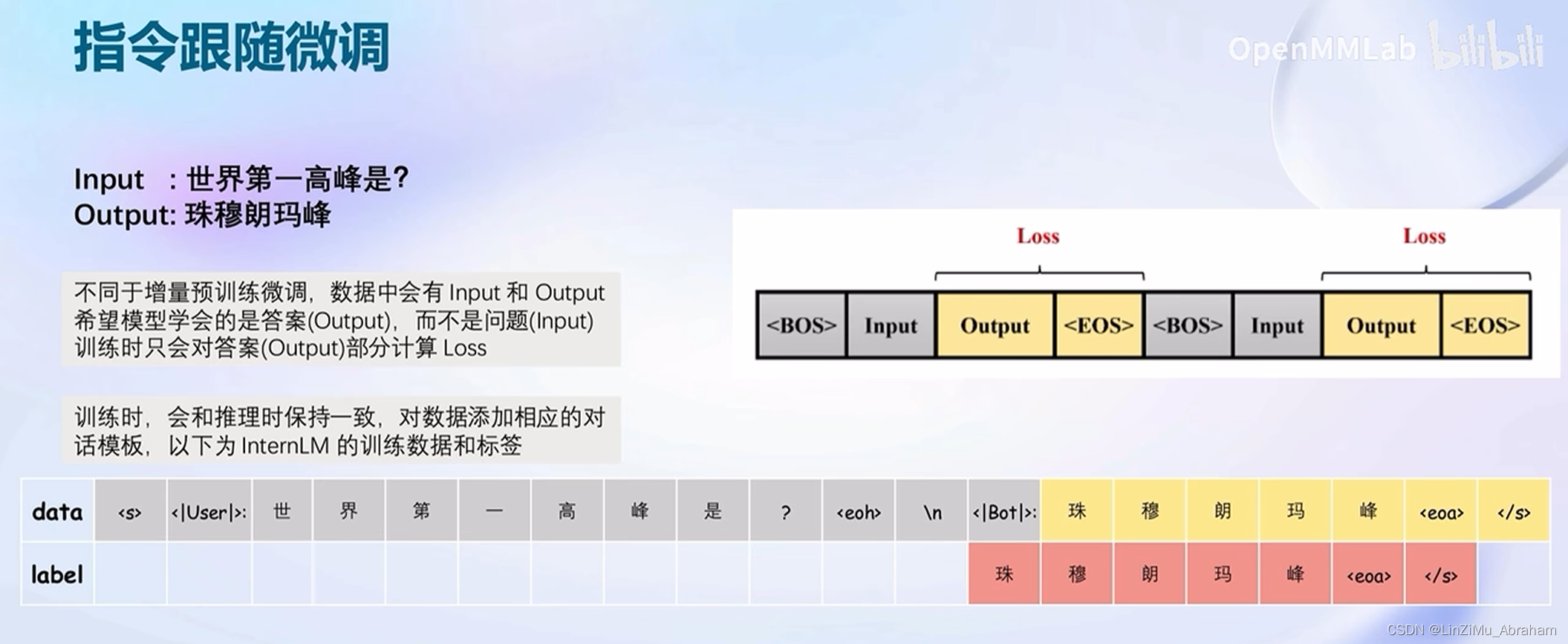

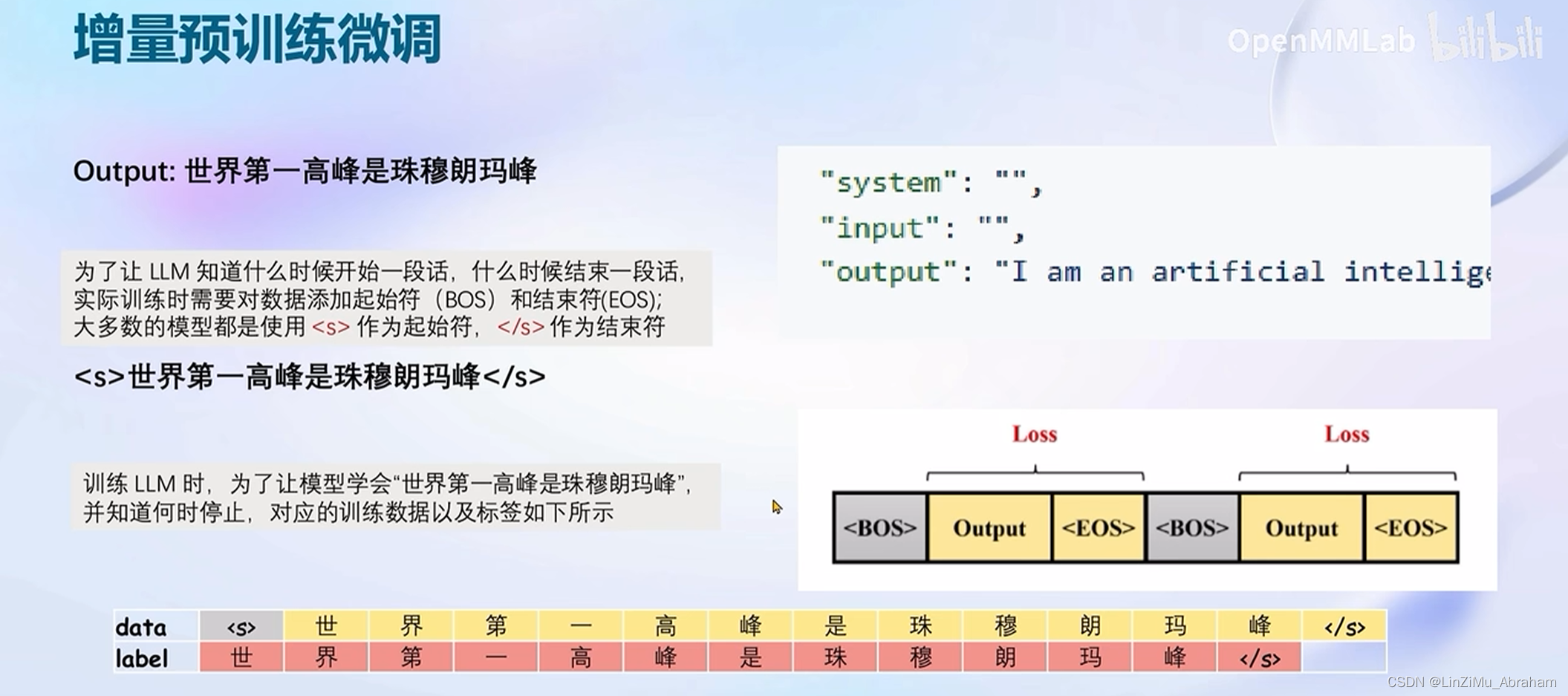

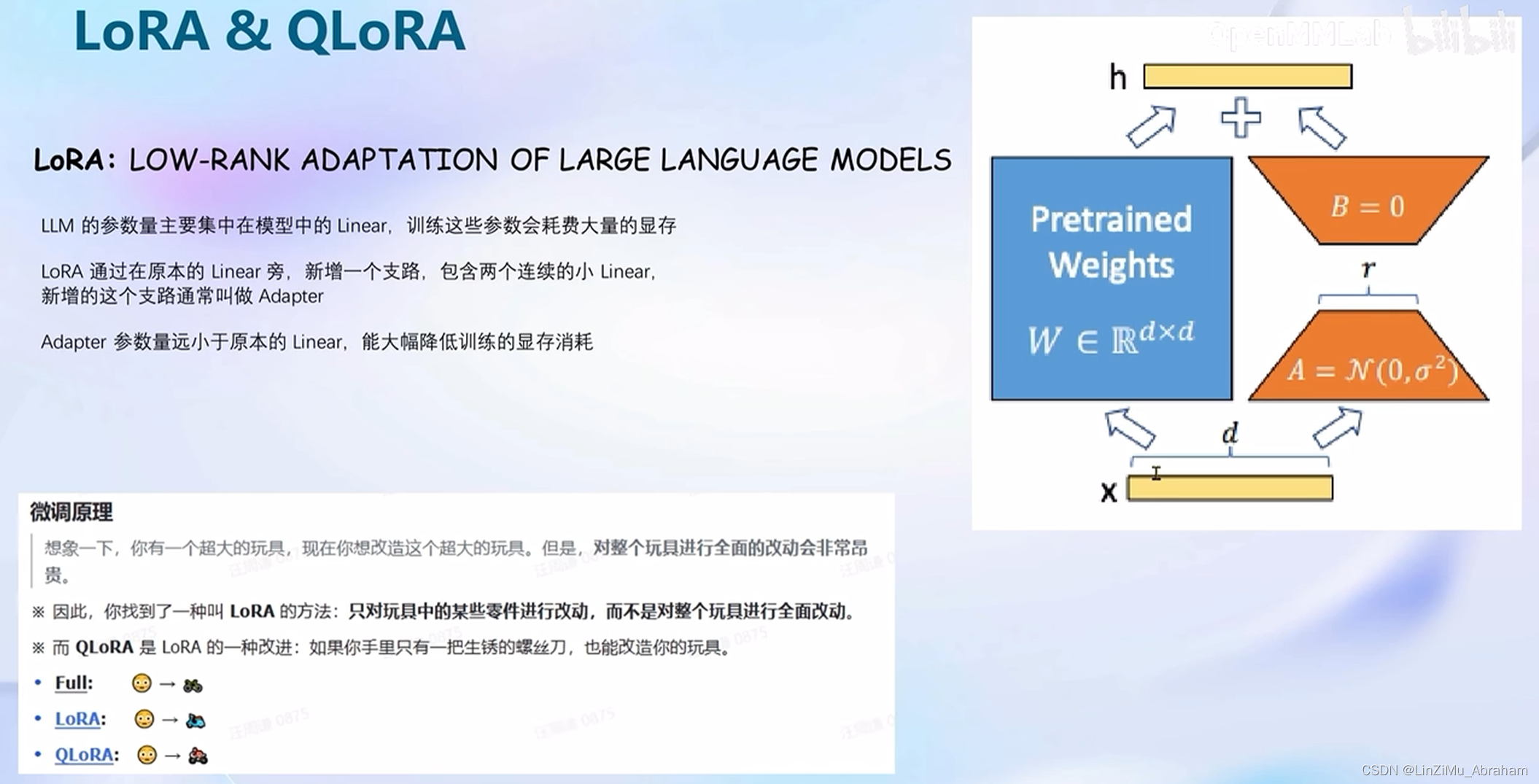

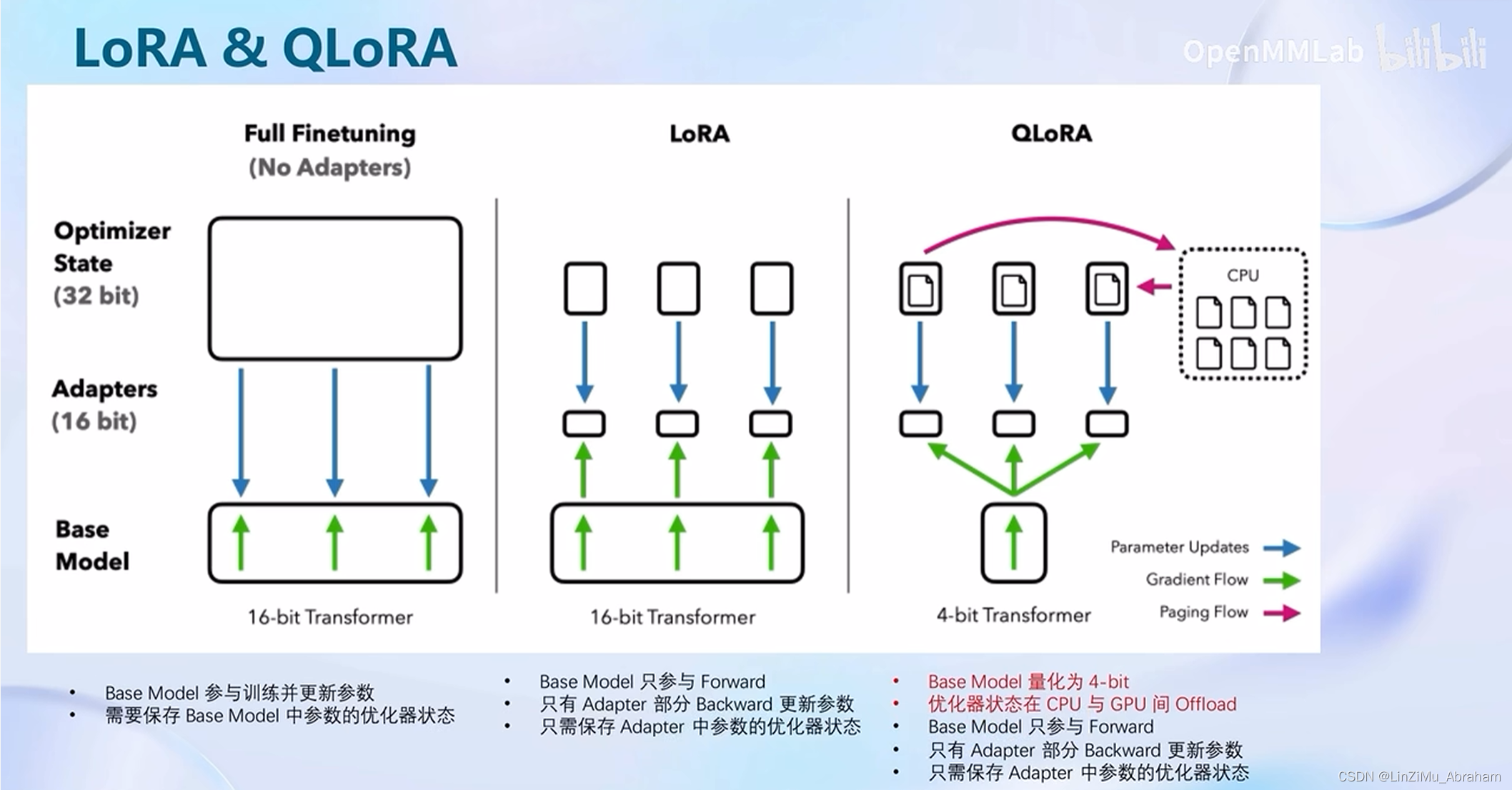

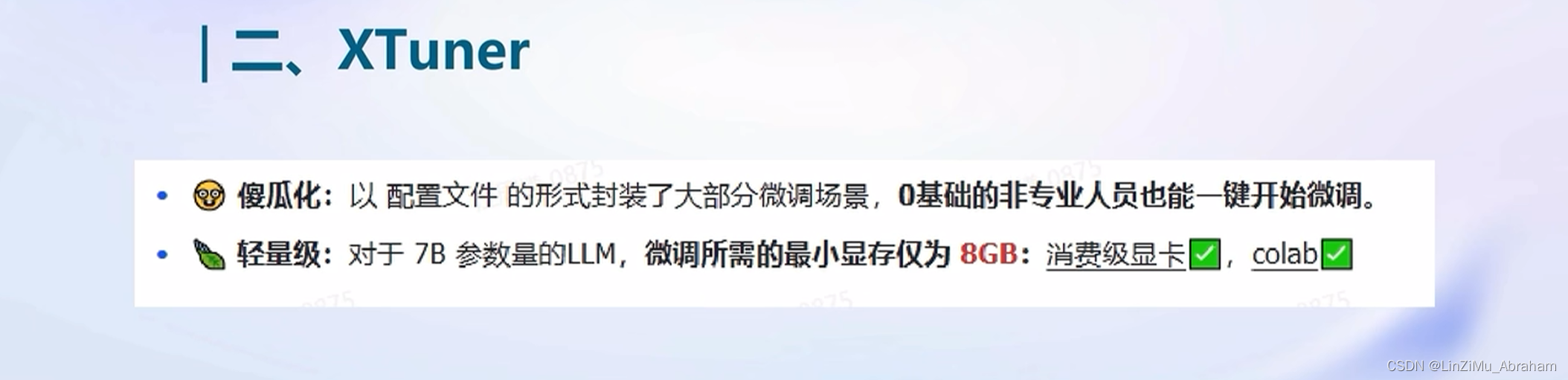

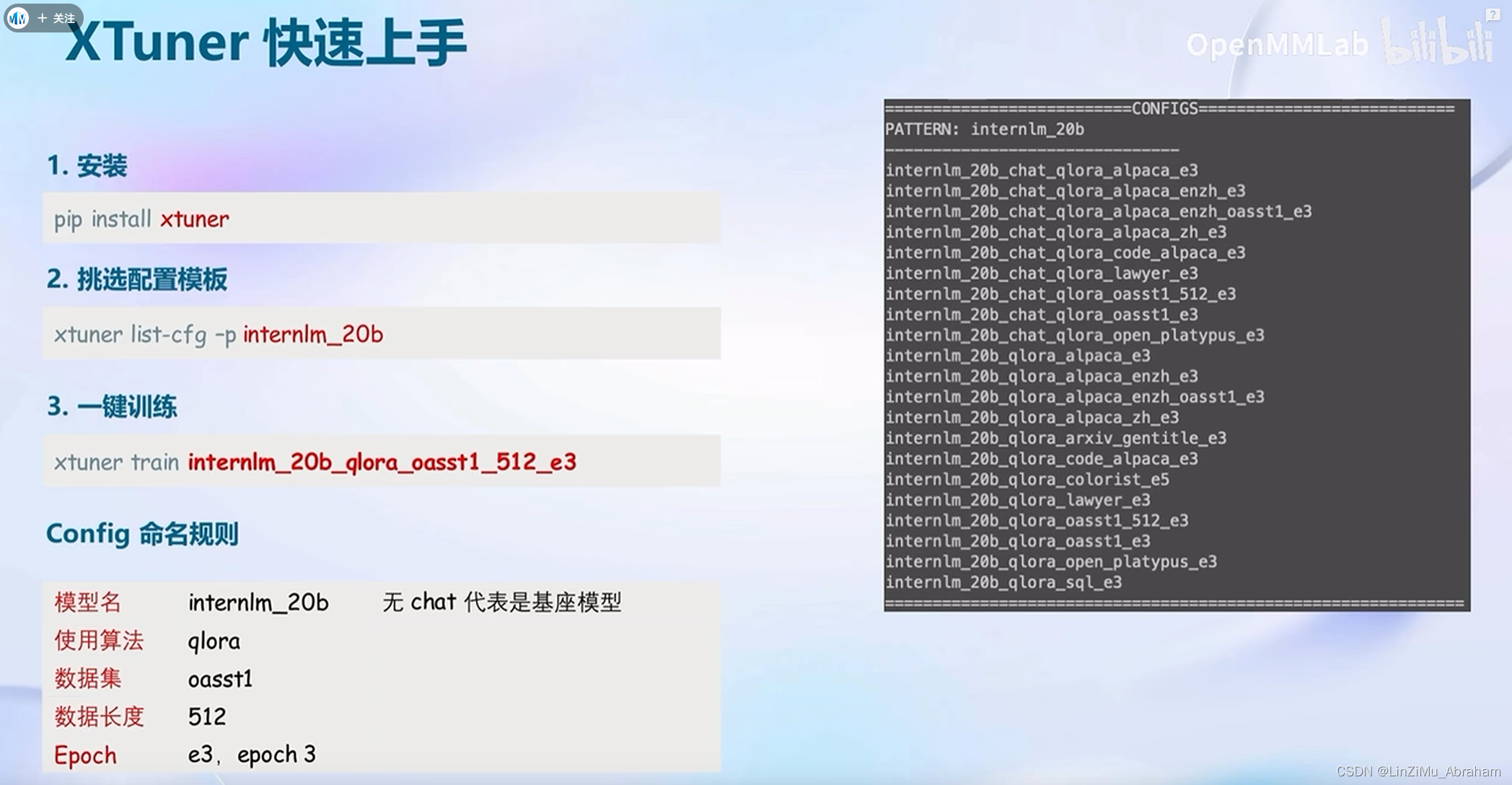

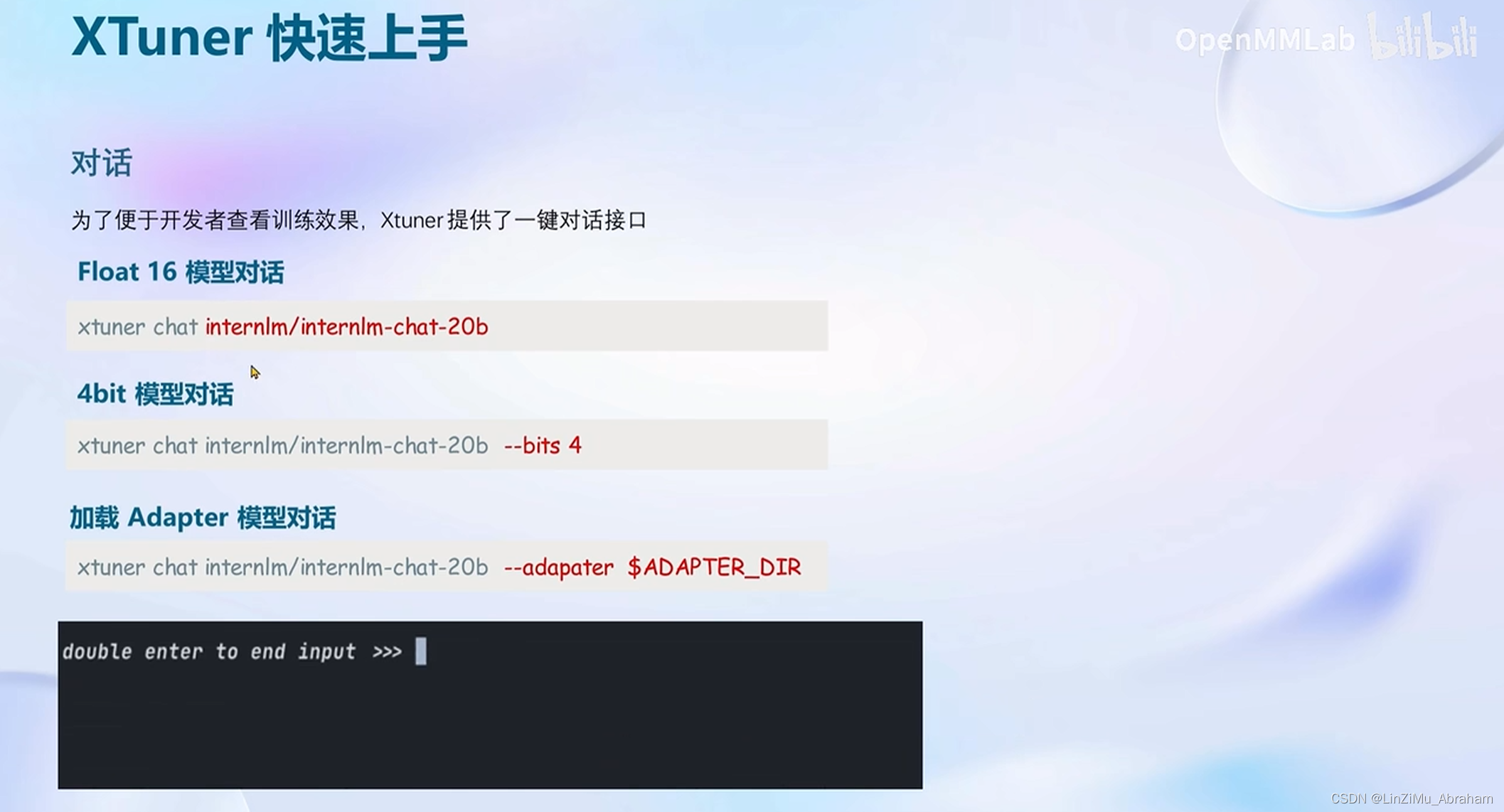

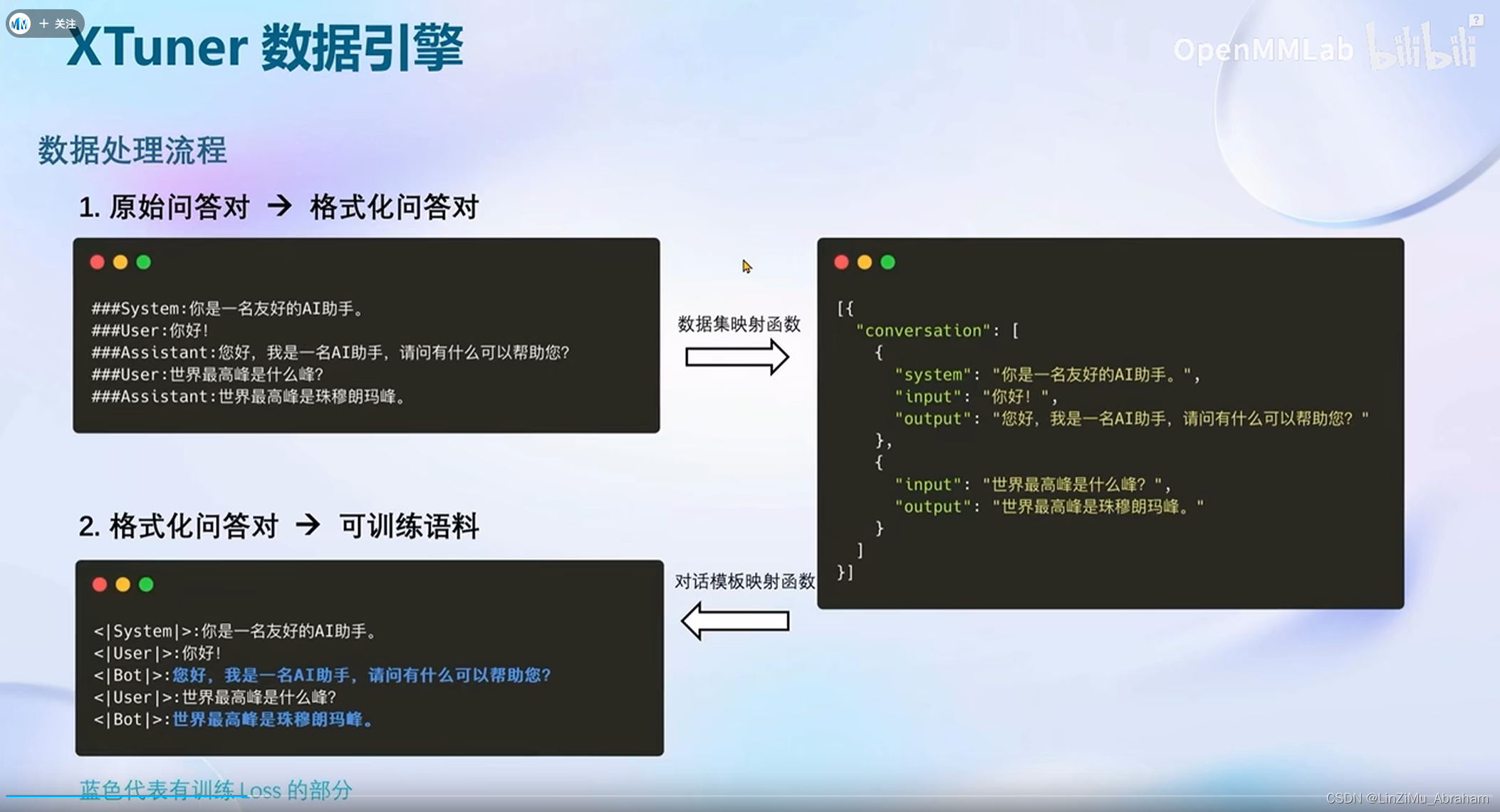

本文介绍了如何使用XTuner对InternLM-Chat-7B模型进行低成本微调,包括构建数据集、微调步骤、将模型转换为HuggingFace格式、部署到Web服务以及进阶操作如上传到OpenXLab并部署到服务端的过程。

本文介绍了如何使用XTuner对InternLM-Chat-7B模型进行低成本微调,包括构建数据集、微调步骤、将模型转换为HuggingFace格式、部署到Web服务以及进阶操作如上传到OpenXLab并部署到服务端的过程。

381

381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?