01引言

大家有没有发现,像 ChatGPT、DeepSeek 这样的 AI 大模型,越来越能“听懂人话”了?无论是写文案、做翻译,还是拆解复杂概念,它们总能精准回应。这背后,一个名为Transformer的核心技术功不可没。

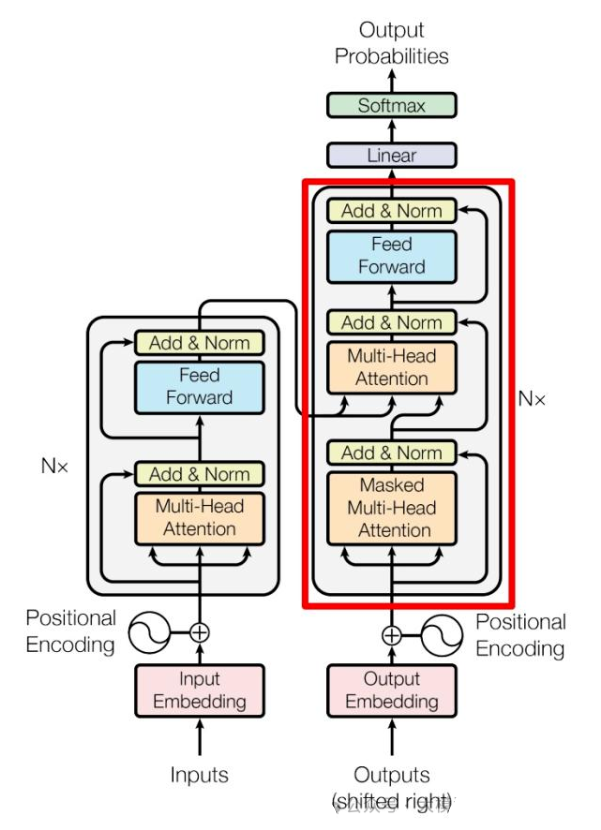

Transformer 是当今 AI 大模型的 “大脑中枢”,它解决了传统模型逐词处理语言的低效问题,让 AI 能像人类一样从整体语境中理解语义。简单说,它就像一个超级 “语言翻译官”:既能把你输入的句子拆解成机器能懂的数字信息(靠编码器),又能把这些信息重新组合成流畅的回答(靠解码器)。接下来我们将从它的核心架构出发,一步步揭开Transformer的技术逻辑。

02技术细节

1. 语义编码

当你输入 “猫在河边追鱼” 时,机器看到的只是一串字符。Transformer 的第一步,是将每个词(“猫”“在”“河边”“追”“鱼”)转换成包含语义信息的 “数字身份证”—— 词向量。这些向量就像词语的 “电子档案”,不仅记录了词的基本含义(如 “猫” 关联 “动物”“捕食者”),还暗藏着词语间的潜在联系(比如“猫”和“鱼”的捕食关系)。

2. 全局关联分析:自注意力机制

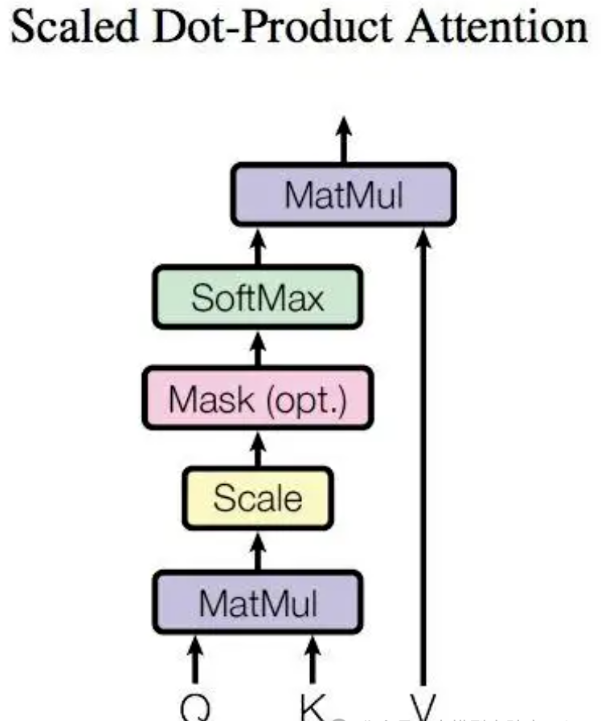

传统模型处理词语如同 “单线聊天”,只能看到前后几个词,而 Transformer 的灵魂 —— 自注意力机制,让每个词都能 “同时关注” 整个句子,并给不同词语打上 “重要性分数”。比如 “猫在河边追鱼” 里的 “追”,不再像传统模型那样只能挨着看前后词,而是能同时 “扫视” 全句所有词的关系。具体来说,每个词会先拆成三张 “任务卡”:

Query(提问卡):“追” 会问 “谁在做动作?”“追的对象是谁?”;

Key(身份卡):“猫” 在 Key 卡上写 “我是捕食者动物”,“鱼” 写 “我是水生猎物”;

Value(信息包):“河边” 的 Value 里装着 “有水的场景” 等细节。

然后 “追” 用 Query 卡逐个对比其他词的 Key 卡,按匹配度打分(比如 “猫” 打 8 分、“鱼” 打 7 分),再用类似 “投票加权” 的方式把这些词的 Value 信息拼起来 ——40% 的 “猫” 信息 + 30% 的 “鱼” 信息 + 20% 的 “河边” 信息,让 “追” 瞬间明白自己处于 “猫在河边追鱼” 的完整场景里。

为了让理解更全面,Transformer 还会让多个自注意力 “小组” 同时工作,也就是多头注意力机制。这些小组各自负责不同的分析角度:

第一个小组专门关注语法结构,比如确定 “猫” 是主语、“追” 是谓语,保证句子成分的正确性;

第二个小组深挖词语之间的语义关联,比如发现 “河边” 和 “鱼” 都与水相关,把场景信息串联起来;

第三个小组则琢磨动作背后的逻辑链条,从 “追” 这个行为推理出 “猫可能在捕食鱼” 的目的。

每个小组独立完成 “提问 - 对比 - 加权” 的自注意力计算过程,最后把各自的结果汇总到一起。这样一来,模型既能抓住句子的语法骨架,又能填充语义细节,还能理解深层逻辑 —— 就像人听到 “猫在河边追鱼” 时,不仅能听懂字面意思,还能联想到 “猫在抓鱼” 的完整场景,这就是多头注意力让 AI 理解更深入的关键。

3. 位置编码保证词序

“猫追鱼” 和 “鱼追猫” 意思天差地别,如何保留词序?Transformer 在生成词向量时,会附加一个 “位置编码”,如同给每个词发一个 “出场顺序牌”。这样,“猫” 在 “追” 前、“鱼” 在 “追” 后的关键顺序信息就不会丢失,避免语义混淆。

4. 层层提炼形成深度理解

上述流程只是一个基础单元 ——Transformer 层。实际模型会堆叠多层,像流水线一样深度处理:

第一层输出的 “猫 +”“追 +” 等表示已包含初步上下文;

第二层会在此基础上挖掘更深层关系(如 “河边” 可能暗示 “鱼的逃生环境”);

层数越多,模型对语义的抽象能力越强,最终实现对句子的深度理解。

5. 解码器:理解后再创造

当需要输出结果(如翻译或续写)时,解码器开始工作。它一边生成当前词语(如英文 “The cat”),一边 “回头看” 编码器提炼的输入信息,确保内容忠实原意;同时利用自注意力机制关注已生成的内容,保证输出流畅合规。

03总结:Transformer 的核心优势

Transformer 架构之所以能成为 ChatGPT、DeepSeek 等顶尖 AI 模型无可撼动的基石,关键在于它集成了以下革命性的优势:

全局视野(自注意力机制): 突破传统模型逐词处理的线性局限,让模型中的每个词都能瞬间“关注”整个句子的所有其他词,捕捉词语间的复杂关联和整体语境。

并行高效:得益于其架构设计,模型可以同时计算句子中所有词语之间的关系,而非像 RNN 那样必须顺序处理,这带来了巨大的速度提升,使得训练和运行超大规模模型成为可能。

顺序保真(位置编码): 通过为每个词嵌入独特的位置信息(如同“时间戳”),精确地保留了词语在句子中的先后顺序,避免了“猫追鱼”和“鱼追猫”的语义混淆。

深度抽象(多层堆叠): 多个 Transformer 层像精密的流水线一样串联工作。每一层都在前一层提取的信息基础上进行更深层次的理解和抽象(如从词语表面含义到隐含逻辑),最终实现对语言复杂含义的深度挖掘。

正是这四大核心优势的协同作用,让 Transformer 彻底改变了 AI 处理语言的方式。它不再孤立地看待词语,而是教会了 AI 像人类一样思考——从整体的语境、词语间的内在联系和深层的逻辑中去理解语义。

185

185

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?