论文标题:Scaling Instruction-Based VideoEditing with a High-Quality Synthetic Dataset

作者团队:香港科大、蚂蚁集团、浙江大学、东北大学

发布时间:2025年10月17日

[👉Lab4AI大模型实验室论文阅读](https://www.lab4ai.cn/paper/detail/reproductionPaper?utm_source=lab4ai_jssq_csdn

_Ditto&id=03e89d3d4c294a38a33e46328ce25993)

✅Lab4AI平台提供AI导读和翻译等工具,辅助您的论文阅读。

✨本文核心贡献

(1)提出Ditto数据生成框架

突破现有方法的“成本-质量-多样性”权衡:融合先进图像编辑器的视觉先验与上下文视频生成器(VACE),结合模型蒸馏与量化技术,将计算成本降至原始高保真方法的20%,同时保证时间一致性与编辑质量。

自动化流程:通过视觉语言模型(VLM)实现指令生成与质量筛选,无需人工干预,支撑大规模数据生产。

(2)构建Ditto-1M数据集

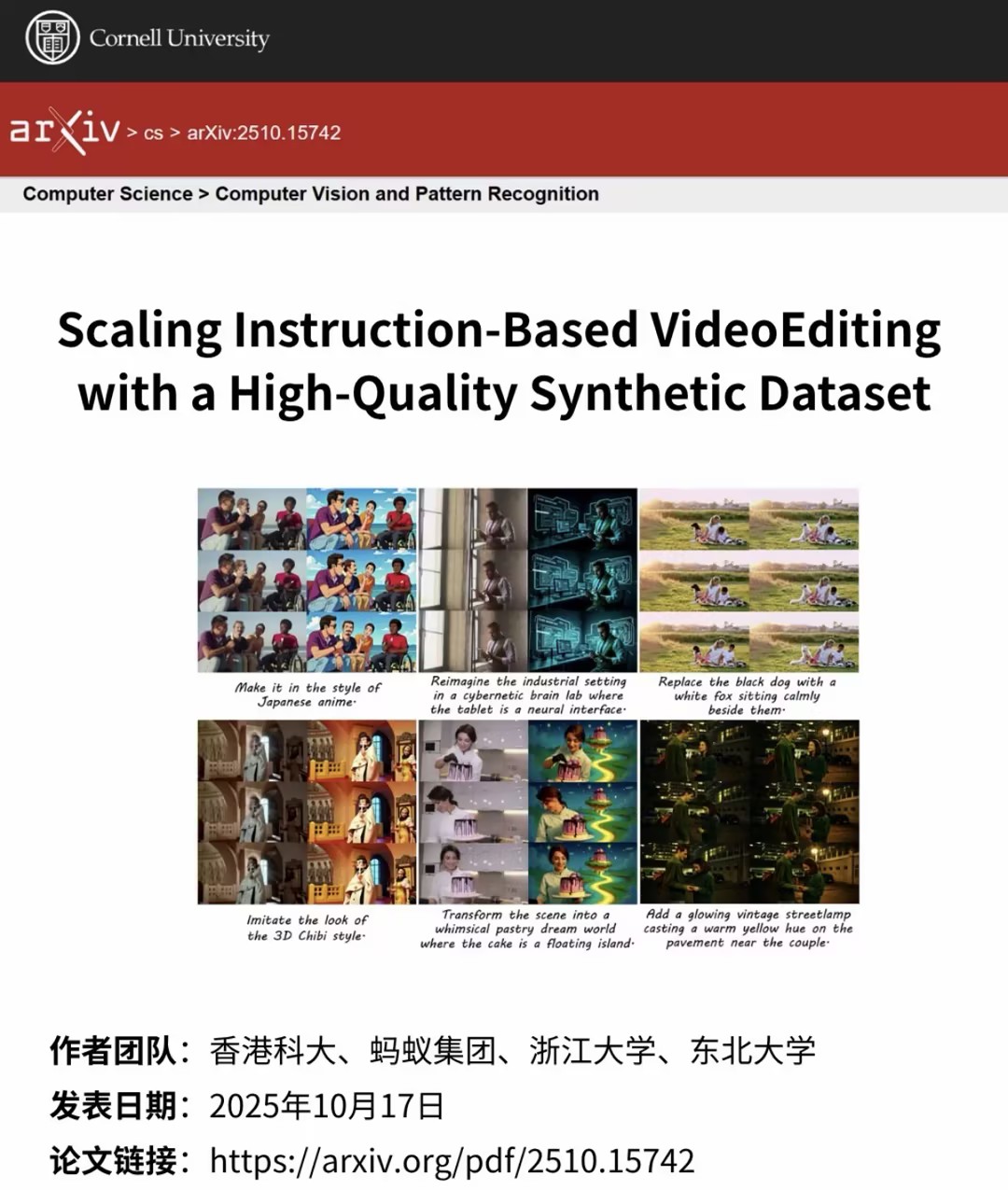

规模与质量:包含100万“源视频-指令-编辑后视频”三元组,分辨率1280×720(超现有数据集),每段101帧、20FPS,覆盖70%全局编辑(风格、场景)与30%局部编辑(物体操作)。

数据筛选严格:源视频来自专业平台(Pexels),经去重、运动筛选、VLM质量控制,确保高美学价值与自然运动特性。

(3)提出Editto模型与模态课程学习

- Editto模型:基于上下文视频生成器VACE改进,在Ditto-1M上训练后,在指令跟随、时间一致性、视觉质量上超越现有基线,成为指令驱动视频编辑的新SOTA。

- 模态课程学习(MCL):通过“逐步移除视觉引导”的训练策略,解决从“视觉+文本引导”到“纯文本指令引导”的模态鸿沟,提升模型对抽象指令的理解能力。

(4)验证框架有效性

实验证明Ditto框架生成的数据可支撑模型泛化至真实场景(sim2real能力),且Editto模型性能随数据规模增长而稳定提升,验证了大规模高质量数据的核心价值。

174

174

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?