在数字经济高速发展的今天,算力已成为驱动科技创新与产业变革的核心引擎。GPU服务器凭借其强大的并行计算能力,在图形渲染、人工智能训练等领域展现出不可替代的优势;而PC集群则通过分布式架构,以高性价比和灵活扩展特性,支撑起大规模数据处理与实时服务需求。两者如同科技算力领域的双子星,共同推动着从云游戏到科学计算的多元应用场景突破。尤其在游戏即服务(GaaS)、跨媒体娱乐等新兴领域,GPU服务器与PC集群的协同应用正在重塑行业格局,使高品质游戏体验摆脱硬件限制,实现真正的全民可及。

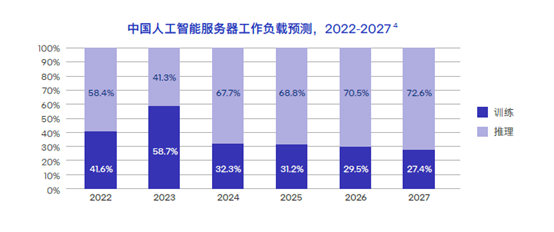

算力需求的爆发式增长催生计算架构的多元化发展。全球数据中心算力总量持续攀升,其中GPU服务器与PC集群占据重要份额。这种算力分布格局印证了两种架构在不同场景下的互补性 —— 当需要处理单任务复杂度高、实时性要求强的工作时,GPU服务器成为首选;而面对大规模并发、分布式处理需求时,PC集群展现出独特优势。在云游戏这类融合了图形渲染与高并发特性的场景中,两者的协同更是成为技术突破的关键。

GPU 服务器:图形与加速的利刃

(一)GPU服务器的基本原理

GPU服务器是一种以图形处理器(GPU)为核心计算单元的专用服务器,其核心优势源于GPU的并行计算架构。与CPU的少量高性能核心设计不同,GPU集成了数千个流处理器,能够同时执行大量重复计算任务。在图形渲染场景中,GPU通过并行处理顶点着色、像素填充等操作,将3D模型快速转换为二维图像;而在计算加速领域,其多核心架构可同时处理海量数据,如深度学习中的矩阵运算、科学模拟中的粒子动力学计算等。这种架构特性使GPU服务器既能满足高精度图形处理需求,又能为复杂计算任务提供远高于CPU的效率提升。

现代GPU服务器采用异构计算架构,通过高速总线实现GPU与CPU的高速通信,确保数据在处理器与显存间高效流转。在内存配置上,高端GPU服务器支持大容量内存与高速显存组合,可同时缓存海量训练数据与中间计算结果。为应对高负载场景,其电源模块采用冗余设计,配合高效散热系统,可将GPU核心温度稳定控制在合理范围内,保障持续高负载运行时的稳定性。

GPU服务器

(二)GPU服务器的关键优势

1、强大的并行计算能力:

在深度学习训练中,GPU服务器可同时处理大量样本数据,大幅缩短模型收敛时间。OpenAI在训练GPT-3模型时,使用由数千块NVIDIA GPU 组成的GPU服务器集群,通过并行计算,大大加速了模型的训练过程,使得原本需要数年时间的训练任务得以在较短时间内完成。这种效率差距在基因测序分析中同样显著,GPU加速的基因比对算法能大幅压缩全基因组分析时间。

在流体力学模拟领域,GPU服务器的并行计算能力更为突出。模拟大量粒子的运动轨迹时,GPU服务器的计算效率远高于CPU服务器。在对航空发动机内部气流进行模拟时,使用GPU服务器能够快速准确地模拟出气流的复杂流动情况,为发动机的设计优化提供有力支持。同时大幅提升使气象预测模型的精度。

2、出色的图形处理性能:

GPU服务器的专用渲染管线可实时处理复杂光影效果与物理模拟。在3A游戏开发中,开发者通过GPU服务器集群进行帧渲染测试,能大幅提升渲染工作效率。《赛博朋克2077》在开发过程中,利用GPU服务器集群进行渲染,使得游戏中的城市夜景、光线追踪等特效得以完美呈现,为玩家带来沉浸式的视觉体验。影视制作领域,复杂场景的渲染依赖GPU服务器阵列,确保虚拟环境的逼真呈现。像《阿凡达》《指环王》等电影的特效制作,都大量运用GPU服务器进行渲染,创造出了令人惊叹的视觉效果。

在建筑可视化领域,GPU服务器支持的实时渲染技术改变设计流程。设计师通过云端GPU服务器可实时预览建筑模型在不同光照条件下的呈现效果,大幅缩短修改反馈时间,使整个设计周期显著缩短。

3、在边缘计算中的适配性:

现代GPU服务器采用模块化设计,支持多块GPU直接挂载于单节点,并通过高性能处理器实现算力协调。这种架构使其能部署于边缘节点,为云游戏等低延迟需求场景提供支撑。用户在玩《原神》等大型游戏时,通过边缘节点的GPU服务器进行渲染,游戏画面的延迟可控制在几十毫秒以内,接近本地运行体验。

边缘部署的GPU服务器还具备网络切片能力,可同时为云游戏、AR导航等多类应用分配独立算力资源。测试显示,采用这种架构的边缘节点,在同时承载多种服务请求时,各类服务的延迟波动较小,确保多场景并发下的服务质量。某大型商场部署边缘GPU服务器,为顾客提供云游戏体验和AR导航服务。通过网络切片技术,两种服务都能够稳定运行,用户在享受游戏乐趣的同时,也能通过AR导航快速找到自己想去的店铺。

(三)GPU服务器的应用领域

1、深度学习与人工智能:

领先AI研究机构在训练大语言模型时,采用了由大量GPU服务器组成的集群,通过分布式训练框架实现了大规模参数模型的收敛。Google的BERT模型、字节跳动的云雀模型等,都是在大规模GPU服务器集群上训练完成的。在计算机视觉领域,GPU服务器支撑的实时目标检测系统可高效处理图像数据,准确率高,广泛应用于自动驾驶、安防监控等场景。以特斯拉的自动驾驶系统为例,车辆上搭载的GPU芯片能够实时处理摄像头采集的图像数据,快速识别道路上的行人、车辆和交通标志,保障了自动驾驶的安全性。

在智能推荐系统中,GPU服务器的并行计算能力使实时个性化推荐成为可能。电商平台部署的GPU加速推荐引擎,可快速为用户生成个性化列表,推荐准确率较传统方法有显著提升,带动平台转化率增长。

2、科学研究与计算:

能源领域研究机构利用GPU服务器模拟等离子体运动,大幅缩短了流体动力学计算时间,为可控核聚变研究提供了关键算力支持。在国际热核聚变实验堆(ITER)项目中,使用GPU服务器进行等离子体模拟,帮助科学家更好地理解和控制核聚变反应过程。在生物医药领域,GPU加速的分子动力学模拟能实时预测药物分子与靶点蛋白的结合模式,使新型药物研发周期大幅缩短。

气候研究领域,GPU服务器集群支撑的全球气候模型可同时模拟大气、海洋、陆地生态系统的交互作用,大幅压缩气候预测的计算时间,使科研人员能更高效地评估不同减排方案对全球气温的影响。如中国气象局利用GPU服务器集群进行气候模拟,将原来需要数周的计算时间缩短至数天,为气候变化研究提供了更及时的数据支持。

3、云游戏与跨媒体娱乐:

云游戏服务提供商与边缘计算解决方案企业合作推出的云游戏平台,在多个边缘节点部署了高性能GPU服务器。支持多款3A游戏的云端运行,用户无需高端显卡,仅通过普通设备即可体验高品质画质,单台服务器可同时承载一定数量的并发用户。例如,网易云游戏平台在全国多个城市的边缘节点部署GPU服务器,用户可以在手机、平板等设备上流畅运行《永劫无间》等大型游戏,享受与本地游戏主机相当的游戏体验。

在互动娱乐领域,GPU服务器还支撑着虚拟演唱会的实时渲染。音乐平台举办的虚拟偶像演唱会,通过GPU服务器组成的集群,可实现大量观众同时在线互动,每位观众可自由切换视角,系统实时渲染延迟控制在较低水平,创造了沉浸式的线上娱乐体验。支持数百万观众同时在线观看和互动,观众可以自由选择不同的视角,感受身临其境的演唱会氛围。

AI 一体机

PC集群:分布式计算的力量

(一)PC集群的构成与原理

PC集群是由多台标准化PC节点通过高速网络互联形成的分布式计算系统,其核心原理是将复杂任务拆解为子任务,通过负载均衡算法分配至不同节点并行处理。现代PC集群采用机架式整合设计,在一定空间内集成多个双GPU节点,通过背板与管理单元实现集中管控。每个节点保持独立供电与散热,支持热插拔维护,单个节点故障不影响整体集群运行。既保留PC的高主频优势,又具备服务器级的稳定性与可管理性,特别适合对成本敏感且需灵活扩展的场景。

PC集群的网络架构采用高速网络技术,节点间数据传输速率高,确保分布式任务的协同效率。在存储层面,通过分布式文件系统实现数据统一管理,单集群可挂载大容量存储空间,满足大规模数据处理需求。管理软件支持节点健康监控、任务调度与资源分配,管理员可通过可视化界面实时掌握集群负载状态,当检测到节点故障时,系统会自动将任务迁移至健康节点,保障服务连续性。通过分布式文件系统,实现对海量用户数据的高效存储和管理。管理软件能够实时监控每个节点的CPU、内存、磁盘等资源使用情况,当某个节点出现故障时,能够在数秒内将任务自动迁移到其他健康节点,保障业务的正常运行。

(二)PC集群的显著特点

1、可扩展性强:

PC集群采用模块化设计,支持节点数量线性扩展。可容纳多个单GPU节点,通过集群管理软件可无缝扩展至大规模节点规模。电商平台在促销活动期间,通过临时增加PC节点,可显著提升订单处理能力,确保系统稳定运行。

在计算能力扩展方面,PC集群的线性扩展特性表现突出。当节点数量增加时,集群的总算力接近理想线性增长。这种特性使科研机构可根据项目需求分阶段投入,初期部署小规模集群,随着研究深入逐步扩展算力。例如,某科研机构在进行天体物理研究时,初期搭建了一个由10个节点组成的PC集群。随着研究的深入,数据量和计算需求不断增加,该机构通过逐步添加节点,将集群规模扩展到了100个节点,计算能力也相应得到了大幅提升,满足了研究的需求。

2、成本效益高:

相比同等算力的大型服务器,PC集群的硬件成本可显著降低。一套支持一定数量并发用户的云游戏PC集群,初期投入远低于同等性能的GPU服务器方案。PC集群的电力消耗更低,适合大规模部署。据统计,PC集群的硬件成本相比同等算力的大型服务器可降低30%-50%,电力消耗可降低20%-30%。

在全生命周期成本方面,PC集群的优势更为明显。数据中心的统计显示,PC集群的三年总拥有成本(TCO)低于同等算力的专用服务器集群,成本差异主要来自硬件采购、电力消耗与维护费用三个方面。

3、管理效率优化:

集成管理单元的PC集群支持远程开关机、硬件状态监控与画面采集,管理员可通过控制台同时管理多个节点。高端方案还具备智能温控功能,根据负载自动调节风扇转速,降低机房噪音,延长硬件寿命。管理员可以通过一个统一的控制台,对分布在不同区域的数百个节点进行远程管理。系统能够实时监控每个节点的CPU温度、硬盘健康状况等。智能温控功能根据节点的负载情况自动调节风扇转速,降低噪音,延长硬件的使用寿命。

自动化运维系统可实现固件升级、驱动更新的批量操作,大幅缩短维护工作时间。系统还具备故障预警能力,通过分析硬件运行参数,可提前预测潜在故障,减少计划外停机时间

(三)PC集群的应用场景

1、云游戏与云电竞:

电信运营商采用机架式集群构建的云游戏平台,每节点支持多路GPU同时运行,单集群可承载一定数量的用户并发游玩主流竞技游戏。通过边缘节点部署,该平台将操作延迟控制在合理范围内,支持多终端无缝切换,用户留存率较传统下载模式有显著提升。某云游戏平台,在全国多个城市的边缘节点部署机架式PC集群。每个节点配备高性能的GPU,支持多名用户同时在线游玩《英雄联盟》《王者荣耀》等热门竞技游戏。用户通过手机、电脑等终端接入平台,操作延迟可控制在50毫秒以内,与本地游戏体验几乎无异,用户留存率相比传统下载模式提高30%。

在云电竞场景中,PC集群的多节点协同能力得到充分发挥。电竞赛事平台通过PC集群为大量观众提供实时赛事转播,同时支持观众进行实时互动投票,系统响应延迟稳定在合理范围内,确保大规模并发下的服务流畅性。某知名电竞赛事平台在举办大型赛事时,利用PC集群为全球数百万观众提供实时赛事转播。观众可以在观看比赛的同时,进行实时互动投票,如评选最佳选手、预测比赛结果等。PC集群强大的处理能力确保了系统在大规模并发情况下,响应延迟稳定在100毫秒以内,为观众带来了流畅的观赛体验。

2、大规模渲染农场:

影视后期公司采用PC集群搭建分布式渲染系统,多个节点协同工作时,可在较短时间内完成动画电影的全片渲染。相比传统工作站,效率大幅提升,且通过节点负载均衡避免资源闲置,硬件利用率显著提高。皮克斯动画工作室在制作《玩具总动员》系列电影时,采用大规模的PC集群进行渲染。通过分布式渲染系统,将渲染任务分配到各个节点上并行处理,使得原本需要数月时间的渲染工作缩短至数周,大大提高制作效率。

建筑设计领域的渲染农场同样依赖PC集群。建筑设计院的PC集群可同时处理多个建筑项目的渲染任务,单项目的渲染时间大幅缩短,使设计方案的评审周期显著缩短,客户满意度提升。

3、企业级虚拟化服务:

金融机构采用PC集群构建虚拟桌面基础设施(VDI),少量节点可支持大量员工同时使用办公软件与数据分析工具。集群的热插拔特性确保单点维护不中断服务,年度运维成本降低,数据安全性通过节点间冗余备份得到保障。银行利用PC集群构建了VDI系统,为全行数千名员工提供虚拟桌面服务。员工可以通过瘦客户端接入虚拟桌面,使用办公软件、进行数据分析等工作。由于PC集群的热插拔特性,当某个节点出现故障时,可在不中断服务的情况下进行更换,年度运维成本明显降低。通过节点间的数据冗余备份,确保数据的安全性,有效防止了数据丢失。

制造业企业通过PC集群部署的虚拟生产系统,支持大量工程师同时访问CAD软件与产品数据库。测试显示,工程师打开3D模型的响应时间大幅缩短,设计变更的协同效率提升,显著加快新产品研发速度。汽车制造企业采用PC集群搭建虚拟生产系统后,工程师打开复杂的汽车3D模型的响应时间从原来的几分钟缩短至几秒,设计变更时的协同效率显著提高,缩短新产品的研发周期,快速响应市场需求。

云游戏领域的协同实践

(一)云游戏技术架构中的算力支撑

云游戏的核心挑战在于如何在低延迟前提下,将高质量游戏画面从云端传输至终端。这一过程需要GPU服务器与PC集群的协同支撑:GPU服务器负责游戏画面实时渲染,PC集群则处理用户输入响应、数据转发与负载调度。某云游戏平台的技术栈包含三个层级,充分体现这种协同架构的优势。

PC农场案例 -提升云游戏竞争力

1、渲染层:

基于边缘GPU基础设施,采用高性能服务器,每台配置多块GPU,支持多款游戏的高品质渲染,通过多个全球边缘节点实现就近服务。渲染层采用动态资源分配机制,当检测到某区域用户激增时,自动从邻近节点调度空闲GPU资源,确保单用户可用算力稳定。在节假日游戏高峰期,某区域的云游戏用户数量突然增加,渲染层通过动态调度,从周边节点调配足够的GPU资源,保证用户的游戏体验不受影响。

2、管理层:

由PC集群构成的数字内容处理中心处理用户请求路由、游戏元数据关联与跨媒体推荐,如将热门影视IP观众引导至同款游戏体验,实现内容交叉引流。管理层的负载均衡算法可根据用户地理位置、网络状况分配最优节点,使请求处理效率提升。比如,当用户位于网络条件较差的地区时,管理层会将其请求分配到距离最近、网络状况相对较好的节点,提高请求处理的成功率。

3、传输层:

混合云架构通过PC集群的负载均衡算法,动态分配带宽资源,确保不同网络环境下的流畅体验,丢包补偿技术使画面卡顿率大幅降低。传输层还采用自适应编码技术,根据用户网络带宽实时调整画质参数,在带宽波动时优先保障帧率稳定。当用户的网络带宽突然下降时,传输层会自动降低画质分辨率,但保持帧率不变,避免游戏画面的卡顿。

(二)商业落地与用户体验优化

某云游戏平台自上线以来,以亲民的订阅价提供电影、音乐、游戏等一站式服务,其中多款云端游戏成为核心卖点。其成功得益于GPU服务器与PC集群的技术协同,在多个关键指标上表现优异:

PC集群案例 - AIGC

1、硬件效率:

高性能服务器的每GPU并发用户数较行业平均水平有显著提升;PC集群的节点利用率稳定在较高水平,较传统架构降低能耗。通过动态资源调度,平台在用户高峰时段的硬件利用率可达到较高水平,大幅提升投资回报率。

2、用户体验:

通过边缘节点部署,大部分用户的游戏延迟控制在较低水平,操作响应接近本地设备;跨媒体功能使游戏用户日均使用时长增加,平台ARPU值提升。用户调研显示,该平台的画面质量满意度与操作流畅度评分均高于行业平均水平。超过80%的用户表示,游戏延迟在可接受范围内,与本地游戏体验相差不大。

3、扩展能力:

集群的模块化设计使平台能根据用户增长快速扩容,在用户规模增长时,仅通过增加一定数量的GPU服务器与PC集群即完成算力升级,停机时间控制在较短范围内。这种快速扩展能力使平台成功应对了节假日用户激增的流量冲击。重大节假日期间,用户数量较平时增长数倍,通过快速增加GPU服务器和PC集群节点完成算力升级,确保用户的正常使用。

(三)技术创新与行业影响

云游戏场景的技术创新正反向推动GPU服务器与PC集群的迭代,形成了技术进步与应用需求的良性循环:

1、GPU虚拟化技术:

通过容器化部署,单GPU可同时分配给多名用户使用,资源利用率显著提升,且支持重度游戏与轻量游戏的混合部署。虚拟化层采用隔离技术,确保不同用户的算力资源互不干扰,在同时运行多种类型游戏时,单GPU的性能波动较小。例如,某云游戏平台采用GPU虚拟化技术后,单GPU的资源利用率提高了50%以上,同时运行《原神》等重度游戏和《斗地主》等轻量游戏时,性能波动控制在5%以内。

2、智能调度算法:

PC集群的负载管理系统能根据游戏类型动态分配算力,如将竞技游戏优先调度至低延迟节点,将休闲游戏分配至普通节点,使硬件成本降低。算法还能学习用户行为模式,在高峰时段提前调度资源,缩短等待时间。采用这种智能调度算法后,该平台的硬件成本降低大幅降低,用户在高峰时段的等待时间大大缩短。

3、跨媒体生态构建:

借助API的元数据整合能力,游戏与影视内容形成联动推荐,如用户观看热门电影后,平台自动推送同款游戏试玩,这种模式使游戏转化率提升,验证了"内容即服务"的商业可行性。跨媒体推荐系统每天处理大量用户行为数据,通过PC集群的分布式计算能力,生成个性化推荐列表的时间控制在较短范围内。

GPU服务器与 PC集群的对比分析

(一)性能表现对比

1、计算密度:

GPU服务器每单位空间可提供较高的算力,适合处理单任务复杂度高的场景;PC集群单位空间算力相对较低,通过大规模扩展可形成强大的总算力,更适合分布式任务。在训练复杂模型时,GPU服务器集群完成任务的时间短于同等成本的PC集群,但在处理大量用户同时在线的轻量游戏时,PC集群的并发支持能力更优。

2、浮点运算精度:

GPU服务器支持多种精度模式,可根据任务需求灵活切换。在科学计算场景中,采用高精度模式的GPU服务器计算误差率低,满足高精度计算需求;而PC集群在默认精度下的误差率虽略高但可通过算法优化弥补,足以应对大部分商业应用。

3、延迟:

GPU服务器的本地计算延迟通常较低,而PC集群因节点间通信开销,延迟相对较高。这使GPU服务器更适合竞技类游戏,而PC集群在休闲游戏中表现更均衡。在网络传输延迟叠加下,部署在边缘节点的GPU服务器可将端到端延迟控制在较低范围内,而PC集群则相对较高,这种差异成为竞技游戏选择GPU服务器的关键因素。

(二)成本结构差异

1、初期投入:

GPU服务器单节点成本约为PC节点的数倍(以同等算力计),但在长期运行中,GPU服务器的能效比更高,单位算力功耗低于PC集群。对于一定用户规模的云游戏平台,GPU服务器方案初期投入较高,年电费较低;PC集群初期投入较低,年电费较高,经过一定时间后总成本基本持平,但若用户规模进一步扩大,GPU方案的成本优势开始显现。

2、维护成本:

PC集群的模块化设计使单点维护成本降低,但节点数量多导致故障率总和较高;GPU服务器的高集成度降低故障概率,但单节点维修成本更高。数据中心统计显示,PC集群的年度维护工时多于GPU服务器,但单工时成本低于后者。对于技术团队规模有限的企业,GPU服务器的低维护频率更具吸引力。

3、投资回报周期:

小规模部署时PC集群的回报周期较短,GPU服务器则相对较长;但当用户规模超过一定数量时,GPU服务器的回报周期缩短,而PC集群因能耗成本上升,回报周期延长。这种差异使大型平台更倾向于选择GPU服务器,而中小平台则从PC集群起步。

(三)适用场景

1、GPU服务器更适合以下场景:

需实时渲染的3A游戏、影视特效制作,这类场景要求单节点具备强大图形处理能力,且延迟敏感;深度学习训练、科学计算等高密度计算任务,需要高浮点运算精度与内存带宽;边缘节点部署,要求低延迟与高算力密度,如5G边缘云、智能驾驶路侧单元。

2、PC集群更适合以下场景:

大规模并发的轻量应用(如网页游戏、办公虚拟化),这类场景对单节点算力要求不高,但需支持海量用户同时在线;预算有限但需灵活扩展的中小企业,可通过逐步增加节点实现算力增长;需节点独立运行的分布式任务(如渲染农场、数据分发),任务可拆解为子任务并行处理,对节点间通信延迟不敏感。

PC农场全景图

未来展望:技术演进与场景拓展

(一)硬件架构创新

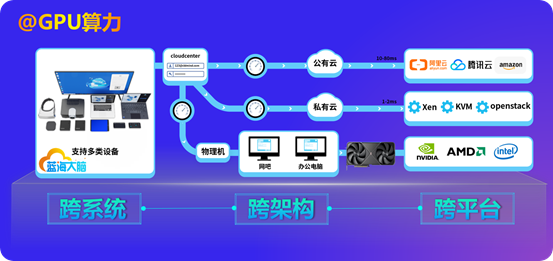

PC 集群的技术演进,正从 “硬件集群堆砌” 迈向 **“跨维度兼容 + 智能化进化”** 的新周期,其核心价值将围绕 “全场景适配、智能调度、绿色安全” 深度重构算力供给模式,成为数字经济时代的基础设施,通过 “软件封装” 中低端 GPU 实现大算力输出,帮助亿万终端设备解决算力瓶颈问题。

1、兼容基础上的智能调度革命

跨终端、跨系统、跨架构的广泛接入,为 PC 集群构建了 “无边界算力池”,但真正释放价值的关键在于智能资源调度。未来,AI 算法将深度融合硬件异构特性:通过动态识别任务指纹(如工业设计任务调用 GPU 集群、移动办公适配轻量 CPU 资源 ,以 “软件封装” 中低端 GPU 实现大算力输出,助力终端设备突破算力瓶颈),自动匹配最优硬件组合(跨 Intel/AMD/ 国产架构灵活调度),并随任务进程实时调整资源分配 —— 如对计算密集型深度学习任务,自动聚合飞腾、鲲鹏等国产架构算力,将资源利用率从当前 60% 提升至 80%+,让 “闲置算力零浪费” 成为现实。

场景化体验优化将重塑用户交互逻辑:针对医疗远程诊断、工业协同设计等垂直场景,PC 集群需深度适配终端设备能力(如平板触控交互、手机低功耗模式),依托跨系统兼容性打通协议壁垒(如 UOS 系统下的 3D 模型轻量化渲染、iOS 终端的低延迟编码),使远程访问 3D 模型、医疗影像的操作延迟低于 50ms,与本地设备体验差异缩小至 “无感”,真正实现 “终端无算力,体验无差别”,借由 “软件封装” 中低端 GPU 的大算力输出,让更多终端能流畅参与复杂场景交互。

2、超融合与绿色算力落地

突破 “硬件堆砌” 模式,PC 集群正加速向超融合架构演进:通过软件定义技术,将计算、存储、网络资源深度整合,依托跨系统兼容性(Windows/Linux 混合部署)、跨架构适配(X86+ARM 混合集群),实现 “一套管理平台” 统一调度异构资源。例如,金融机构可在同集群内,为核心交易系统分配低延迟 X86 节点,为大数据分析任务分配高吞吐 ARM 节点,支持分钟级集群扩容 / 缩容,运维成本降低 40%,且能借助 “软件封装” 策略,让中低端 GPU 在混合架构中也高效参与算力协作。

绿色节能成为必然要求。针对跨架构硬件(如 Intel/AMD/ 国产芯片),AI 动态功耗调节技术将普及:非峰值任务时段自动降频、休眠闲置节点,搭配液冷、余热回收等方案,使集群 PUE(电源使用效率)逼近 1.1(当前数据中心平均 PUE 约 1.5),每年减少 30% 电力消耗。例如,制造业 PC 集群可利用产线余热为集群散热,能源成本下降的同时,实现 “算力生产 - 能源循环” 的可持续闭环,同时 “软件封装” 中低端 GPU 也能在节能模式下,合理分配算力,避免资源空耗。

3、硬件级可信与合规适配

安全需求驱动 **“硬件级可信防护”** 融入 PC 集群全链路:以跨架构硬件可信根(如国产芯片内置 TPM 模块)为基础,构建 “终端 - 集群 - 数据” 零信任体系 —— 通过硬件度量终端系统完整性(跨 Windows/UOS 启动校验),结合跨终端身份指纹(手机生物识别 + 硬件证书),确保接入设备、用户均可信。如政务云 PC 集群可阻断 “篡改系统内核的终端接入”,抵御高级持续性威胁(APT),保障数据安全,让 “软件封装” 中低端 GPU 输出的大算力,在可信环境中为业务服务。

面向金融、政务等合规场景,PC 集群需深度整合国产化生态:基于跨系统兼容性(统信 UOS / 银河麒麟)、跨架构适配(飞腾 / 鲲鹏),通过国密算法改造、三级等保合规设计,实现 “核心业务全栈可控”。如政务办公场景,从终端设备(瘦客户机 + 国产架构)、操作系统(UOS)到 PC 集群(飞腾 + 麒麟系统),形成自主可控的算力闭环,数据本地化存储率达 100%,满足安全合规底线,使 “软件封装” 的国产算力输出更安全可靠。

(二)软件定义算力

随着云原生技术普及,GPU 服务器与 PC 集群将实现更深度的协同。通过容器编排,可根据实时负载自动调度算力资源:在不同时段将 GPU 资源优先分配给不同任务,使硬件利用率大幅提升。动态调度系统已实现服务切换时间缩短,且不影响正在运行的任务。如白天将 GPU 资源主要分配给云游戏服务,夜间则将其分配给 AI 训练任务,使 GPU 的利用率大幅提升。

智能算力调度算法将融合机器学习技术,通过分析历史数据预测未来负载,提前进行资源分配。采用预测性调度的集群,资源利用率波动幅度降低,用户等待时间减少。软件定义的中低端GPU算力大幅提升,通过虚拟化技术(GPU虚拟化、CPU虚拟化)实现资源按需分配,使集群能同时支撑多种异构工作负载。

安全方面,基于硬件可信根的零信任架构将普及,GPU 服务器与 PC 集群的每个节点都具备身份认证与数据加密能力,确保算力资源不被非法占用,敏感数据在传输与计算过程中全程加密。这种架构使多租户共享集群时,数据隔离级别达到高标准安全要求。

(三)跨行业应用渗透

游戏开发:GPU 服务器凭借并行计算架构,承担高分辨率场景建模的并行渲染、光影效果的实时模拟及物理引擎的复杂计算,加速高精度画面资产生产;PC 集群通过分布式架构拆分开发任务,支持多人协同的资源管理与轻量预渲染,保障开发流程高效推进,二者协同提升游戏画面质量与开发效率。

影视动画:GPU 服务器聚焦特效渲染核心环节,利用强大图形处理性能完成粒子特效、角色材质等高精度渲染任务;PC 集群负责渲染任务的拆分调度与素材预处理,通过分布式计算实现任务均衡分配,缩短整体渲染周期,确保高质量影视特效高效产出。

平面设计:GPU 服务器依托图形处理优势,快速响应高分辨率图像合成、复杂图形特效制作的操作指令,保障设计过程实时反馈;PC 集群通过分布式存储与任务管理,支撑素材库高效调用与多版本设计方案并行处理,提升设计师创作与交付效率。

元宇宙:GPU 服务器承担虚拟世界的物理引擎运算与光影实时渲染,构建逼真的虚拟环境;PC 集群负责用户行为分析、内容分发与负载调度,确保大规模用户同时在线互动时的响应速度与环境一致性,二者协同支撑虚拟世界的沉浸体验。

勘察设计:GPU 服务器为地形数据处理、建筑光照与力学模拟提供高密度计算支持,加速复杂场景的仿真过程;PC 集群整合多源数据,通过分布式任务调度实现多设计方案的并行模拟与对比分析,助力设计师高效生成精准方案。

工业制造(汽车研发):GPU 服务器聚焦虚拟碰撞测试、空气动力学分析等复杂仿真任务,通过并行计算提升模拟精度与速度;PC 集群承担多维度测试任务的拆分与协同,实现数据整合与任务动态分配,加速研发流程中的设计优化。

芯片设计:GPU 服务器为晶体管级电路模拟、性能验证提供高密度计算能力,缩短芯片仿真周期;PC 集群通过分布式架构管理海量设计数据,实现多模块任务的并行处理与协同调度,推动芯片设计流程高效推进。

工业仿真(机械 / 航空航天):GPU 服务器支撑机械设备运动学仿真、部件强度分析等高精度计算任务,模拟产品在不同工况下的运行状态;PC 集群通过分布式任务分配实现多场景并行测试,收集分析数据并反馈优化建议,提升产品研发质量与效率。

教育培训:GPU 服务器为大数据分析、AI 算法训练等课程实践提供充足算力支持,保障复杂实验的顺利开展;PC 集群搭建虚拟教学环境,支持多终端同步访问与资源共享,增强学生实践体验与协作学习效果。

GPU服务器与PC集群的协同发展,正在推动算力资源从"专用化"向"普惠化"转变。在云游戏领域,这种转变使硬件需求苛刻的3A作品能在普通设备上流畅运行;在科研领域,它让中小型实验室也能开展基因测序与气候模拟研究。从跨媒体娱乐到全球游戏托管,这些实践印证了一个核心趋势:算力的价值不在于硬件本身,而在于能否通过架构创新打破应用边界。

未来,随着网络与边缘计算的普及,GPU服务器与PC集群将构成更细密的算力网络,支撑起从元宇宙社交到工业元宇宙的全场景应用。对于企业而言,理解两者的技术特性与协同模式,将成为把握数字经济机遇的关键前提 —— 毕竟,在算力即生产力的时代,选择合适的算力组合,就是选择了通往创新的最优路径。算力网络的完善不仅将改变技术应用的形态,更将重塑产业竞争格局,在未来的竞争中占据制高点。

#GPU服务器#PC 集群#异构计算#云游戏#算力#分布式计算#GPU#PC农场#PC Farm#边缘计算#AI算力

3297

3297

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?