在选择构建AI计算平台时,一个关键决策摆在面前:是选择标准PCIe GPU的灵活性,还是投身于NVIDIA专有的SXM架构以追求极致性能?这个选择远非简单的接口差异,它深刻地影响着系统架构、互联带宽、总体拥有成本以及最终的任务执行效率。理解SXM与PCIe的根本区别,并非比较孰优孰劣,而是厘清它们各自的设计哲学与应用边界,从而为特定的工作负载做出最明智的决策。

本质上的区别:专用系统 vs. 通用标准

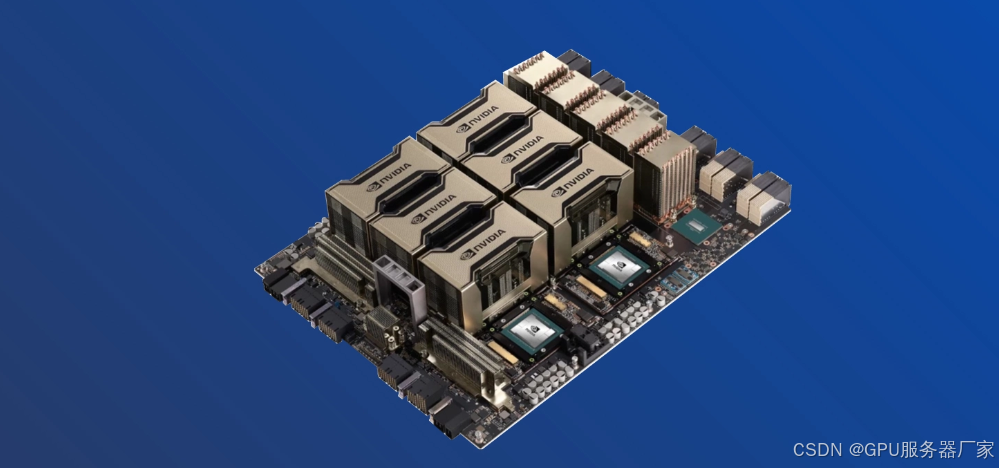

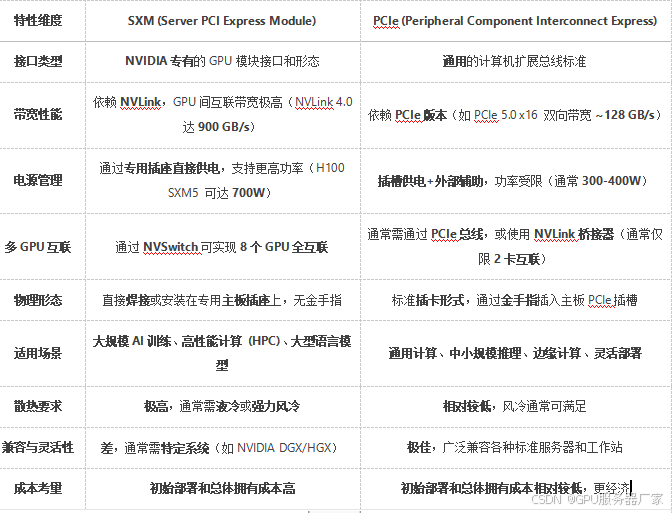

首先,最核心的区别在于:SXM并不是一个替代PCIe的接口标准,而是NVIDIA为其数据中心级GPU设计的一种专属封装和互联形态。它的全称“Server PCI Express Module”有点误导性,因为它最关键的特性恰恰是绕开了PCIe总线在GPU间通信时的瓶颈。

PCIe 是一种开放的、通用的扩展总线标准。它的设计目标是让各种不同的设备(GPU、网卡、SSD等)能够以一种标准化的方式与CPU和内存系统连接。它的核心优势是灵活性和兼容性。

SXM 是NVIDIA为了追求极致性能,特别是多GPU协同计算性能,而打造的专有解决方案。它是一整套包含物理封装、供电、散热和高速互联技术的集成式设计

深入技术细节:架构、互联与设计哲学

1. 互联架构:通信路径的根本差异(这是两者最根本的性能分水岭)

PCIe的通信路径:

在典型的PCIe多GPU系统中,当两块GPU(例如两块RTX 4090)需要交换数据时,数据必须离开GPU A,通过PCIe总线“北上”到CPU的PCIe根复合体(Root Complex),然后再“南下”通过PCIe总线到达GPU B。这条路径长,延迟高,且带宽受限于当时PCIe版本的瓶颈(如PCIe 5.0 x16双向带宽约128 GB/s)。即使使用NVLink桥接器(NVIDIA NVLink Bridge)连接两张卡,其本质也是创建了一条点对点的专用链路,但通常仅限于双卡,且带宽远不如SXM架构中的NVLink。

SXM的通信路径:

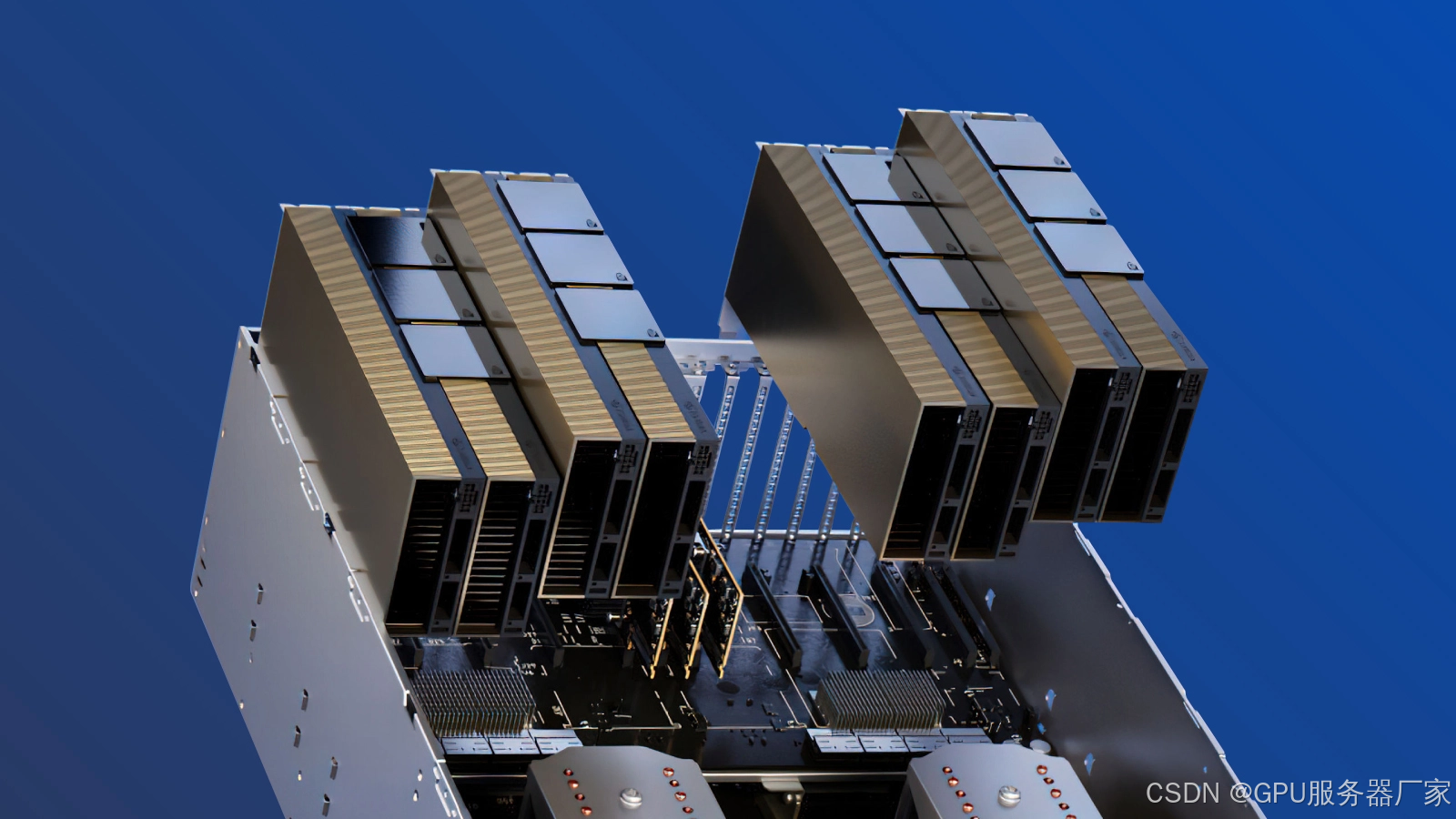

SXM模块本身通过PCIe与CPU通信(所以它仍然兼容PCIe协议),但其GPU与GPU之间的通信完全不走PCIe总线。在SXM系统中(如DGX H100),多个SXM模块被安装在一个专门的主板上,这个主板上集成了名为 NVSwitch 的专用交换芯片。

每个GPU通过其NVLink接口直接连接到NVSwitch芯片上。当GPU A需要与GPU B通信时,数据通过NVLink直接发送到NVSwitch,然后由NVSwitch直接转发给GPU B。这条路径是点对点的,完全绕开了PCIe和CPU,延迟极低,带宽极高。

以H100 SXM5为例,其第三代NVLink技术提供了高达900 GB/s的GPU间双向带宽,是PCIe 5.0 x16的7倍多。更重要的是,NVSwitch可以实现全互联,即8个甚至更多GPU中的任意两个都能以这种高速直接通信,形成一个庞大、统一、高效的计算 fabric(网络)。这对于需要频繁进行All-Reduce等集合通信操作的大模型训练至关重要。

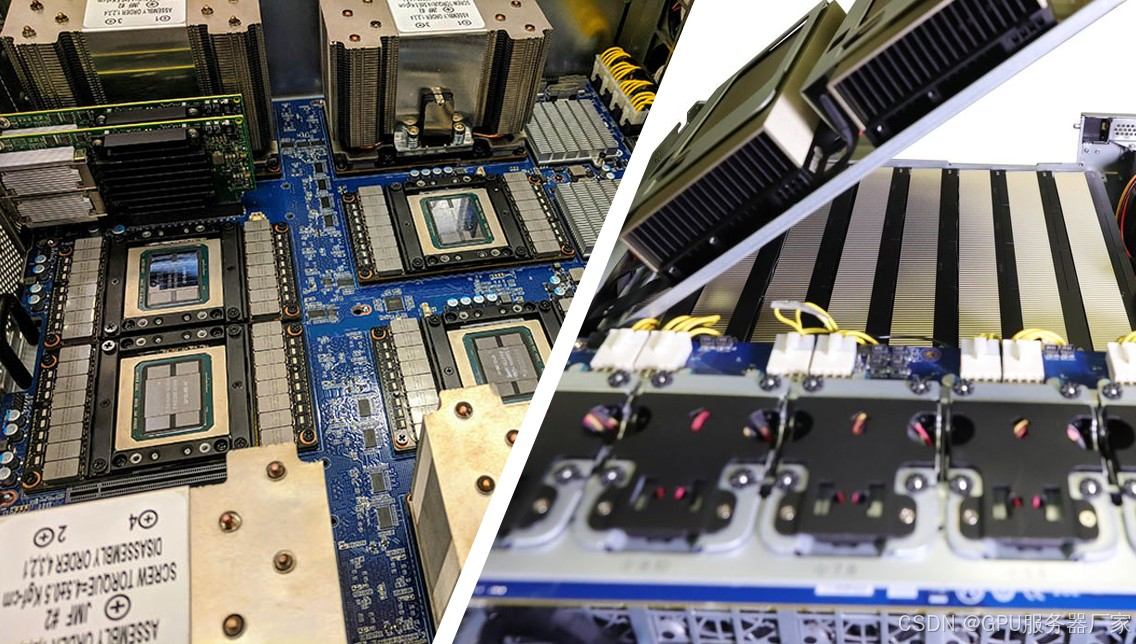

2. 物理形态与集成度:焊死 vs. 插拔

PCIe:采用大家熟悉的插卡形式,通过金手指插入主板的PCIe插槽。这种设计赋予了它无与伦比的灵活性。用户可以根据需要随时购买、升级、更换单块GPU,可以安装在无数种不同品牌和规格的服务器、工作站甚至个人电脑中。

SXM:模块没有金手指。它是一块裸露的电路板,GPU、显存(HBM)等元件直接封装在上面,通过一个专用的、巨大的插座与主板连接。这个插座不仅传输数据信号,更重要的是直接提供巨额电力。

这种设计带来的好处是:

①优化的电气特性:消除了金手指可能带来的信号衰减和完整性挑战,为超高频率信号(如NVLink)提供了更纯净的通道。

②高密度集成:SXM模块可以非常紧密地排列在一起,从而实现极高的计算密度。

代价就是完全丧失了灵活性和兼容性。你无法单独购买SXM模块并将其插入普通服务器。你必须购买NVIDIA设计好的整个系统,比如DGX(单个服务器)或HGX(主板参考设计,由超微等O厂商集成成服务器)。

3. 供电与散热:能量消耗的尺度差异

PCIe:受限于PCI-SIG的标准规范。PCIe插槽本身最多提供75W功率,额外的功率需要通过外接的6-pin或8-pin PCIe电源线缆提供。通常,一张顶级PCIe显卡的功耗上限被设计在400W到500W左右。散热主要依靠自带的风冷散热器。

SXM:由于其专用性,完全不用考虑通用标准限制。SXM插座可以通过大量的引脚直接提供远超PCIe标准的电力。H100 SXM5的TDP达到了惊人的700W。如此巨大的能量密度,使得传统风冷几乎无法有效散热。因此,SXM系统几乎无一例外地采用更大的风冷散热系统。这不仅是为了降温,更是为了将GPU核心温度维持在一个可以持续运行在最高boost频率下的水平,从而榨取全部性能。供电和散热的设计,直接决定了SXM是为数据中心级别的基础设施而生的。

应用场景与哲学:不同的使命

PCIe的使命:普惠与灵活

PCIe GPU是通用计算的基石。它的目标是在尽可能多的平台和场景中提供强大的加速计算能力。无论是AI推理、中小规模的模型训练、科学计算、图形渲染,还是视频编码,PCIe GPU都能胜任。它的生态系统是开放的,鼓励竞争,为用户提供了丰富的选择和更具成本效益的解决方案。它是“民主化”的高性能计算。

SXM的使命:征服性能巅峰

SXM的目标只有一个:为最大、最复杂的计算问题提供无与伦比的性能。当你的训练任务需要数天甚至数周,而通信瓶颈成为主要制约因素时,SXM的价值就体现出来了。它将所有资源(算力、高速互联、供电、散热)整合到一个高度优化的封闭系统中,以追求极致的效率和速度。它服务的对象是那些需要训练千亿参数级别大模型的大型科技公司、研究机构和超算中心。它不是用来“通用”的,而是用来“专攻”最顶点的挑战。

总结

SXM和PCIe是NVIDIA GPU两种不同的接口形态和互联理念,直接决定了GPU的工作方式和性能上限。

PCIe (Peripheral Component Interconnect Express) 是通用标准,核心优势在于灵活性、兼容性和更低的总体拥有成本。它适合更广泛的应用场景,尤其是在单卡性能为主或对多卡互联带宽要求不高的任务中。

SXM (Server PCI Express Module) 是NVIDIA的专有设计,核心价值在于通过NVLink和NVSwitch实现极致的GPU间互联带宽和扩展性,为大规模并行计算优化。但它通常需购买整个专用系统,成本高昂且缺乏灵活性。

可以做一个生动的比喻:

PCIe GPU 像是顶级跑车。每一辆(每一张卡)本身性能极其强悍,你可以自由选择买一辆、两辆,或者把它们停放在不同的车库(服务器)里。但它们之间协作需要普通的公路(PCIe总线),交通效率有上限。

SXM系统 像是一列精心调校的高速磁悬浮列车。每一节车厢(每个SXM模块)的性能或许和跑车相近,但它们被刚性连接在一起,运行在专属的真空管道(NVLink+NVSwitch Fabric)中,拥有极低的空气阻力和摩擦,所有车厢以完美的同步和极高的效率共同向着一个目的地前进。

因此,选择SXM还是PCIe,从来不是在比较两种接口孰优孰劣,而是在于审视你的任务规模、性能瓶颈、基础设施预算和总体拥有成本。对于绝大多数应用,PCIe提供了最佳性价比和灵活性。但当你需要挑战计算领域的珠穆朗玛峰时,SXM是那把必不可少的专业冰镐。

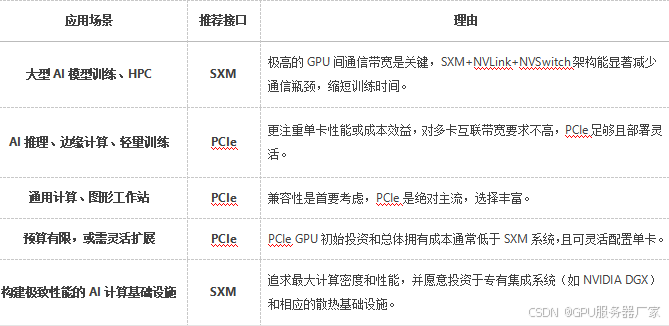

选择建议:

如果你的工作负载主要集中在推理、边缘计算、中小型模型训练,或者需要灵活的配置和升级,PCIe GPU是更经济、务实的选择。

如果你的核心业务是训练超大规模人工智能模型(如大型语言模型)、进行高性能计算,且追求极致的计算效率和速度,预算充足,那么投资基于SXM的系统(如NVIDIA DGX/HGX)是值得的,它能有效减少通信瓶颈,提升整体效率。

希望以上分析能帮助你做出明智的决策。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?