你是不是也发现,最近想换显卡越来越贵,甚至根本抢不到?

手机价格悄悄上涨,连二手内存条都变得抢手?

别急,这背后是一场由AI引爆的全球内存供应地震,而且才刚开始。

一、AI的“饭量”有多大?揭秘服务器如何“吃光”全球内存

开头我们抛出一个问题:为什么AI会导致全球内存短缺?要理解这一点,我们得先弄明白AI服务器和咱们普通电脑的“食量”差异。

1. 一个比喻:普通电脑是“家庭小炒”,AI服务器是“万人宴席”

你的电脑: 处理文档、看视频,就像在家里做一顿饭。需要的食材(内存)不多,一个8G或16G的“菜篮子”(内存条)就足够了。

AI服务器: 运行一次大规模AI推理(比如同时处理成千上万用户的提问、生成图片或自动驾驶数据),就像操办一场“万人宴席”。它需要瞬间处理TB级别的海量数据——这相当于把几百部高清电影同时塞进后厨。你家的“小菜篮”瞬间就不够看了。

2. 两种关键的“食材”为何严重缺货?

这场“万人宴席”需要两种顶级食材,而它们现在都供不应求:

食材A:HBM——后厨的“超级传菜梯”

·它是什么? 高带宽内存。你可以把它想象成连接厨房和宴会厅的高速、多层传菜电梯。

·为什么关键? 传统内存是“单层小梯子”,数据一盘一盘慢慢送。而HBM通过3D堆叠技术,建起了一座“立体交通枢纽”,能让数据几十盘、上百盘地并行高速送达给AI芯片(CPU/GPU)。没有这个“超级传菜梯”,AI芯片这个“大厨”再厉害,也得停工等菜。

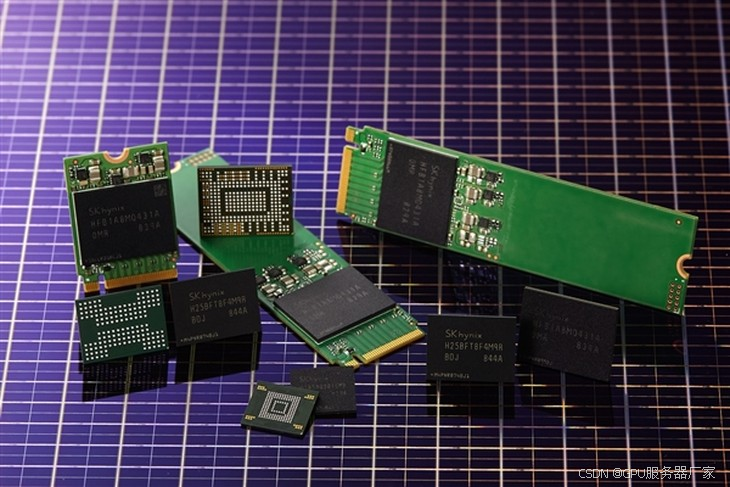

·为什么缺? 技术极其复杂,全球只有三星、SK海力士、美光少数几家能大规模生产,产能爬升慢,而“订宴席”的AI公司却蜂拥而至。

食材B:RDIMM——后厨的“中央储备粮仓”

·它是什么? 服务器内存模组。这就是AI服务器的“中央粮仓”,用来存放所有待处理的原始数据、中间计算结果和最终的“成品菜”。

·为什么关键? 即便有HBM这个“传菜梯”高速运送,你总得有个地方来堆放如山的面粉、蔬菜和肉类(原始数据)吧?RDIMM就是这个“粮仓”。一个AI服务器动不动就需要配备1TB甚至数TB的RDIMM,是普通电脑的几十上百倍。

·为什么缺? 需求是“海啸级”的增长。每一台新部署的AI服务器,都在无情地消耗着全球的RDIMM产能。

3. 连锁反应:巨头开始“扫货”,危机预警拉响

当正常的供应链无法满足这种爆发式需求时,市场就开始“变形”了。

“扫货”模式开启: 像华硕这样的巨头,公开承认不得不从现货市场购买内存。这是什么概念?就像一个大型连锁超市,因为常规供应商断供,被迫去菜市场零售摊点高价抢购,这直接推高了整个市场的价格水位。

库存告急: 华硕说库存能撑到年底,这话需要反过来听:这其实是一颗“定心丸”式的预警,潜台词是“如果明年供应没有根本改善,我们就真的麻烦了”。

专家预判: 因此,业内将2026年视为一个关键节点。如果HBM和RDIMM的产能没有突破性增长,届时供需矛盾将彻底爆发,“有钱也买不到货”可能成为现实,价格调整将不再是猜测。

二、为何是“十年风暴”?一场深陷“需求陷阱”的产业链博弈

如果说第一部分描绘的是AI“海啸”的第一波冲击,那么“十年风暴”的预测则揭示了我们正深陷一个结构性的“需求陷阱”。这并非短期波动,而是底层逻辑的彻底改变。

1. 风暴的“风眼”:从“算力饥渴”到“数据饥渴”的范式转移

早期AI竞争的核心是“算力”,大家比拼的是GPU的数量。但业界正面临一个残酷现实:空有强大的算力芯片,而没有足够快、足够大的内存和存储来喂饱它,芯片就只能无效空转。

这就导致了需求的范式转移:

过去: 模型训练是“间歇性高峰”。如同节假日的高速公路,车流高峰后就会平缓。

现在与未来: AI推理与应用是“7x24小时的不息洪流”。模型训练好后,要投入实际使用,为数百万、上千万用户提供服务。这意味着数据中心需要持续地、高负荷地进行数据吞吐,对内存和存储的需求从“脉冲式”变成了“常态化”。

2. NAND闪存:即将被“篡位”的王者

闪迪CEO的预测——“2026年数据中心对NAND闪存的需求将首次超越移动设备”——是一个划时代的信号。

过去的格局: 过去十年,全球NAND闪存产能的最大驱动力是智能手机。每部手机容量的提升,都在吞噬着巨大的产能。

未来的格局: AI服务器对高速SSD的需求,正在创造一个新的、比手机更大的“吞金兽”。为什么?

·模型本体存储: 一个大型AI模型的参数文件(如GPT-4)本身就可能达到数百GB甚至更大,必须存储在超高速的SSD中,才能在推理时被快速调入内存。

·“工作记忆”空间: AI处理用户请求时会产生大量的中间数据,这些“工作记忆”也需要高速存储作为临时缓存。

·数据洪流缓冲: 持续流入数据中心的实时数据,需要被高速暂存,等待处理。

SK海力士2026年产能售罄的消息,正是这一趋势最极致的体现:巨头们已经不满足于在现货市场抢货,而是直接“包矿”,通过长期协议锁定未来数年的产能。这进一步挤压了中小企业和消费市场的供应空间。

3. “十年周期”的底层逻辑:一场与时间的赛跑

专家之所以判断这场风暴可能持续十年,是因为解决它需要跨越三个巨大的时间鸿沟:

技术研发鸿沟(约3-5年): 无论是更先进的HBM4,还是下一代存储技术(如更高速率的NAND或潜在革命性的SCM存储级内存),从实验室研发到量产,需要漫长的技术攻关和良率爬坡。

产能建设鸿沟(约2-4年): 建造一座先进的半导体晶圆厂(Fab)是一项极其复杂的巨型工程。从决策、选址、建厂、设备安装调试到最终量产,本身就是以“年”为单位的漫长过程。

需求增长鸿沟(未知): 就在产业努力爬升产能的同时,AI的应用场景和模型规模仍在以我们无法预测的速度膨胀。需求增长的速度,很可能持续快于供给扩张的速度。 这就如同在一个向上运行的 escalator 上往上跑,虽然你在努力前进,但脚下的台阶也在不断移动。

这三重鸿沟叠加,共同构成了“十年风暴”的悲观预期。这并非危言耸听,而是基于半导体产业发展规律的一次理性推演。

三、你的手机和显卡,为何成了AI风暴的“买单者”?

当AI数据中心在全球范围内疯狂“扫货”时,这场供应链的地震已经开始传导至我们每一个普通人的数字生活。这并非危言耸听,而是一场正在发生的、由AI需求引发的“消费电子价格危机”。

1. 手机涨价:一场关于LPDDR的“生存争夺战”

你可能不知道,你的智能手机和顶尖的AI服务器,正在抢购同一类核心部件:低功耗内存(LPDDR)。

技术的“跨界”流动: LPDDR内存在过去是智能手机的专属,因为它功耗极低,能有效延长手机续航。然而,最新的行业动态显示,为了降低庞大的能耗,像英伟达、英特尔这样的巨头,已经开始在其AI服务器和AI推理GPU中采用LPDDR5X内存,以替代部分传统内存。这意味着,原本为手机准备的产能,现在被需求量极大的AI产业硬生生分走了一杯羹。

供需失衡的必然结果: 报告指出,由于NVIDIA等公司转向LPDDR用于服务器内存,市场出现了相当于一家主要智能手机制造商级别的额外需求,现有的供应链难以轻松吸收这种变化。当服务器市场这个“巨无霸”客户闯入,手机厂商能获得的内存芯片自然变少,价格随之水涨船高。小米等厂商的涨价预警,正是这场“争夺战”最直接的体现。

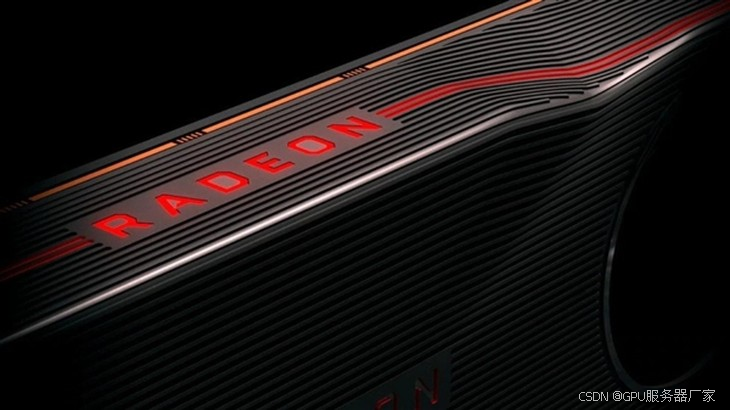

2. 显卡危机:HBM与GDDR6的“产能虹吸效应”

显卡价格的困境,比我们想象的要复杂。它不仅仅是“矿潮”的余波,更深层次的原因是高端AI芯片对先进内存产能的“虹吸”。

HBM的“贵族”血统: AI芯片(如GPU)需要搭配一种叫做HBM(高带宽内存)的顶级内存,它通过堆叠和高速互联,能提供远超普通内存的数据吞吐量。然而,HBM的生产工艺极其复杂,成本高昂,全球产能极为有限。

产能的优先分配: 存储巨头如三星、SK海力士正将产能优先分配给利润更丰厚的HBM和服务器DDR5内存。这就产生了连锁反应:一方面,用于显卡的GDDR6显存(本质也是DRAM的一种)产能受到挤压;另一方面,AMD等公司因显存成本持续上涨,已计划执行第二次显卡涨价。这直接导致了我们购买显卡的价格居高不下。

新品发布的延期: 成本的波动和核心部件(包括显存)的供应不确定性,甚至影响到了英伟达下一代显卡(如RTX 50 SUPER系列和RTX 60系列)的发布节奏。因为这需要芯片厂商与内存供应商进行长期的产能规划和价格谈判。

3. 存储生态的连锁反应:从SSD到“万物涨价”

这场风暴席卷了整个存储生态系统:

SSD(固态硬盘)的“身份转变”: 闪迪CEO预测,到2026年,数据中心对NAND闪存的需求将首次超越移动设备领域。你的电脑SSD和AI数据中心的“数据仓库”,正在抢购同一种NAND闪存芯片。当最大的买家从手机厂商变成亚马逊、谷歌、微软这些云巨头时,整个市场的游戏规则就变了。

“长期协议”锁死供应: 面对不确定性,巨头们不再满足于在现货市场采购,而是直接与上游厂商签订长期供应协议,提前锁定未来数年的NAND产能。这进一步减少了流向公开市场的货源,使得中小厂商和消费级市场面临“无米下锅”的窘境。

写在最后:风暴之中,谁能开辟新航线?

我们清晰地看到,这场席卷全球的内存风暴,并非一次简单的周期性缺货,而是一场深刻的产业结构性变革。AI作为一种前所未有的“资源吞噬者”,正在重塑全球半导体供应链的优先级和游戏规则。

这场危机,暴露了传统架构的“天花板”

当前以DRAM和NAND为核心的存储体系,是在“移动互联网+云计算”时代被设计和优化的。当面对AI这种要求“海量数据瞬时处理”的极端场景时,传统架构在带宽、容量、功耗和成本之间陷入了难以调和的矛盾。

堆砌硬件已是“杯水车薪”: 单纯地扩大现有HBM和SSD的产能,不仅投资巨大、周期漫长,而且在物理和经济学上都即将触及瓶颈。

“存算分离”范式遭遇挑战: 传统数据中心将计算和存储分离的架构,在AI的实时推理需求面前,正因数据搬运的延迟而显得效率低下

危机,永远是创新最强劲的催化剂

正如每一次能源危机都催生了更高效的动力技术,这次“内存饥渴”也正在倒逼整个产业寻求突破。未来的解决方案,很可能不再局限于“生产更多内存”,而是转向一场更为深刻的架构革命:

1、近存计算与存内计算: 这是解决“内存墙”问题的根本性思路。与其在处理器和内存之间来回搬运数据,不如让计算在数据存储的地方发生。这就像是把“厨师”派到“粮仓”里直接做饭,彻底消除了数据搬运的瓶颈。虽然技术尚处早期,但已是全球大厂和初创公司竞相押注的焦点。

2、CXL技术引领的“内存池化”: CXL是一种新兴的高速互联协议,它允许服务器将不同机箱的内存、SSD等资源“池化”,形成一个统一的、可灵活调配的巨大资源池。这相当于将每个服务器孤立的“小水库”打通,连成一片“可调度的湖泊”,极大提升了内存资源的利用效率。

3、异构集成与先进封装: 通过3D堆叠等先进封装技术,将计算芯片与不同制程、不同功能的内存芯片像“搭乐高”一样紧密地集成在一起,在物理层面缩短数据传输路径,从而实现更高的带宽和更低的功耗。

我们的数字生活,将因此改变

对于普通用户而言,这场变革的最终体现将是:

短期阵痛: 为更昂贵的电子设备买单。

长期收益: 我们将享受到由新架构驱动的、更强大、更实时、更个性化的AI服务。下一次AI的体验飞跃,或许不再源于芯片主频的微小提升,而是来自于一次成功的“内存墙”突围。

这场风暴,吹响的不是终场哨,而是下一次技术革命的开场号角。我们见证的,不仅是短缺的危机,更是突破的前夜。

986

986

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?