文章目录

官网参考文档

Tobii的默认注视点滤波器是I-VT,官方给出了参考文档《The Tobii I-VT Fixation Filter》。今天学习了一下,这里做个笔记。

主要看第三小节“The Tobii Studio implementation of the Tobii I-VT filter”的内容,简单概述I-VT滤波器的基本操作流程:内插fixations=>眼动位置确定=>降噪处理=>速度计算=>分类=>临近注视区合并。

整个流程的关键参数就在下面这张图中,下面分别介绍具体操作流程:

Gap fill-in interpolation

主要目的是将一些missing的fixations通过内插的方式填补上,关键的参数‘Max gap length’。为避免将一些由于被试眨眼,转头和遮挡等非采取误差导致数据填补,系统默认设置Max gap length小于正常眨眼的时间,一般为75mm。(通常2~6秒就要眨眼一次,每次眨眼要用0.2~0.4秒钟时间)

对于数据的填补就是简单线性内插即可。

Eye selection

相对很好理解,由于采集的两只眼的眼动信息,需要选取以哪只眼的fixations位置为准。可选择的有左右眼,以及平均。我们选择avarage就好,即两只眼都采集到数据时去两者位置的平均,只有一只眼时只取一只眼的数据。

Noise reduction

Tobii采用的non-weighted moving-average filter,也是一个很好理解的滤波方式,即连续取某一个时刻前N和后N个样本点,取平均位置。

y [ n ] = 1 2 ∗ N + 1 ∑ k = − N N x [ n − k ] y[n]=\frac{1}{2 * N+1} \sum_{k=-N}^{N} x[n-k] y[n]=2∗N+11k=−N∑Nx[n−k]

显然样本点的个数将直接影响fixations的位置曲线,样本点越多曲线越平滑,对应的眼动速度也越低。这样操作虽然能消除噪音的影响也会对影响数据准确度,所以需要合适选取数据。

采样时间间隔乘以N需要远小于眼跳的时间间隔。

相比均值降噪,中位数降噪能减少对过度区域的过平滑操作。

Velocity calculator

为方便分类阈值的设定,这里眼动速度一般采用视角,桌面式的眼动仪器因为知道被试与刺激物的纵向距离,视角便可以方便计算得到。

视角速度的计算就是两个注视点的距离除以一个时间间隔,其中window length需要进行合理设置,经验选取20ms可以有效降噪且避免打乱数据。

v t 1 t 2 = ∣ s t 1 − s t 2 ∣ ∣ t 1 − t 2 ∣ v_{t_{1} t_{2}}=\frac{\left|s_{t_{1}}-s_{t_{2}}\right|}{\left|t_{1}-t_{2}\right|} vt1t2=∣t1−t2∣∣st1−st2∣

I-VT classifier

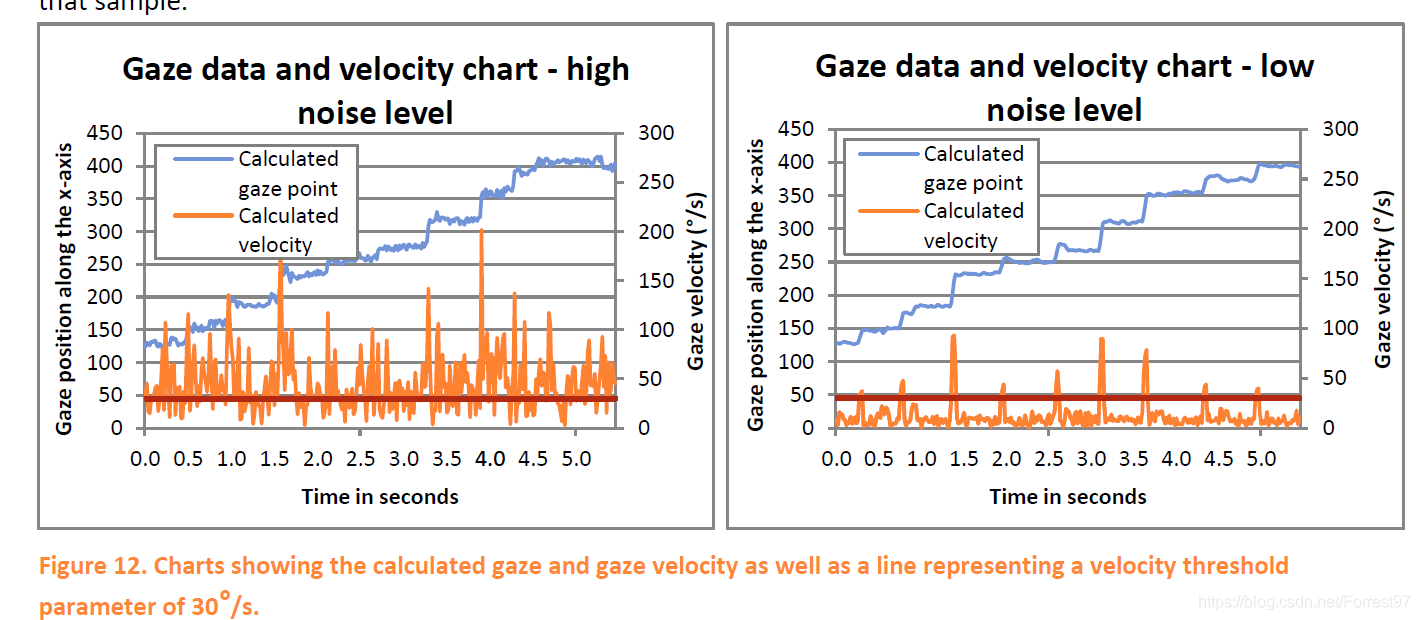

接下来就是根据velocity threshold对注视点进行分类了,默认设置为30°/s。但是根据数据的信噪比,需要合理调整阈值。每秒的眼跳次数为2-5次,眼跳持续时间10-100ms,一次注视的时间约200-500ms,可据此检验阈值设置的可靠性。比如下图左侧,噪声较多,阈值需要设置大一些,右侧噪声少,阈值设当设置小一些。

Merge adjacent fixations

对于临近的注视点处理,主要基于三个参数:

max time between fixations: 75ms(大约75超过眼跳,应该时眨眼等行为)

max angle between fixations: 0.5°(小于这个数值,合并)

merge adjacent fixations: 60ms (小于一次注视的时长合并)

意思都很好理解了,提出的机理是根据文献中人的行为特点决定的,比如最后一个参数注视时长是人视觉观察物体,并提取关键信息所必须的最短时长。

至此便完成了对眼动数据的滤波处理。

官方文档

https://www.tobiipro.com/learn-and-support/learn/

本文介绍了Tobii I-VT滤波器的基本操作流程,包括缺失数据内插、眼动选择、降噪处理、速度计算、分类以及相邻注视点合并。详细解析了每个步骤的关键参数和作用,如线性内插、非加权移动平均滤波、视角速度计算等。同时,讨论了阈值设置和Python代码实现中遇到的问题及改进策略。

本文介绍了Tobii I-VT滤波器的基本操作流程,包括缺失数据内插、眼动选择、降噪处理、速度计算、分类以及相邻注视点合并。详细解析了每个步骤的关键参数和作用,如线性内插、非加权移动平均滤波、视角速度计算等。同时,讨论了阈值设置和Python代码实现中遇到的问题及改进策略。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5591

5591