前言

在使用huggingface中的模型时很多情况下会因为网络原因无法访问,导致模型的下载失败。为了应对这种问题,最便捷的方式是下载相应的模型后使用本地调用的方式,本文将介绍使用modelscope和hf-mirror镜像网站,下载并调用模型的方式来避免受网络影响模型的下载失败问题。

镜像网站

modelscope

ModelScope 是一个由阿里巴巴达摩院推出的开源模型库和工具集,基本上能够涵盖常用的大语言模型和数据。

镜像地址:https://www.modelscope.cn/models

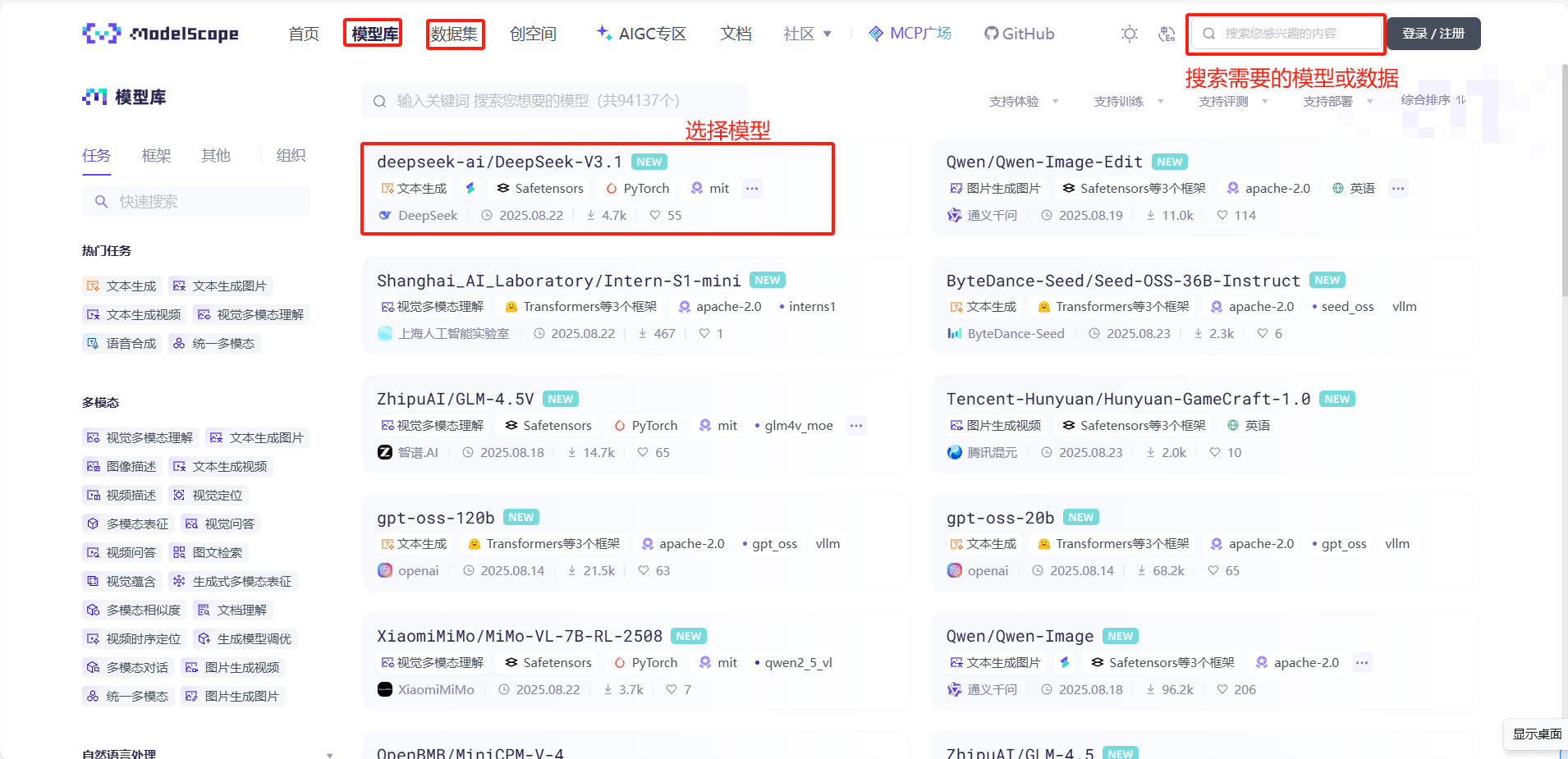

打开主页如下

查找模型

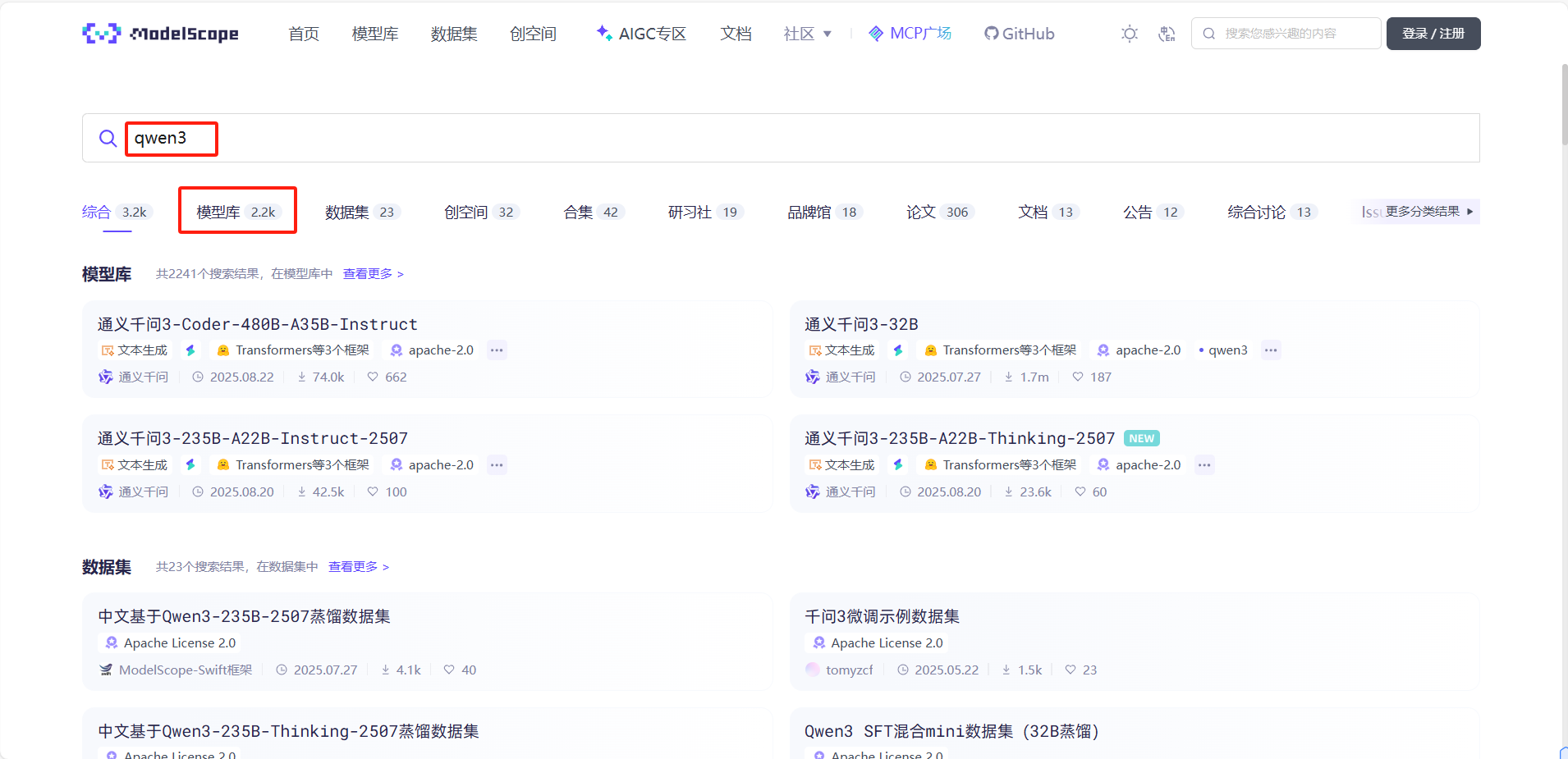

本文中以下载qwen3为例,搜索后选择模型库

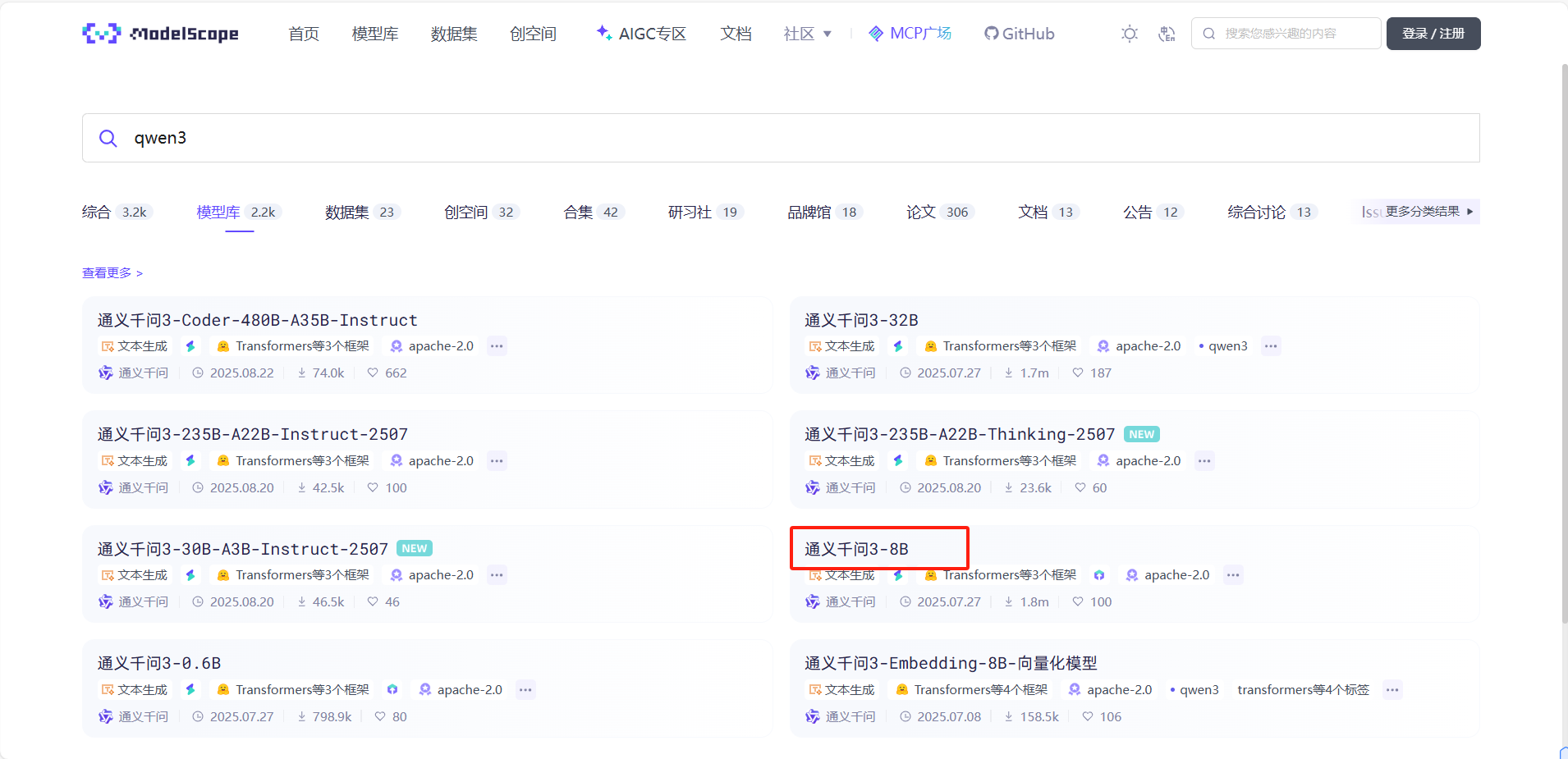

然后找到符合自身硬件条件的模型大小,一般来讲显存要比模型大小大一些,如果要秒出结果,最好显存比模型大两倍。

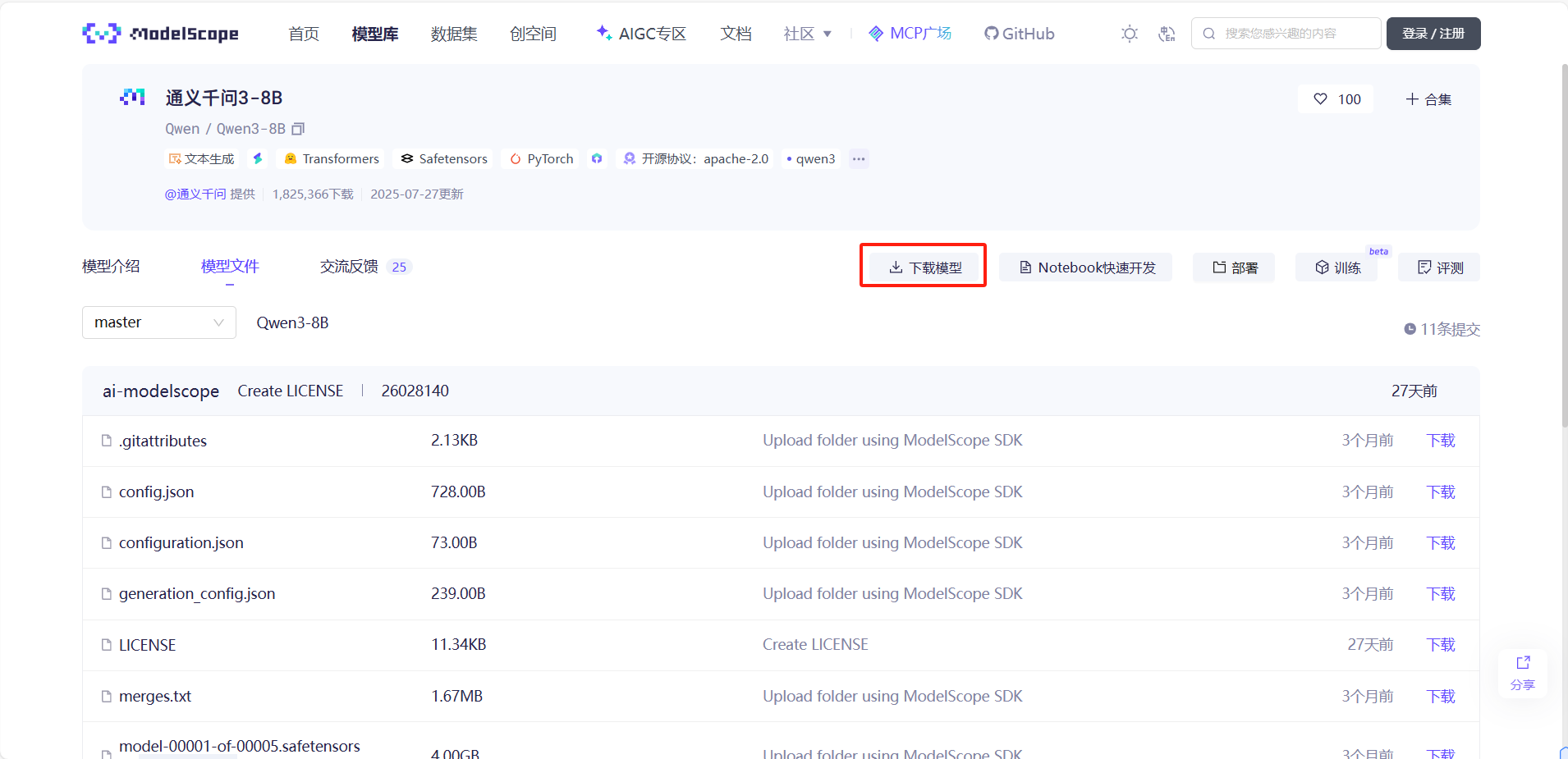

点进去选择模型文件,然后选择下载模型

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1462

1462

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?