🌐 社群导航

🔗点击加入➡️【AIGC/LLM/MLLM/3D/自动驾驶】 技术交流群

最新论文解读系列

论文名:DreamRenderer: Taming Multi-Instance Attribute Control in Large-Scale Text-to-Image Models

论文链接:https://arxiv.org/pdf/2503.12885

开源代码:https://limuloo.github.io/DreamRenderer/

导读

除了传统的文本到图像模型,图像条件生成方法,如深度和Canny条件方法,已成为更可控内容创作的强大工具,在动画、游戏开发、视觉修复和虚拟现实等领域得到应用。

简介

图像条件生成方法,如深度和Canny条件方法,已在精确图像合成方面展现出卓越能力。然而,现有模型仍难以准确控制多个实例(或区域)的内容。即使是像FLUX和3DIS这样的先进模型也面临挑战,例如实例之间的属性泄漏,这限制了用户的控制能力。为解决这些问题,我们引入了DreamRenderer,这是一种基于FLUX模型的无训练方法。DreamRenderer使用户能够通过边界框或掩码控制每个实例的内容,同时确保整体视觉和谐。我们提出了两项关键创新:1)用于硬文本属性绑定的桥接图像令牌,它使用复制的图像令牌作为桥接令牌,以确保仅在文本数据上预训练的T5文本嵌入在联合注意力期间为每个实例绑定正确的视觉属性;2)仅应用于关键层的硬图像属性绑定。通过对FLUX的分析,我们确定了负责实例属性渲染的关键层,并仅在这些层应用硬图像属性绑定,在其他层使用软绑定。这种方法在保证图像质量的同时实现了精确控制。在COCO - POS和COCO - MIG基准测试中,DreamRenderer比FLUX将图像成功率提高了17.7%,并将像GLIGEN和3DIS这样的布局到图像模型的性能提高了多达26.8%。

方法与模型

1. 预备知识

FLUX。FLUX [3] 模型是一种先进的文本到图像生成模型,它利用整流流 [8, 25] 框架迭代生成图像。在每次迭代中,FLUX首先使用T5文本编码器 [35] 将文本提示编码为文本嵌入,该编码器仅在文本数据上进行训练。然后,将此文本嵌入与随机采样的基于噪声的图像嵌入进行拼接;如果需要,还会包含控制图像嵌入(如深度或边缘检测)。随后,多层联合注意力 迭代优化图像和文本嵌入,确保它们保持对齐。最后,FLUX通过变分自编码器(Variational Autoencoder,VAE) [14] 对优化后的图像嵌入进行解码,生成忠实反映用户文本描述的输出图像。

联合注意力。在联合注意力机制中,文本和图像嵌入会同时进行处理。每个嵌入首先通过线性层转换为令牌表示:文本嵌入转换为 和 ,而图像嵌入映射到 、 和 。然后,这些令牌集按如下方式拼接: 和 ,其中 表示拼接操作。随后,注意力机制会应用于拼接后的令牌。

其中 是键向量的维度。这种联合注意力机制允许文本和图像嵌入之间进行双向信息流,使模型能够将视觉内容与文本描述对齐。

2. 问题定义与挑战

问题定义。给定一个深度/边缘检测图、一个全局提示和详细的实例(或区域)描述,目标是生成一幅图像,该图像不仅要符合深度/边缘检测图和全局提示的全局结构约束,还要确保每个受控实例准确符合指定的描述。

挑战。我们基于FLUX模型构建了DreamRenderer,要实现我们的目标主要有两个挑战:1)在多实例场景中正确绑定文本嵌入属性。与之前使用CLIP [34]的文本到图像模型不同,FLUX采用了T5文本编码器,该编码器在纯文本数据上进行预训练,不包含视觉信息。这就带来了一个挑战,即在联合注意力过程中,要确保文本嵌入正确绑定每个实例的视觉属性,尤其是在涉及多个实例时。2)在为每个实例保持正确属性的同时,增强生成图像的整体协调性。在多实例场景中,对应不同实例的图像标记在联合注意力过程中可能会无意中泄露属性[32]。我们的目标是尽量减少这种泄露,同时确保最终生成的图像在所有实例上保持连贯和谐的构图。

3. 概述

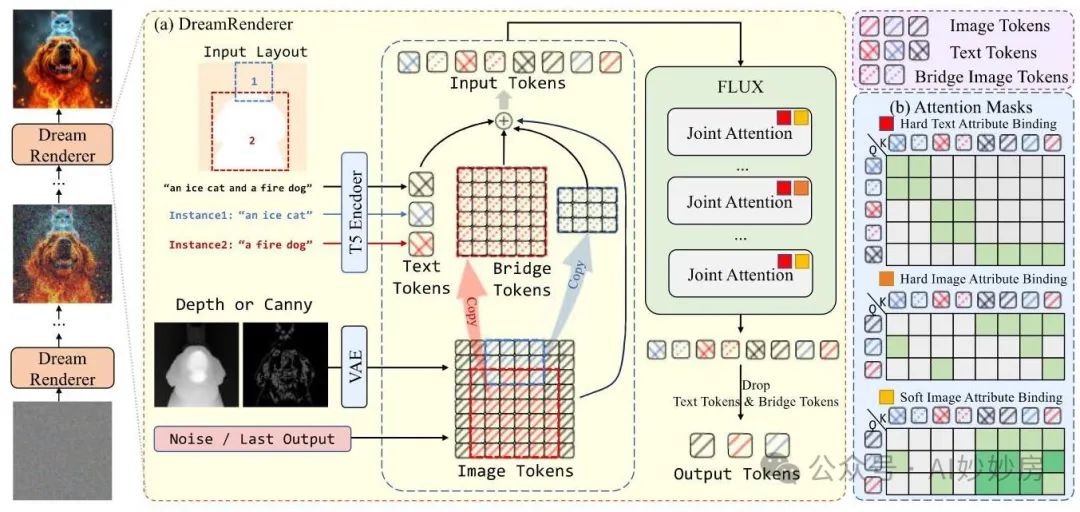

图2. DreamRenderer概述。(§ 3.3)(a)DreamRenderer的流程。(b)联合注意力机制中的注意力图,其中包括1)硬文本属性绑定(§ 3.5),2)硬图像属性绑定(§ 3.6),以及3)软图像属性绑定(§ 3.6)。在(b)中所示的注意力图中,行表示查询,列表示键。我们使用不同的图案来区分图像标记2020、文本标记300和桥接图像标记2020,而不同的颜色(2020表示冰猫,表示火狗,全局文本标记和背景图像标记)表示来自不同实例的标记。

图2展示了DreamRenderer的概述。在联合注意力机制中,DreamRenderer引入了一种新颖的硬文本属性绑定算法,以确保每个实例的文本嵌入正确绑定相关的视觉信息。此外,为了在为每个实例保持准确的图像嵌入属性的同时增强生成图像的整体协调性,我们对FLUX中的每一层进行了实验分析,并决定仅在FLUX模型的中间层应用硬图像属性绑定。在所有其他层中,使用软图像属性绑定。

4. 准备工作

如图2(a)所示,DreamRenderer首先通过T5文本编码器分别对每个实例的输入文本描述和全局提示进行嵌入。然后将这些编码嵌入连接起来,形成用于生成过程的完整文本嵌入。我们的方法要求用户提供深度图或Canny边缘图作为结构引导,这将作为生成图像中实例空间排列的基础。对于实例定位,我们利用用户提供的边界框或掩码,在这个结构引导中识别每个实例的区域。

5. 硬文本属性绑定

动机。在生成单个实例时,FLUX模型通常会生成与文本提示相符的图像,属性误差极小。在这种情况下,联合注意力中的图像和文本标记仅关注该单个实例的信息,从而使文本嵌入能够绑定准确的视觉属性。基于这一见解,我们提出,在多实例场景中,每个实例的图像和文本标记应主要关注自身,而不是不同实例的标记,这样文本嵌入就能有效地绑定正确的视觉信息。

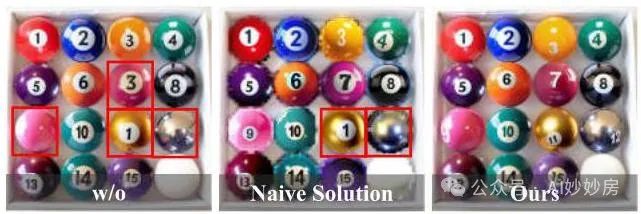

简单解决方案。确保每个实例的文本嵌入绑定到正确属性的一种直接方法是在联合注意力过程中独立处理每个实例。在这种方法中,给定实例的图像和文本标记仅与自身交互,与其他实例的标记保持隔离。然而,这种完全隔离存在一个重大缺点:它破坏了整体图像的视觉协调性,并显著降低了生成结果的质量(如图7所示)。

图7. 硬文本属性绑定消融研究。我们使用图1的相同布局进行测试。由于正文篇幅限制,补充材料中提供了额外的图像结果。

用于高级解决方案的桥接图像标记。由于在联合注意力中严格隔离每个实例的原始图像标记会降低图像质量,DreamRenderer提出了一种高级解决方案:在联合注意力过程中,为每个实例的图像标记创建一个额外的副本,称为桥接图像标记。这些桥接图像标记不会对最终输出图像产生影响,仅用于在联合注意力过程中帮助每个实例的文本嵌入绑定正确的视觉属性。如图2所示,每个实例的桥接图像标记和文本标记的排列方式与单实例生成过程完全相同,确保最终文本嵌入中的视觉属性与文本描述一致。形式上,对于第个实例,硬文本属性绑定注意力掩码定义为:

其中和分别是查询和键的索引,和分别表示第个实例的文本和桥接图像标记的标记索引。

6. 图像属性绑定

概述。在确保文本嵌入属性的准确性之后,下一步是保证每个实例的图像标记中视觉属性的正确性。如图2所示,DreamRenderer在关键绑定层采用硬图像属性绑定(Hard Image Attribute Binding),以确保每个实例都以正确的属性进行渲染。在其余层中,使用软图像属性绑定(Soft Image Attribute Binding)来确保所有实例最终形成一个连贯的图像。在接下来的章节中,我们将详细介绍硬和软图像属性绑定的机制,并解释我们如何确定硬图像属性绑定的关键层。

硬图像属性绑定。如图2所示,硬图像属性绑定在联合注意力(Joint Attention)期间对每个实例的图像标记施加注意力掩码约束。首先,它确保每个实例只关注其对应的文本标记——在经过硬文本属性绑定(Hard Text Attribute Binding)之后,该文本标记包含正确的视觉信息。其次,为了防止不同图像标记之间的属性泄漏,硬图像属性绑定进一步限制每个实例的图像标记只能关注其自身的图像标记。对于第个实例,硬图像属性绑定掩码构造如下:

其中表示属于第个实例的图像标记索引集,表示其对应的文本标记索引。

软图像属性绑定。为了确保最终生成图像的整体连贯性,软图像属性绑定放宽了硬图像属性绑定所施加的约束。具体而言,对于每个实例的图像标记,软图像属性绑定允许其关注整个图像的图像标记,从而增强整个场景的凝聚力。对于第个实例,软图像属性绑定掩码构造如下:

其中表示所有图像标记索引的集合,是与任何实例都不相关的所有图像标记的集合。

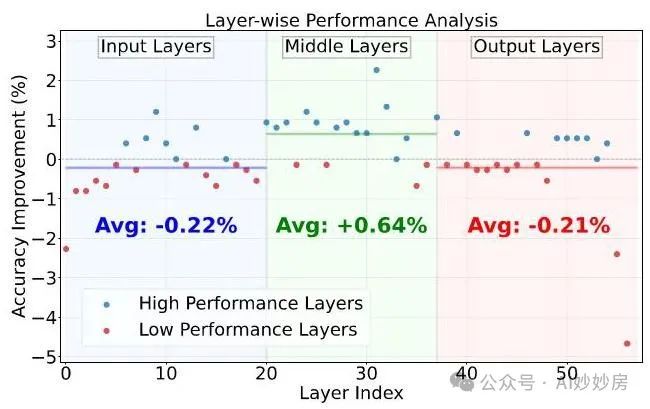

搜索关键绑定层。如图3所示,我们在由57个联合注意力层组成的FLUX网络上逐层应用硬图像属性绑定,并将其结果与在所有层上使用软图像绑定得到的结果进行比较,以确定哪些层更适合绑定特定实例属性。图3的结果表明,在FLUX的输出层和输入层附近应用硬图像绑定会导致性能显著下降。相反,我们观察到在FLUX的中间层实施硬图像属性绑定通常会提高属性保真度。基于这些发现,我们认为FLUX的输入层和输出层主要用于处理全局图像信息,而中间层在渲染图像中实例的属性方面起着关键作用。因此,我们在FLUX的中间层执行硬图像绑定,而在其余层采用软图像绑定。这种方法在实例属性的保真度和图像的整体连贯性之间实现了最佳平衡。

图3. 关键绑定层搜索(§ 3.6)。我们逐层应用硬图像属性绑定,观察到在FLUX模型的输入或输出层应用该绑定会降低性能,而在中间层应用则会提升性能。

实验与结果

1. 实验设置

基线方法。除了FLUX模型外,我们还将我们的方法与几种用于多实例生成的先进方法进行了比较。由于DreamRenderer被设计为一种即插即用的解决方案,我们通过将其与现有方法集成来进行实验,这些方法包括:GLIGEN [18]、InstanceDiffusion [42]、MIGC [59]和3DIS [62]。

实现细节。我们分别使用FLUX.1 - Canny [3]和FLUX.1 - Depth [3]进行Canny条件和深度条件生成。在这两种情况下,我们都在20步内采样图像。在深度条件生成期间,我们将无分类器引导(Classifier - Free Guidance,CFG)[13]系数设置为10.0,而在Canny条件生成中,CFG系数设置为30。在我们的实验中,对于那些位置由边界框指定的实例,我们进一步使用SAM - 2 [15, 36]模型对它们进行分割,以获得更精确的实例掩码,这与之前的工作[61]一致。

评估基准。我们在两个广泛使用的基准上进行实验:1) COCO - POS基准,该基准要求根据指定的布局生成图像。我们从COCO数据集中的图像中提取深度图或Canny边缘作为条件信号,并利用数据集固有的布局进行渲染。模型必须在指定位置生成与实例类别匹配的结果。在这里,我们将我们的方法与无需训练的渲染方法(包括Multi - Diffusion和3DIS)进行比较。2) COCO - MIG基准,该基准测试具有精确位置和属性控制的多实例生成。我们通过以下方式评估DreamRenderer与先进的多实例生成(Multi - Instance Generation,MIG)模型的集成能力:首先使用这些模型生成RGB图像,然后提取深度图与布局相结合进行实例渲染。这评估了DreamRenderer应用于现有MIG框架时的属性控制有效性。

评估指标。我们使用以下指标来评估模型:1) 平均交并比(Mean Intersection over Union,MIoU):衡量渲染实例位置与目标位置之间的重叠比率。2) 局部CLIP分数:评估渲染实例与其相应文本描述的视觉一致性。3) 平均精度(Average Precision,AP):评估渲染图像布局的准确性。4) 实例成功率(Instance Success Ratio,ISR):计算正确渲染实例的比率。5) 图像成功率(Image Success Ratio,ISR):衡量所有实例都正确渲染的图像的比率。

2. 与最先进方法的比较

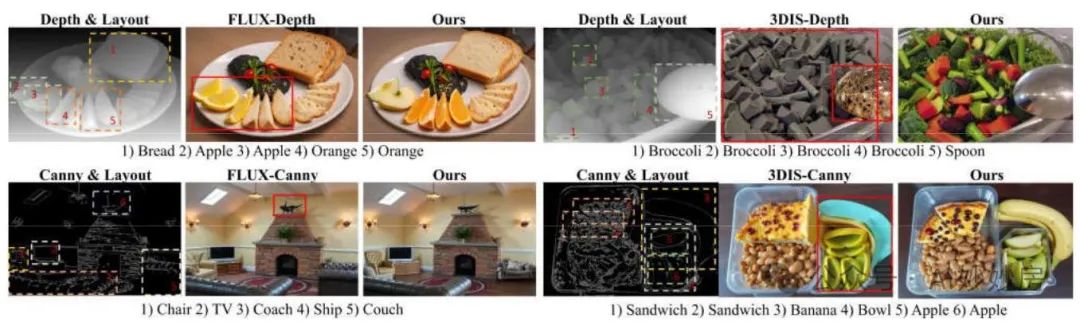

COCO - POS基准测试。表1展示了将我们的方法与FLUX和3DIS进行比较的定量结果。在深度引导和Canny边缘检测引导的生成场景中,我们的方法在所有指标上都始终表现更优。在深度引导设置下,DreamRenderer在成功率(SR)方面有显著提升(62.50%,而3DIS为53.88%),这表明场景结构更加连贯。较高的实例成功率(ISR,94.51%)和平均交并比(MIoU,84.36%)进一步证实了其在实例级别上的精确控制能力。在要求更高的Canny边缘检测引导场景中,DreamRenderer在成功率方面也比3DIS高出。同时,如图4所示,由于仅在关键层应用了硬图像属性绑定,我们的方法并未降低原始FLUX模型的图像生成质量。

表1. 在COCO - POS基准上的定量结果。SR:整个图像的成功率,ISR:实例成功率,MIoU:平均交并比,AP:平均精度。*:Canny引导。†:深度引导。

图4. 在COCO - POS基准上的定性比较。

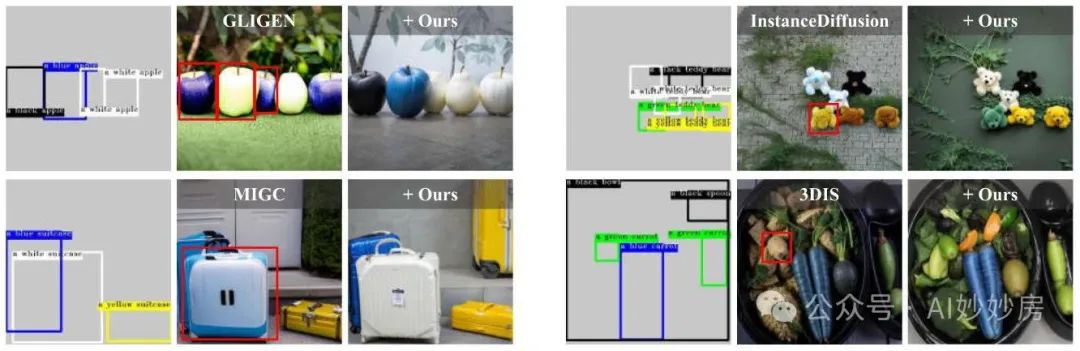

COCO - MIG基准测试。表2和图5展示了将DreamRenderer应用于各种最先进的布局到图像生成方法的结果。如图所示,DreamRenderer显著提高了实例属性控制的准确性,最终使图像成功率相较于GLIGEN提高了26.8%,相较于InstanceDiffusion提高了19.9%,相较于MIGC提高了8.3%,相较于3DIS提高了7.4%。值得注意的是,随着需要控制的实例数量增加,这种改进变得更加明显:例如,在控制两个实例时,DreamRenderer相较于3DIS的性能提升仅为2.5%,但在控制六个实例时,这一提升幅度上升到了10.5%。这些优势源于我们的硬文本属性绑定算法,该算法确保在联合注意力机制中,即使对于大量实例,每个实例的文本嵌入也能准确绑定其视觉属性。

表2. COCO - MIG基准上的定量结果。表示需要生成的实例数量为i。

图5. 在COCO - MIG基准测试上的定性比较。

表3. 31名参与者的用户研究结果(1 - 5分制)。

用户研究。表3展示了一项有31名参与者的用户研究,该研究在感知质量方面将我们的方法与FLUX [3]和3DIS [62]进行了比较。参与者查看成对的输出结果,并使用5分制对每对结果在(1)布局准确性和(2)图像质量方面进行评分,这是在随机展示的盲测比较中进行的。每位参与者评估了17对结果,并能看到输入的布局和文本描述。结果表明,我们提出的DreamRenderer不仅提升了FLUX模型的布局控制能力,还生成了对用户更具视觉吸引力的输出。

总结

我们提出了DreamRenderer,这是一种即插即用的方法,能够实现深度和边缘条件生成,以控制特定区域和实例的内容,同时不影响原始模型的图像质量。我们的工作有两个关键贡献。首先,我们引入了一种新颖的硬文本属性绑定机制,该机制采用桥接图像标记,确保在联合注意力过程中每个实例的文本嵌入绑定正确的视觉信息。其次,通过对FLUX各层的实验分析,我们仅在关键层应用硬图像属性绑定,在保持全局图像连贯性的同时实现精确的实例级控制。在COCO - POS和COCO - MIG基准测试上的大量实验证明了DreamRenderer的卓越性能。在深度引导设置下,我们的方法实现了的实例成功率(ISR)和84.36%的平均交并比(MIoU),显著优于现有方法。即使在更具挑战性的边缘引导设置下,DreamRenderer仍然表现稳健,实现了74.61%的实例成功率和66.95%的平均交并比。此外,DreamRenderer可以作为重渲染器,显著提高布局到图像方法的准确性。其无需训练的特性使DreamRenderer能够轻松应用于各种基础模型,具有很高的灵活性。未来,我们将进一步探索DreamRenderer与其他图像条件生成方法的集成。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?