在使用大型语言模型时,我们经常会遇到一些现实问题:

模型文件太大、加载太慢、部署麻烦、兼容性差……

尤其是当你尝试在本地电脑甚至手机上运行一个几百亿参数的模型时,这些问题就会变得尤为明显。

于是,GGUF(GGML Universal File) 诞生了。

它是由 ggml 项目演化而来的一种全新模型文件格式,专门为大语言模型的高效部署而设计。

简单来说,GGUF 就像是为 LLM 打造的 “高性能压缩包”,既能节省空间,又能提升加载速度,还能在不同平台间无缝使用。

一、GGUF 是什么?

GGUF 是一种 通用二进制文件格式,用于存储大语言模型的参数(如权重和偏置)、元信息、配置以及 Tokenizer 等内容。

它的目标是让开发者只用一个文件就能完成模型的加载、推理和部署,无需额外配置。

换句话说,如果以前的 LLM 模型是一堆分散的文件(权重文件、配置文件、词表文件等),

那么 GGUF 就把它们都“打包进了一个文件里”,方便拷贝、分发、加载。

二、GGUF 的内部架构

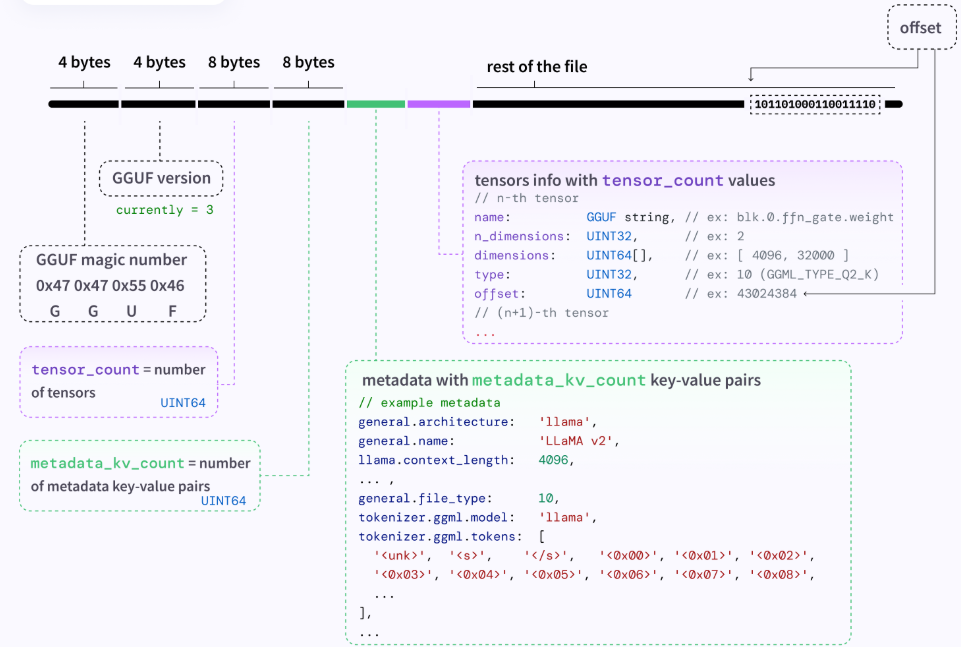

一个 GGUF 文件本质上是一个二进制文件(binary file),内部按照固定顺序存储了模型的元信息(metadata)、张量信息(tensor info)以及实际的权重数据(tensor data)。

整个文件可以大致分为三部分:

- 文件头(Header)

- 元数据区(Metadata Section)

- 张量信息与权重区(Tensor Section)

1)文件头部分(Header)

位于文件开头,占据固定字节长度。它的作用类似于“文件身份证”,用于告诉加载程序:

“我是谁、版本是多少、里面有多少张量和元信息。”

| 字段 | 说明 | 类型 | 示例 |

|---|---|---|---|

| GGUF magic number | 文件标识符,用于验证文件是否为 GGUF 格式。值为 0x47 0x47 0x55 0x46(即 ASCII 的 “GGUF”) | 4 bytes | G G U F |

| GGUF version | 当前文件版本号。最新版通常是 3 | 4 bytes | 3 |

| tensor_count | 文件中包含的张量数量 | 8bytes (UINT64) | 例如:500 |

| metadata_kv_count | 文件中包含的元数据(键值对)数量 | 8bytes (UINT64) | 例如:30 |

这部分信息帮助程序快速定位后续数据的布局。

2)元数据区(Metadata Section)

在头部之后,是一系列键值对(key-value pairs),描述模型的通用属性、词表、架构信息等。

在图中,用绿色方框标出。

这些键值对的数量由上面的 metadata_kv_count 决定。

每一个键(key)都是字符串,每个值(value)可以是字符串、整数或数组。

常见的元数据示例:

general.architecture: 'llama'

general.name: 'LLaMA v2'

llama.context_length: 4096

general.file_type: 10

tokenizer.ggml.model: 'llama'

tokenizer.ggml.tokens: ['<unk>', '<s>', '</s>', ...]

这些信息告诉程序:

- 模型是什么架构(LLaMA、Mistral、Phi等)

- 上下文长度是多少(4096 tokens)

- 文件的量化类型(

file_type = 10表示 Q4、Q5 等) - 词表定义是什么(

tokenizer.ggml.tokens)

🔹理解要点:

元数据部分就像模型的“说明书”,提供了解释文件中权重该如何使用的上下文。

3)张量信息区(Tensor Info Section)

紧接在元数据后面,用紫色方框标出。

这里存储了每个张量(权重矩阵)的基本信息,数量为 tensor_count。

每个张量包含以下字段:

| 字段 | 说明 | 类型 | 示例 |

|---|---|---|---|

| name | 张量名称 | GGUF string | blk.0.ffn_gate.weight |

| n_dimensions | 张量维度数 | UINT32 | 2 |

| dimensions | 各维度大小 | UINT64[] | [4096, 32000] |

| type | 数据类型 / 量化方式 | UINT32 | 10(GGML_TYPE_Q2_K) |

| offset | 该张量在文件中实际数据的偏移位置 | UINT64 | 43024384 |

也就是说,这里列出的是“索引表”,告诉加载程序去文件哪个位置取对应权重。

4)张量数据区(Tensor Data Section)

在文件的最后部分(图中黑色长条 “rest of the file”)存储的是实际的模型权重数据。

每个张量在前面的 offset 字段中标明了自己在文件中的位置。

这些数据通常是量化后的数值矩阵,例如使用 Q4 或 Q5 量化后的权重块。

它们通过 mmap 技术可以直接映射到内存中进行计算,而不需要全部加载到内存中。

三、GGUF 的核心特点

🧩 1. 高效存储

GGUF 对模型参数的存储方式进行了深度优化。

它使用紧凑的二进制编码与高效的数据结构,极大地减少了文件体积。

这对于拥有数十亿甚至上千亿参数的模型来说,意味着节省数十 GB 的空间。

此外,它还支持多种量化格式(如 Q4、Q5、Q8),允许在牺牲极少精度的前提下大幅压缩模型大小,让普通设备也能轻松加载。

🚀 2. 快速加载(mmap 支持)

GGUF 格式支持 内存映射(memory mapping, mmap),这是一种操作系统层面的快速加载技术。

通过 mmap,模型文件可以直接映射到内存中,不必将整个模型读入 RAM 才能使用。

这就像“即用即读”,大大加快了模型的启动速度。

因此,即使是几十 GB 的大模型,也能在几秒钟内加载完成,适合需要即时响应的场景,例如:

- 在线聊天机器人

- 实时语音翻译

- 本地 AI 助手等

💡 3. 单文件部署

GGUF 将模型的所有必要信息(包括权重、词表、超参数、元数据等)都封装在一个文件中。

这样一来,部署模型就像复制一个文件那么简单,不需要担心路径错乱或缺少依赖文件。

对开发者而言,部署 GGUF 模型就像拖一个文件到服务器一样轻松。

🌍 4. 跨平台兼容

GGUF 文件具有极强的跨平台兼容性。

无论你使用的是 Python、C++、Rust、Go 甚至 R,都可以通过简单的 API 来加载模型。

同时,它也适用于各种硬件平台——从高性能 GPU 服务器到笔记本电脑,乃至移动设备。

这让 GGUF 成为开源社区和边缘计算领域中最受欢迎的模型格式之一。

🔧 5. 支持微调与扩展

GGUF 不仅仅是静态存储模型,还支持在文件中保存微调信息,例如 LoRA 权重或自定义提示模板。

这意味着用户可以基于同一个基础模型,创建适配自己任务的“个性化版本”,并方便地在不同环境中共享与部署。

🔄 6. 取代 GGML

GGUF 是 GGML 格式的继任者。

GGML 虽然是轻量化模型部署的重要里程碑,但它在扩展性、兼容性和文件结构方面存在限制。

GGUF 的出现,弥补了这些不足,使得模型格式更灵活、更标准化,也更易于长期维护。

四、GGUF 的应用场景

- 🖥 本地部署大模型

在个人电脑甚至树莓派上运行 LLM 已成为可能。GGUF 的高效设计让普通设备也能运行如 LLaMA、Mistral、Phi 等模型。 - 📱 移动端推理

得益于体积小、加载快的特性,GGUF 格式可用于移动设备的本地 AI 助手和离线翻译等应用。 - ⚙️ 快速原型与测试

对开发者来说,使用 GGUF 格式可以极大简化实验流程:

只需加载一个文件,就能快速测试模型性能或不同量化配置的效果。 - ☁️ 云边协同部署

由于其跨平台特性,GGUF 文件可以在云端训练、边缘端推理,适合混合部署场景。

五、总结

GGUF = 更轻、更快、更兼容的大模型文件标准

它不仅继承了 GGML 的高效精神,更在存储结构、扩展能力和跨平台兼容性上实现了全面升级。

随着越来越多的大语言模型(如 LLaMA、Mistral、Phi-3)支持 GGUF 格式,

GGUF 很可能成为未来本地和边缘 AI 推理的事实标准。

无论你是 AI 开发者、科研人员,还是想在自己电脑上跑大模型的爱好者,

了解并使用 GGUF,都是迈向高效 AI 部署的重要一步。

那么,如何系统的去学习大模型LLM?

作为一名深耕行业的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

5693

5693

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?