点击下方卡片,关注“自动驾驶之心”公众号

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Kai Zeng等

编辑 | 自动驾驶之心

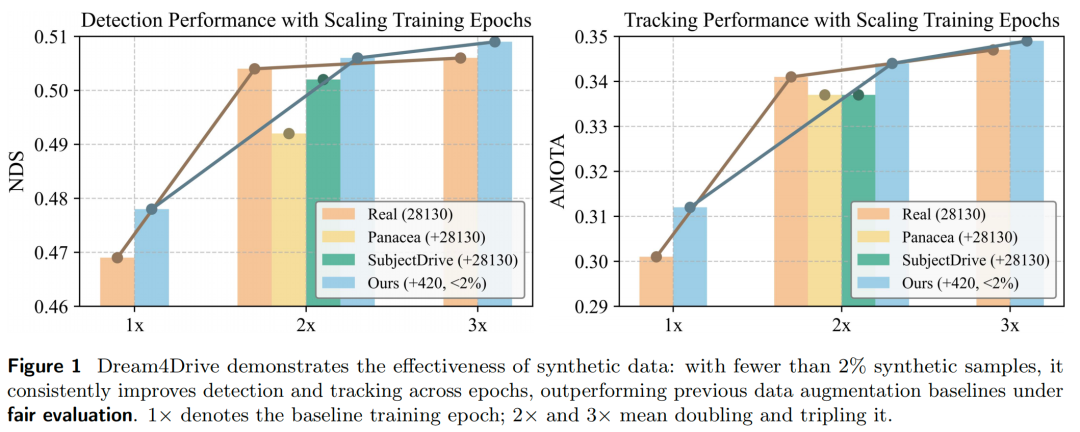

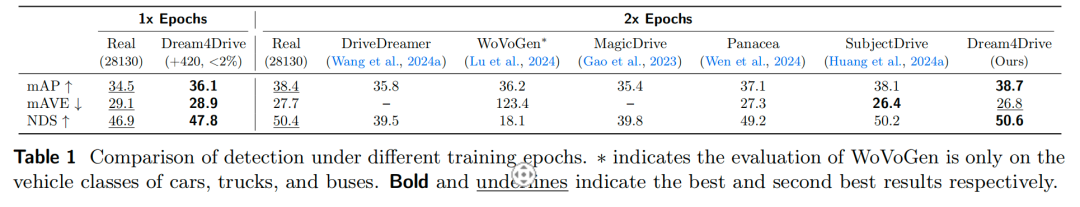

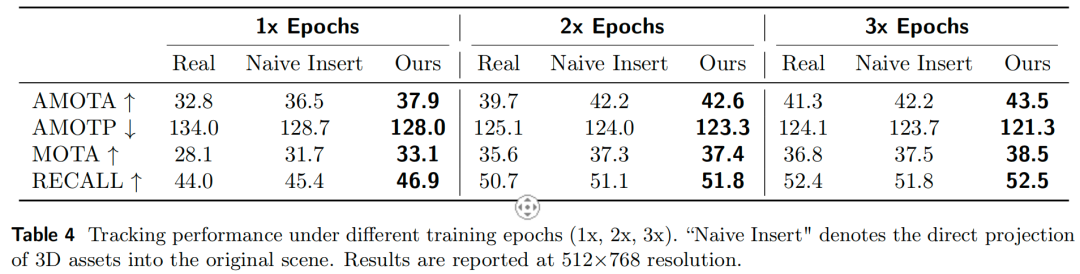

最新的自动驾驶世界模型已经可以实现高质量的可控多模态视频生成。现有方法主要关注与生成质量和可控性相关的指标,却往往忽视了对下游感知任务的评测——而这些任务对自动驾驶性能至关重要。现有方法通常采用“先在合成数据上预训练,再在真实数据上微调”的训练策略,导致训练epoch是基准模型(仅使用真实数据)的两倍。而当我们将基准模型的训练epoch翻倍时,合成数据的优势便会变得微乎其微。

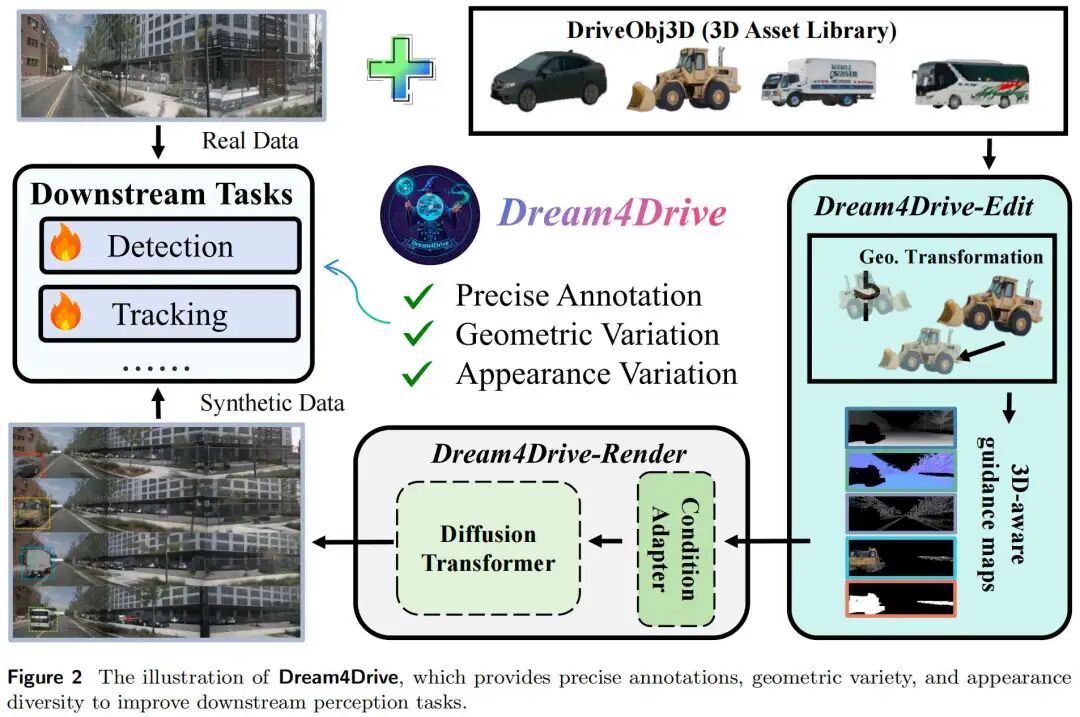

为充分证明合成数据的价值,北京大学、小米汽车和华中科技大学的团队提出了Dream4Drive——一种全新的合成数据生成框架,专为提升下游感知任务性能设计。Dream4Drive首先将输入视频分解为多个3D感知引导图(3D-aware guidance maps),随后将3D资产渲染到这些引导图上;最后,通过微调世界模型,生成经过编辑的多视角真实视频,该视频可用于训练下游感知模型。Dream4Drive能够前所未有地灵活生成大规模多视角极端场景,显著提升自动驾驶中的极端场景感知能力。

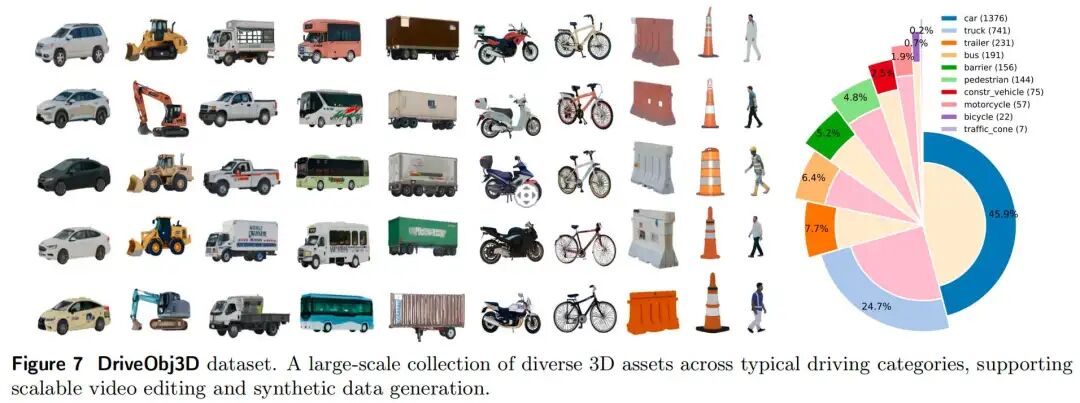

为助力未来研究,Dream4Drive还构建了一个大规模3D资产数据集DriveObj3D,涵盖驾驶场景中的典型类别,可支持多样化的3D感知视频编辑。大量实验表明,在不同训练epoch下,Dream4Drive均能有效提升下游感知模型的性能。

论文名称:Rethinking Driving World Model as Synthetic Data Generator for Perception Tasks

论文链接:https://www.arxiv.org/abs/2510.19195

项目链接:https://wm-research.github.io/Dream4Drive/

一、背景回顾

3D目标检测和跟踪等感知任务是下游决策规划的重要输入模块。然而感知模型的性能高度依赖大规模人工标注训练数据集。为确保在极少数罕见的安全场景中具备可靠性,获取充足的长尾数据十分重要。尽管自动驾驶领域已开发出完善的4D标注流程以简化数据获取,但收集长尾数据仍需耗费大量时间与人力。

基于扩散模型和ControlNet的自动驾驶世界模型已在业内得到应用,可根据场景布局(BEV map、3D目标框和文本生成)合成数据。但这类模型对单个目标的位姿和外观控制能力有限,导致难以生成多样化的合成数据。与之不同,视频编辑方法(而非生成方法)通过参考图像和3D边界框修改目标的外观与位姿,扩展了自动驾驶世界模型的能力,可生成多样化极端场景;但单视角插入的局限性使其无法应用于环视BEV感知任务。

基于神经辐射场(NeRF)或3D高斯splatting(3DGS)的重建类方法,能够实现对几何结构的精确控制;尽管这类方法能保留几何信息,但稀疏的训练视角往往会导致生成结果出现伪影和渲染不完整的问题,且缺乏光照建模会造成插入目标与背景之间的视觉不一致。

更重要的是,我们认为现有方法的合成数据增强实验存在公平性问题:它们通常采用“先合成数据预训练、再真实数据微调”的策略,导致训练epoch是基准模型(仅用真实数据)的两倍。我们发现,在训练轮次相同的情况下,大规模合成数据集不仅难以体现优势,甚至可能比仅使用真实数据的效果更差。如图1所示,在2× epoch设置下,仅用真实数据训练的模型在平均精度均值(mAP)和nuScenes检测得分(NDS)上,均优于结合真实数据与合成数据训练的模型。鉴于下游感知任务对自动驾驶的重要性,我们认为有必要重新审视“自动驾驶世界模型作为感知任务合成数据生成器”的有效性。

为重新评估合成数据的价值,我们提出了Dream4Drive——一种专为下游感知任务设计的3D感知合成数据生成框架。其核心思路如下:首先将输入视频分解为多个3D感知引导图,随后将3D资产渲染到这些引导图上;最后通过微调驾驶世界模型,生成经过编辑的多视角照片级真实感视频,用于训练下游感知模型。通过这一流程,我们可在同一场景中融入具有不同轨迹(如视角、位姿、距离)的多种资产,显著提升合成数据的多样性。

如图1所示,在相同训练轮次(1×、2×或3×)下,我们的方法仅需420个合成样本(不足真实样本的2%),即可超越现有数据增强方法。据我们所知,本文首次通过公平对比证明:合成数据在性能上可超越仅使用真实数据的训练方式,为感知任务带来切实增益。

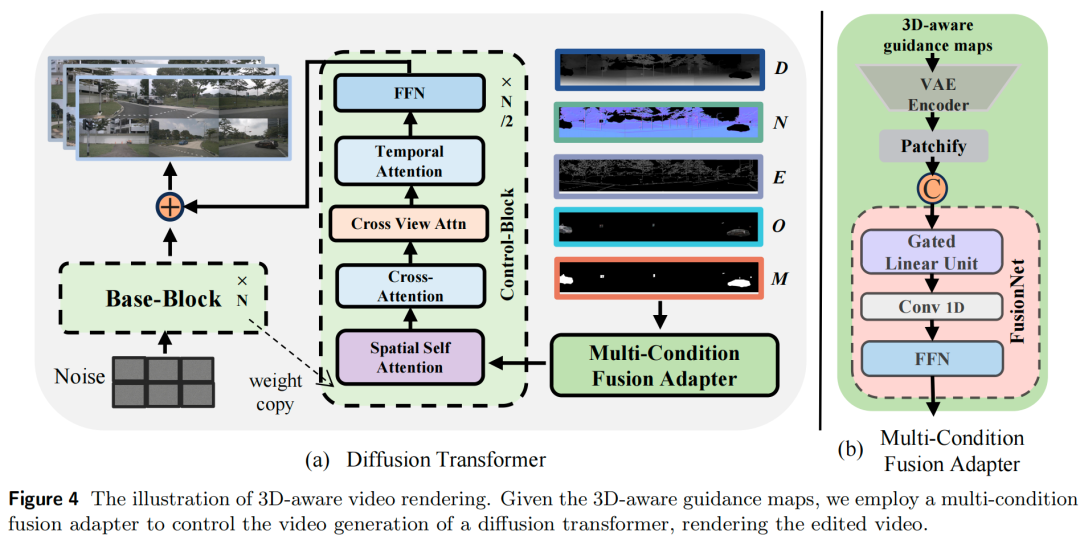

具体而言,Dream4Drive基于Diffusion Transformer微调得到多视角视频修复模型。与依赖稀疏空间控制(如BEV、3D边界框)的现有方法不同,Dream4Drive采用密集型3D感知引导图(如深度图(depth)、法向量图(normal)、边缘图(edge)、裁剪图(cutout)、掩码图(mask)),在保留原始视频几何与外观信息的同时,通过将3D资产渲染到引导图中实现编辑。这种设计支持实例级、跨视角一致的视频编辑,同时保证视觉真实感与几何准确性。生成的视频不仅质量优异,还可直接用于训练最先进的感知模型。

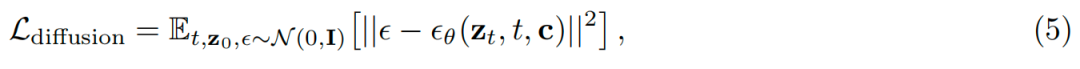

为支持多样化的3D感知视频编辑,Dream4Drive设计了一套流程:基于目标场景图像或特定类别资产的视频,自动获取高质量3D资产。流程步骤如下:

1)采用图像分割模型定位并裁剪指定类别的目标;

2)使用图像生成模型生成目标目标的多视角一致图像;

3)将这些图像输入网格生成模型,生成高质量3D资产。

Dream4Drive构建了大规模3D资产数据集DriveObj3D,涵盖驾驶场景中的典型类别,可为未来研究提供支持。本文的主要贡献如下:

发现现有数据增强方法的评估存在公平性问题:在训练轮次相同时,“真实数据+合成数据”的混合数据集相比仅使用真实数据并无优势;

提出3D-aware合成数据生成框架Dream4Drive,通过密集引导图实现视频编辑,生成兼具外观多样性与几何一致性的合成数据;

构建大规模数据集DriveObj3D,涵盖驾驶场景典型类别,支持3D感知视频编辑。

不同训练轮次下的大量实验表明,仅添加极少量的合成数据,即可显著提升感知性能,充分验证了Dream4Drive的有效性。

二、Dream4Drive算法详解

本文的目标是从带有3D box标注的真实视频和目标3D资产中生成高质量合成视频,用于训练感知模型。

预备知识

潜在扩散模型LDM通过在低维潜在空间中运算,解决了扩散模型计算成本高的问题。对于图像 ,首先使用编码器 得到其对应的潜在表示 。潜在空间中的前向扩散过程定义为一个逐步加噪过程:

其中

,

反向扩散过程由神经网络

其中

最终,解码器

ControlNets通过引入额外的条件信号

这种修改使模型能根据条件信号

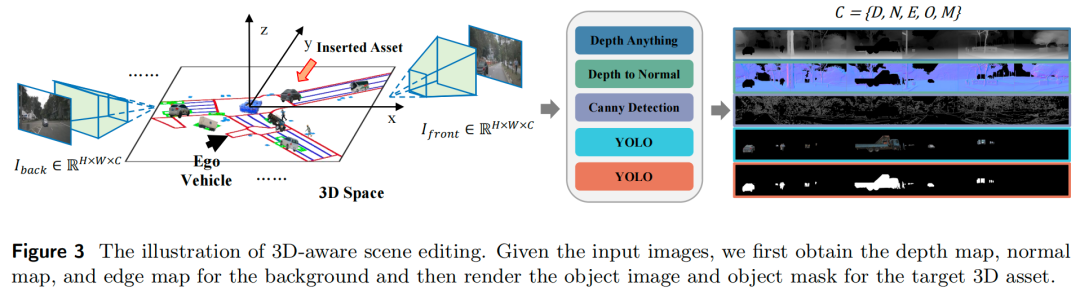

3D-aware场景编辑

对于输入RGB图像

对于DriveObj3D数据集中的目标3D资产,首先根据给定的3D边界框

在获取背景的深度图、法向量图、边缘图以及目标3D资产的渲染目标图像和目标掩码后,我们利用微调后的自动驾驶世界模型,基于这些3D感知引导图渲染编辑后的视频。该3D感知场景编辑流程充分利用了3D资产提供的精确位姿、几何和纹理信息,确保生成结果的几何一致性。值得注意的是,本文方法不依赖3D边界框嵌入来控制目标位置,而是直接在3D空间中进行编辑,这种方式更直观且可靠性更高。

3D-aware视频渲染

现有方法的视频生成过程依赖稀疏空间控制(如BEV地图和投影3D边界框)。尽管这种方式能对合成内容实现一定控制,但在生成高质量视频方面往往存在不足。本文不依赖稀疏空间控制,而是通过微调自动驾驶世界模型,从背景的深度图(

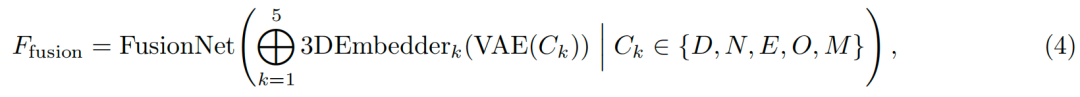

多条件融合适配器的结构如图4所示。首先通过变分自编码器(VAE)对五种条件(深度图、法向量图、边缘图、目标图像、目标掩码)进行编码,然后采用不同的3D嵌入器(3D embedders)对潜在变量进行分块(patchify)处理;随后,融合网络(FusionNet)模块对这五组特征进行融合,融合过程可通过以下公式描述:

其中

本文采用rectified flow实现稳定采样,并采用无分类器引导(classifier-free guidance)平衡文本与多种3D几何条件,从而提升可控性。主要训练目标是简化的扩散损失,用于预测每个时间步的噪声分量:

其中

最终训练目标为:

在实验中,损失权重通过经验设定为

三、DriveObj3D资产

为构建用于多样化3D感知视频编辑的大规模3D资产库,本文设计了一套简洁且高效的流程。该流程的核心思路是将资产生成过程分解为三步:(i)2D实例分割;(ii)多视角图像生成;(iii)3D网格生成。如图5所示,该流程以视频或图像以及目标资产类别作为输入,生成用于下游应用的3D网格。

具体流程如下:首先对目标目标进行定位与分割。给定输入图像

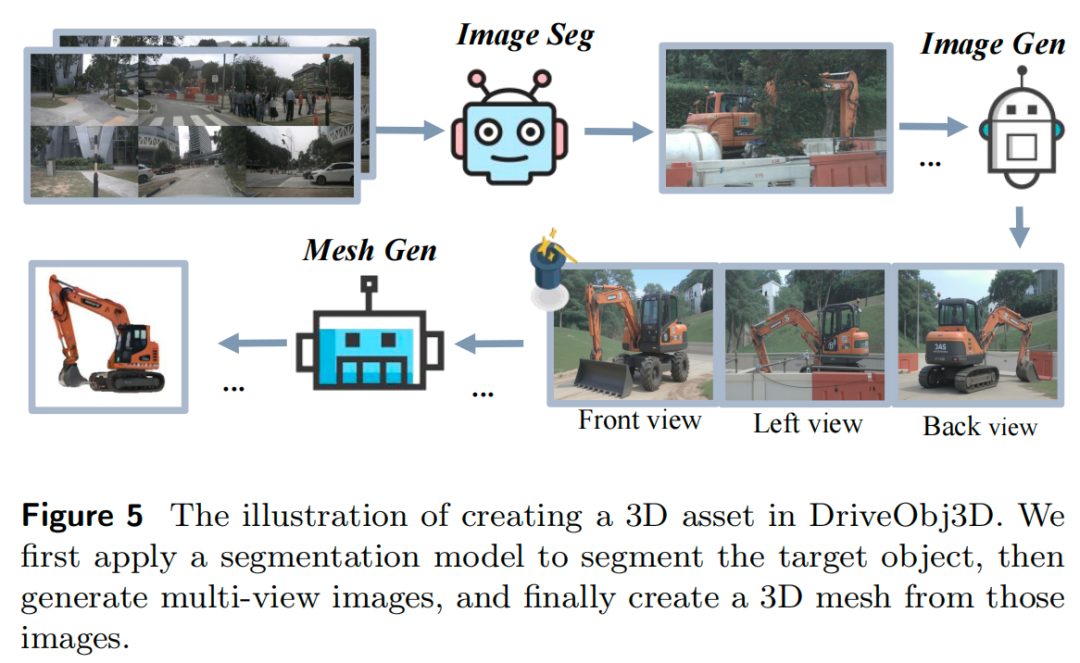

如图6所示,Text-to-3D方法生成的资产往往与原始数据存在风格不一致问题,而单视角方法则容易生成不完整的资产。相比之下,本文提出的简洁流程通过多视角合成生成完整且高保真的资产,即使在严重遮挡情况下也能保持性能。为支持大规模下游驾驶任务,本文构建了多样化的资产数据集DriveObj3D,涵盖驾驶场景中的各类典型类别(如图7所示)。所有资产将公开。

实验结果分析

主要实验结果

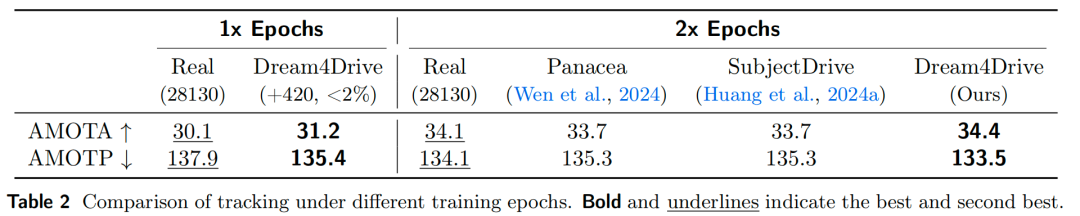

下游任务有效性: 本文将Dream4Drive与现有驾驶世界模型在下游任务上的性能进行对比,检测与跟踪结果分别如表1和表2所示。尽管Panacea与SubjectDrive在“2x训练轮次”设置下性能优于纯真实数据基准,但当统一训练轮次后,其相比纯真实数据的性能增益微乎其微。

相比之下,本文方法通过在指定3D位置对目标进行显式编辑,并利用3D感知引导图指导前景-背景合成,生成标注精确的视频,可持续提升下游感知模型性能。值得注意的是,仅使用420个插入样本(不足真实样本的2%),本文方法的性能便超过了使用完整合成数据集的现有方法;更重要的是,本文首次实现了“训练轮次相同时,合成数据辅助训练的性能超越纯真实数据训练”的突破。

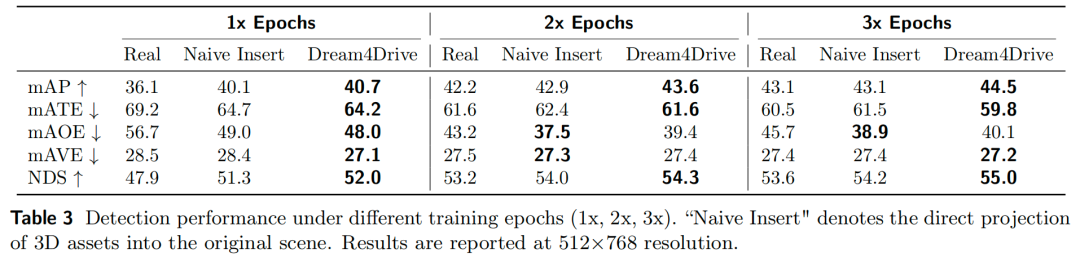

**不同分辨率下的有效性:

随着生成模型的发展,合成高分辨率视频已成为可能。为探究高分辨率合成数据对下游感知模型的影响,本文进一步在512×768分辨率下开展检测与跟踪实验,结果分别如表3和表4所示。

在1倍与2倍轮次设置下,真实数据与Dream4Drive的高分辨率(512×768)实验结果均显著优于低分辨率(256×512,见表1、表2)结果。值得注意的是,通过高分辨率合成数据增强,Dream4Drive仅需420个样本即可实现mAP提升4.6个百分点(12.7%)、NDS提升4.1个百分点(8.6%)。性能增益主要来自大型车辆类别(如公交车、工程车辆、卡车),各类别的详细AP值详见附录B。

与现有数据增强范式不同,无论训练轮次多少,Dream4Drive的性能始终优于纯真实数据训练,这充分证明了高质量合成数据的价值。

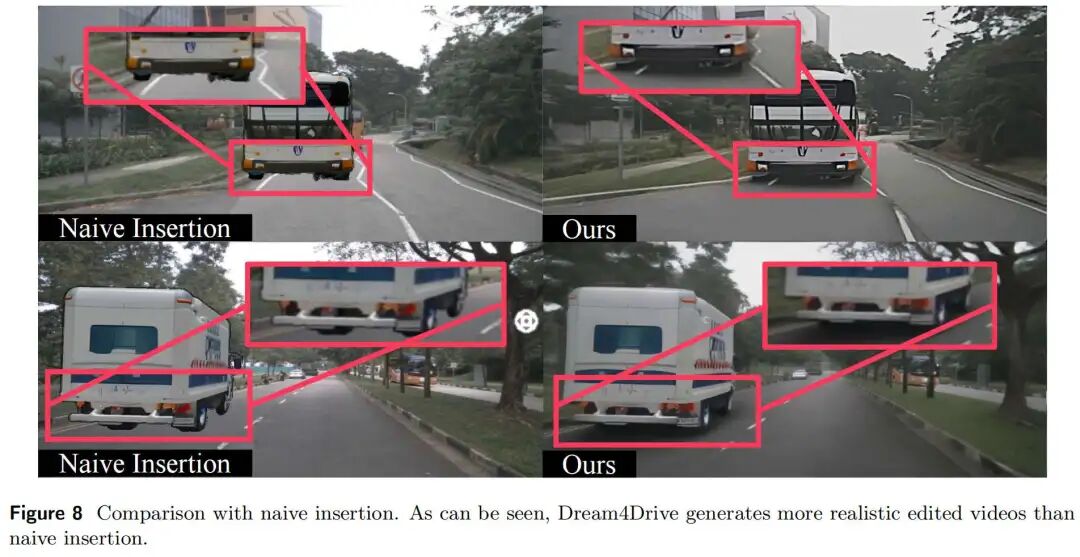

与朴素插入方法的定量与定性对比:

提取3D资产后,可通过直接投影生成编辑视频。为评估“3D感知视频渲染”与“直接插入”对下游任务的影响,本文开展了全面对比实验,结果如表3和表4所示。尽管“直接插入”的性能优于纯真实数据,但由于缺乏阴影、反射等真实感细节,其性能仍低于本文生成式方法。有趣的是,“直接插入”的mAOE指标最高,这可能是因为插入资产与原始边界框朝向完全对齐所致。

图8展示了不同场景下“朴素插入”与本文生成式方法的视觉效果对比,可见Dream4Drive生成的编辑视频真实感更优。

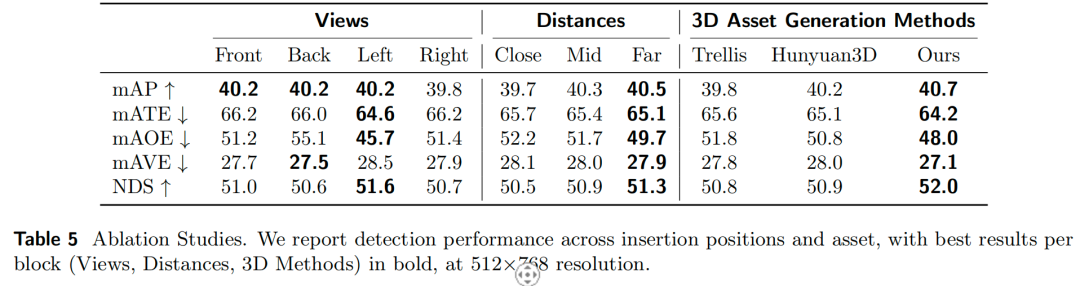

消融实验

插入位置的影响: Dream4Drive可通过在场景中任意位置投影3D资产实现视频编辑。为系统评估插入位置对下游模型性能的影响,本文将插入位置分为“前方(Front)、后方(Back)、左侧(Left)、右侧(Right)”四类,结果如表5所示。

实验结果表明:

在前/后方插入资产的性能相近;

左侧插入的性能优于右侧插入,具体表现为mAP提升0.4个百分点、NDS提升0.9个百分点、mAOE降低5.7个百分点。

这一现象可能源于数据集偏差:nuScenes数据集中多数车辆出现在自车左侧,因此增强这类极端场景可提升模型预测性能,而右侧极端场景对验证集性能的增益有限。

本文还在表5中分析了插入距离对性能的影响:近距离插入的性能往往较差,这可能是因为资产遮挡了相机视野,干扰了其他实例的训练;远距离插入的增强效果更优——由于检测器对远距离目标的检测能力通常较弱,增加远距离目标样本可显著提升检测性能。

3D资产来源的影响: 与现有研究(Ljungbergh et al., 2025)一致,本文发现插入资产的来源会影响合成数据质量,因此进一步探究了不同资产来源对下游感知性能的影响。

如表5所示:

Trellis虽能生成高质量资产,但其风格与自动驾驶场景不完全匹配,插入后易产生伪影并导致质量下降,对下游任务产生负面影响;

Hunyuan3D的单视角生成性能低于本文多视角方法——单视角生成的资产可能存在完整性问题,而本文方法可生成完整、高质量的3D资产。

实验结论

本文总结了合成数据增强感知模型的核心实验发现:

复制原始场景布局生成合成数据无法提升性能;通过插入新3D资产增强场景才是有效的数据增强策略;

高分辨率合成数据对数据增强的增益更显著;

插入资产的位置会影响增强效果,这揭示了数据集中存在的偏差;

远距离插入通常能提升性能,而近距离插入可能因严重遮挡阻碍模型训练;

使用与数据集风格一致的资产可缩小合成数据与真实数据的Domain Gap,更有利于下游模型训练。

结论

本文发现,现有自动驾驶世界模型对“合成数据用于下游任务的有效性”评估存在偏差。为解决这一问题,本文提出Dream4Drive——一种3D感知合成数据生成流程,可合成高质量多视角极端场景(corner cases)。

为助力未来研究,本文还构建了大规模3D资产数据集DriveObj3D,涵盖驾驶场景中的典型类别。大量实验表明,仅添加不足2%的合成数据,Dream4Drive即可持续提升下游感知任务性能,充分验证了合成数据对自动驾驶的实用价值。

自动驾驶之心

论文辅导来啦

自驾交流群来啦!

自动驾驶之心创建了近百个技术交流群,涉及大模型、VLA、端到端、数据闭环、自动标注、BEV、Occupancy、多模态融合感知、传感器标定、3DGS、世界模型、在线地图、轨迹预测、规划控制等方向!欢迎添加小助理微信邀请进群。

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

2855

2855

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?