端到端作为当前自动驾驶量产的核心算法,所涉及的技术栈十分丰富。很多研究生的同学和转行的工业界小伙伴在刚开始接触时,往往会遇到很多问题。目前业内主要有两大类范式:一段式和两段式。一段式最具代表性的就是UniAD,直接从传感器输入(视觉/Lidar/Radar等)建模自车轨迹的输出,二段式基于感知结果进一步输出自车和他车的轨迹。

一段式端到端又可以进一步延伸出基于感知的一段式、基于扩散模型的一段式、基于世界模型的一段式以及基于VLA的一段式端到端算法。不难看出,端到端已经衍生出很多子领域,尤其是基于VLA的相关算法,这两年相关论文在爆发式发表,工业界也在争先量产。

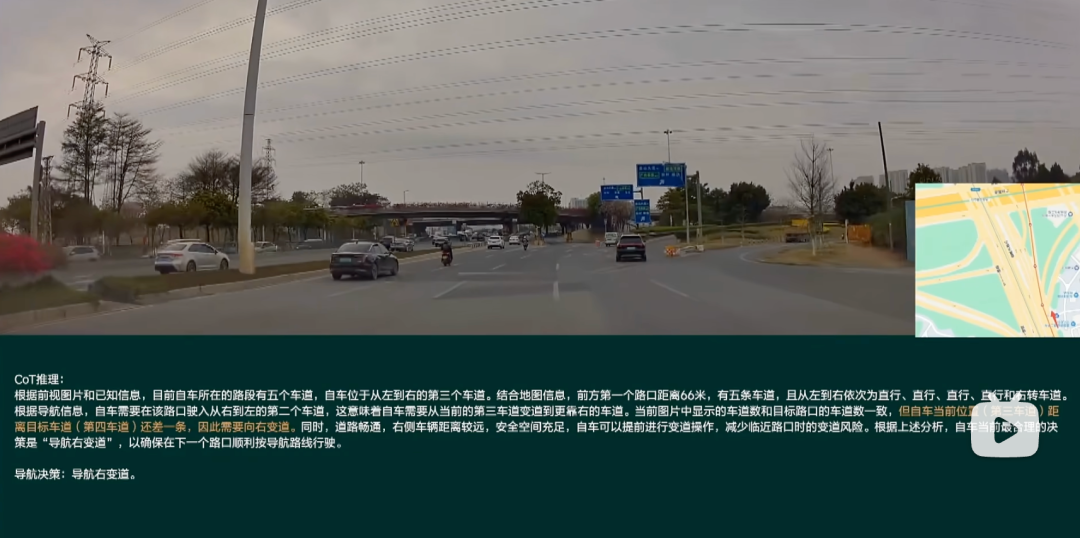

从模块化的量产算法发展到端到端,再到如今的VLA。核心算法涉及BEV感知、视觉语言模型VLM、扩散模型、强化学习、世界模型等等。通过学习端到端与VLA自动驾驶,可以掌握学术界和工业界最前沿的技术方向。

最近几个月,我们收到了很多同学的咨询如何快速高效的入门端到端和VLA。所以我们联合了工业界和学术界的大佬开展了《端到端与VLA自动驾驶小班课》和《自动驾驶VLA和大模型实战课程》!

国庆优惠即将截止!

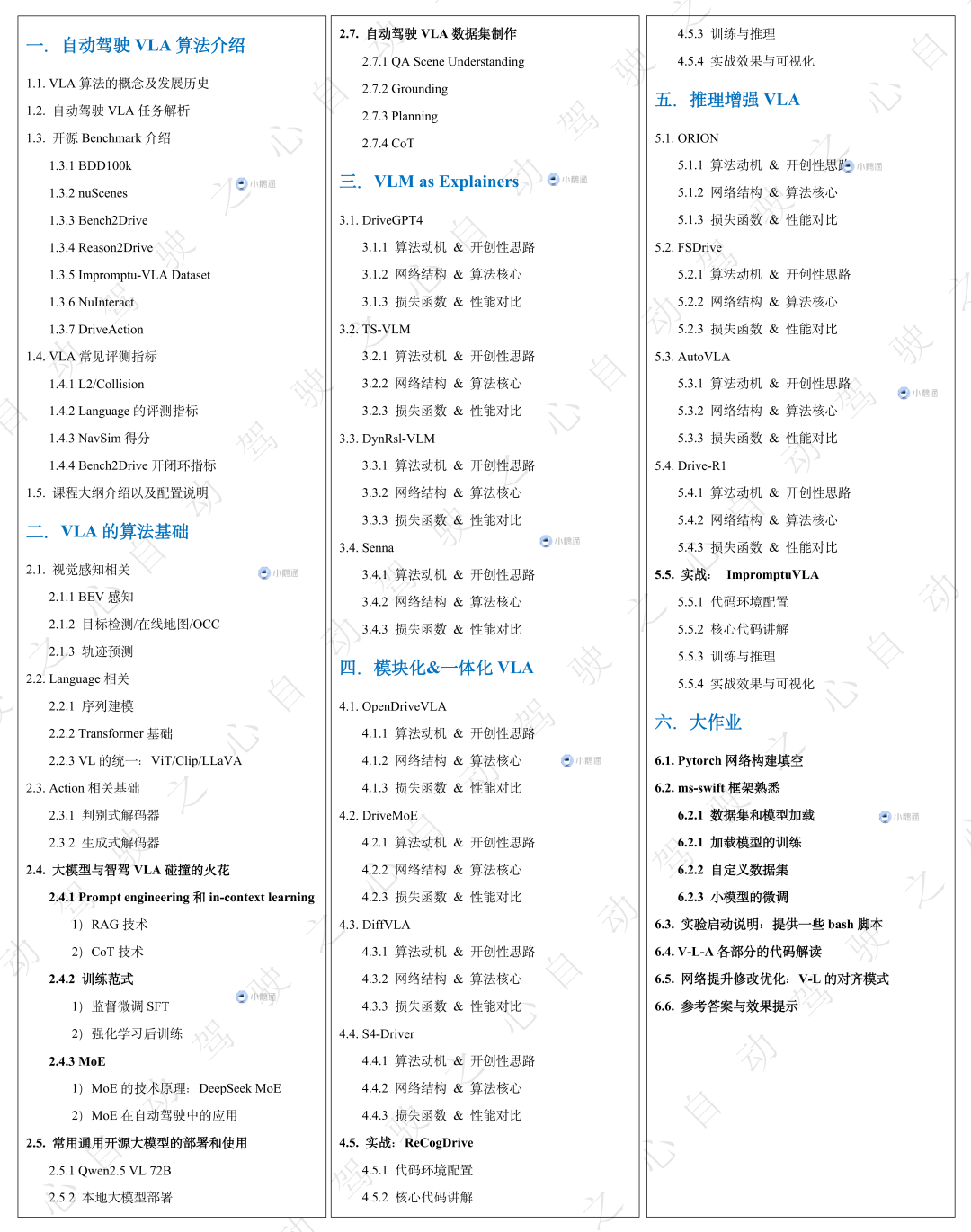

课程大纲

自动驾驶VLA与大模型实战课程

由学术界大佬带队!这门课程聚焦在VLA领域,从VLM作为自动驾驶解释器开始,到模块化VLA、一体化VLA,再到当前主流的推理增强VLA。三大自动驾驶VLA领域全面梳理,非常适合刚接触大模型、VLA的同学。课程也配套了详细的理论基础梳理,Vision/Language/Acition三大模块、强化学习、扩散模型等等基础,更有专门的大作业章节教会大家从零搭建自己的VLA模型及数据集!课程大纲如下:

课程老师团队介绍:

咖喱,清华大学硕士生:在ICCV/IROS/EMNLP/Nature Communications发表论文若干篇。目前从事多模态感知、自动驾驶VLA、大模型Agent等前沿算法的预研,并已主持和完成多项自动驾驶感知和大模型框架工具,拥有丰富的自动驾驶、大模型研发和实战经验。

Max,QS30高校博士在读:在EMNLP、IROS、ICCV、AISTATS等国际顶级会议发表多篇论文,研究方向涵盖多模态大模型与自动驾驶VLA等前沿领域。长期维护GitHub上多个自动驾驶与计算机视觉开源项目,总Star数已超过2k,具备扎实的多模态大模型研发能力与丰富的实战经验。

Eric,清华大学硕士生:在RAL/IROS/EMNLP发表论文若干篇。目前从事在线建图感知、自动驾驶VLA、大模型Agent等前沿算法的预研,拥有丰富的自动驾驶、大模型研发和实战经验。

端到端与VLA自动驾驶课程

由工业界大佬带队!这门课程则聚焦在端到端自动驾驶的宏观领域,梳理一段式/两段式方向的重点算法和理论基础,详细讲解了BEV感知、大语言模型、扩散模型和强化学习。课程设计了两大实战:基于扩散模型的Diffusino Planner和基于VLA的ORION算法。课程大纲如下:

课程老师介绍:Jason, C9本科+QS50 PhD,已发表CCF-A论文2篇,CCF-B论文若干。现任国内TOP主机厂算法专家,目前从事端到端、大模型、世界模型等前沿算法的预研和量产,并已主持和完成多项自动驾驶感知和端到端算法的产品量产交付,拥有丰富的端到端算法研发和实战经验。

面向人群

需要自备GPU,推荐算力在4090及以上;

一定的自动驾驶领域基础,熟悉自动驾驶的基本模块;

了解transformer大模型、强化学习、BEV感知等技术的基本概念;

一定的概率论和线性代数基础,熟悉常用的数学运算;

具备一定的python和pytorch语言基础;

课程咨询

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?