谈机器人,离不开具身智能......

具身智能是一种融合人工智能与机器人技术的创新形式,强调机器人在感知、理解和环境互动中的能力。与传统智能系统不同,具身智能通过物理形式直接与世界交互,从而完成更复杂的任务。其核心在于让机器“身体力行”,以灵活、智能的方式工作,可以说,是机器人领域的GPT时刻。

尤其在工业领域,具身智能的应用日益增多,例如 Figure AI 和特斯拉的人形机器人等。这些机器人旨在解放人类,减少在繁重和重复劳动中的投入,使人们能够专注于更具创造性和价值的工作。国际上,像擎天柱和波士顿动力这样的公司,已经研发出一系列先进的具身智能机器人。这些机器人不仅在制造业中找到了应用,还在物流、运输和甚至家庭服务等领域展现了巨大的潜力。在国内,宇树科技、云深处和智元机器人等公司也相继推出了具身智能产品,完成了量产,进一步推动了这一领域的发展。具身智能的发展空间十分广阔,它不仅可以推动工业和服务业的转型升级,甚至有可能重塑C端(消费者端)和B端(商业端)市场的格局。因此,它引起了资本的高度关注和青睐,投资者纷纷看好这一技术所带来的商业价值和市场潜力。

VLA是什么?VLA的技术栈有哪些?

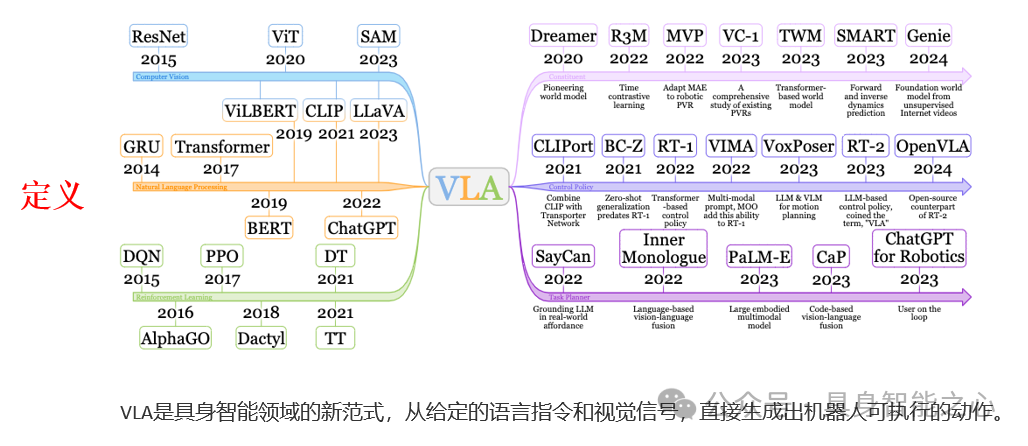

VLA,Vision-Language-Action模型,是具身智能领域的新范式,从给定的语言指令和视觉信号,直接生成出机器人可执行的动作。这种范式打破了以往只能在单个任务上训练大的局限性,提供了机器人模型往更加通用,场景更加泛化的方向发展。VLA模型在学术界和工业界的重要性主要体现在其将视觉信息、语言指令和行动决策有效整合,显著提升了机器人对复杂环境的理解和适应能力。

这种新范式打破了传统方法的单任务局限,使得机器人能够在多样化的场景中自主决策,灵活应对未见过的环境,广泛应用于制造业、物流和家庭服务等领域。此外,VLA模型已成为研究热点,推动了多个前沿项目的发展,如RT-2、OpenVLA、QUAR-VLA和HumanVLA,这些研究促进了学术界与工业界的合作。其适应性体现在能够应用于机械臂、四足机器人和人形机器人等多种平台,为各类智能机器人的发展提供了广泛的潜力和实际应用价值,成为智能机器人领域的关键驱动力。

对于VLA构成的机器人系统来说,主要包括:视觉的感知处理模块,语言指令的理解以及生成机器人可执行动作的策略网络。根据不同的需求,目前的VLA主要分为三类范式:显示端到到VLA,隐式端到端VLA以及分层端到端VLA。

显示端到到VLA,是最常见最经典的范式。通常是将视觉语言信息压缩成联合的表征,然后再基于这个表征去重新映射到动作空间,生成对应的动作。这类端到端的范式依赖于先前广泛的研究先验,通过不同架构(diffusion/ transformer/dit),不同的模型大小,不同的应用场景(2d/3d),不同的任务需求(从头训/下游微调),产生了各类不同的方案,取得了不错的性能。

隐式端到端VLA,则不同于前者,更加关注工作的可解释性,旨在利用当前的video diffusion模型实现未来状态的预测,再根据未来的状态通过逆运动学规律生成未来可执行的动作。通过显式的生成未来观测不仅提高了可解释性,同样也增加了避开机器人动作而scalingVLA模型的潜能。

分层端到端VLA,则关注于充分利用大小模型的特点,提升模型的泛化性同时也保留对于下游执行频率的高效性,近来也成为了研究的热点。

入门学习依然很困难?

无论是显示端到到VLA,还是隐式/分层端到端VLA,其中涉及到的模块、细节众多。这类知识点琐碎,系统也比较复杂,如果没有比较好的教程带着入门,往往会踩坑,后期不知道怎么学习。如何进行感知编码、动作生成?不同架构的优缺点是什么?泛化性和通用性如何保留?数据是怎么采集的?联合训练怎么做?这些都是阻挡新手入门以及进阶的难点。

欢迎微信扫码学习试听!早鸟88折优惠

为此,我们联合业界知名的机器人系统与算法专家,联合展开了业内首门面向具身智能的VLA理论与实战课程,让大家真正能够学得透彻,后期配有代码讲解,助力大家真正从实现的角度上搞懂算法。课程大纲:

课程部分内容一览:

讲师介绍

Perry老师,在智能机器人和人工智能领域具有深厚的学术背景和丰富的实践经验。曾在多个顶级会议:RSS、ICLR、CVPR、ECCV、ICRA和IROS上发表研究。丰富的具身智能实战和研究经验,运用生动的案例和互动式教学,帮助学员深入理解复杂概念,激发对该领域的兴趣与探索。

适合人群

VLA领域的从业人员,需要进一步进阶提升;

从事具身智能研究的本科、硕士、博士生;

希望从传统计算机视觉(CV)或自动驾驶领域转行进入具身智能的专业人士;

对具身智能领域感兴趣的其他人员;

学后收获

能够掌握VLA模型的基本原理和实际应用;

能够理解如何将视觉、语言和行动结合,以提升机器人系统的智能化水平;

获得实用的技能,包括模型训练、数据处理和多任务学习的基本方法;

无论是工程落地还是科学研究都能有所收获;

学习课程后,达到1-2年左右VLA从业经验;

开课说明

2025.1.20号开课,离线视频教学,预计3个月结课。由于课程是虚拟商品,购买后不支持退款。

购买课程

欢迎微信扫码学习试听!早鸟88折优惠

更多问题咨询小助理微信

98

98

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?