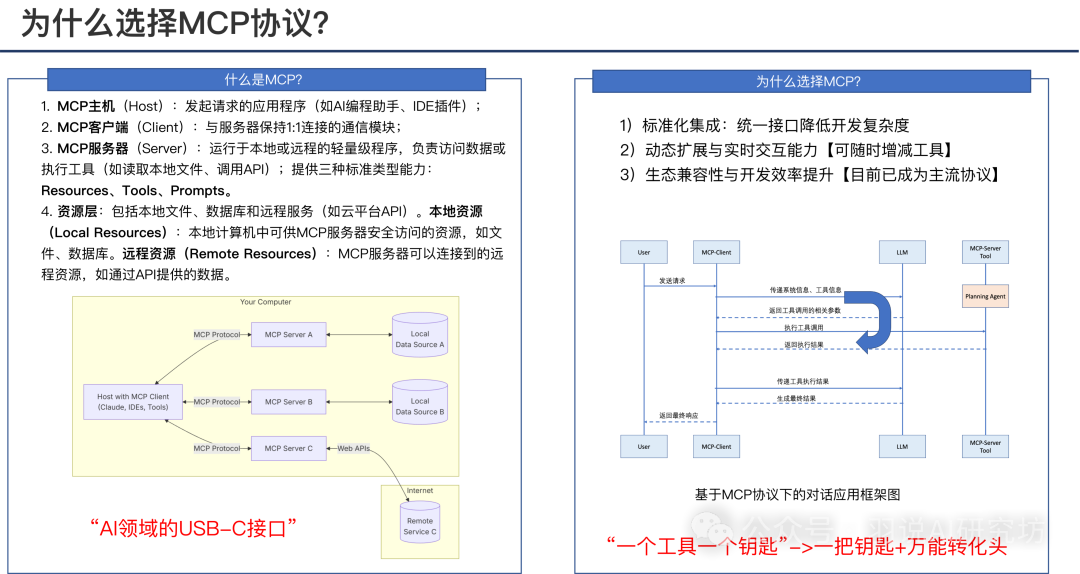

什么是MCP?

最简单而言:MCP提供了工具(资源和prompt用的少)的规范化协议。它的核心组件有以下几点:

-

- MCP主机(Host):发起请求的应用程序(如AI编程助手、IDE插件);

-

- MCP客户端(Client):与服务器保持1:1连接的通信模块;

-

- MCP服务器(Server):运行于本地或远程的轻量级程序,负责访问数据或执行工具(如读取本地文件、调用API);提供三种标准类型能力:Resources、Tools、Prompts。

-

- 资源层:包括本地文件、数据库和远程服务(如云平台API)。本地资源(Local Resources):本地计算机中可供MCP服务器安全访问的资源,如文件、数据库。远程资源(Remote Resources):MCP服务器可以连接到的远程资源,如通过API提供的数据。

为什么选择MCP ?

MCP协议的优势主要有以下几点:

1)标准化集成:统一接口降低开发复杂度

2)动态扩展与实时交互能力【可随时增减工具】

3)生态兼容性与开发效率提升【目前已成为主流协议】

工具侧具体的实现不公开给HOST应用系统,互相独立维护。MCP协议统一,有助于优秀工具的快速集成,在实际开发HOST系统的时候就能快速使用到市面上相对较好的工具(而不需要自己再调用API维护工具函数或者去找到开源代码重新整合到系统中)。

不过实际开发的时候也发现了它的问题,工具和系统互相独立之后,如果需要调整整个系统的准确率,还是免不了可能需要调整工具层。

小白对MCP可能的误区

1)MCP出现之前是不是没有办法调度工具?

不是的。它算是一个通用管理协议,把一个个工具按照一定的规范装在一个量身定做的箱子里。之前也可以进行调度,调度工具关键的点在于大模型识别出使用什么工具以及工具相对应的参数。langchain等在MCP之前就已经支持了工具调度的能力。

2)MCP可以代替function call?

不行,他们是一起工作的关系。如上个问题所述,它只是一个通用协议层。具体函数调用还是需要大模型的支持,而这个协议并不是必须的,在它出现之前就有不少方式,可以直接把工具也放在系统层,直接在系统内调用就可以。

3)MCP能减少调用的token数么?

不行,它只是整合了工具,但实际还是需要把工具参数都发给大模型。整体tokens数消耗相比之前的方式是没有本质区别的,整体依赖于系统的实现。

4)是不是有了MCP,agent应用就能轻而易举搭建了?

不是。MCP只是把工具管理和获取调用这里规范了,但agent应用关键点还有:LLM调用(含function call、prompt工程),记忆系统(RAG,上下文管理),思考和计划系统等。如果想要做好一个agent系统应用,还需要仔细打磨前面提到的模块。

【这里的核心点和踩坑点,后续再梳理文章详细叙述】

如何搭建基于MCP协议的大模型agent应用?

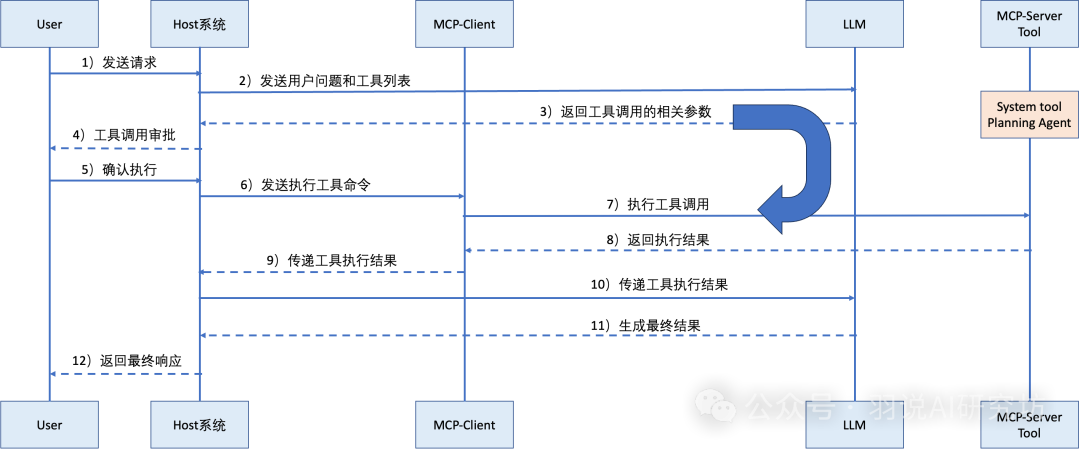

基于MCP协议的大模型Agent应用的工作流程图解。流程始于用户发送请求(步骤1),Host系统将问题及工具列表传递给MCP-Client(步骤2),随后LLM生成工具调用参数(步骤3)并经审批确认(步骤4-5)。MCP-Server Tool执行具体操作(步骤6-7)后,结果通过多级传递(步骤8-10)最终由LLM生成响应(步骤11)返回给用户(步骤12)。整个架构突出了MCP协议在协调用户、主机系统、大语言模型和工具服务之间的核心枢纽作用,体现了模块化分工与安全审批机制的设计理念。

1)User→Host系统

用户向HOST系统发送一个需要处理的问题(自然语言)

2) Host系统→MCP-Client

Host系统将用户原始问题(自然语言)和可调用工具列表(如API、数据库接口等)打包发送至MCP-Client,触发工具规划流程。

3) MCP-Client→LLM

MCP-Client请求LLM分析用户问题,生成结构化工具调用方案(包括工具选择、输入参数等),例如解析"查询北京天气"为调用WeatherAPI的参数{location: “北京”}。

4-5) MCP-Client→Host系统(审批闭环)

MCP-Client提交工具调用申请至Host系统,触发安全审批(如权限校验/风险过滤),通过后返回确认执行指令,确保操作合规性。

6) Host系统→MCP-Server Tool

Host系统向MCP-Server Tool发送工具执行命令(如REST API调用指令),携带LLM生成的标准化参数。

7) MCP-Server Tool执行

工具服务执行具体操作(如调用天气API、数据库查询等),生成原始执行结果(如JSON格式的天气数据)。

8-10) 结果逆向传递链

MCP-Server Tool→Host系统→MCP-Client→LLM,逐层返回工具执行结果,数据经校验和格式化传递,保持上下文一致性。

11) LLM生成最终响应

LLM将工具返回的原始数据转化为用户友好的自然语言(如"北京今日晴,25°C"),并补充逻辑推理或多工具结果融合。

12) Host系统→User

Host系统将LLM生成的最终响应返回给用户,完成闭环。流程中MCP协议通过标准化接口和审批机制,确保多主体间安全、高效的协同。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

如果你真的想学习大模型,请不要去网上找那些零零碎碎的教程,真的很难学懂!你可以根据我这个学习路线和系统资料,制定一套学习计划,只要你肯花时间沉下心去学习,它们一定能帮到你!

大模型全套学习资料领取

这里我整理了一份AI大模型入门到进阶全套学习包,包含学习路线+实战案例+视频+书籍PDF+面试题+DeepSeek部署包和技巧,需要的小伙伴文在下方免费领取哦,真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

部分资料展示

一、 AI大模型学习路线图

整个学习分为7个阶段

二、AI大模型实战案例

涵盖AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,皆可用。

三、视频和书籍PDF合集

从入门到进阶这里都有,跟着老师学习事半功倍。

四、LLM面试题

五、AI产品经理面试题

六、deepseek部署包+技巧大全

😝朋友们如果有需要的话,可以V扫描下方二维码联系领取~

677

677

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?