01Transformer 网络的组成部分

一个基础的 Transformer 语言模型通常包含以下几个模块:

(1)Tokenizer 和 Input Layer

Tokenizer:当输入一段文本时,首先需要通过分词器(Tokenizer)将文本转为对应的 token ID。

这一过程依赖于词汇表(vocabulary),通常保存在模型下载文件中,如 tokenizer.json 或 vocab.json。

常见的分词算法包括 BPE、WordPiece、SentencePiece,它们的核心思想是根据词频学习最优的子词划分方式。

Input Layer(Embedding + Positional Encoding):Token ID 需进一步通过嵌入层(Embedding Layer)转换为向量。

Embedding 的本质是查表:ID 是索引,查找一个预训练矩阵(模型的权重之一)得到其 D 维向量表示。位置编码(Positional Embedding)用于提供 token 的位置信息。

早期 Transformer 使用的是固定的正余弦位置编码,后来逐渐演进为可学习的位置编码,当前主流模型(如 LLaMA、Qwen)则使用旋转位置编码(RoPE)。这三者的对比详见“面试问题1”。

(2)Transformer Block(Attention + Feedforward)

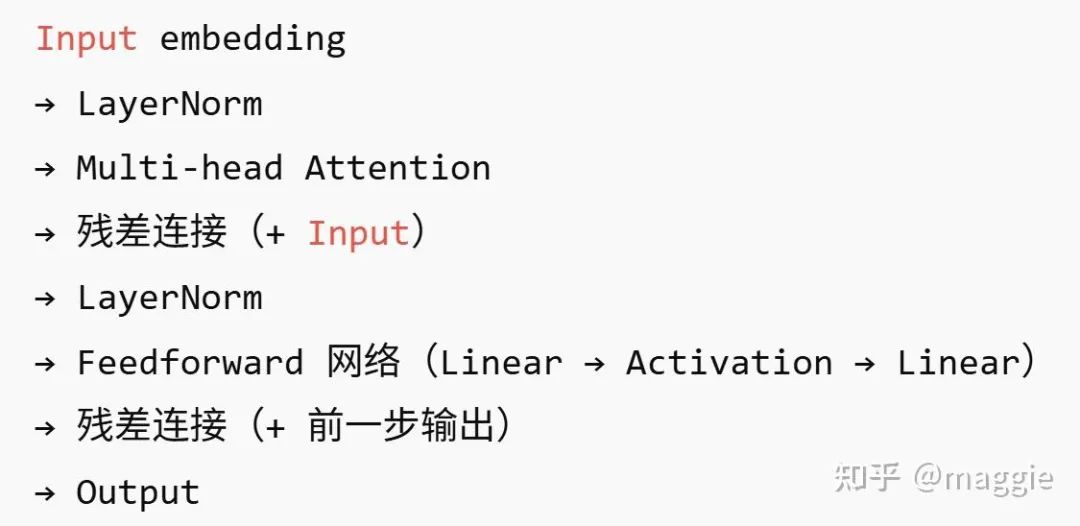

Transformer 的核心结构为多个 Transformer Block 的堆叠,每个 block 包含以下步骤:

注意:每个 Transformer Block 包括 Multi-head Attention 和 Feedforward 子模块。

Multi-head Attention

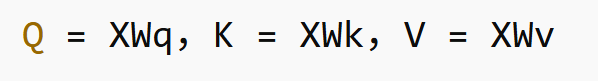

输入为形状 [Batch,SeqLen,D] 的向量序列。通过矩阵乘法得到 Q,K,V:

设有 M 个 head,每个 head 的维度为 D/M,将 Q/K/V 拆成 [Batch,M,SeqLen,D/M]。

每个 head 独立计算 attention,再将所有 head 的输出拼接后经 Linear 层整合回 [Batch,SeqLen,D]。

Multi-head 的优势包括:

- 每个 head 可关注不同的关系:如语义相似、时间顺序、句法结构等;

- 每个 head 参数量较小,有助于训练收敛;

- 天然适合并行计算。

(3)Output Layer

输出层根据任务类型调整结构:

- 对于生成任务(如文本生成),只在最后一个 token 输出结果;

- 对于序列标注(如翻译),需要对每个 token 输出。

通常结构为 Linear(D → V)+ Softmax,其中:

- D 是 Transformer 的输出维度;

- V 是词表大小。

- 例如,若最后一个 Token 输出为 [1,D],词表大小为 V,则经过 [D,V] 的 Linear 层得到 [1,V]。Linear 层的输出叫做 logits,表示每个 token 的打分,Softmax 后转换为概率分布。

- 常见采样方法:Sampling 模块用于从概率分布中选择最终的输出 token。

常见策略有:

- Argmax:直接取最大概率的 token,确定性强,但结果单一;

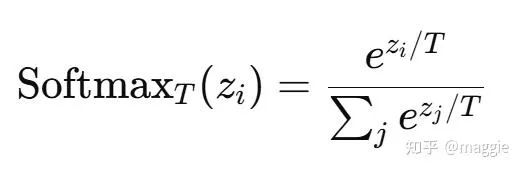

- 温度采样(Temperature Sampling):将 logits 除以一个超参数 T(温度),再进行 softmax。

- T > 1:分布更平滑,多样性更强;

- T < 1:分布更陡峭,保守;

- T → 0:趋近于 Argmax。

Top-K / Top-P(Nucleus)采样:

- Top-K:只从概率最高的 K 个 token 中采样;

- Top-P:选择累计概率超过 P 的前几个 token 进行采样,更稳定、更灵活。

Beam Search:宽度优先搜索,保留多个候选路径,计算每条路径的整体概率,最后选出全局最优。缺点是速度慢,且结果多样性不强。

02 面试高频问题深度解析(5个)

(1)如何设计一个好的位置编码?有哪些主流方法?

位置编码的作用:弥补 Transformer 缺乏位置信息的问题,使模型能区分“我爱你”和“你爱我”。

好的位置编码需满足:

- 每个位置编码唯一(可区分性);

- 相近位置编码相似,远距离差别大(连续性);

- 编码应能推广至未见过的位置(外推性);

- 编码应关注相对位置,而非绝对位置;

- 具备多尺度特征,以建模长短依赖。

常见方法:

正弦位置编码(Sinusoidal): 固定编码,可外推。每个位置的编码为 D 维向量,偶数维为 sin,奇数维为 cos。不同维度代表不同频率,形成多尺度表达。

可学习位置编码(Learnable): 用神经网络学习每个位置的向量。缺点是训练时需设定最大长度,泛化差,不支持外推。

RoPE(Rotary Position Embedding): 用正余弦构建旋转矩阵,不是直接加到 embedding 上,而是应用于 Q/K。

其核心优势:

- 支持任意长度外推;

- 相对位置不变性;

- 可用于注意力中的 QK 点积操作;

- 是目前主流 LLM 的默认配置。

(2)为什么主流 LLM 都采用 Decoder-Only 架构?

原始 Transformer 是 Encoder-Decoder 结构,Decoder 包含 Masked Self-Attention 和 Cross-Attention。

主流 LLM(如 GPT 系列)精简为 Decoder-only,即仅使用 Masked Self-Attention。

Encoder 与 Decoder 区别:

- Encoder 是 双向注意力,每个 token 可关注前后上下文;

- Decoder 是 单向注意力,只能关注前面的 token。

Decoder-only 优点:

- 简化结构(无需 cross attention);

- 所有输入统一处理,代码更简洁;

- 适合生成任务(如 GPT);

- 支持 KV Cache 提速,极大提高推理效率。

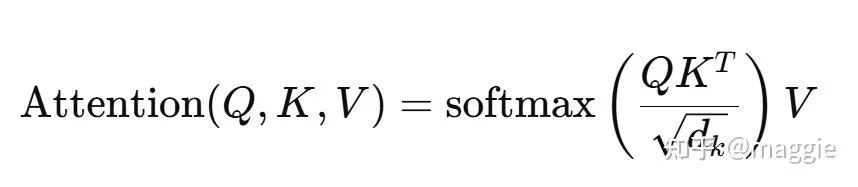

(3)Attention 为什么除以 √d?

Attention 中:

- QKᵀ 是向量点积,结果方差随 d 增大;

- 若不除以 √d,softmax 的输入会过大或过小,导致梯度爆炸或消失

- 除以 √d 可将方差归一化到 1(假设 Q,K ~ N(0, 1));

- 这是 Attention 模块数值稳定性的关键

(4)有哪些常用的 Norm,为什么 LayerNorm 适合 LLM?

归一化的本质:避免梯度消失/爆炸,缓解“内部协变量偏移”,提升模型的收敛速度与泛化能力。

常见 Norm:

PreNorm vs PostNorm:

- PreNorm(注意力前):更稳定,训练容易;

- PostNorm(注意力后):与原始 Transformer 一致,但训练时可能不稳定。

(5)Transformer 中用哪些激活函数?优缺点如何?

作用:引入非线性,否则神经网络只能拟合线性函数。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

如果你真的想学习大模型,请不要去网上找那些零零碎碎的教程,真的很难学懂!你可以根据我这个学习路线和系统资料,制定一套学习计划,只要你肯花时间沉下心去学习,它们一定能帮到你!

大模型全套学习资料领取

这里我整理了一份AI大模型入门到进阶全套学习包,包含学习路线+实战案例+视频+书籍PDF+面试题+DeepSeek部署包和技巧,需要的小伙伴文在下方免费领取哦,真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

部分资料展示

一、 AI大模型学习路线图

整个学习分为7个阶段

二、AI大模型实战案例

涵盖AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,皆可用。

三、视频和书籍PDF合集

从入门到进阶这里都有,跟着老师学习事半功倍。

四、LLM面试题

五、AI产品经理面试题

六、deepseek部署包+技巧大全

😝朋友们如果有需要的话,可以V扫描下方二维码联系领取~

5分钟搞懂Transformer核心考点

5分钟搞懂Transformer核心考点

710

710

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?