前言

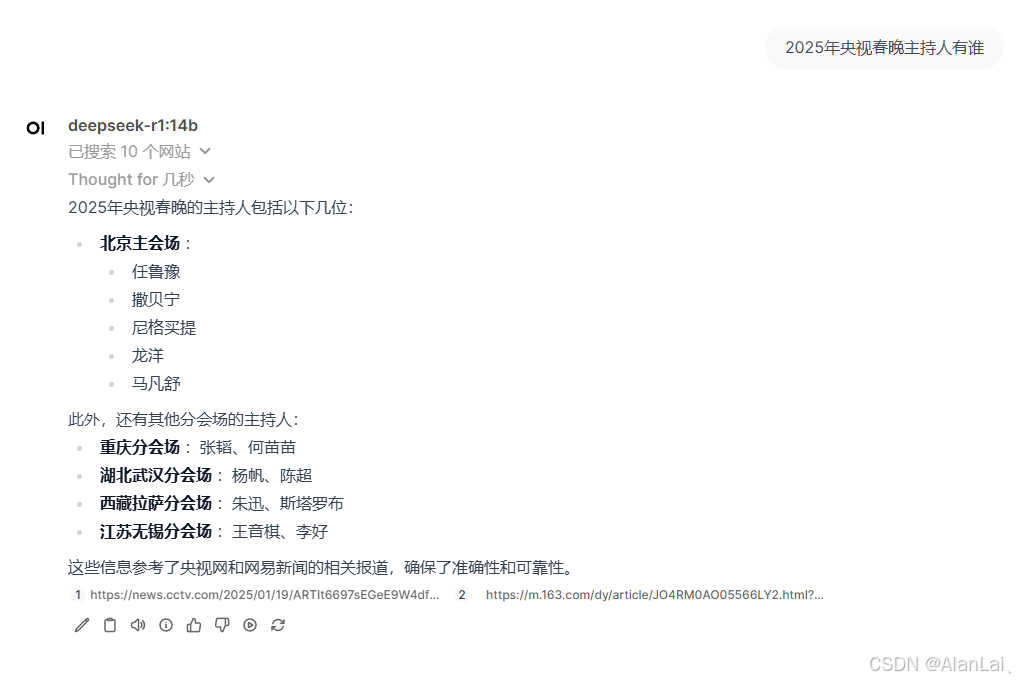

上一篇文章讲解了本地部署ollama + deepseek + open-webui并开启cuda、cudnn加速,现在讲解下open-webui实现网络搜索。

传送门:保姆级教程 本地部署 deepseek + ollama + open-webui + cuda + cudnn

一、博查简介

市面上有很多web search api厂商,比如brave、exa、bing等,但是基本是国外的,访问慢有些还需要魔法,微软的bing价格贵且订阅需要绑定国际信用卡,所以这里推荐国内的博查。

简介:持自然语言搜索的 Web Search API,从近百亿网页和生态内容源中搜索高质量世界知识,包括新闻、图片、视频、百科、机酒、学术等。

官网:https://bochaai.com/

开放平台:https://open.bochaai.com/

二、安装博查版open-webui

由于open-webui官方还没集成博查,据说已提交审核,应该快了,集成之后直接用open-webui配置即可。

- 博查提供的安装文档:Deepseek满血+联网本地部署教程:在 Ollama + OpenWebUI 中使用博查联网搜索能力

- 博查open-webui源码地址:https://github.com/BochaAI/open-webui-Bocha

将源码下载到本地,上一篇已经讲述了如何安装Anaconda,现在一样创建一个 open-webui-bocha 的虚拟环境:

conda create -n open-webui-bocha python=3.11

切换到 open-webui-bocha 环境

activate open-webui-bocha

切换pip镜像源

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

进入 open-webui-Bocha/backend 目录,安装依赖

pip install -r requirements.txt -U

在 backend 目录新建data文件夹存放数据库

三、安装nvm并构建前端

因为需要打包前端,所以推荐使用nvm来管理node版本,方便切换使用。

下载完直接安装即可,然后安装node V20.3.0

nvm install 20.3.0

切换到node 20.3.0

nvm use 20.3.0

设置npm镜像源

npm config set registry=https://registry.npmmirror.com

进入 open-webui-Bocha 根目录,安装前端所需的相应依赖和模块

npm install

构建前端环境

npm run build

四、启动open-webui-bocha

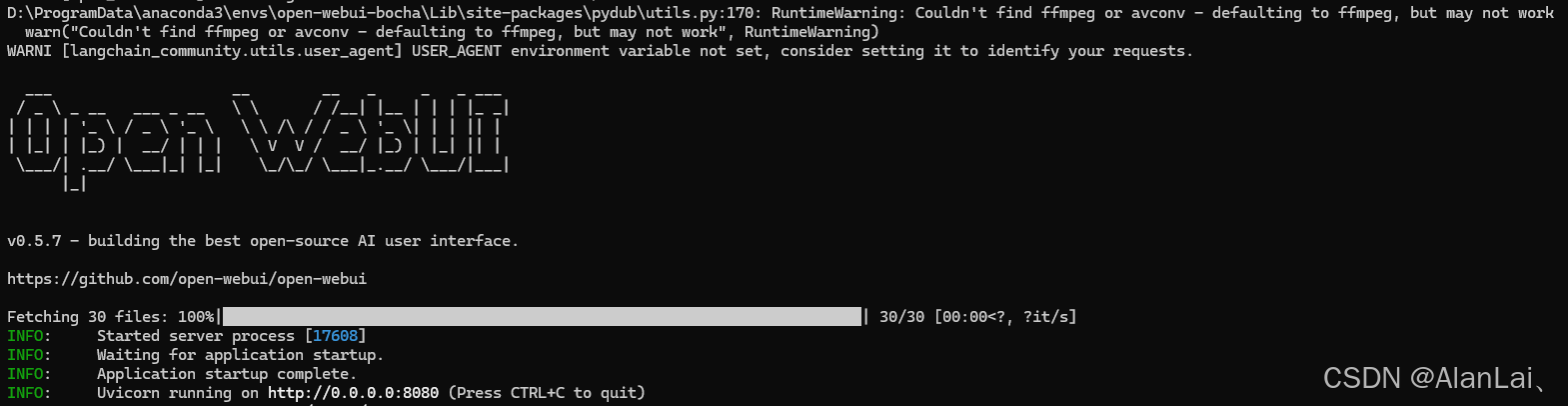

进入 open-webui-Bocha/backend 文件夹下执行 start_windows.bat,出现以下内容说明启动成功:

如出现包含 huggingface 的报错,是由于本机因无法访问huggingface网站而导致无法下载对应的语义向量模型,自己加点魔法~

五、配置博查联网搜索

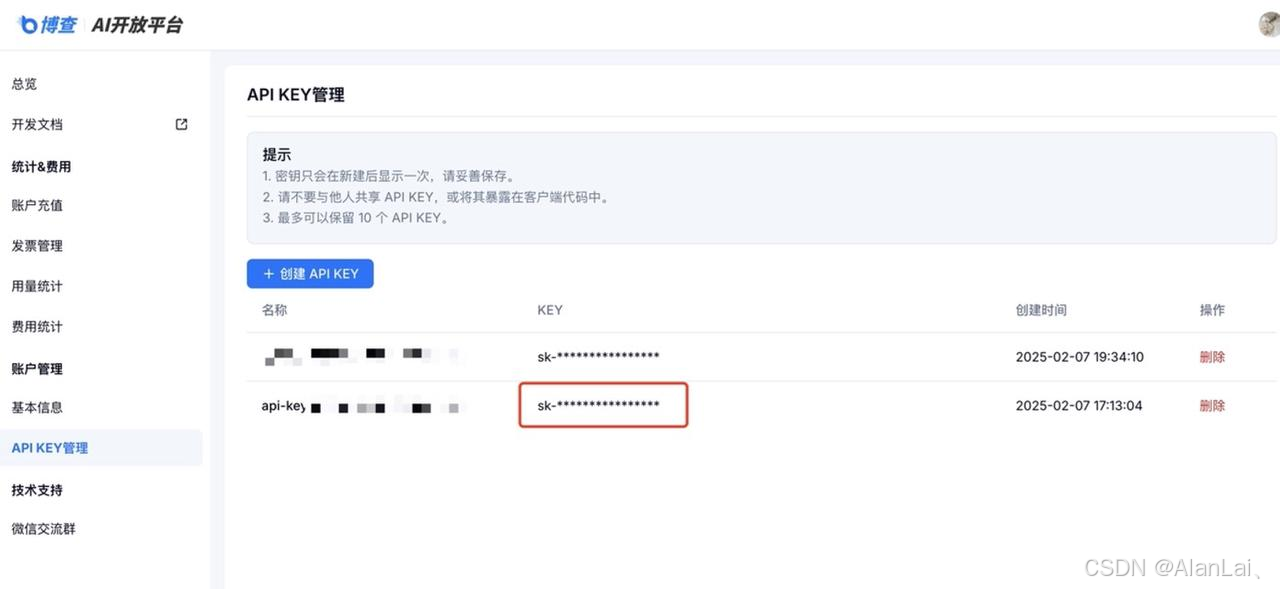

进入博查开放平台(https://open.bochaai.com/),登录之后获取自己的API key 信息(需要充个10块,没免费额度~)

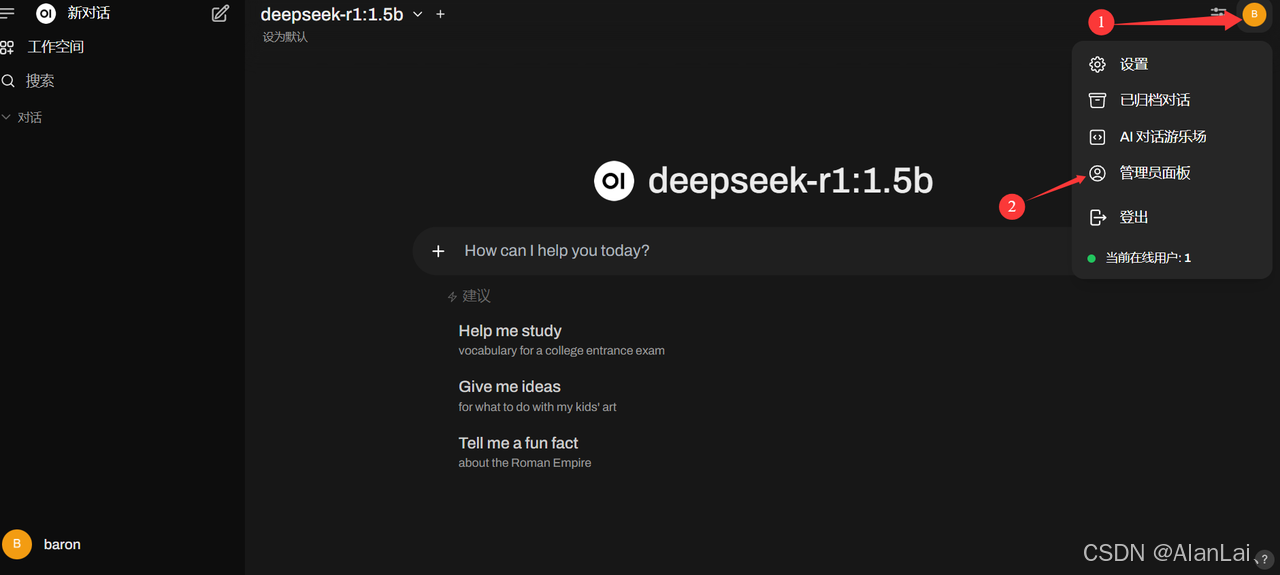

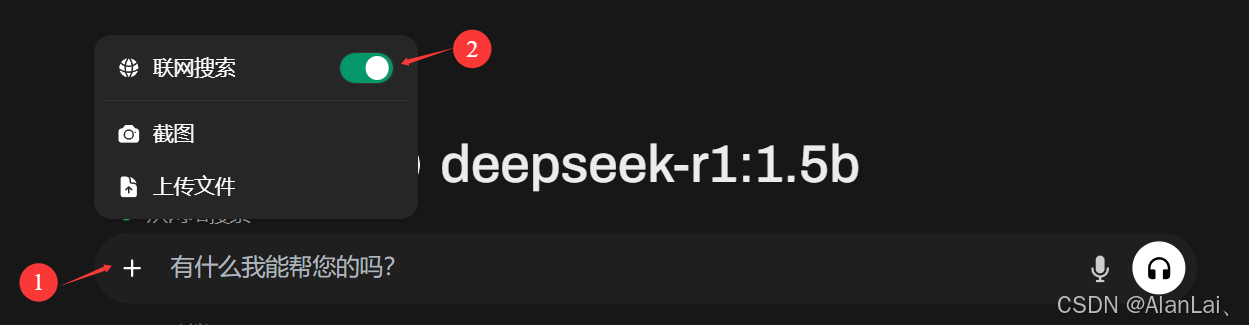

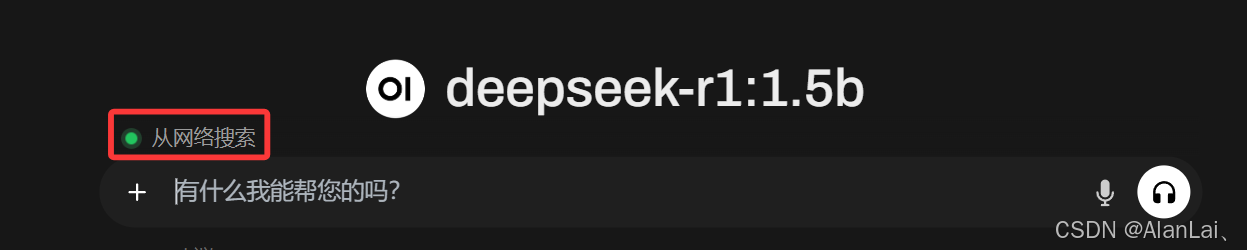

设置联网搜索:管理员面板->设置->联网搜索->点开启用联网搜索->选择bocha->输入bochaAPI->保存

4243

4243

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?