前言

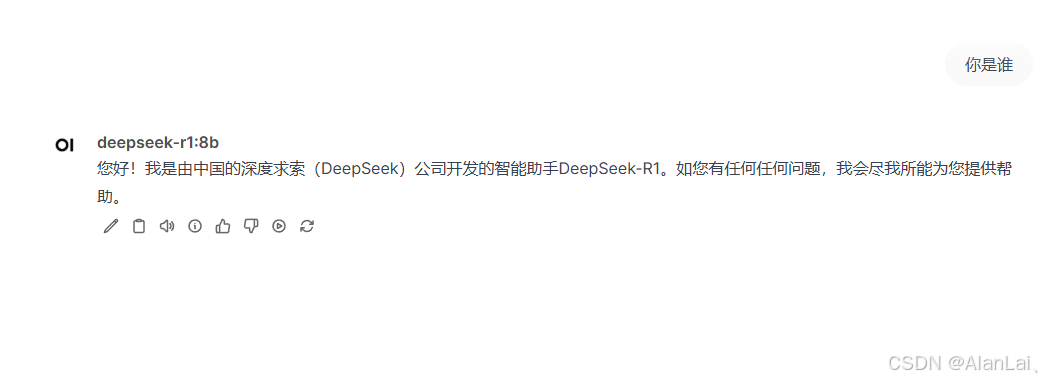

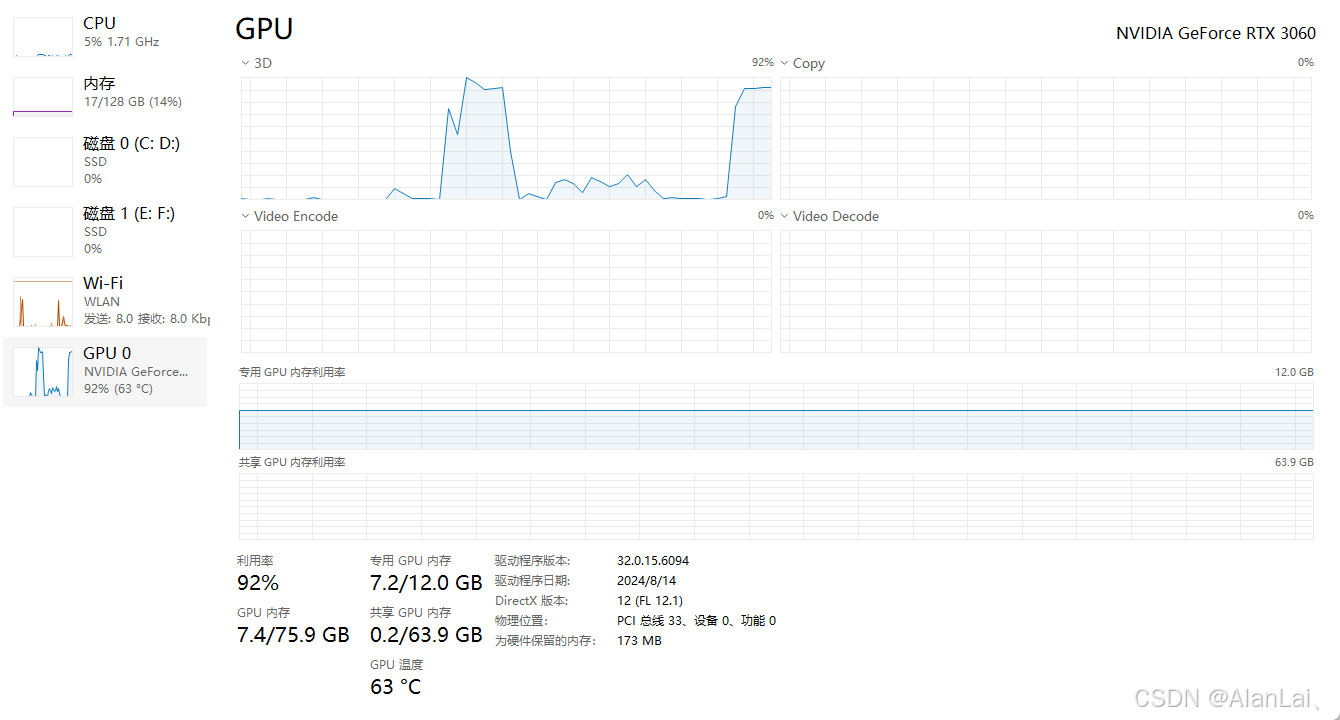

本地部署deepseek-r1,基于ollama + webui,并开启cuda + cudnn 加速运算,我电脑显卡是3060 12G,没显卡的可以跳过cuda + cudnn的安装。

一、安装cuda、cudnn

- CUDA(Compute Unified Device Architecture)是 NVIDIA 的并行计算平台和编程模型,允许开发者利用 GPU 进行通用计算。

- cuDNN(CUDA Deep Neural Network library)是基于 CUDA 的深度学习加速库,专为神经网络操作优化。

总结,CUDA 提供 GPU 计算基础,cuDNN 在此基础上优化深度学习任务,两者共同提升深度学习应用的性能。

- 安装cuda

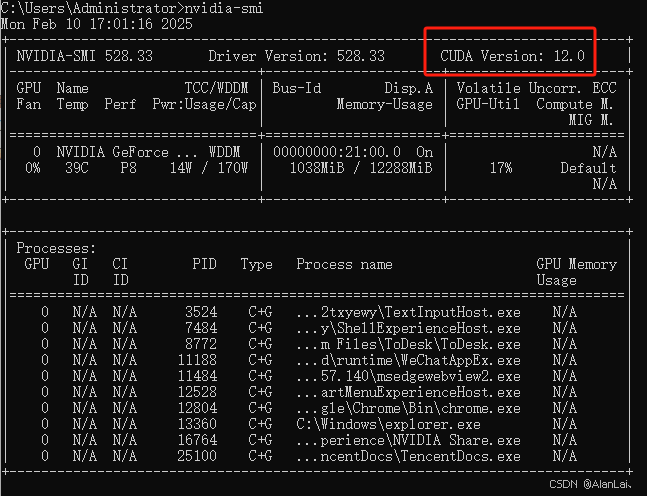

查看当前显卡所支持的cuda版本,打开cmd,执行nvidia-smi

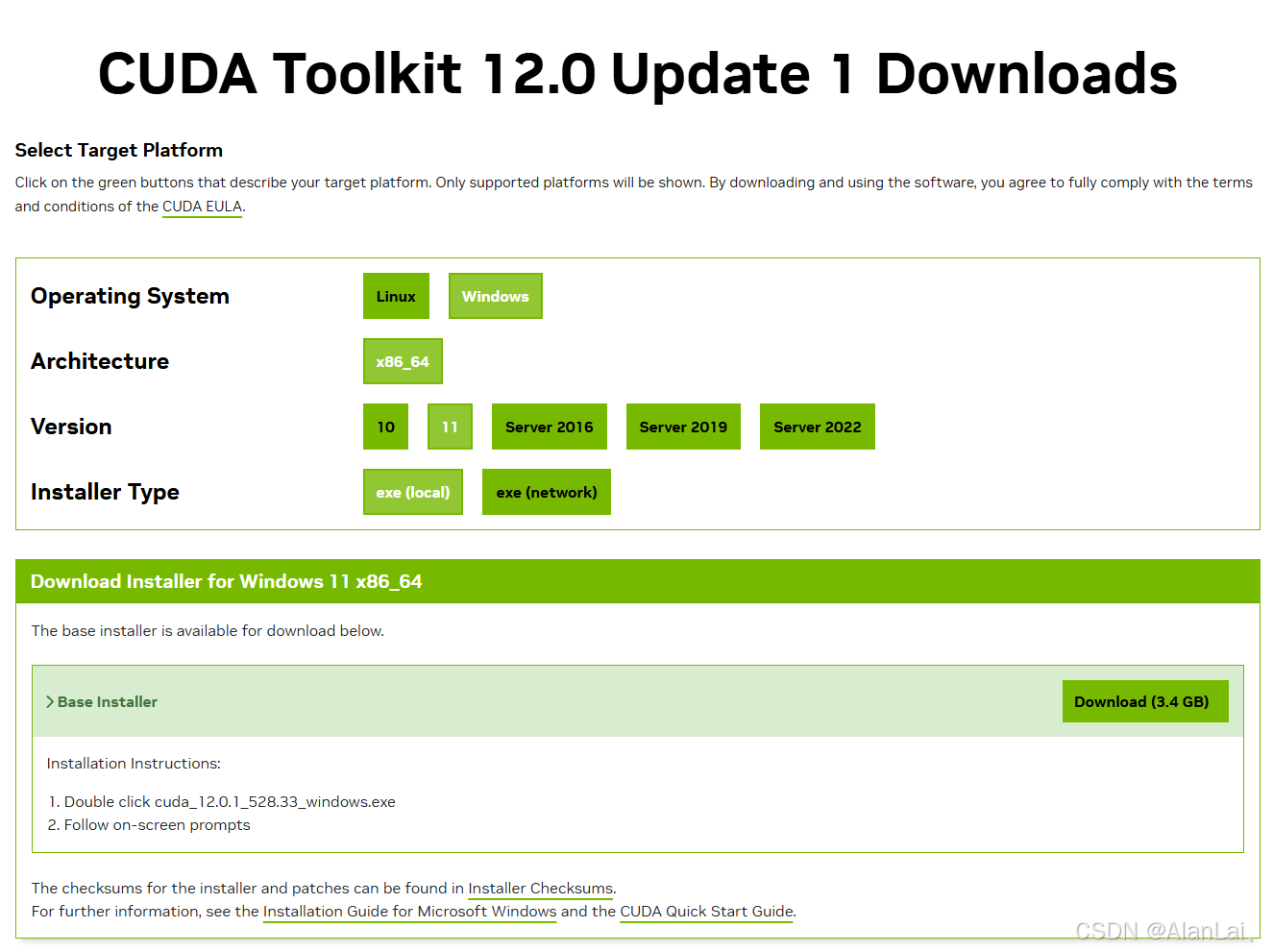

如图所示,我的cuda版本是12.0,然后去官网下载对应的cuda。地址:https://developer.nvidia.com/cuda-toolkit-archive,然后根据自己操作系统进行选择下载。

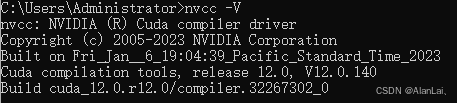

下载好后直接安装,全部按默认的就行,更改路径容易导致安装失败,安装完成后,打开cmd,执行nvcc -V,可以查看cuda信息。

- 安装cudnn

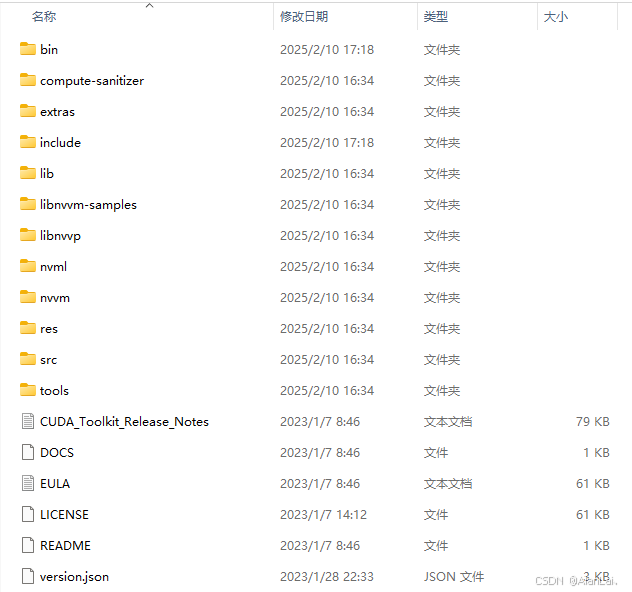

根据自己cuda版本选择下载,地址:https://developer.nvidia.com/rdp/cudnn-archive,下载完成后,将里面的文件,全部拷贝至cuda根目录(C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.0)。

cudnn目录结构

cuda目录结构

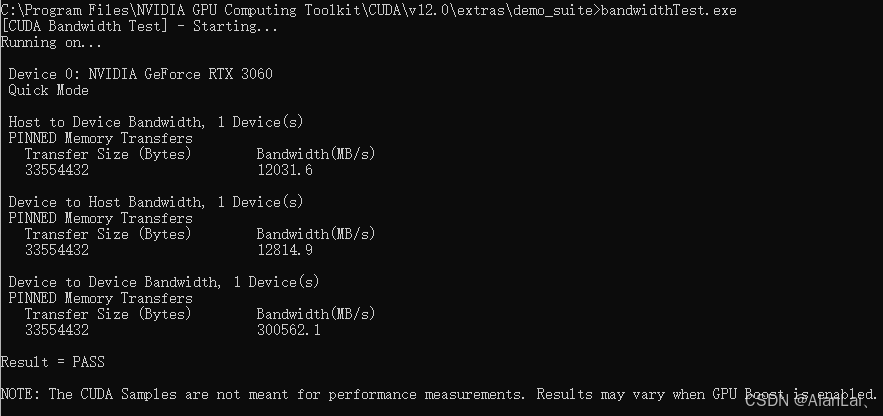

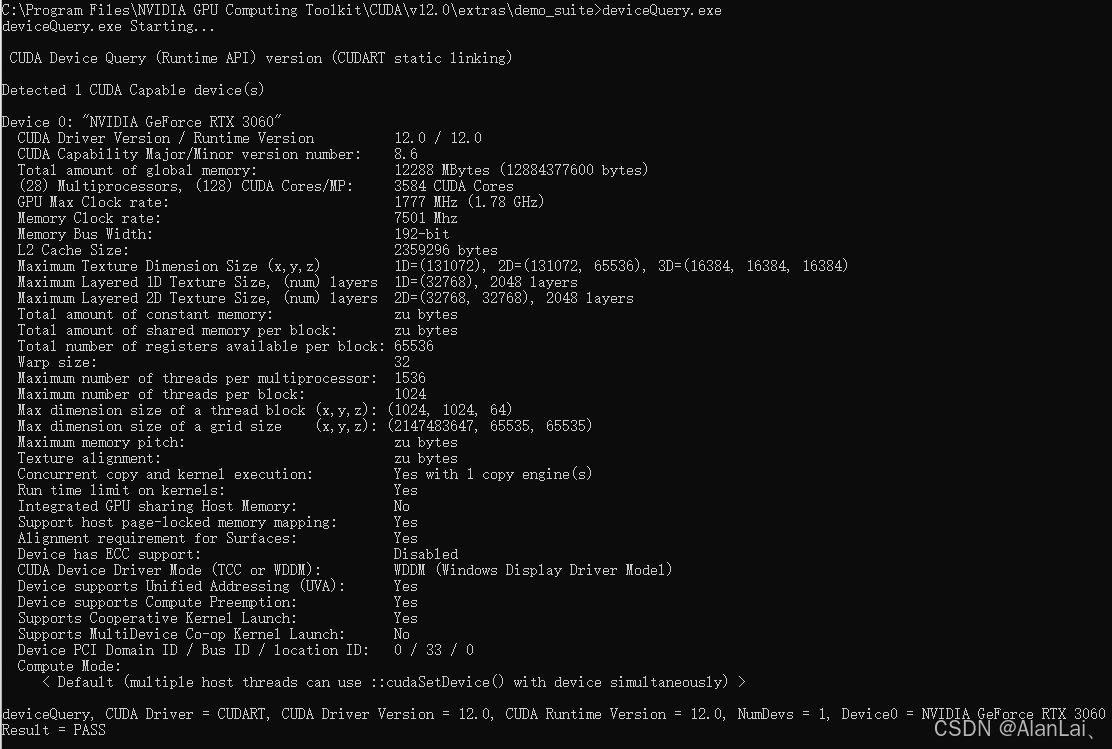

打开cmd,执行C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.0\extras\demo_suite目录下的 bandwidthTest.exe 和 deviceQuery.exe,输出一下信息说明安装成功。

二、安装ollama

下载ollama,地址:https://ollama.com/,默认安装在C盘,如果想换目录,打开cmd,输入以下命令:

OllamaSetup.exe /DIR="D:\ollama"

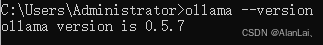

打开cmd,输入以下命令验证安装是否成功:

ollama --version

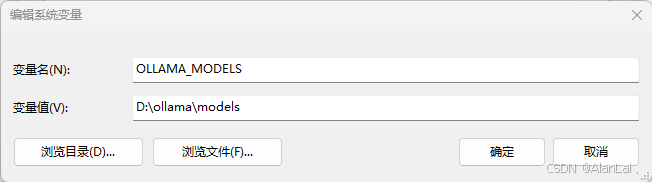

修改模型下载目录,配置系统环境变量OLLAMA_MODELS,并设置目录。

三、下载模型

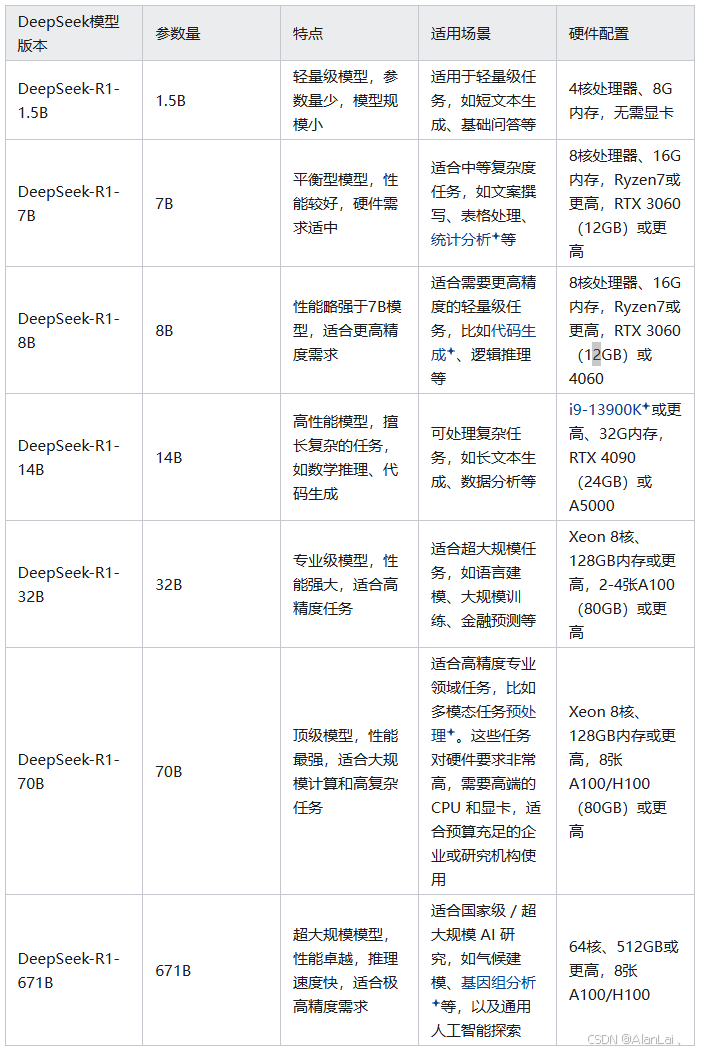

deepseek各个模型之间的对比

- DeepSeek V3

- 定位:通用型大语言模型,专注于自然语言处理(NLP)、知识问答和内容生成等任务。

- 核心能力:高效的多模态处理能力(文本、图像、音频、视频),适用于大规模文档处理、搜索引擎优化和高并发查询任务。

- 优势:低成本、高通用性,适合广泛的应用场景,如智能客服、内容创作、知识问答等。

- DeepSeek R1

- 定位:专为复杂推理任务设计,强化在数学、代码生成和逻辑推理领域的性能。

- 核心能力:通过强化学习(RL)和动态门控机制,优化推理能力,适用于科研、算法交易、代码生成等复杂任务。

- 优势:在推理任务中表现卓越,支持模型蒸馏,可将推理能力迁移至更小的模型,适合本地化部署。

- DeepSeekLLM

- 定位:专为大规模语言生成任务设计,适用于对话系统和生成任务。

- 核心能力:强大的语言生成能力,支持对话生成、文本生成、情感分析等任务。

- 优势:适应复杂对话场景,具备强大的上下文理解能力。

大家依据自己情况选择模型,这里我选DeepSeek R1,各个参数量的对比如下:

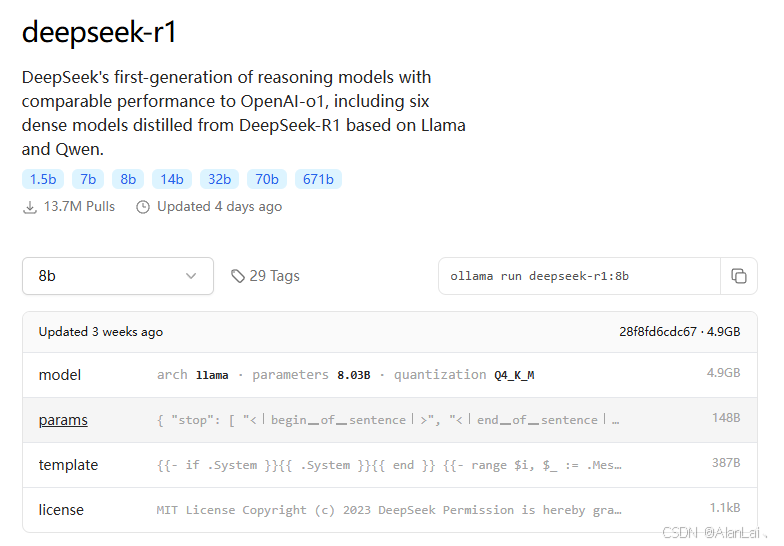

我的显卡只有12G,所以选择DeepSeek-R1-8B,在cmd中执行下载:

ollama run deepseek-r1:8b

模型地址:https://ollama.com/library/deepseek-r1:8b

四、安装客户端OpenWebUI

市面上常见的AI客户端有好多,常见的如下:

-

CherryStudio,官网(https://cherry-ai.com/),支持市面上绝大多数服务商的集成,并且支持多服务商的模型统一调度。

-

chatbox,官网(https://chatboxai.app/zh),一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

-

open-webui,官网(https://openwebui.com/),一个功能丰富且用户友好的自托管 Web 用户界面(WebUI),它被设计用于与大型语言模型(LLMs)进行交互,特别是那些由 Ollama 或与 OpenAI API 兼容的服务所支持的模型。Open WebUI 提供了完全离线运行的能力,这意味着用户可以在没有互联网连接的情况下与模型进行对话,这对于数据隐私和安全敏感的应用场景尤为重要。

大家可以根据自己情况去选择下载,下面讲解open-webui安装教程。

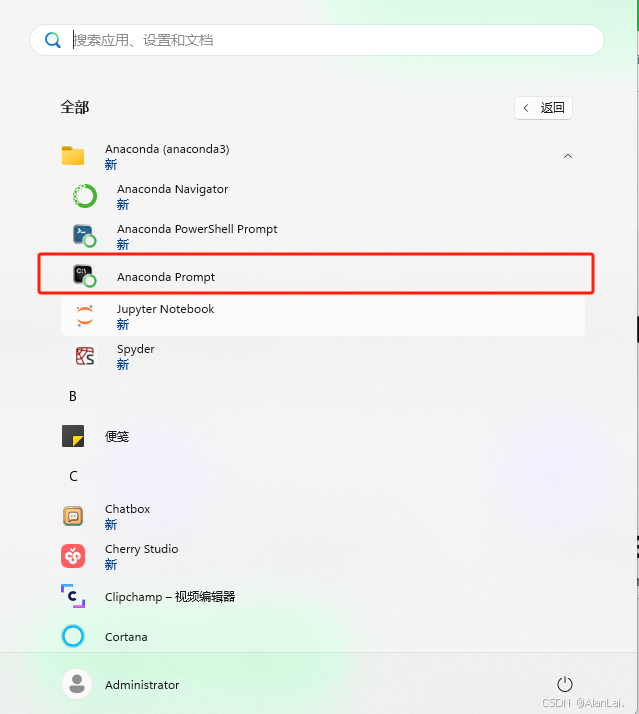

首先,下载Anaconda,python多环境管理工具,官网(https://www.anaconda.com/download),然后打开Anaconda控制台,如图所示:

执行命令创建一个python 3.11

conda create -n open-webui python=3.11

查看虚拟机环境列表

conda env list

使用open-webui虚拟环境

activate open-webui

查看当前python版本

python --version

切换pip镜像源

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

安装open-webui

pip install open-webui

升级open-webui

pip install open-webui --upgrade

启动open-webui

open-webui serve

访问open-webui( http://localhost:8080/)

这里就基本完成了本地部署,在使用中可以观察显卡和cpu使用情况,就可以知道有没有走显卡运算。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?