1. 引言

最近deepseek爆火,随着用户激增,服务器时常繁忙,但是deepseek作为一款开源大模型,我们可以采取本地部署解决在线服务的延迟和宕机问题。

2. 本地部署

deepseek的本地部署可以借助于Ollama这个工具,访问 https://ollama.com/ 进入 Ollama 官网下载 Ollama,在官网上下载自己系统对应的版本即可。

注:下载时网页访问github,浏览器可能提醒无法访问,挂个梯子即可解决

下载完后打开程序安装,windows系统中ollama默认安装在C盘

默认安装后的目录:C:\Users\username\AppData\Local\Programs\Ollama

默认安装的模型目录:C:\Users\username\ .ollama

默认的配置文件目录:C:\Users\username\AppData\Local\Ollama

安装完成后打开cmd(按win键搜索即可),在命令栏中输入

ollama help若出现如下列表,即安装成功

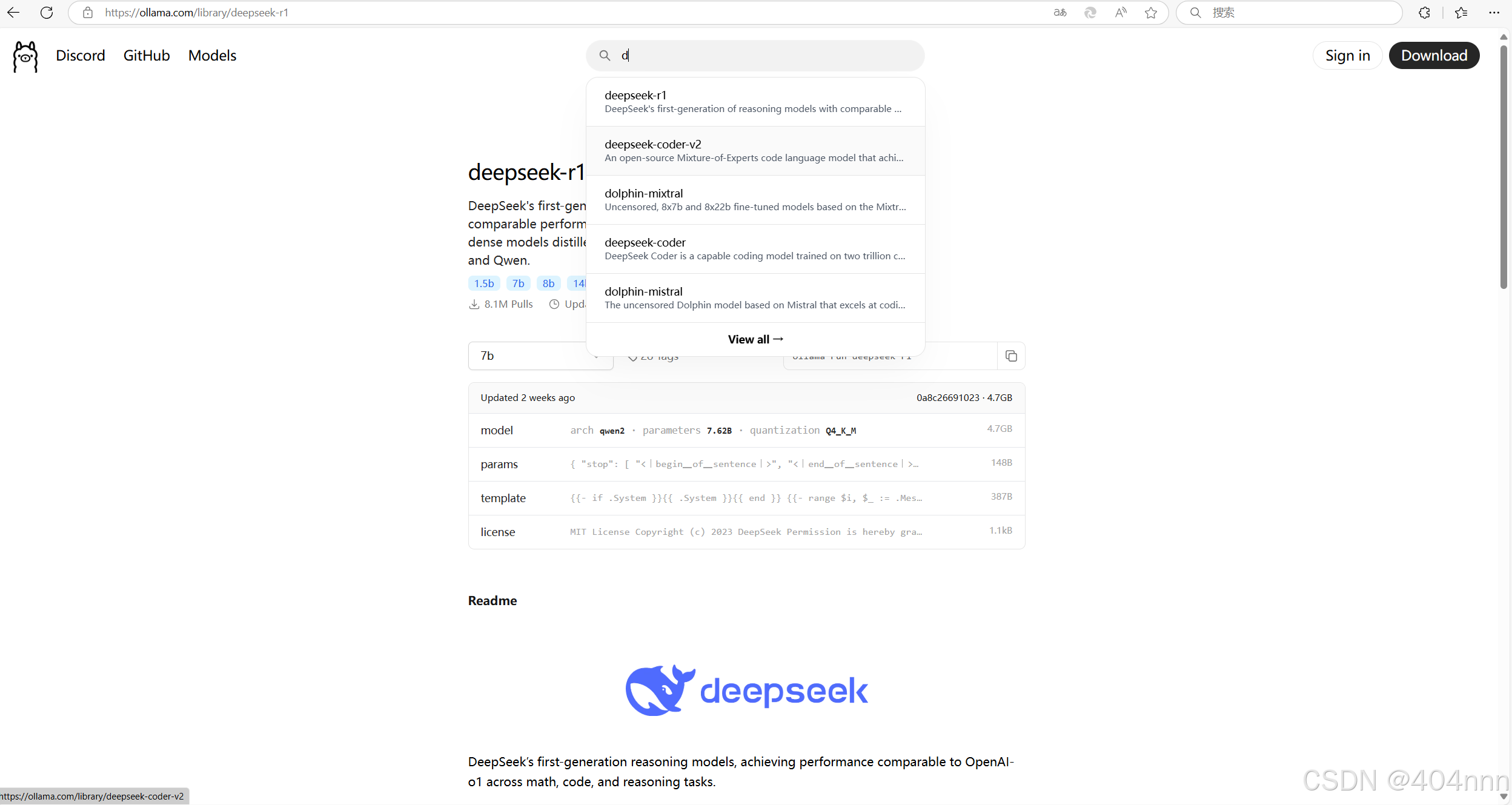

回到ollama官网https://ollama.com/,在搜索栏输入deepseek-r1

选择想要部署的模型参数规模,参数越大效果越好,但是硬件要求越高,可以根据自己硬件配置选择,配置参考如下

在页面中选中想要的参数规模之后,复制命令(此处用1.5b模型进行演示),输入到cmd中。

1.5b的命令:

ollama run deepseek-r1:1.5b

等待下载完成即本地部署完成(不出现端口占用的情况下)

出现端口占用,提示:Error: Post "http://127.0.0.1:11434/api/show": dial tcp 127.0.0.1:11434: connectex: No connection could be made because the target machine actively refused it.

请看下一点。

如果需要可视化界面,可以通过 Chatbox https://chatboxai.app/zh 这个可视化图文交互界面来使用它。

3. 解决端口占用问题

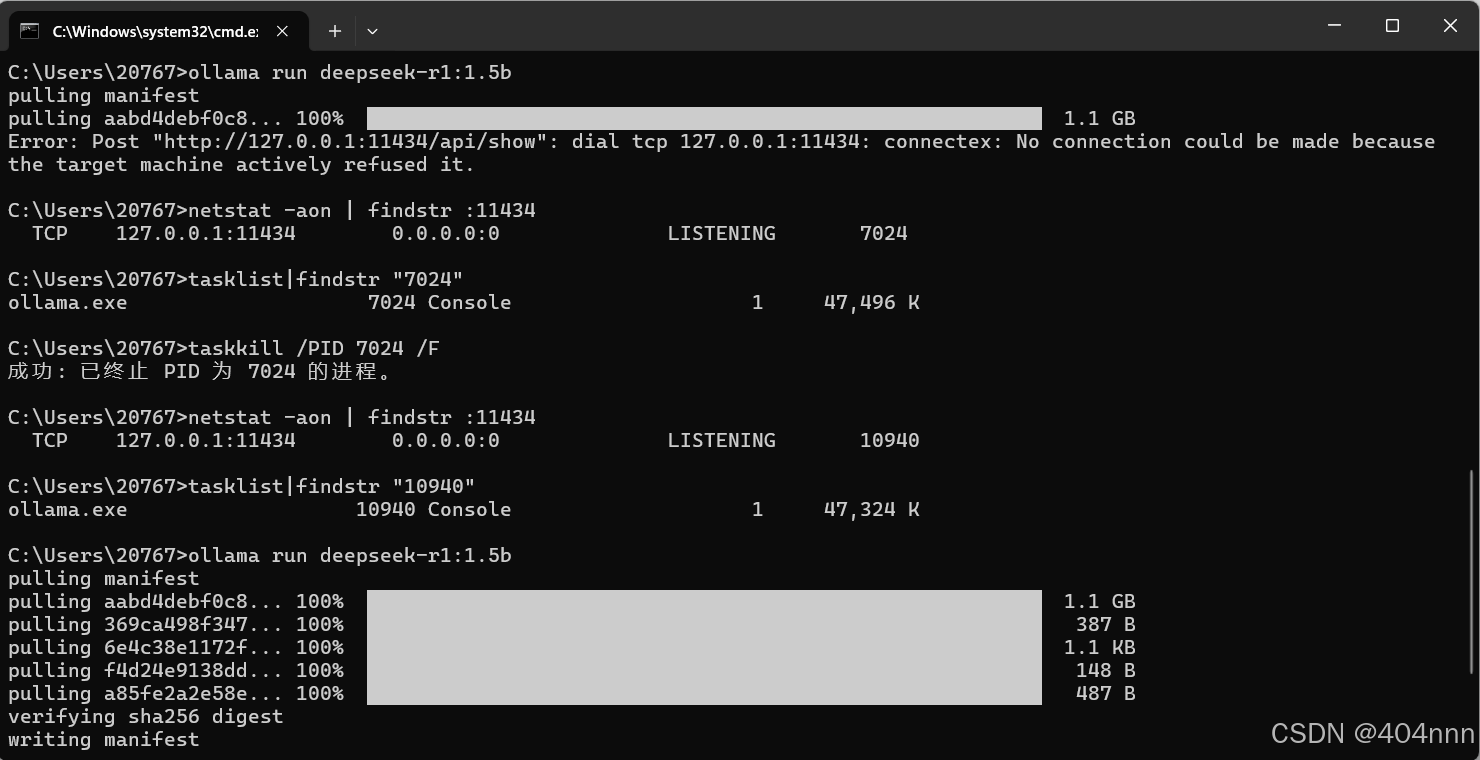

在输入ollama run deepseek-r1:1.5b之后,可能出现如下提示

C:\Users\20767>ollama run deepseek-r1:1.5b

pulling manifest

pulling aabd4debf0c8... 100% ▕███████████████████████████████████████████████████████ 1.1 GB

Error: Post "http://127.0.0.1:11434/api/show": dial tcp 127.0.0.1:11434: connectex: No connection could be made because the target machine actively refused it.

这时候你直接结束占用这个端口的进程没有用的,ollama会自启动,占用端口的还是ollama.exe

解决方法:

打开任务管理器(ctrl+alt+del),在启动应用中找到ollama.exe,右键把它禁用了,如下图所示:

然后重新在cmd中输入

netstat -aon | findstr :11434查看默认端口11434下的任务进程PID(此处为7024)

输入命令结束PID为7024的进程(把下面命令中的7024改成你自己任务进程)

taskkill /PID 7024 /F

此时重新输入ollama run deepseek-r1:1.5b,即可正常开始安装部署,完成后即可本地使用。

4. 结语

本文为笔者在本地部署deepseek-r1模型时的经验与相关问题解决方法,后续可能会完善关于chatbox作为本地部署的大模型的前端的使用方法,写本篇用作分享,希望可以给您带来一些帮助或者遇上bug的启发。如果确实帮助到了您,希望您给我点点赞和星星,不胜感激!!!

5904

5904

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?