本地部署deepseek

一、下载并安装OllamaSetup

官网https://ollama.com/download,点击download下载对应系统的版本,支持win、linux、mac

默认装c盘了。。。没发现可以更改安装目录的地方

默认装c盘了。。。没发现可以更改安装目录的地方

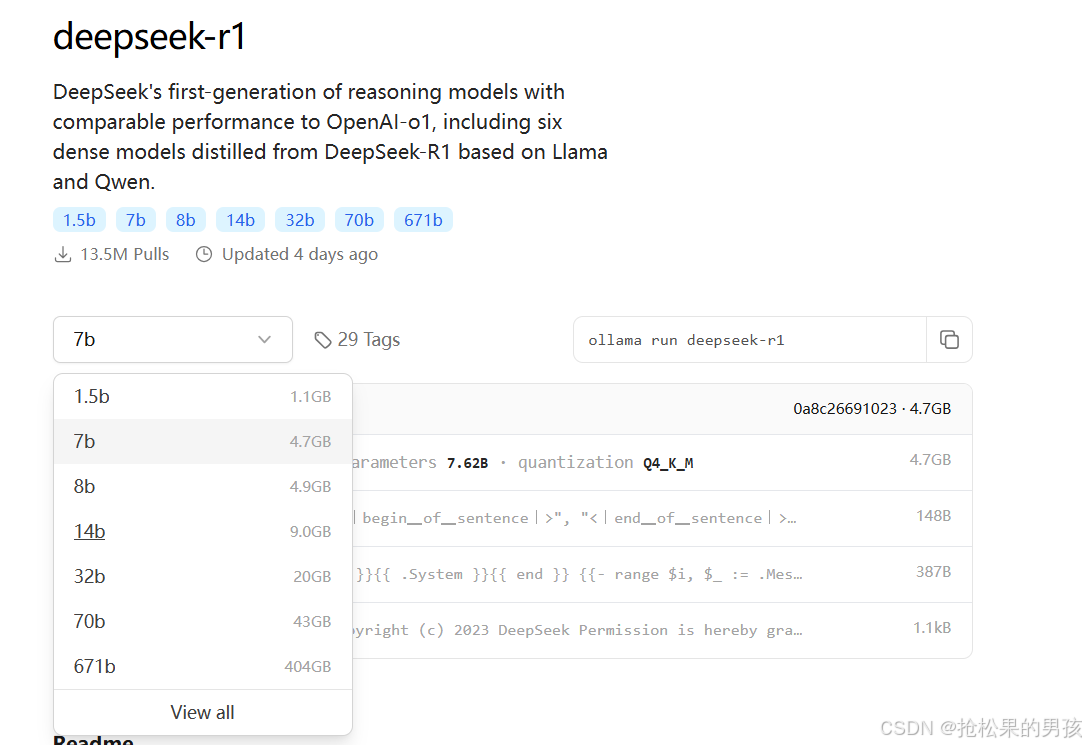

二、在Ollama官网https://ollama.com/search中找到自己想要的模型-此处以deepseek模型为例

根据上面的配置提示选择适合自己设备的模型,或者可以去百度查一下配置要求,我这里是4090显卡,内存16GB(用14b的时候风扇快把电脑吹上天了,响应超级慢,8b就很德芙🍫)

三、复制ollama run deepseek-r1:14b到CMD下,即可开始安装deepseek模型,安装完成后就可开始使用

四、图形化模式-安装chatbox

官网:https://chatboxai.app/zh

安装好后再设置里配置API接口(即占用的本地端口,deepseek默认11434),配置好后即可使用,不知道到端口的可以使用netstat -ano查一下端口占用,或者自行百度搜索。注意模型提供方选择OLLAMA API

测试后图形化有个缺点,响应时间比cmd下慢很多。。。。。不知道是不是自己电脑的问题

1966

1966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?