时间差分

背景

时间差分学习简称TD学习,和蒙特卡洛一样,他也从Episode学习,不需要了解模型本身,但是它可以学习不完整的Episode。

模型状态转移及奖励的情况下,学习不完整的轨迹,通过贝尔曼递推公式(自举的方法)求取值函数,获得最优解。。

优点:可在线实时学习,可学习不完整的轨迹。比较适用于控制工程。

同策略VS异策略

同策略:产生采样的策略和评估控制的策略是同一个策略。

异策略:产生采样的策略和评控制的策略是不同的策略。比较容易的从人类经验或其他个体的经验中学习,有人可以从一些旧的策略中学习,可以比较两份策略的优劣,其中可能也是最主要的原因就是遵循一个探索式策略的基础上优化现有得策略。

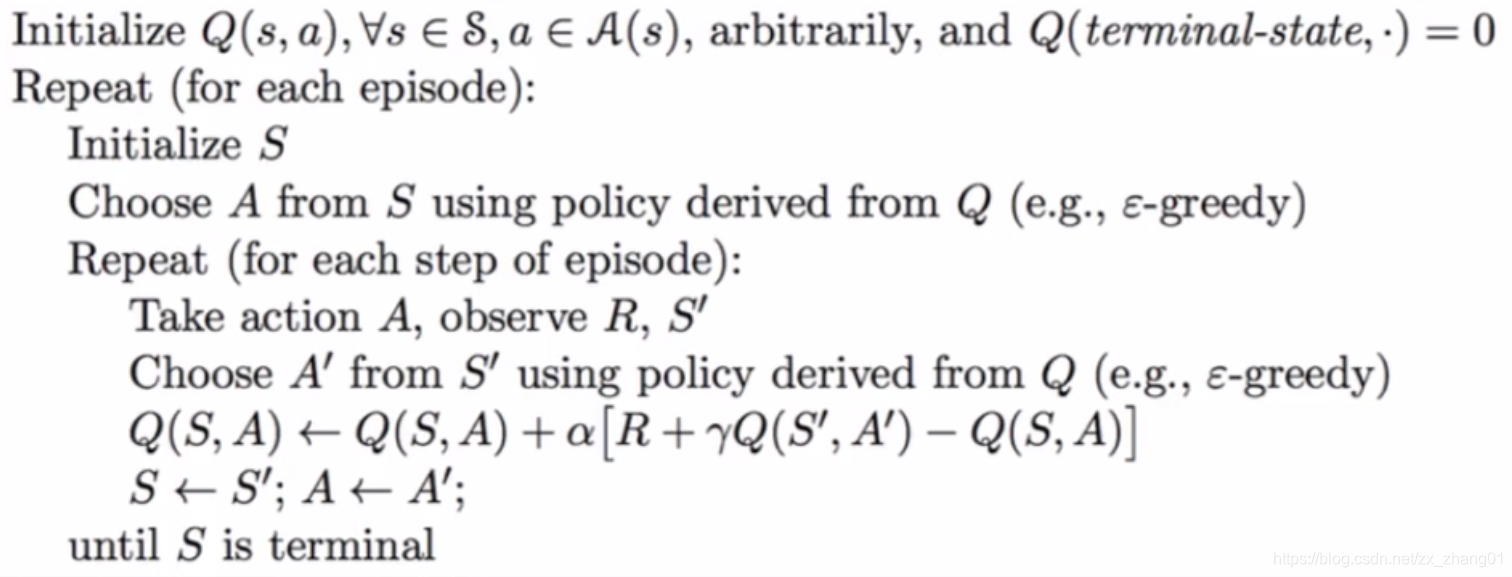

同策略时间差分:

算法步骤;

Step1:算法输入Initialize S,迭代次数 T,状态集合 S,动作集合 A,即初始化。

Step2.Choose A from S从当前状态下所选择的动作;

Step3.Take action A,observe R,S’,状态执行当前动作,得到新的状态 S’ 和新的奖励 R;

Step4:Q(S,A)←Q(S,A)+α[R+γmaxaQ(S′,a)−Q(S,A)];\begin{array}{l}{Q(S, A) \leftarrow Q(S, A)+\alpha\left[R+\gamma \max _{a} Q\left(S^{\prime}, a\right)-Q(S, A)\right]} ;

\end{array}Q(S,A)←Q(S,A)+α[R+γmaxaQ(S′,a)−Q(S,A)];更新价值函数;

Step5:S←S′S \leftarrow S^{\prime}

S←S′把下一个状态重新赋值一个新的状态。

910

910

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?