手撸代码:https://zhuanlan.zhihu.com/p/666471085?utm_id=0

1.1dropout

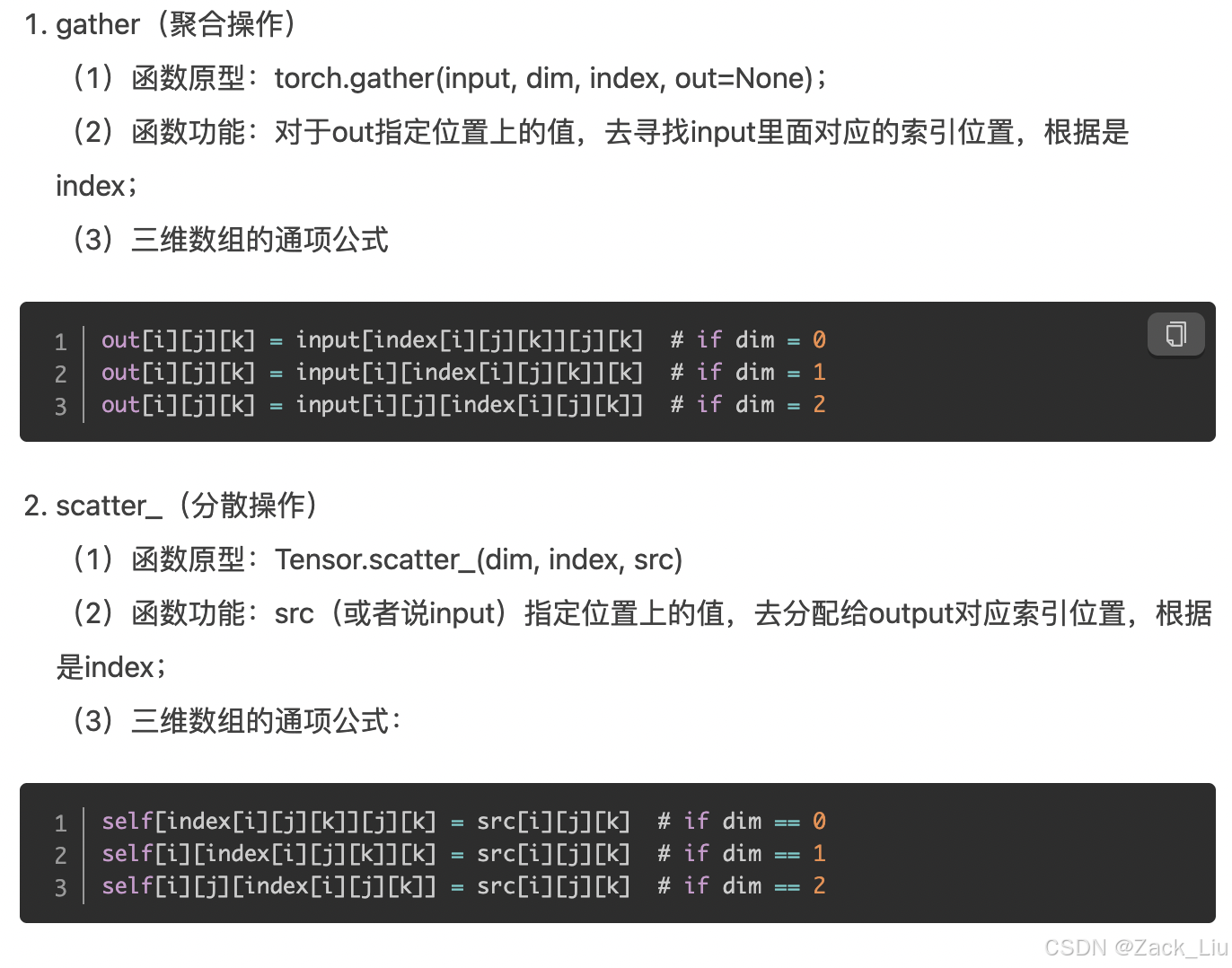

1.2 pytorch中gather和scatter_区别

1.3 pytorch中torch.Tensor()和torch.tensor()的相同点和区别

1.4 pytorch中train和eval有什么不同

(1). model.train()——训练时候启用

启用 BatchNormalization 和 Dropout,将BatchNormalization和Dropout置为True

(2). model.eval()——验证和测试时候启用

不启用 BatchNormalization 和 Dropout,将BatchNormalization和Dropout置为False

train模式会计算梯度,eval模式不会计算梯度。

1.5 减小模型内存的方法?

模型剪枝、模型蒸馏、模型量化、模型结构优化

2427

2427

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?