本文作者丁学文武,多年算法负责人,主要研究方向是大模型、智能体、RAG、ChatBI、微调、部署等。本文核心内容来自Gemma3官方论文。

论文地址:https://arxiv.org/abs/2507.18071

摘要翻译

本论文介绍了 Group Sequence Policy Optimization (GSPO),这是我们用于训练大语言模型的稳定、高效且性能卓越的强化学习算法。与之前采用token级重要性比率的算法不同,GSPO基于序列似然定义重要性比率,并执行序列级别的裁剪、奖励和优化。我们证明了GSPO相比GRPO算法实现了更优越的训练效率和性能,显著稳定了混合专家模型(MoE)的强化学习训练,并具有简化强化学习基础设施设计的潜力。GSPO的这些优点为最新的Qwen3模型带来了显著的改进。

1. 引言

强化学习(RL)已成为扩展语言模型的关键范式。通过大规模强化学习,语言模型能够通过进行更深入和更长的推理过程来解决复杂问题,如竞赛级数学和编程。

要成功地通过更大的计算投入来扩展强化学习,首要前提是保持稳定和robust的训练动态。然而,当前最先进的强化学习算法(如GRPO)在训练超大型语言模型时表现出严重的稳定性问题,经常导致灾难性且不可逆的模型崩溃。

在本论文中,我们识别出GRPO的不稳定性源于其算法设计中重要性采样权重的根本性误用和失效。这引入了高方差的训练噪声,随着响应长度的增加而逐渐累积,并被裁剪机制进一步放大,最终导致模型崩溃。

2. 预备知识

符号表示

-

自回归语言模型参数化为 θ,定义为策略 πθ

-

x 表示查询,D 表示查询集合

-

给定查询 x 的响应 y,其在策略 πθ 下的似然为:

πθ(y∣x)=∏t=1∣y∣πθ(yt∣x,y<t) π_θ(y|x) = \prod_{t=1}^{|y|} π_θ(y_t|x, y_{<t}) πθ(y∣x)=t=1∏∣y∣πθ(yt∣x,y<t)

-

查询-响应对 (x, y) 可以通过验证器 r 评分,得到奖励 r(x, y) ∈ [0, 1]

Proximal Policy Optimization (PPO)

PPO使用从旧策略 πθold 生成的样本,通过裁剪机制将策略更新限制在旧策略的近似区域内:

JPPO(θ)=Ex∼D,y∼πθold(⋅∣x)[1∣y∣∑t=1∣y∣min(wt(θ)A^t,clip(wt(θ),1−ε,1+ε)A^t)] J_{PPO}(θ) = E_{x∼D, y∼π_{θ_{old}}(·|x)} \left[ \frac{1}{|y|} \sum_{t=1}^{|y|} \min \left( w_t(θ)\hat{A}_t, \text{clip}(w_t(θ), 1-ε, 1+ε) \hat{A}_t \right) \right] JPPO(θ)=Ex∼D,y∼πθold(⋅∣x)∣y∣1t=1∑∣y∣min(wt(θ)A^t,clip(wt(θ),1−ε,1+ε)A^t)

其中重要性比率定义为:

wt(θ)=πθ(yt∣x,y<t)πθold(yt∣x,y<t) w_t(θ) = \frac{π_θ(y_t|x,y_{<t})}{π_{θ_{old}}(y_t|x,y_{<t})} wt(θ)=πθold(yt∣x,y<t)πθ(yt∣x,y<t)

PPO的核心挑战在于对价值模型的严重依赖,这引入了相当大的内存和计算负担。

Group Relative Policy Optimization (GRPO)

GRPO通过计算同一查询的多个响应组内每个响应的相对优势来绕过对价值模型的需求:

JGRPO(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)[1G∑i=1G1∣yi∣∑t=1∣yi∣min(wi,t(θ)A^i,t,clip(wi,t(θ),1−ε,1+ε)A^i,t)] J_{GRPO}(θ) = E_{x∼D, \{y_i\}_{i=1}^G∼π_{θ_{old}}(·|x)} \left[ \frac{1}{G} \sum_{i=1}^G \frac{1}{|y_i|} \sum_{t=1}^{|y_i|} \min \left( w_{i,t}(θ)\hat{A}_{i,t}, \text{clip}(w_{i,t}(θ), 1-ε, 1+ε) \hat{A}_{i,t} \right) \right] JGRPO(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)G1i=1∑G∣yi∣1t=1∑∣yi∣min(wi,t(θ)A^i,t,clip(wi,t(θ),1−ε,1+ε)A^i,t)

其中优势定义为:

A^i=r(x,yi)−mean{r(x,yi)}i=1Gstd{r(x,yi)}i=1G \hat{A}_i = \frac{r(x, y_i) - \text{mean}\{r(x, y_i)\}_{i=1}^G}{\text{std}\{r(x, y_i)\}_{i=1}^G} A^i=std{r(x,yi)}i=1Gr(x,yi)−mean{r(x,yi)}i=1G

3. 动机

模型规模、稀疏性(如MoE模型)和响应长度的增长需要大的rollout batch size来最大化强化学习期间的硬件利用率。为了提高样本效率,标准做法是将大批量rollout数据分割为多个mini-batch进行梯度更新。

这个过程不可避免地引入了off-policy学习设置,其中响应y是从旧策略πθold而不是当前正在优化的策略πθ中采样的。

GRPO的根本问题:其目标是ill-posed的。这个问题在训练大型模型处理长响应任务时变得特别严重,导致灾难性的模型崩溃。

重要性采样的原理是通过重新加权从行为分布πbeh抽取的样本来估计目标分布πtar下函数f的期望:

Ez∼πtar[f(z)]=Ez∼πbeh[πtar(z)πbeh(z)f(z)] E_{z∼π_{tar}}[f(z)] = E_{z∼π_{beh}} \left[ \frac{π_{tar}(z)}{π_{beh}(z)} f(z) \right] Ez∼πtar[f(z)]=Ez∼πbeh[πbeh(z)πtar(z)f(z)]

关键是,这依赖于从行为分布πbeh进行多次采样(N ≫ 1)的平均,重要性权重才能有效地校正分布不匹配。

相比之下,GRPO在每个token位置t应用重要性权重。由于这个权重基于每个next-token分布的单个样本,它无法执行预期的分布校正作用。相反,它向训练中引入了高方差噪声。

4. 算法

4.1 GSPO:Group Sequence Policy Optimization

虽然token级重要性权重在GRPO中存在问题,但我们观察到在语言生成的上下文中,序列级重要性权重 πθ(y|x)/πθold(y|x) 具有清晰的理论含义:它反映了从πθold(·|x)采样的响应y与πθ(·|x)的偏离程度。

基于这个直观观察,我们提出了Group Sequence Policy Optimization (GSPO)算法。GSPO采用以下序列级优化目标:

JGSPO(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)[1G∑i=1Gmin(si(θ)A^i,clip(si(θ),1−ε,1+ε)A^i)] J_{GSPO}(θ) = E_{x∼D, \{y_i\}_{i=1}^G∼π_{θ_{old}}(·|x)} \left[ \frac{1}{G} \sum_{i=1}^G \min \left( s_i(θ)\hat{A}_i, \text{clip}(s_i(θ), 1-ε, 1+ε) \hat{A}_i \right) \right] JGSPO(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)[G1i=1∑Gmin(si(θ)A^i,clip(si(θ),1−ε,1+ε)A^i)]

其中我们采用基于组的优势估计:

A^i=r(x,yi)−mean{r(x,yi)}i=1Gstd{r(x,yi)}i=1G \hat{A}_i = \frac{r(x, y_i) - \text{mean}\{r(x, y_i)\}_{i=1}^G}{\text{std}\{r(x, y_i)\}_{i=1}^G} A^i=std{r(x,yi)}i=1Gr(x,yi)−mean{r(x,yi)}i=1G

并基于序列似然定义重要性比率:

si(θ)=(πθ(yi∣x)πθold(yi∣x))1∣yi∣=exp(1∣yi∣∑t=1∣yi∣logπθ(yi,t∣x,yi,<t)πθold(yi,t∣x,yi,<t)) s_i(θ) = \left( \frac{π_θ(y_i|x)}{π_{θ_{old}}(y_i|x)} \right)^{\frac{1}{|y_i|}} = \exp \left( \frac{1}{|y_i|} \sum_{t=1}^{|y_i|} \log \frac{π_θ(y_{i,t}|x, y_{i,<t})}{π_{θ_{old}}(y_{i,t}|x, y_{i,<t})} \right) si(θ)=(πθold(yi∣x)πθ(yi∣x))∣yi∣1=exp∣yi∣1t=1∑∣yi∣logπθold(yi,t∣x,yi,<t)πθ(yi,t∣x,yi,<t)

因此,GSPO对整个响应而不是单个token应用裁剪,以排除过度"off-policy"的样本进行梯度估计,这与序列级奖励和优化都匹配。

4.2 梯度分析

GSPO目标的梯度可以推导如下:

∇θJGSPO(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)[1G∑i=1G(πθ(yi∣x)πθold(yi∣x))1∣yi∣A^i⋅1∣yi∣∑t=1∣yi∣∇θlogπθ(yi,t∣x,yi,<t)] ∇_θ J_{GSPO}(θ) = E_{x∼D, \{y_i\}_{i=1}^G∼π_{θ_{old}}(·|x)} \left[ \frac{1}{G} \sum_{i=1}^G \left( \frac{π_θ(y_i|x)}{π_{θ_{old}}(y_i|x)} \right)^{\frac{1}{|y_i|}} \hat{A}_i · \frac{1}{|y_i|} \sum_{t=1}^{|y_i|} ∇_θ \log π_θ(y_{i,t}|x, y_{i,<t}) \right] ∇θJGSPO(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)G1i=1∑G(πθold(yi∣x)πθ(yi∣x))∣yi∣1A^i⋅∣yi∣1t=1∑∣yi∣∇θlogπθ(yi,t∣x,yi,<t)

GSPO和GRPO之间的根本区别在于它们如何加权token的对数似然梯度。在GRPO中,token根据各自的"重要性权重"进行加权,这些不相等的权重可能导致不可预测的后果。相比之下,GSPO对响应中的所有token进行相等加权,消除了GRPO的这一不稳定因素。

4.3 GSPO-token:Token级目标变体

在多轮强化学习等场景中,我们可能希望比序列级更细粒度的优势调整。为此,我们引入了GSPO的token级目标变体,即GSPO-token:

JGSPO−token(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)[1G∑i=1G1∣yi∣∑t=1∣yi∣min(si,t(θ)A^i,t,clip(si,t(θ),1−ε,1+ε)A^i,t)] J_{GSPO-token}(θ) = E_{x∼D, \{y_i\}_{i=1}^G∼π_{θ_{old}}(·|x)} \left[ \frac{1}{G} \sum_{i=1}^G \frac{1}{|y_i|} \sum_{t=1}^{|y_i|} \min \left( s_{i,t}(θ)\hat{A}_{i,t}, \text{clip}(s_{i,t}(θ), 1-ε, 1+ε) \hat{A}_{i,t} \right) \right] JGSPO−token(θ)=Ex∼D,{yi}i=1G∼πθold(⋅∣x)G1i=1∑G∣yi∣1t=1∑∣yi∣min(si,t(θ)A^i,t,clip(si,t(θ),1−ε,1+ε)A^i,t)

5. 实验和讨论

5.1 实验结果

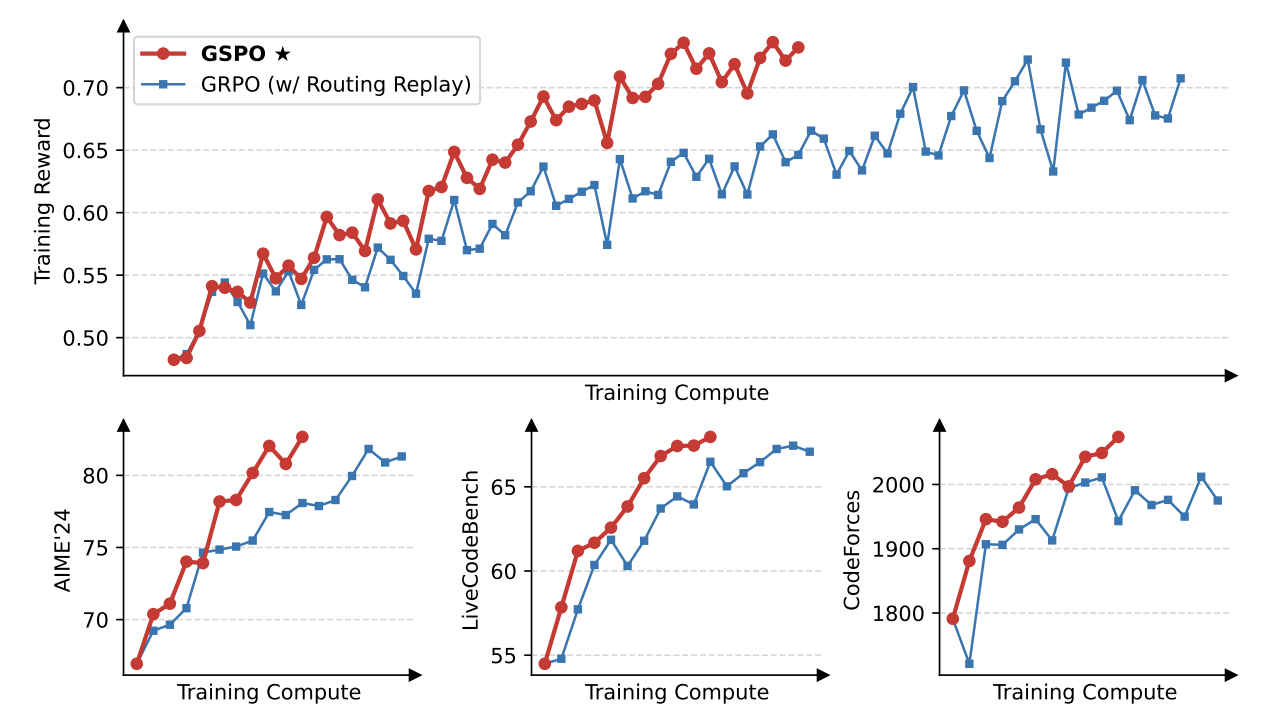

我们使用从Qwen3-30B-A3B-Base微调的冷启动模型进行实验,报告了训练奖励曲线以及在AIME’24、LiveCodeBench和CodeForces基准上的模型性能曲线。

实验结果显示:

- GSPO的训练进展始终稳定

- GSPO在相同的训练计算和消耗查询下实现了更好的训练准确性和基准性能

- GSPO已成功应用于最新Qwen3模型的强化学习训练

图1:GSPO相比GRPO具有显著更高的训练效率

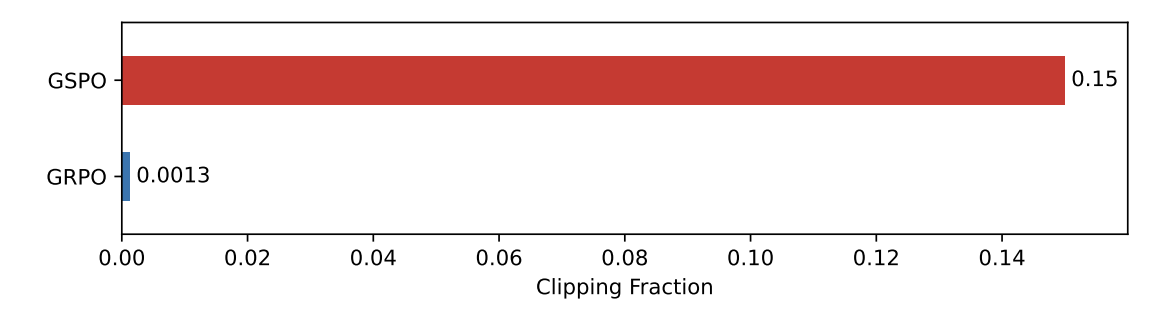

5.2 关于裁剪分数的有趣观察

GSPO相比GRPO的一个关键区别是它对整个响应而不是单个token进行裁剪。如图2所示,我们观察到GSPO和GRPO之间裁剪token分数相差两个数量级。

然而,尽管裁剪了更多token,GSPO仍然实现了比GRPO更高的训练效率。这个反直觉的发现进一步表明GRPO的token级梯度估计本质上是嘈杂和低效的。

5.3 GSPO对MoE训练的好处

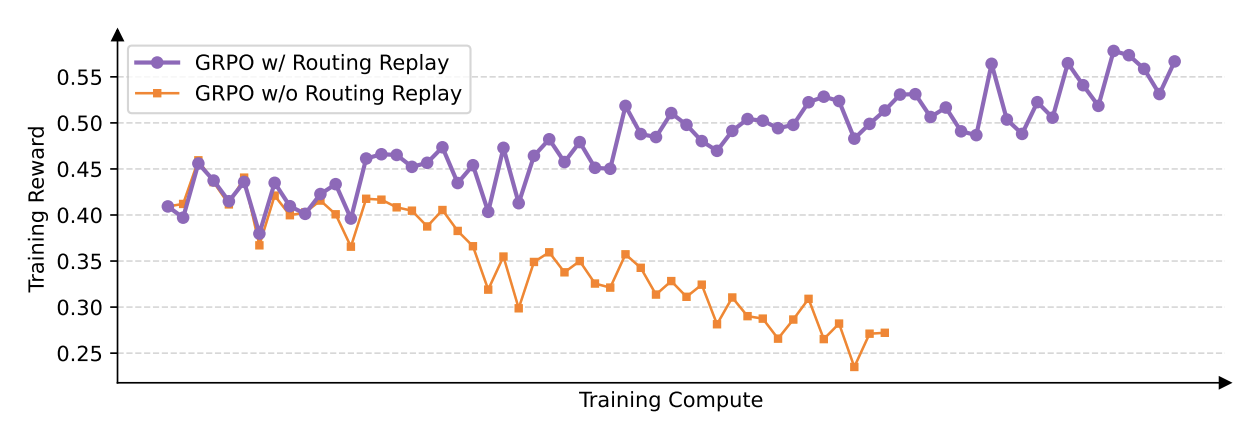

背景:相比密集模型的强化学习训练,MoE模型的稀疏激活特性引入了独特的稳定性挑战。我们发现当采用GRPO算法时,MoE模型的专家激活波动性可能阻止强化学习训练正常收敛。

我们之前的方法:为了解决这个挑战,我们之前采用了Routing Replay训练策略。具体来说,我们缓存πθold中激活的专家,并在计算重要性比率时在πθ中"重放"这些路由模式。

GSPO的好处:如图1所示,GSPO消除了对Routing Replay的依赖,完全能够常规地计算重要性比率、正常收敛和稳定优化。关键洞察是GSPO只关注序列似然,对单个token似然不敏感。

5.4 GSPO对强化学习基础设施的好处

由于训练引擎和推理引擎之间的精度差异,实际上我们通常使用训练引擎重新计算采样响应在旧策略πθold下的似然。然而,GSPO仅使用序列级而非token级似然进行优化,直观上前者对精度差异的容忍度更高。

因此,GSPO使得直接使用推理引擎返回的似然进行优化成为可能,从而避免了用训练引擎重新计算的需要。

6. 结论

我们提出了Group Sequence Policy Optimization (GSPO),一种用于训练大语言模型的新强化学习算法。遵循重要性采样的基本原理,GSPO基于序列似然定义重要性比率,并执行序列级裁剪、奖励和优化。

GSPO相比GRPO展现出显著优越的训练稳定性、效率和性能,对大规模MoE模型的强化学习训练表现出特别的效力,为最新Qwen3模型的卓越改进奠定了基础。

关键技术贡献

-

理论创新:识别出GRPO中token级重要性权重的根本问题,提出基于序列似然的重要性比率定义

-

算法设计:GSPO实现序列级裁剪和优化,与奖励的序列级特性保持一致

-

稳定性改进:解决了MoE模型训练中的专家激活波动问题,无需复杂的Routing Replay策略

-

实用价值:简化强化学习基础设施,提高训练效率和模型性能

这项工作为大规模语言模型的强化学习训练提供了更加稳定和高效的算法基础,是强化学习领域的重要理论和实践贡献。

2740

2740

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?