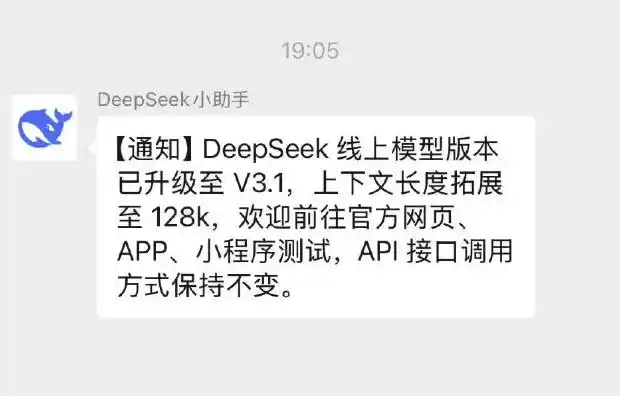

🔬 DeepSeek-V3.1 深度技术解析与全面指南

一、核心架构与技术升级

-

基于 Transformer 的演进:

- 延续 DeepSeek-V3 系列高效的纯解码器(Decoder-Only)Transformer 架构。

- 核心创新点集中在注意力机制优化与位置编码增强,使其能高效处理超长上下文。

- 未进行大规模架构重构,保证了与 V3 系列的兼容性和升级平滑性。

-

128K 上下文窗口的实现:

- 关键技术: 采用分块注意力(Grouped Query Attention, GQA) 或优化版的滑动窗口注意力(Sliding Window Attention) 结合高效的 KV Cache 管理策略。这大幅降低了处理超长序列时的显存占用和计算复杂度。

- 位置编码优化: 对 RoPE (Rotary Position Embedding) 等位置编码进行针对性改进,确保模型在超长距离下仍能有效捕捉位置关系,减少信息衰减。

- 长上下文训练: 在原有高质量预训练数据基础上,引入了大量精心构建的长文档(书籍、技术手册、法律条文、长对话剧本、大型代码库片段)和长序列任务数据进行增量预训练(Continued Pre-training) 和监督微调(SFT) ,显著提升对长依赖关系的建模能力。

- 窗口外信息遗忘控制: 通过训练技巧减少模型在处理超长文本时对窗口开头信息的遗忘程度。

-

性能与效率优化:

- 推理速度: 在典型硬件(如 A100/A10 GPU)上,处理中等长度输入时,生成速度稳定在约 60 tokens/秒 左右(实际速度受输入长度、输出长度、硬件、批次大小等因素影响)。

- 吞吐量(Throughput): 优化了计算内核和批处理能力,在 API 和私有化部署场景下支持更高的并发请求处理能力。

- 显存效率: 通过 Flash Attention-v2(或类似优化)和前述的注意力机制改进,有效控制了处理 128K 上下文所需的显存增长斜率。

- 量化支持: 官方提供或社区维护的 GPTQ/AWQ 量化方案(如 INT4/INT8)可用于减小模型体积、降低显存消耗、提升推理速度,适用于资源受限的边缘部署或成本敏感场景(量化后精度会有可控损失)。

-

能力提升与“幻觉”抑制:

- 长文档理解与推理:

- 提升了对跨页面、跨章节信息的关联、总结、问答能力。

- 在复杂逻辑链条、多步骤推理任务(如数学证明、法律条款推导、大型系统调试)中表现更稳健连贯。

- 长文档理解与推理:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

577

577

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?