目录

一、算法开启智能之门

在当今这个科技飞速发展的时代,人工智能早已不再是科幻作品里遥不可及的概念,而是如同一股无形却强大的力量,深度融入到我们生活的每一个角落。清晨,当你在手机上查看天气预报,背后可能是人工智能通过对海量气象数据的分析预测;上班途中,智能交通系统借助人工智能优化信号灯时长,缓解拥堵;到了办公室,智能办公软件帮你处理繁琐的文档排版和数据整理;回到家中,智能音箱能精准识别你的语音指令,播放想听的音乐、查询信息。

在医疗领域,人工智能可以通过分析医学影像,辅助医生更精准地诊断疾病,甚至预测疾病的发展趋势;金融行业里,它能快速处理大量交易数据,进行风险评估和智能投资决策;教育方面,人工智能实现了个性化学习,根据每个学生的学习进度和特点提供定制化的学习方案。

人工智能如此神通广大,其背后的核心驱动力究竟是什么呢?答案就是学习算法。学习算法就像是人工智能的 “大脑”,赋予机器从数据中学习、归纳和做出决策的能力,让它们能够在不断的 “学习” 中变得越来越 “聪明”。接下来,就让我们一同走进人工智能学习算法的奇妙世界,揭开它神秘的面纱。

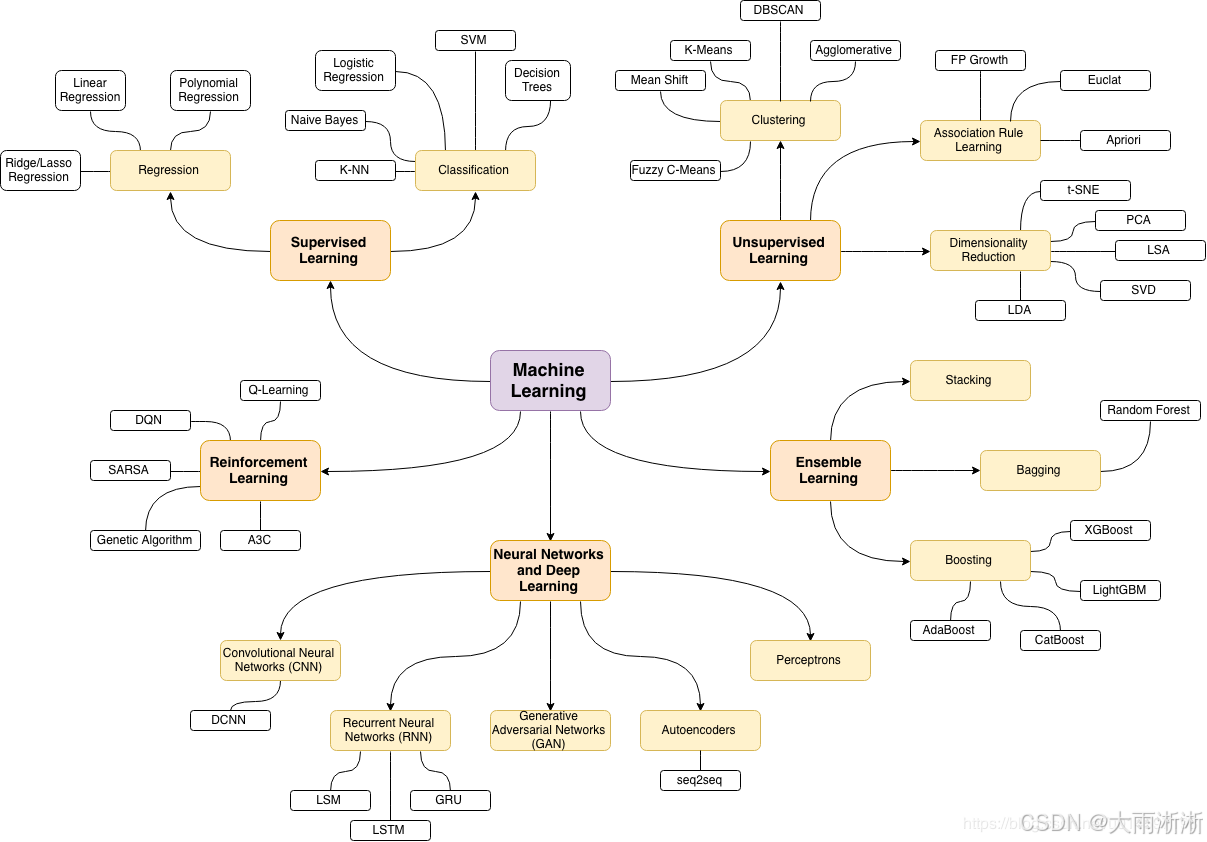

二、机器学习算法家族

机器学习算法如同一个庞大而多元的家族,成员众多,各有所长。根据学习方式和目标的不同,这个家族大致可以分为监督学习、无监督学习和强化学习三大分支,每个分支又包含了许多经典且实用的算法。

2.1 监督学习:有导师的学习之路

监督学习就像是有一位经验丰富的导师在旁指导的学习过程。在这个过程中,算法会使用一组已知输入和对应输出(标签)的训练数据来构建模型。简单来说,就是给算法提供一系列带有正确答案的练习题,让它通过学习这些例题,掌握其中的规律和模式,从而能够对新的、未知的数据进行准确的预测和分类。

线性回归是监督学习中最基础的算法之一,它试图找到一条最佳的直线(或超平面),来描述自变量(输入特征)和因变量(输出标签)之间的线性关系。例如,在预测房价的场景中,我们可以将房屋的面积、房间数量、房龄等作为自变量,房价作为因变量。线性回归算法通过对大量房屋数据的学习,找到这些因素与房价之间的线性关系,从而可以根据新房屋的特征预测其价格。它的优点是简单易懂、计算效率高,结果具有可解释性,我们可以直观地看出每个特征对房价的影响程度。但它也有局限性,只能处理线性关系的数据,如果实际数据存在复杂的非线性关系,线性回归的预测效果就会大打折扣 ,并且对异常值比较敏感,一个或几个异常数据点可能会对最终的回归直线产生较大影响,导致预测偏差。

逻辑回归虽然名字里有 “回归”,但它实际上是一种用于解决二分类问题的算法。它的原理是通过一个 Sigmoid 函数,将线性回归的输出结果映射到 0 到 1 之间的概率值,以此来判断样本属于某个类别的可能性。比如在判断一封邮件是否为垃圾邮件时,逻辑回归模型会根据邮件的内容特征(如关键词出现频率、发件人信息等)计算出它是垃圾邮件的概率,如果概率大于设定的阈值(通常为 0.5),就判定为垃圾邮件,否则为正常邮件。逻辑回归计算开销低,模型可解释性强,我们可以通过查看各个特征对应的系数,了解它们对分类结果的影响方向和程度。不过,它仅适用于线性可分的二分类问题,对于非线性分类问题需要进行复杂的变换或特征工程,而且对噪声数据比较敏感,容易受到干扰。

决策树则是一种基于树形结构的分类和回归模型。它的构建过程就像是在做一系列的决策,从根节点开始,对数据的某个特征进行测试,根据测试结果将数据划分到不同的子节点,如此递归地进行下去,直到叶节点,每个叶节点都对应一个类别标签。以预测客户是否会购买某产品为例,决策树可能会先根据客户的年龄进行划分,如果年龄大于 30 岁,再看客户的收入水平,通过不断地对不同特征进行判断和划分,最终得出客户是否会购买的结论。决策树的优点非常直观易懂,可视化强,我们可以清晰地看到模型是如何做出决策的 。但它也容易出现过拟合的问题,即模型过于复杂,对训练数据的细节和噪声过度学习,导致在新数据上的泛化能力较差。为了解决这个问题,通常会采用剪枝等方法对决策树进行优化,或者使用随机森林等集成学习算法。

2.2 无监督学习:探索未知的结构

无监督学习与监督学习不同,它面对的是没有标签的数据,就像是在一片未知的领域中独自探索,寻找其中潜在的结构和模式。无监督学习算法的目标是发现数据中的自然分组(聚类)、数据的主要特征(降维)或数据的分布规律等。

K-means 聚类是无监督学习中最常用的聚类算法之一。它的基本思想是将数据集中的样本划分成 K 个不同的簇,使得同一簇内的样本相似度较高,而不同簇之间的样本相似度较低。具体实现时,首先会随机选择 K 个初始聚类中心,然后计算每个样本到这些中心的距离,将样本分配到距离最近的中心所在的簇中。接着,重新计算每个簇的中心,即该簇内所有样本的均值,再按照新的中心重新分配样本,如此反复迭代,直到聚类中心不再发生变化或者变化非常小为止。在客户细分领域,企业可以根据客户的消费行为、购买频率、消费金额等数据,使用 K-means 聚类算法将客户分为不同的群体,针对每个群体制定个性化的营销策略,提高营销效果和客户满意度。K-means 算法简单易实现,计算复杂度低,对大规模数据集有较好的可扩展性。然而,它需要预先指定簇的个数 K,而 K 值的选择往往比较困难,不同的 K 值可能会导致不同的聚类结果;并且对初始簇中心的选择比较敏感,如果初始中心选择不当,可能会收敛到局部最优解,而不是全局最优解 。

主成分分析(PCA)是一种常用的降维算法,它的主要作用是将高维数据转换为低维数据,同时尽可能保留数据的主要特征和信息。在实际应用中,数据往往具有多个特征,这些特征之间可能存在一定的相关性,而且有些特征可能对数据的主要结构贡献较小。PCA 通过线性变换,将原始数据转换到一组新的正交基上,这些新的基被称为主成分。主成分按照方差从大到小排列,方差越大表示该主成分包含的信息越多。我们可以选择前几个方差较大的主成分来代表原始数据,从而实现降维的目的。比如在图像压缩领域,一幅图像通常包含大量的像素点,每个像素点又有多个颜色通道,数据量非常大。使用 PCA 可以将图像数据的维度降低,去除冗余信息,在不影响图像主要视觉特征的前提下,大大减少存储空间和传输带宽。PCA 是一种无参数的方法,不需要预先知道数据的类别信息,并且能够有效地

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

15万+

15万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?