亲爱的秃头战友们,今天来聊聊如何让MATLAB丝滑接入deepseek!

想象一下:以前你调个参,咖啡续命到天明,现在把DeepSeek一接——好家伙,矩阵跑得比食堂开饭还快,论文配图自己蹦迪,连误差曲线都学会了自我PUA!

从此科研圈黑话更新:

“你肝了几组数据?”

“没肝,我和DeepSeek开了把双排。”

直接上步骤!

1、安装 Ollama

Ollama 是一个可以让你使用并管理 AI 模型的工具,相当于 R1 的承载器具,因此我们在本地部署模型前必须先安装 Ollama。

打开 「Ollama 官网:」https://ollama.com/,点击“Download”。

选择适合你电脑的版本,例如“「Windows」”点击“「Download for Windows」”。

下载后,无脑点击 Install 即可。

2、下载并部署 DeepSeek R1

打开你的CMD窗口,输入:

ollama run deepseek-r1:7b当然,如果你的电脑配置够高,整个14b的也可以!把上面的7改成14即可!

「DeepSeek R1」 详细硬件要求:此表列出了每种模型最低的硬件要求。

模型型号 | CPU | 内存 | 硬盘 | 显存 | 适用场景 |

|---|---|---|---|---|---|

DeepSeek-R1-1.5B | 4 核 | 8 GB+ | 3 GB+ | 非必需(若需 CPU 加速可选 GTX 1650) | 个人使用,如笔记本电脑、台式电脑等 |

DeepSeek-R1-7B | 8 核 | 16 GB+ | 8 GB+ | 8 GB+显存(如 RTX 3070/4060) | 中小型企业本地开发 |

DeepSeek-R1-8B | 8 核(需略高于 7B 10%-20%) | 16 GB+ | 8 GB+ | 8 GB+显存 | 中小型企业本地开发(提升精度的轻量级任务) |

DeepSeek-R1-14B | 12 核 | 32 GB+ | 15 GB+ | 16 GB+显存(如RTX 4090 或 A5000) | 中小型企业本地开发(中量级任务) |

DeepSeek-R1-32B | 16 核 | 64 GB+ | 30 GB+ | 24 GB+显存(如 A100 40 GB 或 RTX 3090) | 专业领域任务,如医疗、科研、法律 |

DeepSeek-R1-70B | 32 核 | 128 GB+ | 70 GB+ | 多卡并行(如 2x A100 80GB 或 4x RTX 4090) | 大型企业或科研机构,专业领域任务处理 |

DeepSeek-R1-671B(满血版) | 64 核 | 512 GB+ | 300 GB+ | 多卡并行(如 8x A100/H100) | 国家级科研任务处理 |

在cmd窗口输入后,开始部署!出现success表示成功!

3、安装 MATLAB大语言模型工具箱

l链接:https://ww2.mathworks.cn/matlabcentral/fileexchange/163796-large-language-models-llms-with-matlab

点击下载即可,没有mathwork账号的童鞋,用qq邮箱随便注册一个即可,免费的哈!

下载好后,得到这个样一个压缩包:

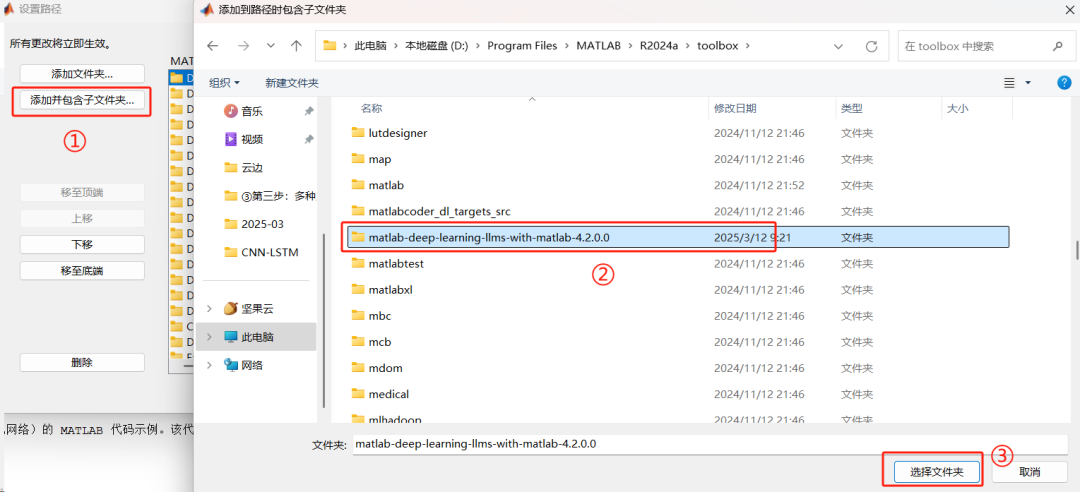

解压缩一下,并将解压缩后的文件夹,复制到你的MATLAB根目录下的toolbox,比如我的文件路径为D:\Program Files\MATLAB\R2024a\toolbox

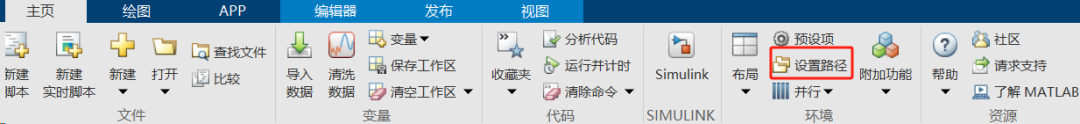

然后打开matlab,点设置路径,点添加并包含子文件夹。

最后点个保存!

4、开始在matlab使用!

安装就这样完成了。现在让我们在 MATLAB 中开始使用它!

对了提醒一下:在使用的过程中,上面的那个CMD窗口不能关掉哦!也就是你下次开关机还想用的话,就先打开cmd,在CMD输入以下指令先运行起来大模型。

ollama run deepseek-r1:7b接下来 在MATLAB中畅快操作吧!代码如下:

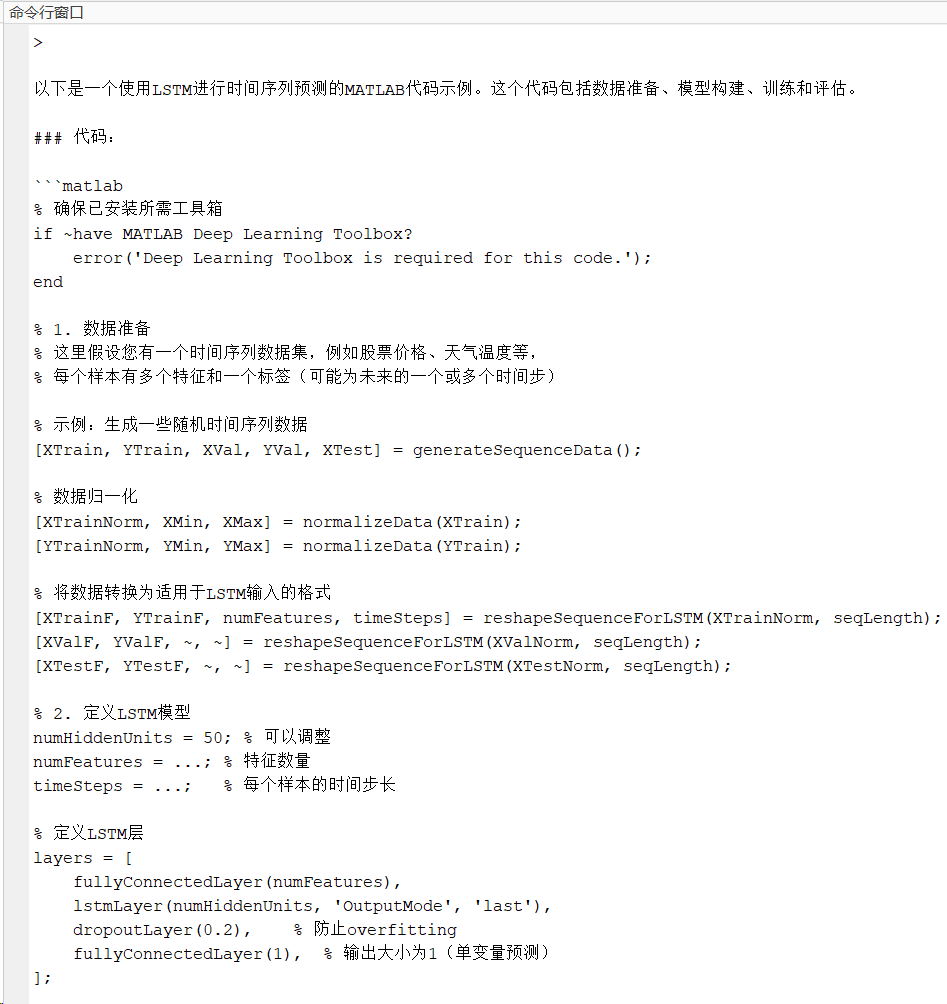

clc %清空命令行窗口clear%% 调用deepseek-R1 7b模型chat=ollamaChat("deepseek-r1:7b"); % 调取模型,如果你是14b请改成14text= generate(chat,"帮我写一个关于LSTM预测的MATLAB代码"); %提问问题text=char(text); %转换为字符串格式

%% 将思考推理的过程删除掉[a,b] = regexp(text,'</think>'); %将思考推理的过程删除掉temp=text(b:end); disp(temp) %打印出来在命令行窗口输出如下结果:

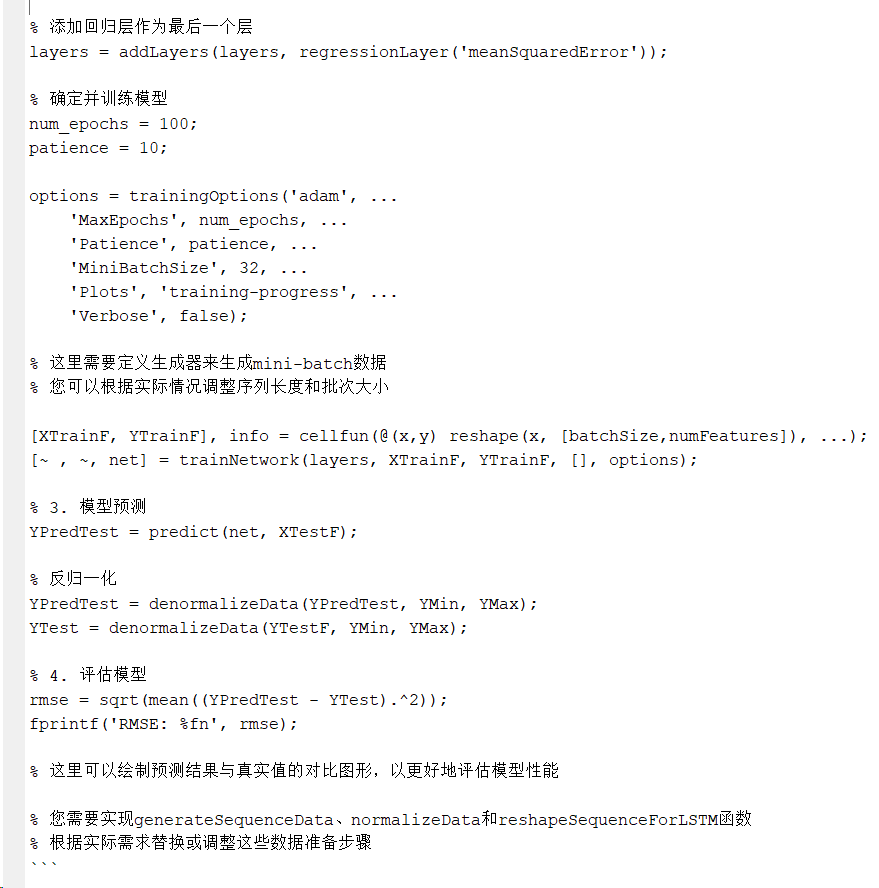

以上只是7b模型的一个输出结果,所以肯定不能直接用,但是回答也相当满意了!

再来个问题!

text= generate(chat,"帮我写一个科研顺利祝福词"); %提问问题[a,b] = regexp(text,'</think>'); %将思考推理的过程删除掉temp=text(b:end); wordcloud(temp) %词云(Word Cloud)可视化文本中单词的频率结果:

结语

让我们一起愉快的摸鱼吧!

获取更多代码:

或者复制链接跳转:https://docs.qq.com/sheet/DU3NjYkF5TWdFUnpu

19万+

19万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?