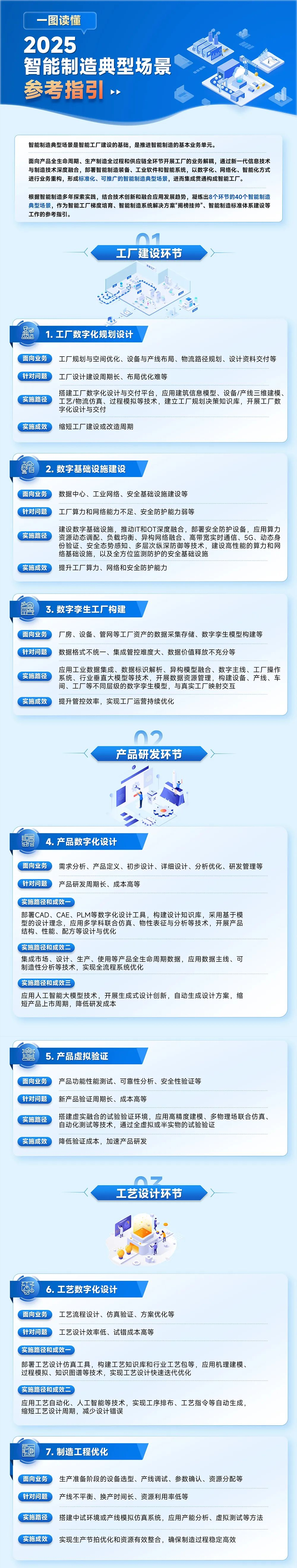

《智能制造典型场景参考指引(2025年版)》是为落实国务院办公厅印发的《制造业数字化转型行动方案》部署,按照《“十四五”智能制造发展规划》任务要求,打造智能制造“升级版”,结合智能制造最新实践和发展趋势,工业和信息化部组织编制的指引。由工业和信息化部办公厅于2025年4月19日印发。

《智能制造典型场景参考指引(2025年版)》该文件是一个13页的详细指导文件。可私有颜有货公号,小编将会提供PDF文件免费让大家下载学习。

除了详细的指导文件,还有清晰明了的“一图读懂”值得大家转发+收藏,认真阅读参考。

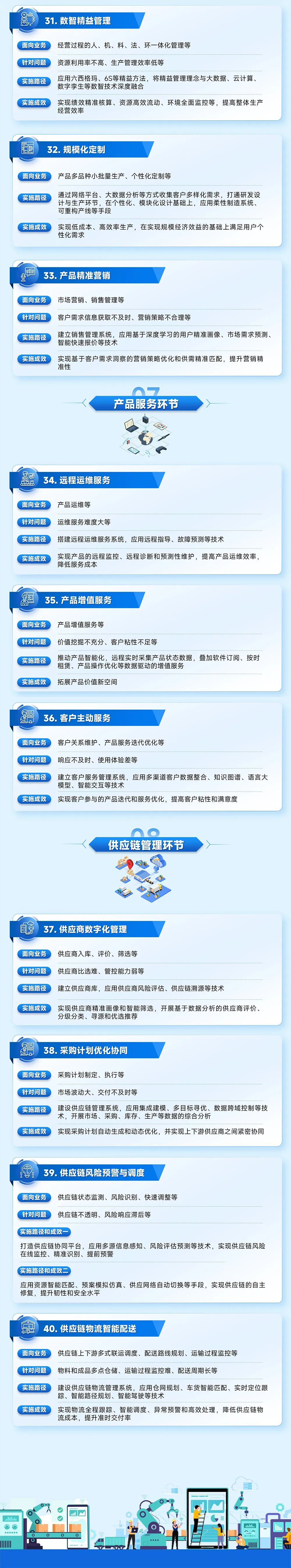

从工厂建设、产品研发、工艺设计到生产管理、作业、运营管理、服务、供应链...

共计凝练出8个环节40个智能制造典型场景,是一份绝对权威的参考指南!

该文件还涵盖了:

一、工厂建设环节

1. 工厂数字化规划设计

面向工厂规划与空间优化、设备与产线布局、物流路径规划、设计资料交付等业务活动,针对工厂设计建设周期长、布局优化难等问题,搭建工厂数字化设计与交付平台,应用建筑信息模型、设备/产线三维建模、工艺/物流仿真、过程模拟等技术,建立工厂规划决策知识库,开展工厂数字化设计与交付,缩短工厂建设或改造周期。

2.数字基础设施建设

面向数据中心、工业网络、安全基础设施建设等业务活动,针对工厂算力和网络能力不足、安全防护能力弱等问题,建设数字基础设施,推动IT和OT深度融合,部署安全防护设备,应用算力资源动态调配、负载均衡、异构网络融合、高带宽实时通信、5G、动态身份验证、安全态势感知、多层次纵深防御等技术,建设高性能的算力和网络基础设施,以及全方位监测防护的安全基础设施,提升工厂算力、网络和安全防护能力。

3.数字孪生工厂构建

面向厂房、设备、管网等工厂资产的数据采集存储、数字孪生模型构建等业务活动,针对数据格式不统一、集成管控难度大、数据价值释放不充分等问题,应用工业数据集成、数据标识解析、异构模型融合、数字主线、工厂操作系统、行业垂直大模型等技术,开展数据资源管理,构建设备、产线、车间、工厂等不同层级的数字孪生模型,与真实工厂映射交互,提升管控效率,实现工厂运营持续优化。

二、产品研发环节

4.产品数字化设计

面向需求分析、产品定义、初步设计、详细设计、分析优化、研发管理等业务活动,针对产品研发周期长、成本高等问题,部署CAD、CAE、PLM等数字化设计工具,构建设计知识库,采用基于模型的设计理念,应用多学科联合仿真、物性表征与分析等技术,开展产品结构、性能、配方等设计与优化;集成市场、设计、生产、使用等产品全生命周期数据,应用数据主线、可制造性分析等技术,实现全流程系统优化;应用人工智能大模型技术,开展生成式设计创新,自动生成设计方案,缩短产品上市周期,降低研发成本。

5.产品虚拟验证

面向产品功能性能测试、可靠性分析、安全性验证等业务活动,针对新产品验证周期长、成本高等问题,搭建虚实融合的试验验证环境,应用高精度建模、多物理场联合仿真、自动化测试等技术,通过全虚拟或半实物的试验验证,降低验证成本,加速产品研发。

三、工艺设计环节

6.工艺数字化设计

面向工艺流程设计、仿真验证、方案优化等业务活动,针对工艺设计效率低、试错成本高等问题,部署工艺设计仿真工具,构建工艺知识库和行业工艺包等,应用机理建模、过程模拟、知识图谱等技术,实现工艺设计快速迭代优化;应用工艺自动化、人工智能等技术,实现工序排布、工艺指令等自动生成,缩短工艺设计周期,减少设计错误。

3111

3111

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?