下文的格式就是:网址+内容介绍,比较个人向,自己想做小目标的旋转目标检测。那让我们开始吧!

https://github.com/iscyy/yoloair

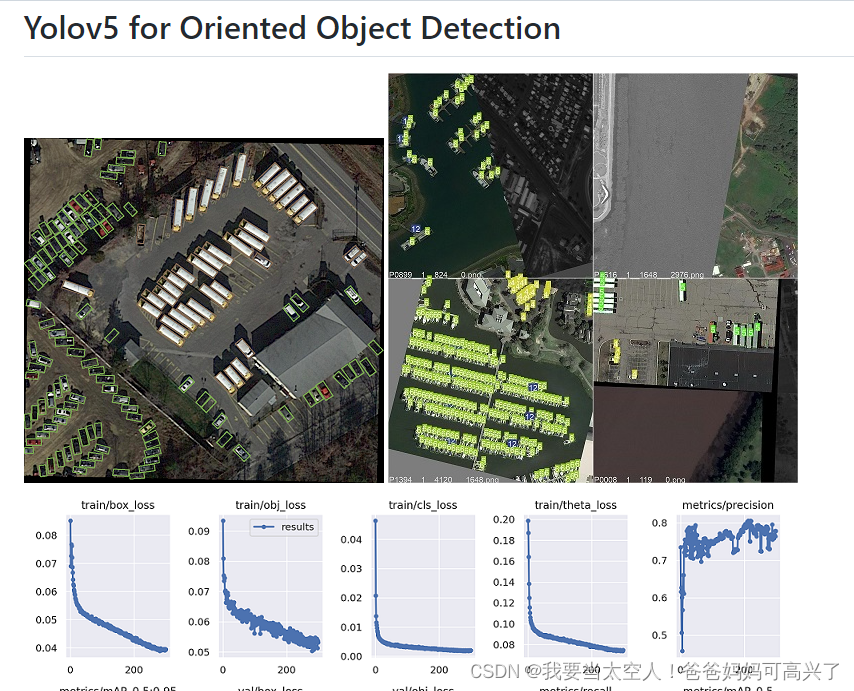

https://github.com/hukaixuan19970627/yolov5_obb

https://github.com/open-mmlab/mmrotate

下面这个是yyds!基本你想到的方法都有了,同时也在持续更新!

https://github.com/hoya012/deep_learning_object_detection

目标检测的论文集,按照时间顺序总结,截止至2020年全部

https://github.com/amusi/awesome-object-detection

目标检测的代码全集,按照时间顺序总结,各种经典的和不经典的都有。但也只是到2019年之前.

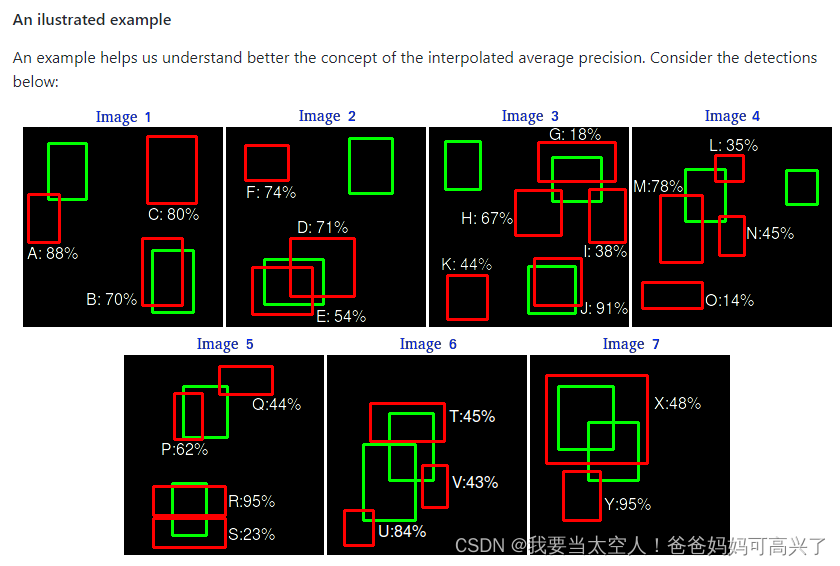

用来评价模型的预测结果的!Evaluate!

比如:

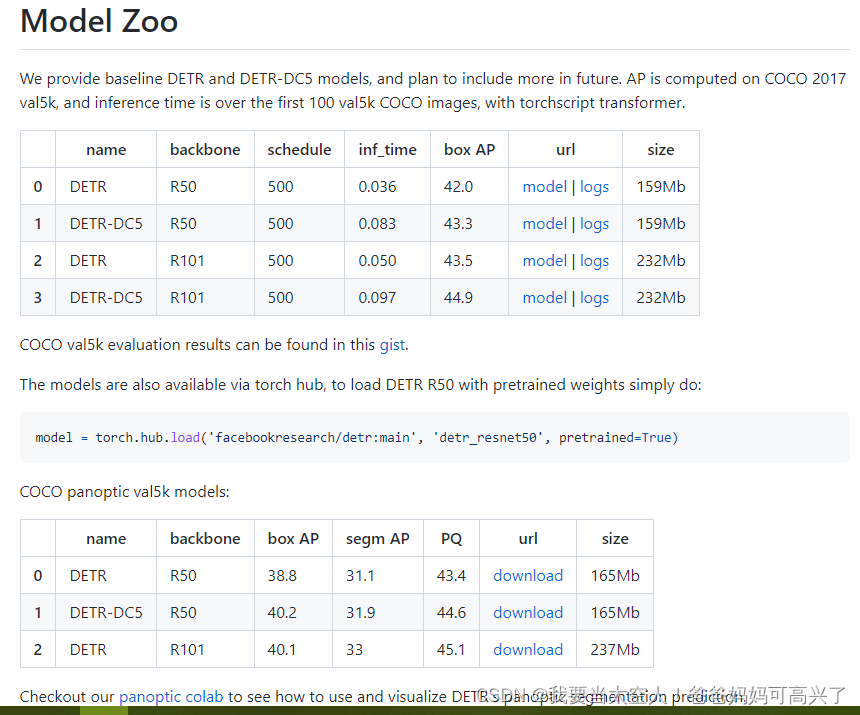

https://github.com/facebookresearch/detr

DETR

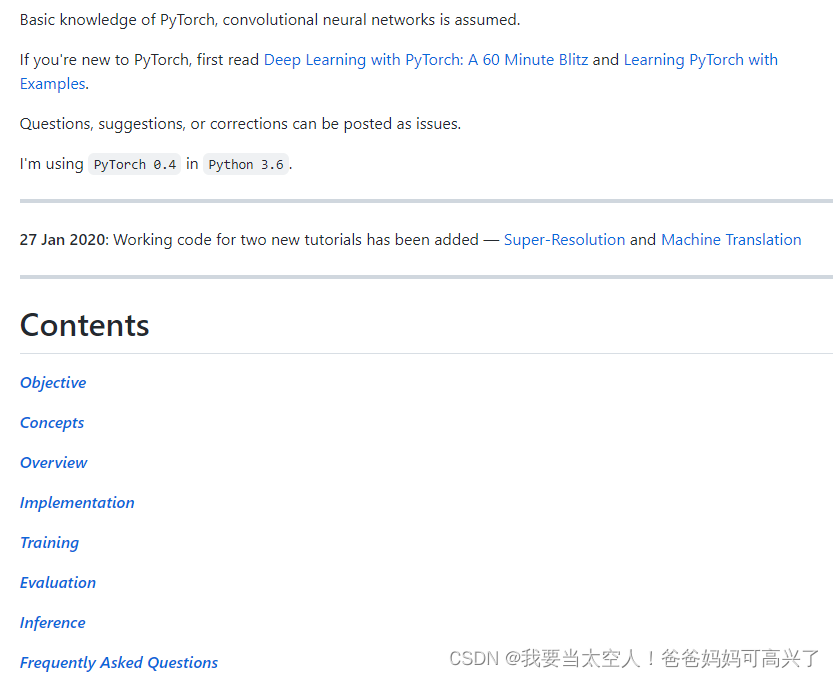

https://github.com/sgrvinod/a-PyTorch-Tutorial-to-Object-Detection

基础知识讲解,也可以跑通代码。

https://github.com/Paperspace/DataAugmentationForObjectDetection

数据增强的代码(旋转缩放对称)

https://github.com/kuanhungchen/awesome-tiny-object-detection

!!!小目标检测终于来了!!!!!!!!!!!!!但这个是论文集,不是代码集或者包

https://github.com/huggingface/transformers/blob/main/README_zh-hans.md

大名鼎鼎的Transformer,这个包可以调用Deformable DETR

https://github.com/ZhangGongjie/SAM-DETR

https://github.com/fundamentalvision/Deformable-DETR

上面两个DETR的变种都对CUDA和GCC有要求。所以不是很能跑通。

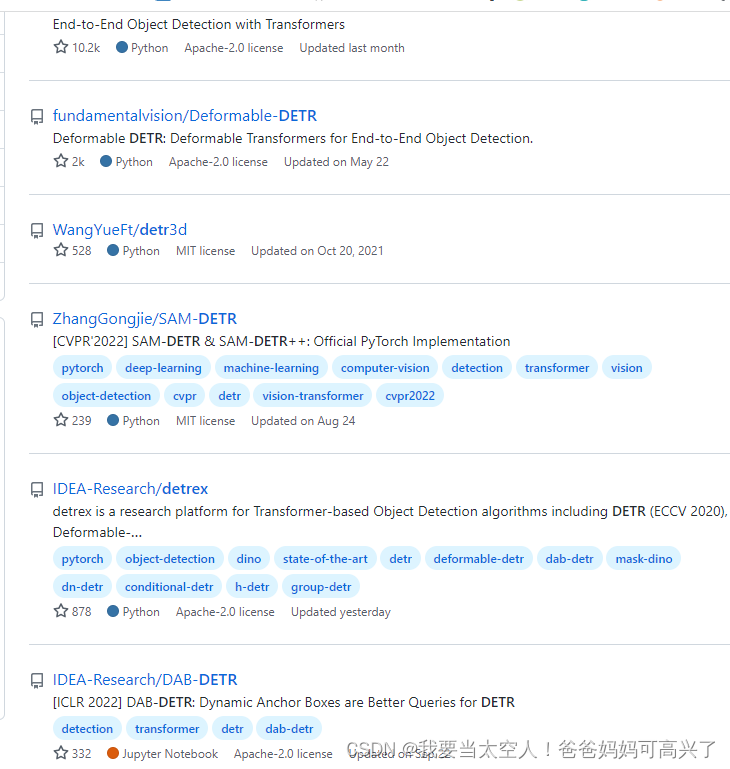

这些是DETR的搜索结果

这些是DETR的搜索结果

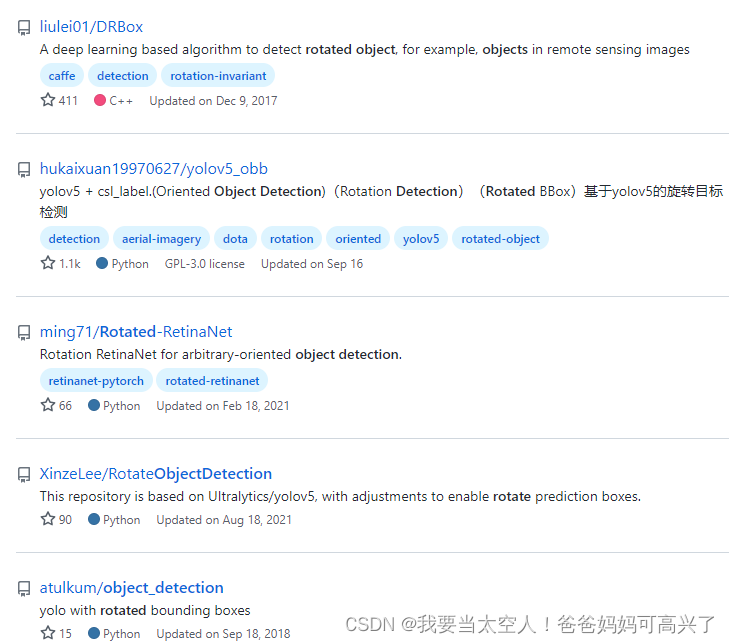

这些是旋转目标检测的搜索结果

https://github.com/lee-gwang/yolov7_obb

https://github.com/SSTato/YOLOv7_obb

这两个都是yolov7旋转目标检测

本文汇总了一系列关于旋转目标检测的开源项目及论文资源,包括基于YOLO的不同版本实现、MMDetection扩展项目MMRotate等,并提供了目标检测领域的论文集及代码集合。

本文汇总了一系列关于旋转目标检测的开源项目及论文资源,包括基于YOLO的不同版本实现、MMDetection扩展项目MMRotate等,并提供了目标检测领域的论文集及代码集合。

818

818

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?