矩阵论的总结

矩阵可以理解为线性空间的元素

矩阵可以理解为线性映射

矩阵的逆(线性映射的反函数)

矩阵行列式值(线性变换前后体积比)

矩阵的秩(线性映射生成域的维度)

矩阵的特征向量(线性映射正交分解的正交基)

矩阵的特征值(线性映射正交分解的系数)

为什么机器学习需要线性代数?

因为机器学习本质是优化问题,优化问题需要矩阵计算

什么是NPhard问题?

算法复杂度是指数增长,无法穷举所有可能的问题

向量可以表示文本

向量可以表示图片

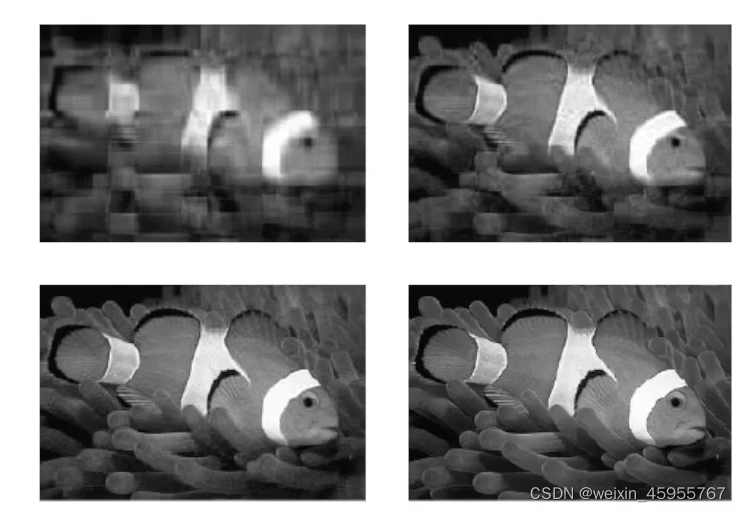

SVD奇异值分解:用于图像压缩

用向量表示时间序列

线性生成空间

向量的所有线性组合的集合称为向量的线性生成空间

空间维度

空间维度是基的数量决定的

范数:向量到长度的映射

正定性:向量的范数一定大于0,当且只有向量为0向量范数才是0

矩阵:可以理解为折叠的向量;更常见的理解是向量到向量的线性映射

如何理解矩阵是个线性函数

矩阵是线性映射,映射等价于函数,矩阵是个线性函数

函数存在一些展开(比如泰勒展开),矩阵也存在基用于展开,这就是特征值和特征向量问题

行列式的值的物理意义

如何理解矩阵的逆

矩阵是个线性函数,矩阵的逆就是反函数

矩阵的秩就是非0特征值的个数

如何解释行秩一定会和列秩相等

线性回归问题

矩阵求导

矩阵相似不变量:行列式的值是不变的,迹是不变的,特征值是不变的

如何理解矩阵相似变换中行列式的值是不变的?

相似变换采取的是同一种变换在不同基下的表达,既然是同种变换 行列式的值肯定是不变的

本文概述了矩阵在机器学习中的关键作用,从线性空间和映射概念,到逆矩阵、行列式、秩、特征值和向量的运用。探讨了为何线性代数对优化问题至关重要,以及NPhard问题的概念。通过实例解析了向量表示文本、图片和时间序列的方法,如SVD在图像压缩中的应用。此外,还解释了矩阵的逆、相似变换中的不变量和线性回归问题,以及矩阵求导的基本概念。

本文概述了矩阵在机器学习中的关键作用,从线性空间和映射概念,到逆矩阵、行列式、秩、特征值和向量的运用。探讨了为何线性代数对优化问题至关重要,以及NPhard问题的概念。通过实例解析了向量表示文本、图片和时间序列的方法,如SVD在图像压缩中的应用。此外,还解释了矩阵的逆、相似变换中的不变量和线性回归问题,以及矩阵求导的基本概念。

996

996

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?