在使用 AI 助手编写代码的过程中,如何让 AI 理解你的接口文档,甚至基于 API 生成调用代码?Apifox 提供的 MCP Server 功能正是为此而生。通过 MCP,AI 工具如 Cursor、VSCode、Trae 等可以直接访问你公开发布的 Apifox 文档,实现无缝的智能协作。

这篇文章将手把手教你如何通过 MCP 使用公开的 Apifox 在线 API 文档。

什么是 MCP?

MCP 即模型上下文协议(Model Context Protocol)的缩写,Apifox MCP Server 可以将公开发布的在线文档提供给 AI 使用,允许 AI 工具通过命令行读取接口文档的数据结构,实现智能代码补全和文档理解。目前 MCP 仅支持已公开发布、无需登录即可访问的在线文档。

如果你希望连接的是私有项目文档,请参考:通过 MCP 使用项目内文档。

第一步:开启 MCP 服务

需要 Apifox 版本 ≥

2.7.2

-

打开你的 Apifox 项目,依次点击:「分享文档」→「发布文档站」→「AI 功能」

-

开启 MCP 服务

开启后,访问该项目的在线文档,你将看到文档右上角出现“AI 编程(使用 MCP)”按钮,点击即可获取 MCP 的配置文件。配置文件中包含一个唯一的 site-id,之后在 IDE 中接入时会用到它。

第二步:配置 MCP 客户端

前置条件

-

安装 Node.js(版本 ≥ 18,建议使用 LTS 版本)

-

使用以下任一支持 MCP 的开发工具:

-

Cursor

-

VSCode + Cline 插件

-

Trae 编辑器

-

-

从 Apifox 在线文档中获取到 MCP 配置(含

site-id)

在 Cursor 中接入 MCP

-

打开 Cursor → 点击右上角「设置」→ 选择左侧「MCP」→ 点击「+ Add new global MCP server」

-

在弹出的

mcp.json配置文件中粘贴以下内容(将123456替换为你的 site-id):

macOS / Linux 示例(这里的配置从在线文档中获取):

{

"mcpServers": {

"API 文档": {

"command": "npx",

"args": [

"-y",

"apifox-mcp-server@latest",

"--site-id=123456"

]

}

}

}Windows 示例(这里的配置从在线文档中获取):

{

"mcpServers": {

"API 文档": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"apifox-mcp-server@latest",

"--site-id=123456"

]

}

}

}-

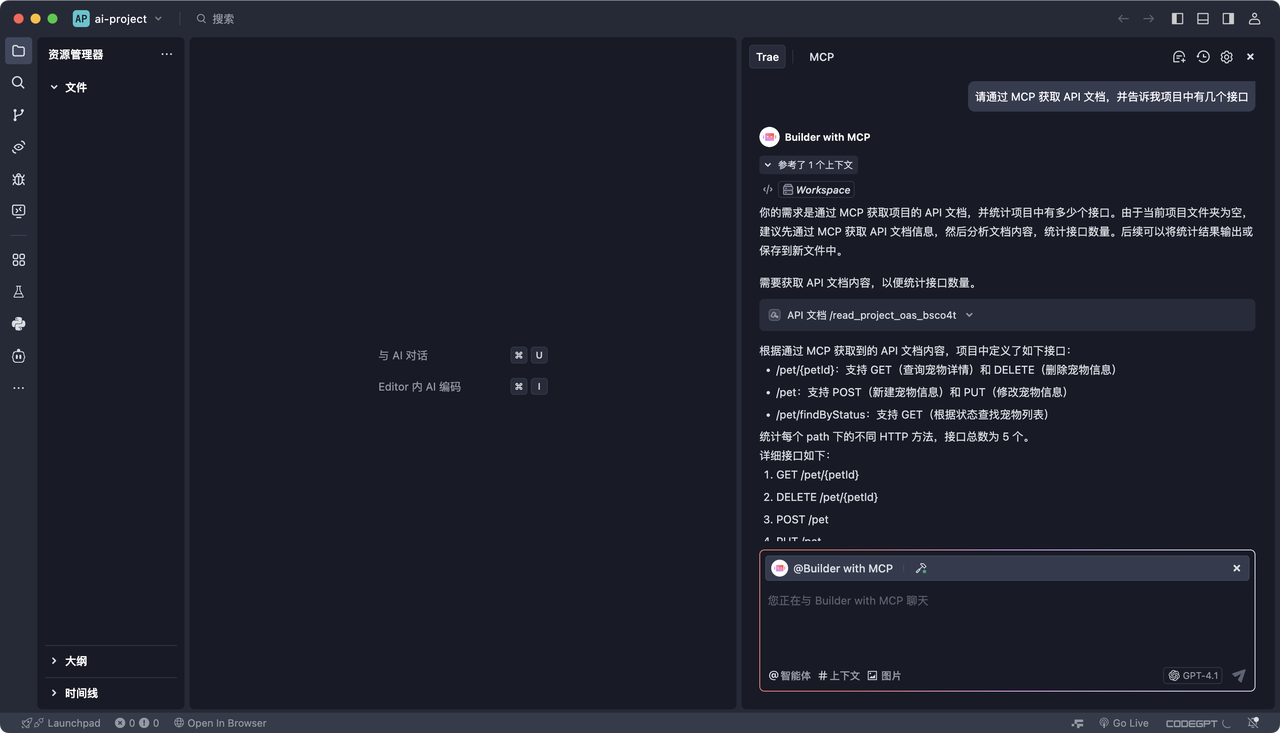

验证配置是否生效:在 Cursor 中向 AI 提问,例如:

请通过 MCP 获取 API 文档,并告诉我项目中有几个接口

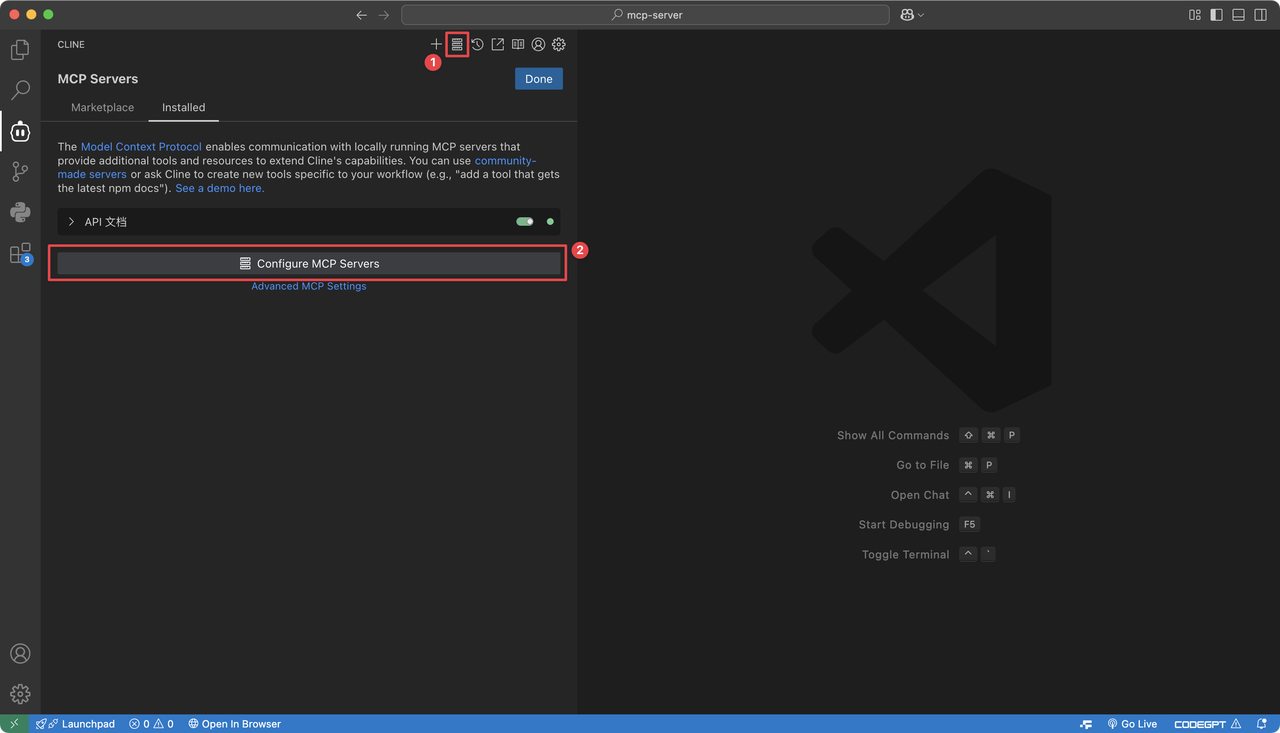

在 VSCode + Cline 插件中接入 MCP

-

安装 Cline 插件

-

打开 Cline 面板 → 点击「MCP Servers > Configure MCP Servers」

-

在配置文件中添加 MCP 信息(与上面的 Cursor 格式一致,配置可以从公开的在线文档中获取)

-

向 AI 提问验证配置即可。

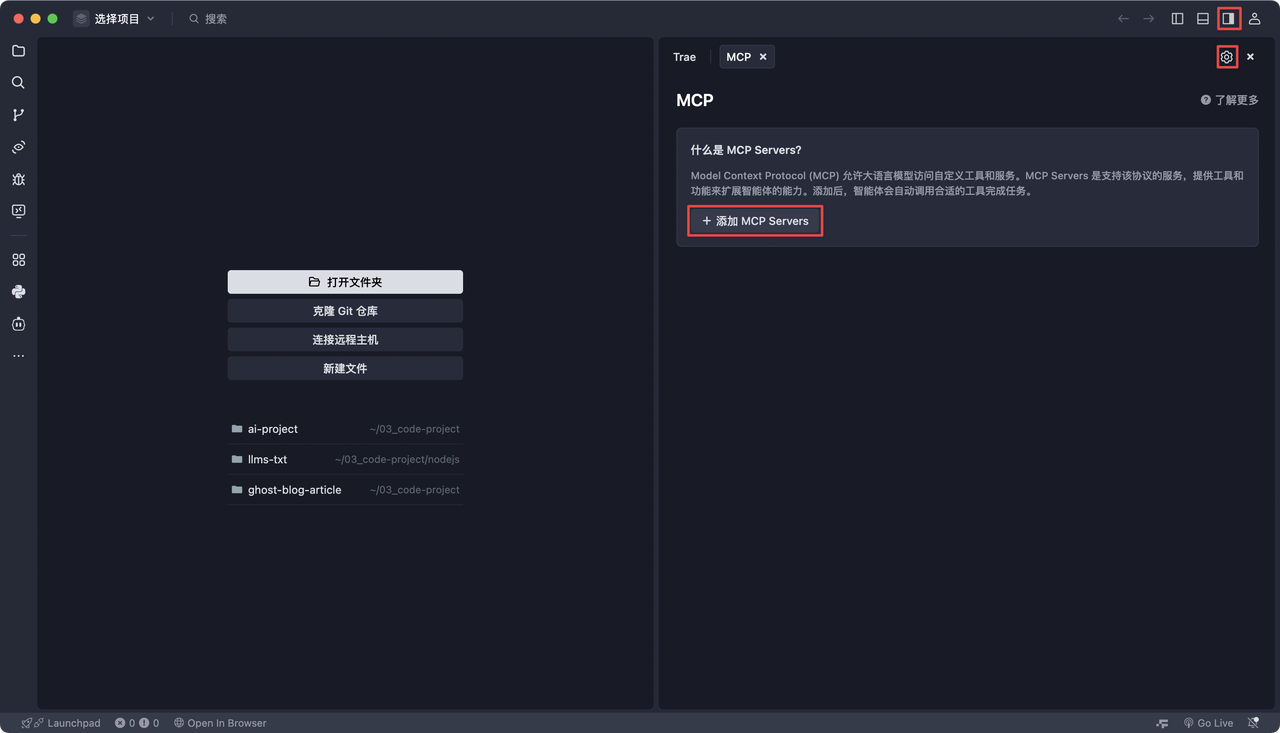

在 Trae 编辑器中接入 MCP

-

打开 Trae → 右上角点击「AI 侧栏 → 设置」→ 进入「MCP」设置界面 → 点击「+ 添加 MCP Servers」

-

选择“手动配置”,编辑

mcp.json文件 -

配置内容参考(配置可以从公开的在线文档中获取):

{

"mcpServers": {

"API 文档": {

"command": "npx",

"args": [

"-y",

"apifox-mcp-server@latest",

"--site-id=123456"

]

}

}

}-

保存并尝试提问验证 AI 是否能识别你的接口文档。

使用注意事项

-

如需连接多个文档,可在配置文件中添加多个

mcpServers项 -

私有化部署时,需额外添加参数:

"--apifox-api-base-url=https://your-apifox-server.com"完整示例:

{

"mcpServers": {

"API 文档": {

"command": "npx",

"args": [

"-y",

"apifox-mcp-server@latest",

"--site-id=123456",

"--apifox-api-base-url=https://your-apifox-server.com"

]

}

}

}常见问题解答

✅ Windows 配置异常?

使用 cmd 包裹指令:

"command": "cmd",

"args": ["/c", "npx", "-y", "apifox-mcp-server@latest", "--site-id=123456"]✅ Node.js 版本过低?

请使用以下命令检查版本:

node -v如版本 < 18,请升级 Node.js。

✅ 文档更新后 AI 读取的还是旧内容?

AI 使用的接口数据有缓存,如文档已更新,请告诉 AI 重新读取文档:

请重新读取 API 文档数据,在 Pet DTO 里添加 API 文档新增的几个字段延伸阅读

借助 MCP,AI 不再只懂代码,也能真正理解你的接口文档,从而成为更聪明的开发助手。如果你还没有试过,不妨今天就动手配置一下吧!

2566

2566

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?