OVRLipSync

该插件时来自Meta公司出品的Oculus Lipsync for Unity Development

可以在Windows或macOS上使用,可以用来同步虚拟人物的嘴唇运动和语音和笑声。Lipsync分析来自麦克风输入或音频文件的音频输入流,并预测一组称为visemes的值,这是与特定语音相对应的嘴唇和面部的手势或表情。在讨论唇读时使用“视素”一词,它是可理解性的基本视觉单位。在计算机动画中,visemes可以用来给虚拟人物动画,使他们看起来像在说话。

一、视素是什么?

此处需要引入一个概念“Viseme”,解释为可视音素(下文称视素),意为人物模型面部在发出声音时表现出来的口型,由此概念可实现通过一段音频来驱动模型口型来模拟真实情况下说话的效果。然后通过随机因子来控制头部朝向,眼球聚焦点,眉毛,眨眼和微笑,不同等级按照高优先级执行,同等级的按照时间先后,优先执行后触发动作。不过这些随机数的效果并不那么完美,可能会出现恐怖谷的现象,通过机器学习来实现可能是一个更好的方向。

二、模型规范

在建模的流程中使用Blendshap来表现面部表情的变化动画,每个视素创建一个Blendshap控制器,Blendshap的名称使用Viseme Name来定义,权重取值范围0-100。

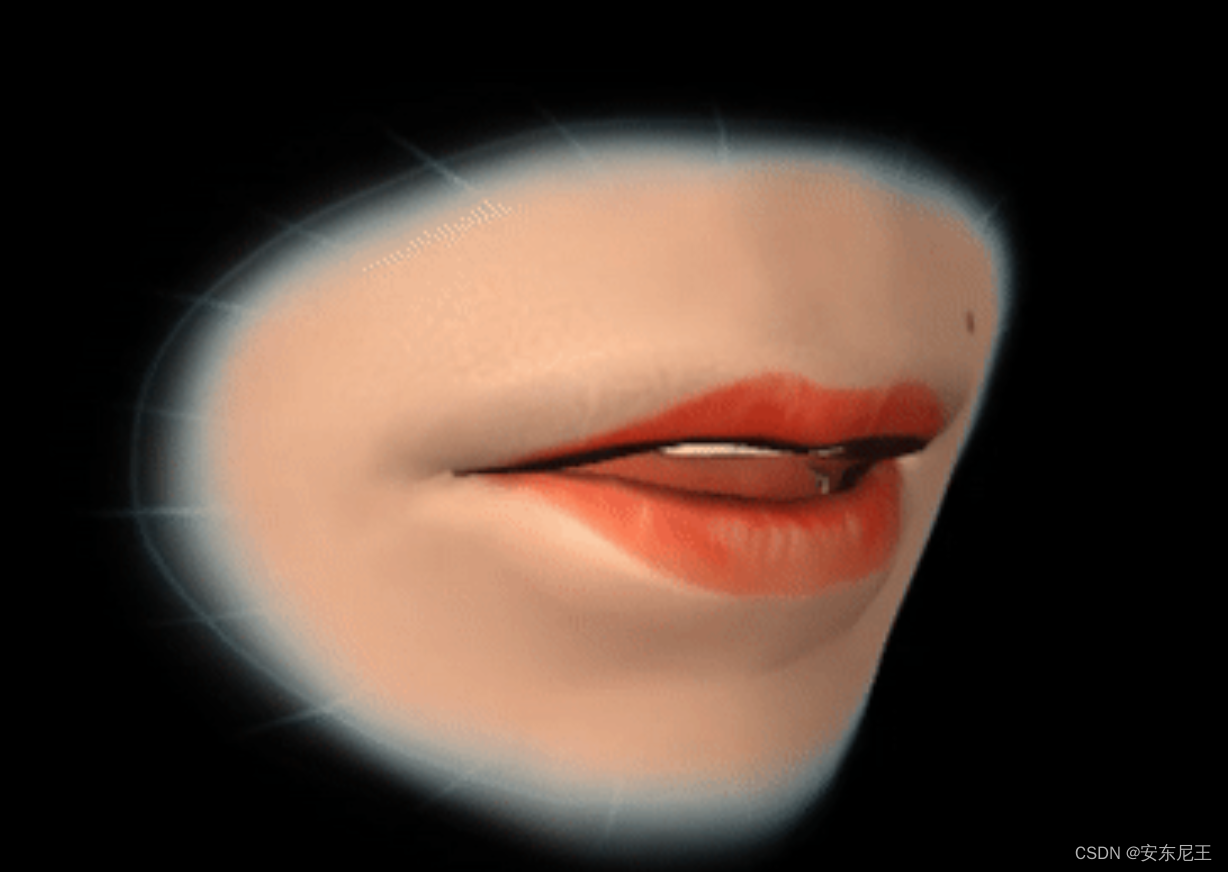

一般情况下,我们使用MetaOculus公司的标准来创建出15个常用的视素,除第一个是表示静默状态下的口型之外,其他的音素都对应一个口型,如下图所示

参考链接

总结

本插件对于标准英文发音的支持表现效果很好,但是最好保持音质的质量,尽量降低环境噪音和吐字清晰,但是在中文发音环境下表现效果并不好,这是因为Meta的识别算法是针对的英文发音口型的,与中文发音习惯并不相同。目前市面上开源的口型同步识别算法很少,支持中文发音识别的更是几乎没有。

本文介绍了Meta公司为Unity开发的OVRLipSync插件,它利用Viseme技术同步虚拟角色的嘴唇动作。文章详细讲解了Viseme的概念,如何通过音频驱动模型口型,以及模型规范中的Blendshape应用。尽管英文发音效果良好,中文发音支持有限,因为算法主要针对英文口型。

本文介绍了Meta公司为Unity开发的OVRLipSync插件,它利用Viseme技术同步虚拟角色的嘴唇动作。文章详细讲解了Viseme的概念,如何通过音频驱动模型口型,以及模型规范中的Blendshape应用。尽管英文发音效果良好,中文发音支持有限,因为算法主要针对英文口型。

1468

1468

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?