最小二乘、极大似然估计、梯度下降法,是机器学习中常出现的名词。

最小二乘和极大似然是目标函数,梯度下降是优化算法。

机器学习的基本框架基本是模型、目标和算法。

对于一个数据集,根据数据的特点和目的来选择相应的模型。

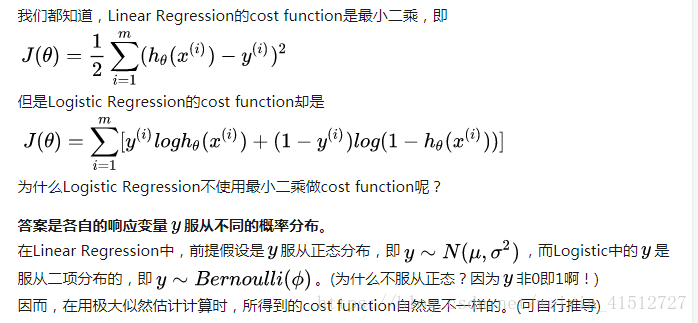

选择了模型后,为了拟合或分类数据,所以要构造一个目标函数cost function。

构造cost function后,有一部分目标函数,可以直接通过求导求解。

而大部分问题,尤其是logistic regression中。不能直接求导而得,所以需要一种优化算法求解。

而梯度下降法,就是一种求解目标函数的最优化算法。

为什么logistic回归的优化算法为什么用梯度下降而不用最小二乘法(姑且这么叫吧),答案是最小二乘法只能解决线性最小二乘问题,而logistic回归的损失函数不是线性最小二乘问题。(注意最小二乘和最小二乘法的区别)

本文解析了机器学习中的几个核心概念:最小二乘法、极大似然估计与梯度下降法。介绍了这些方法在构建机器学习模型中的角色,特别是梯度下降法作为优化算法的应用,及其为何适用于logistic回归。

本文解析了机器学习中的几个核心概念:最小二乘法、极大似然估计与梯度下降法。介绍了这些方法在构建机器学习模型中的角色,特别是梯度下降法作为优化算法的应用,及其为何适用于logistic回归。

3948

3948

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?