自接触三维重建以来,一直为fusion类的三维重建所惊艳,同时心头一直盘旋着写个合集的想法,直至自己亲身实践一番后,终于可以了却心愿。故先写个总览作为备忘,也可给各位看客提供按图索骥的便利。后续还会写具体文章的分析,分享下对相关论文的理解。

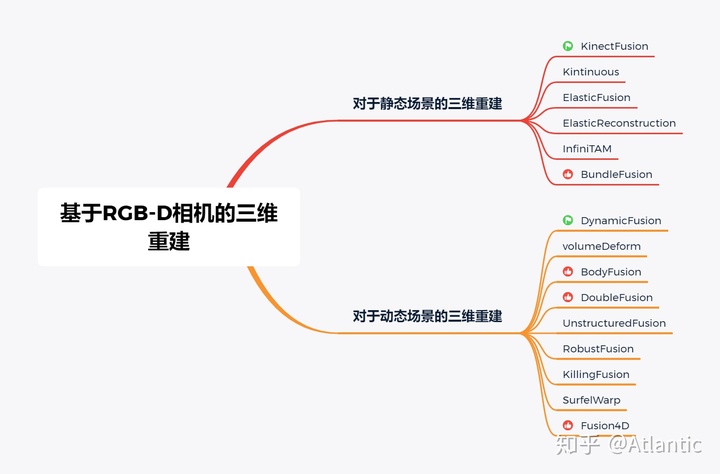

基于fusion类的三维重建其实可以大体分为两种,一种是对于静态场景的三维重建,以KinectFusion为典型代表,一种是对于动态场景的三维重建,以DynamicFusion为典型代表。而不论是静态场景亦或是动态场景的fusion类重建,最大特点就是使用了TSDF模型,当然也有个别工作使用了面元(Surfel)的表示方法。值得一提的是,基于动态场景的三位重建的难度远大于基于静态场景的三位重建,当然,对于拓扑不会发生变化的重建(比如驱动一个模板mesh),难度会下降很多。下面分别介绍下代表性工作。

基于静态场景的三维重建

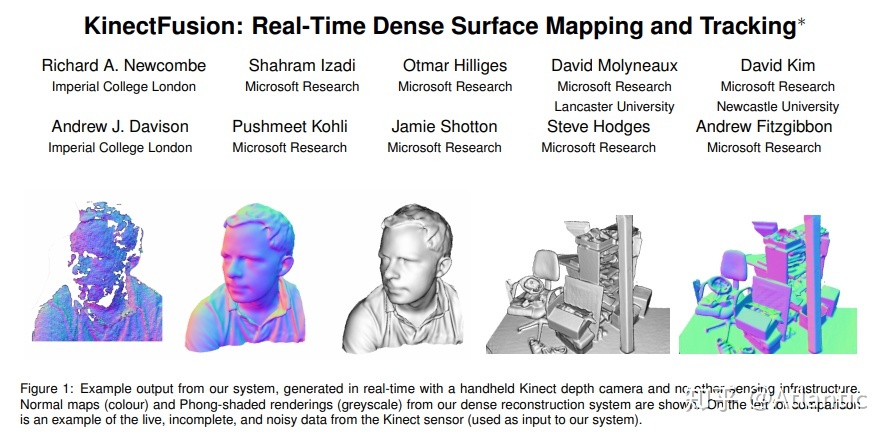

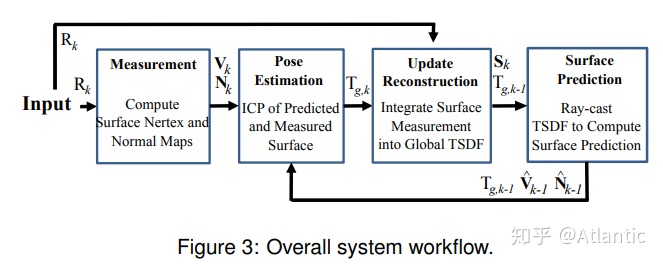

1.KinectFusion

Newcombe的经典之作

paper:

https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/ismar2011.pdfwww.microsoft.comcode:

https://github.com/ParikaGoel/KinectFusiongithub.comdemo:

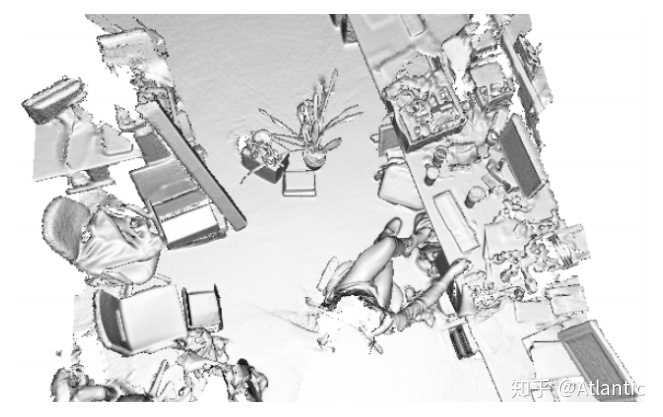

2.Kintinuous

上述 KinectFusion 算法使用固定体积的网格模型(如256*256*256)表示重建的三维场景,从而使得只能重建固定大小的场景;另外当重建体积较大,或者网格的空间分辨率较高时很消耗显存。而且 KinectFusion 算法没有回环检测和回环优化,这也造成当相机移动距离大时,不可避免的会有累积误差。这个算法是比较完善的三维重建系统,融合了回环检测和回环优化,还在实时三维刚体重建中使用了deformation graph做非刚体变换,根据回环优化的结果,更新点的坐标,使得回环的地方两次重建的可以对齐。该算法适合大场景的三维重建。

paper:

http://www.thomaswhelan.ie/Whelan12rssw.pdfwww.thomaswhelan.iecode:

mp3guy/Kintinuousgithub.com

本文提供了一个关于基于RGB-D相机的三维重建的总览,包括静态场景(如KinectFusion、Kintinuous、ElasticFusion等)和动态场景(如DynamicFusion、volumeDeform等)的典型代表工作。这些重建方法利用TSDF模型或面元表示,部分针对大场景、人体动态或复杂形变,具有不同的优势和适用范围。

本文提供了一个关于基于RGB-D相机的三维重建的总览,包括静态场景(如KinectFusion、Kintinuous、ElasticFusion等)和动态场景(如DynamicFusion、volumeDeform等)的典型代表工作。这些重建方法利用TSDF模型或面元表示,部分针对大场景、人体动态或复杂形变,具有不同的优势和适用范围。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1246

1246

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?