此篇文章灵感来源于一位正在做车端感知算法的程序员,本人在这之前并不了解YOLOv3的强大,但亲身感受后,不得不说YOLO的创造者-Joseph Redmon和Ali Farhadi等人简直是鬼才。随后本人翻阅了大量的文献和内容,发现如要想了解 YOLO v3必须得从之前的论文开始,因为关于YOLO v3的论文写的实在是随意。

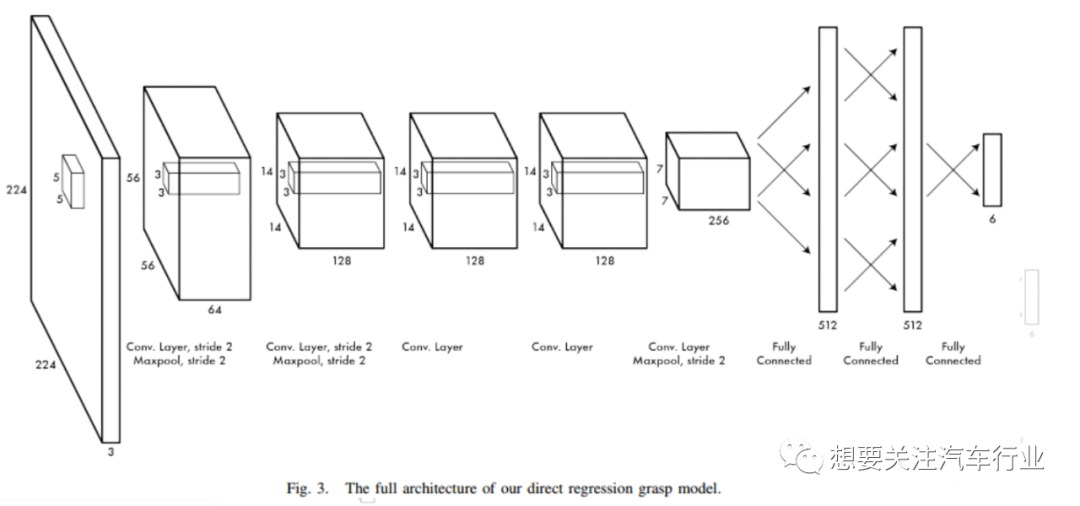

2015年,Joseph Redmon和Ali Farhadi提出的基于单个神经网络的目标检测系统。比目前最好的方法提高了14%的精度,在GPU上能达到13FP。网络结构示意图如下:

详细中文解析链接:https://blog.youkuaiyun.com/u013187057/article/details/84498042

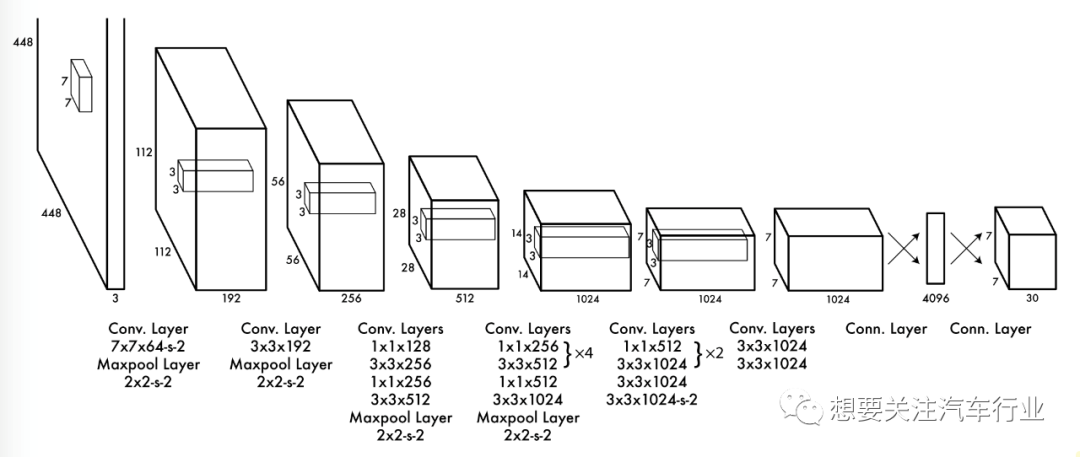

2016年,YOLO诞生了,被后人称为YOLOv1,它摒弃了RCNN系列方法中的region proposal步骤,将detection问题转为一个回归问题。YOLO v1 网络架构是受到图像识别模型GoogLeNet的启发。网络有24个卷积层后接2个全连接层。然而,不同于GoogLeNet中使用的inception modules简单地在1×1卷积层后面接上3×3卷积层(类似于Lin等人)。如下图 Figure 3 所示:

详细中文解析链接:https://www.cnblogs.com/CZiFan/p/9516504.html

2017年,YOLO模型升级,称为YOLOv2,基于实时目标检测系统YOLO9000,YOLOv2在PASCALVOC和COCO等标准检

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

893

893

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?