GBDT又叫梯度提升决策树,它也属于Boosting框架。GBDT核心原理如下:

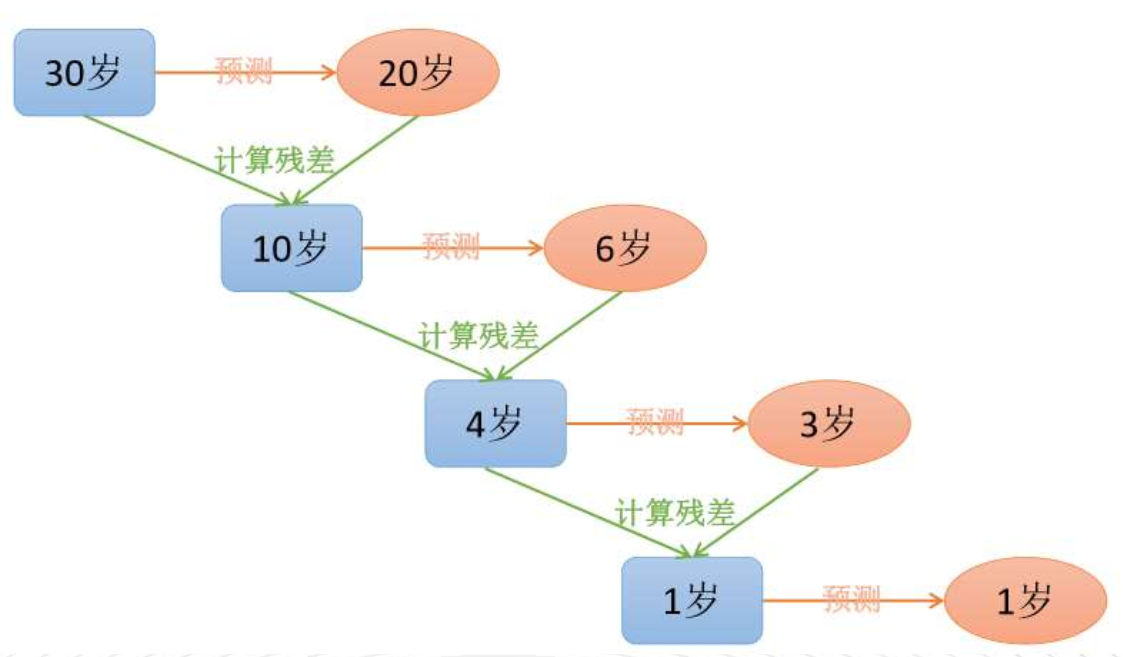

如图所示,用GBDT预测年龄,第一轮,预测到年龄为20,它和真实值之间的残差为10,第二轮,GBDT开始预测上一轮的残差10,预测结果为6,这一轮 的残差为4,第三轮,以年龄4为预测目标,预测来的值为3,和真实值之间相差1,最后以残差1为预测目标,预测结果为1,此时残差为0,预测结束,最后把之前模型预测的结果全部相加,就得到预测的真实值为30岁

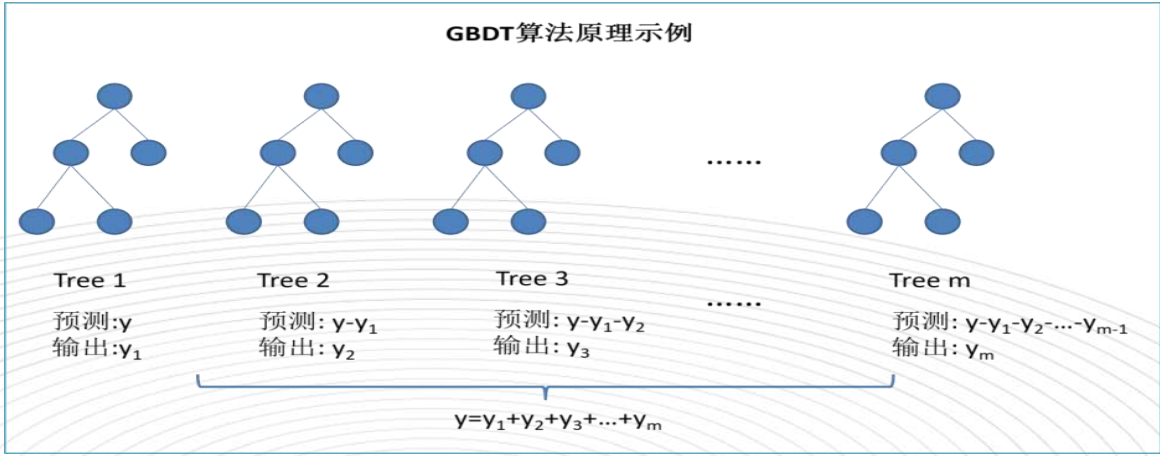

所以,GBDT的核心原理是先用初始值预测一颗决策树,得到本轮的残差,即真实值减预测值,然后用残差作为下一轮决策树的预测对象,这时会再产生一个残差,再用这个残差作为下一轮的预测对象,以此循环迭代直到最后一轮的预测残差为0或非常小的时候就停止迭代,然后把所有轮的模型预测结果相加得到最终预测结果,GBDT核心原理如下图所示

GBDT和AdaBoost的异同

相似之处:

都是基于Boosting思想的融合算法

默认的基分类器都是决策树

AdaBoost其实是GBDT的一个特例

不同之处:

AdaBoost的基分类器可以选择更多的算法,而GBDT只能选决策树

GBDT的模型提升方法与AdaBoost不同,AdaBoost是通过不断加强对错判数据的权重学习来提升模型的预测效果,而GBDT则是通过不断降低模型误差来(学习残差)的思想来提升模型的预测效果

本文详细介绍了GBDT(梯度提升决策树)的工作原理,即通过不断预测残差并学习来提升模型预测效果。同时,对比了GBDT与AdaBoost的异同,指出两者虽然都基于Boosting思想,但提升模型预测效果的方式不同。

本文详细介绍了GBDT(梯度提升决策树)的工作原理,即通过不断预测残差并学习来提升模型预测效果。同时,对比了GBDT与AdaBoost的异同,指出两者虽然都基于Boosting思想,但提升模型预测效果的方式不同。

4772

4772

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?