mAP是目标检测中的基本指标,详细理解有助于我们评估算法的有效性,并针对评测指标对算法进行调整。

1.基本概念定义

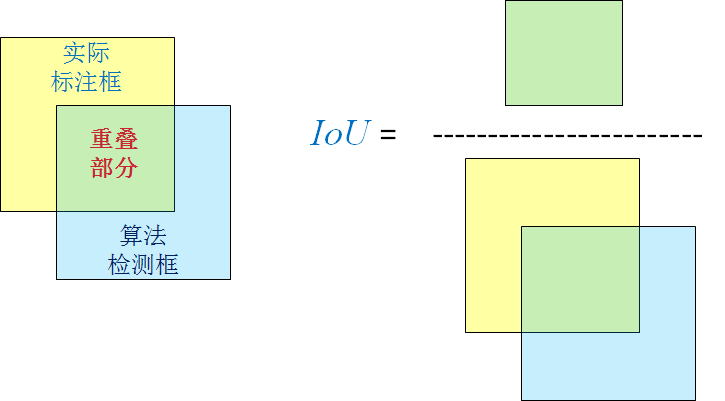

- 在目标检测中IoU为检测框与GroundTruth重叠的比例,如果大于0.5则算作正确True,小于0.5则算作错误False;

其中0.5是VOC比赛中设定的阈值,具体见论文"The PASCAL Visual Object Classes (VOC) Challenge"Page_11。需要说明的是,阈值的改变会影响检测结果,TP\FP\FN\TN等都会随着阈值的改变而改版。

具体的IoU定义和计算如下图所示:

对于目标检测来说,IoU大于阈值、检测到框算作是positive;

- 真阳性TP:正确样本预测为正,在目标检测中为IoU大于阈值记为TP;

- 假阳性FP:错误样本预测为正,检测框的IoU小于阈值记为FP;

- 假阴性FN:正确样本预测为负,没有检测到框;

- 真阴性TN:错误样本预测为负;

对每个样本的检测可以通过上面TP/FP/FN的计数来计算出精度与召回率。

-

Precision精度,即TP/(TP+FP)。指所有结果中正确的检索所占比例。结果中包含了真阳性结果TP和假阳性结果FP。其含义为所有被预测为正类的结果(其中也包含了被错误预测成正类的FP)中预测正确的结果所占比例。

P r e c i s i o n = T P T P + F P Precision = \frac{TP}{TP+FP} Precision=TP+FPTP -

Recall召回率,即TP/(TP+FN)。指模型查找出正确对象的概率。其中包含了正确预测的正类TP,也包括了将正类错误预测成负类的FN。召回率的本质可以理解为查全率,即结果中的正样本占全部正样本的比例。

R e c a l l = T P T P + F N Recall = \frac{TP}{TP+FN} Recall=TP+FNTP -

PR:精度-召回率( P r e c i s i o n − R e c a l l Precision-Recall Precision−Recall)曲线。这条曲线的两个变量程负相关,精度越高,召回率越低;召回率越高,精度越低。如果将所有对象都预测为正类,没有被错误预测成负类的正类(FN为0)那么召回率将为100%;如果将所有对象的预测都为负,没有被错误预测成正的样本,那么精度就将为100%,这两个指标间存在着此消彼长的关系,理想的曲线是向右上方凸出的、包围面积大的曲线。

-

AP均匀精度Average Precision:PR曲线下所围成的面积,面积越大越好;这里的average指的是针对不同recall的平均精度。

-

mAP平均均匀精度,mean Average Precision,指各类计算出AP在不同类别上的均值。这里的mean指的是对于检测算法在数据集上各类对象的表现。

-

Top-1/Top 错误率:指的是预测概率最高的类别输入目标类别的准确率。top1就是最高类别为目标类别的准确率,top5就是最高的五个中命中目标类别的准确率。

2.AP计算

要计算mAP,首先需要计算每一个类别的AP值,主要有两种方法来计算PR曲线下的均值。

- 一种方法是选取 R e c a l l > = [ 0 : 0.1 : 1 ] Recall>=[0:0.1:1] Recall>=[0:0.1:1]等11个值时,其recall>当前recall对应精度precision的最大值,并由这11个最大精度值求取均值即为AP。这种方法也称为11-point interpolated average precision。根据论文对AP的定义:

A P = 1 11 ∑ r ⊂ 0.0.1 , . . . , 1 p i n t e r p ( r ) AP = \frac{1}{11}\sum \limits_{r\subset{0.0.1,...,1}}p_{interp}(r) AP=111

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6182

6182

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?