全文摘要

本文介绍了一种名为ControlCom的图像合成方法,该方法利用扩散模型进行图像融合、图像调和、视点合成和生成式合成等四个任务,并通过自监督训练框架和专门的数据准备管道进行了设计。此外,为了提高前景细节的保真度,作者还提出了局部增强模块。实验结果表明,该方法比现有方法能够生成更真实可控的复合图像。

论文方法

方法描述

该论文提出了一种基于扩散模型的可控图像合成方法。该方法通过使用预先训练好的文本到图像扩散模型来实现。具体来说,它包括两个组件:一个前景编码器和一个可控生成器。在训练阶段,他们设计了一个自监督框架来同时学习四个任务:背景融合、前景增强、光照变换和姿势变化。在推理时,输入包含目标对象的图像、背景图像、边界框和二进制掩码以及控制照明或姿势的指示符,生成与背景场景相容的目标对象。

方法改进

相比于传统的图像合成方法,该方法采用了扩散模型来进行图像合成,使得生成的图像更加真实自然。此外,该方法还引入了自监督框架来提高模型的泛化能力,并且可以同时学习多个任务,从而提高了效率。

解决的问题

该方法解决了传统图像合成方法中存在的一些问题,如图像不真实、难以控制照明和姿势等。通过使用扩散模型和自监督框架,该方法能够更好地满足实际应用的需求,例如在虚拟现实、游戏开发等领域中的应用。

论文实验

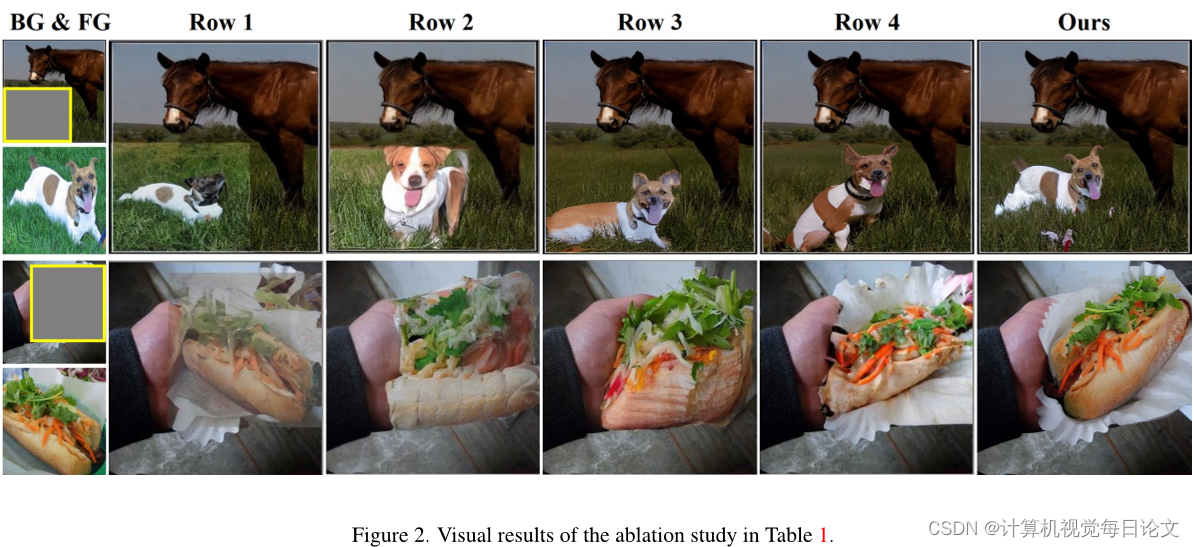

本文主要介绍了在图像合成任务中提出的一种新方法,并进行了与其他方法的比较实验。具体来说,该方法包括四个版本:Blending、Harmonization、ViewSynthesis和Composition。其中,Blending版本直接将原始或和谐化的前景对象复制到背景上,Harmonization版本通过调整输入图像的色彩和亮度来实现前景与背景的一致性,ViewSynthesis版本通过改变前景的位置和光照条件来生成新的视角,Composition版本则是综合了上述三个版本的优点,实现了更加真实的图像合成效果。

在实验方面,作者使用了两个数据集进行比较:COCOEE和FOSCom。对于COCOEE数据集,作者采用了Freechet Inception Distance(FID)和Quality Score(QS)作为评估指标,计算生成的合成图像与测试集中所有图像之间的距离和质量得分。对于FOSCom数据集,作者采用了CLIP score(CLIPfg)、SSIM和LPIPS等指标来评估合成图像的质量。同时,作者还提供了定量和定性的实验结果,以展示所提出的算法相对于其他方法的优势。

总的来说,本文的主要贡献在于提出了一种新的图像合成方法,并且通过多个实验展示了其优越性能。

论文总结

文章优点

该文章提出了一种新的图像合成方法ControlCom,通过引入一个二维指示向量来控制图像合成过程中的属性调整,从而实现了可控的图像合成,并且在保持高保真度的同时提高了合成结果的质量。此外,作者还设计了一个两阶段融合策略,将全局嵌入和局部嵌入分别融合到扩散模型中,以进一步提高合成结果的真实性和细节表现力。

方法创新点

该文章的主要贡献在于提出了一个全新的图像合成方法,通过引入一个二维指示向量来实现对图像合成过程中属性调整的控制,从而解决了传统图像合成方法中存在的不可控问题。同时,作者还设计了一个两阶段融合策略,通过先融合全局嵌入再融合局部嵌入的方式,进一步提高了合成结果的真实性和细节表现力。

未来展望

该文章提出的图像合成方法具有很大的应用前景,可以应用于虚拟现实、增强现实等领域。未来的研究方向包括但不限于:如何进一步提高合成结果的真实性和细节表现力;如何将该方法扩展到其他类型的图像合成任务中;如何结合其他技术(如深度学习)来进一步提升合成效果等。

338

338

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?